Justo después de que Samsung anunciara nuevas funciones de accesibilidad para los Galaxy Buds 2 Pro, Apple anunció algunas funciones de accesibilidad para los iPhone. Justo antes del Día de Concientización sobre la Accesibilidad Global (18 de mayo de 2023), Apple anunció funciones para mejorar la accesibilidad en los iPhones, y parece que esas funciones se han inspirado en las funciones de Samsung.

El acceso asistido de Apple es similar al modo fácil de Samsung, mientras que Live Speech es similar a Bixby Text Call

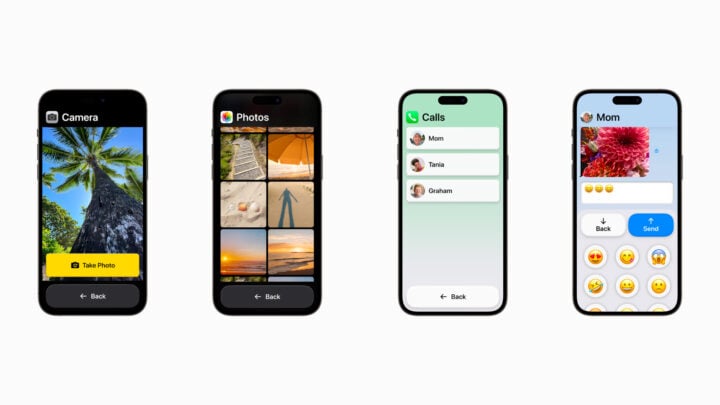

Apple revelado Acceso asistido, Live Speech y Personal Voice. El acceso asistido es para personas con discapacidades cognitivas y ofrece elementos y diseños de interfaz de usuario más grandes para que las personas puedan acceder a las funciones esenciales con facilidad. Esta característica es similar al Modo Fácil de Samsung, que agiliza la interfaz de usuario para un acceso más fácil que ayuda a los ancianos o personas con discapacidades cognitivas. La característica de Apple funcionará en iPhones y iPads con aplicaciones esenciales como Llamadas, Cámara, Mensajes, Música y Fotos, ofreciendo objetivos táctiles y elementos de interfaz de usuario más grandes. Esta función se implementará más adelante este año como parte de la actualización de iOS 17.

Con Live Speech, los usuarios pueden escribir lo que tienen que decir durante una llamada de voz. Un iPhone, iPad o Mac convertirá ese texto en voz y lo transmitirá al otro lado de la llamada. Los usuarios también pueden guardar frases rápidas para usar durante las llamadas. Esta función es similar a la función Bixby Text Call de Samsung, que transcribe las voces a texto y viceversa durante las llamadas.

La función Personal Voice de Apple es similar a Bixby Custom Voice Creator de Samsung

La función de accesibilidad Personal Voice de Apple está diseñada para usuarios que corren el riesgo de perder la voz. Pueden crear una voz que suene como ellos leyendo un conjunto aleatorio de indicaciones de texto para grabar 15 minutos de audio en un iPhone o iPad. Esta función parece inspirada en Bixby Custom Voice Creator, que Samsung lanzó a principios de este año.

Además de todas estas características, Apple también anunció el Modo de Detección en la Lupa que los usuarios de iPhone con baja visión podrían usar para leer el texto de los objetos. Los usuarios pueden simplemente apuntar la cámara del iPhone a un objeto o texto que están mirando, y el modo de detección leerá ese texto y lo dirá en voz alta. Esto es similar a Samsung’s Bixby Vision’s Funciones de detector de color, identificador de objetos, descriptor de escenas y lector de texto.

Otras características nuevas incluyen la certificación’Made for iPhone Hearing Devices’para audífonos, mejoras en el control de voz, más opciones de tamaño de texto en aplicaciones Mac esenciales, pausar imágenes con elementos en movimiento (para aquellos sensibles a las animaciones rápidas), y voces más naturales para Voice Over.