A mesterséges intelligencia viharként hódítja meg a világot, és bár használhatja a Google Bard-ot vagy a ChatGPT-t, használhat egy helyi szervert is a Mac-en. Így használhatja az új MLC LLM csevegőalkalmazást.

A mesterséges intelligencia (AI) a számítástechnika új, élvonalbeli határa, és nagy felhajtást generál a számítástechnika világában.

A chatbotok – mesterséges intelligencia-alapú alkalmazások, amelyekkel a felhasználók domain szakértőként beszélgethetnek – enyhén szólva egyre népszerűbbek.

A chatbotok látszólag szakértői tudással rendelkeznek számos általános és speciális témában, és mindenhol gyors ütemben telepítik. Az egyik csoport – az OpenAI – kiadott néhány ChatGPT-t hónapokkal ezelőtt egy sokkolt világba.

A ChatGPT látszólag korlátlan tudással rendelkezik gyakorlatilag bármilyen témában, és valós időben tud válaszolni olyan kérdésekre, amelyek egyébként órákig vagy napokig tartó kutatást igényelnének. Mind a vállalatok, mind a dolgozók rájöttek, hogy a mesterséges intelligencia felgyorsíthatja a munkát a kutatási idő csökkentésével.

A hátrányok

A fentieket figyelembe véve azonban van néhány AI-alkalmazásnak hátránya is. Az AI elsődleges hátránya, hogy az eredményeket még ellenőrizni kell.

Bár általában többnyire helyes, a mesterséges intelligencia téves vagy megtévesztő adatokat szolgáltathat, amelyek hamis következtetésekhez vagy eredményekhez vezethetnek.

A szoftverfejlesztők és szoftvercégek „másodpilóták”-hoz folyamodtak – olyan speciális chatbotokhoz, amelyek segíthetnek a fejlesztőknek kódot írni a mesterséges intelligencia automatikusan megírja a függvények vagy metódusok vázlatát – amit aztán a fejlesztő ellenőrizhet.

Noha a másodpilóták nagyszerű időmegtakarítást jelentenek, hibás kódokat is írhatnak. A Microsoft, az Amazon, a GitHub és az NVIDIA mind kiadott másodpilótákat a fejlesztők számára.

Kezdő lépések a chatbotokkal

A chatbotok működésének legalább magas szintű megértéséhez először meg kell értenie az AI alapjait, és különösen a gépi tanulást (ML) és Large Language Models (LLM).

A gépi tanulás a számítástechnika egyik ága, amely a számítógépek tanulásra való megtanításának kutatásával és fejlesztésével foglalkozik.

Az LLM alapvetően egy természetes nyelvi feldolgozó (NLP) program, amely hatalmas adathalmazokat és neurális hálózatokat (NN-eket) használ a szöveg létrehozásához. Az LLM-ek úgy dolgoznak, hogy mesterséges intelligencia kódot tanítanak nagy adatmodellekre, amelyek aztán idővel „tanulnak” belőlük – lényegében a bemeneti adatok pontossága alapján egy adott terület tartományszakértőjévé válnak.

Minél több (és pontosabb) a bemeneti adat, annál pontosabb és pontosabb lesz a modellt használó chatbot. Az LLM-ek a Deep Learningre is támaszkodnak, miközben adatmodellekre képezik őket.

Amikor kérdést tesz fel egy chatbotnak, az LLM-től kérdezi meg a legmegfelelőbb választ – a tanult és tárolt ismeretei alapján a kérdéséhez kapcsolódó összes tárgyról.

A chatbotok alapvetően előre kiszámított tudással rendelkeznek egy témáról, és kellően pontos LLM-t és elegendő tanulási időt biztosítanak, sokkal gyorsabban tudnak helyes válaszokat adni, mint a legtöbb ember.

A chatbot használata olyan, mintha egy automatizált doktori csapat azonnal rendelkezésére állna.

2023 januárjában a Meta AI kiadta saját LLM-jét LLaMA néven. Egy hónappal később a Google bemutatta saját mesterséges intelligencia chatbotját, a Bardot, amely saját LLM-jén, a LaMDA-n alapul. Azóta más chatbotok is megjelentek.

Generatív mesterséges intelligencia

A közelmúltban egyes LLM-ek megtanulták, hogyan lehet nem szövegalapú adatokat, például grafikákat, zenét és akár egész könyveket generálni. A vállalatokat érdekli a generatív mesterséges intelligencia, hogy olyan dolgokat hozzanak létre, mint például a vállalati grafika, logók, címek és akár a színészeket helyettesítő digitális filmjelenetek is.

Például ennek a cikknek az indexképét mesterséges intelligencia hozta létre.

A Generatív AI mellékhatásaként a dolgozók aggódnak amiatt, hogy az AI-szoftverek által vezérelt automatizálás miatt elveszítik állásukat.

Chatbot asszisztensek

A világ első kereskedelmi célú, felhasználók által elérhető chatbotja (BeBot) a Bespoke Japan adta ki a Tokyo Station City számára 2019-ben.

Az iOS-és Android-alkalmazásként megjelent BeBot tudja, hogyan irányíthatja Önt a labirintusszerű állomás környékén, segít a poggyász tárolásában és visszavételében, elküldi Önt egy információs pulthoz, vagy megtalálhatja a vonatok időpontját, a földi szállítást, vagy élelmiszereket és üzleteket az állomáson belül.

Még azt is meg tudja mondani, hogy melyik vonatperonra induljon a leggyorsabb vonatút a város bármely célpontjához az utazás időtartama szerint – mindezt néhány másodperc alatt.

Az MLC csevegőalkalmazása

A Machine Learning Compilation (MLC) projekt az Apache Foundation Deep Learning kutatójának ötlete Siyuan Feng és Hongyi Jin, valamint mások Seattle-ben és Sanghajban, Kínában.

Az MLC mögött az az elképzelés áll, hogy előre lefordított LLM-eket és chatbotokat telepítsen a fogyasztói eszközökre és webböngészőkre. Az MLC a fogyasztói grafikus feldolgozó egységek (GPU-k) erejét hasznosítja az AI találatok és keresések felgyorsítására, így a mesterséges intelligencia elérhető a legtöbb modern fogyasztói számítástechnikai eszköz számára.

Egy másik MLC projekt – a Web LLM – ugyanazt a funkcionalitást hozza a webböngészőkbe, és az egy másik projekt-WebGPU. A Web LLM csak meghatározott GPU-kkal rendelkező gépeket támogatja, mivel az ezeket a GPU-kat támogató kódkeretrendszerekre támaszkodik.

A legtöbb mesterséges intelligencia asszisztens kliens-szerver modellre támaszkodik, ahol a kiszolgálók végzik a mesterséges intelligencia nagy részét, de az MLC az LLM-eket helyi kódba sűríti, amely közvetlenül a felhasználó eszközén fut, így nincs szükség LLM-szerverekre.

Az MLC beállítása

Az MLC futtatásához eszközén meg kell felelnie a projektben és a GitHub oldalain felsorolt minimális követelményeknek.

Az iPhone-on való futtatáshoz iPhone 14 Pro Max, iPhone 14 Pro vagy iPhone 12 Pro készülékre lesz szüksége, legalább 6 GB szabad RAM-mal. Az alkalmazás telepítéséhez telepítenie kell az Apple TestFlight alkalmazását is, de a telepítés az első 9000 felhasználóra korlátozódik.

Megpróbáltuk futtatni az MLC-t egy 2021-es alap iPaden, 64 GB tárhellyel, de nem sikerült inicializálni. Az eredmények iPad Pro esetén eltérőek lehetnek.

Az MLC-t forrásokból is létrehozhatja, és közvetlenül a telefonján is futtathatja az MLC-LLM GitHub oldalon található utasítások követésével. A források lekéréséhez telepítenie kell a git forráskód-vezérlő rendszert a Mac számítógépére.

Ehhez hozzon létre egy új mappát a Mac gép Finderében, a UNIX cd paranccsal navigáljon hozzá a terminálban, majd indítsa el a git clone parancsot a terminálban az MLC-LLM GitHubon felsoroltak szerint. oldal:

https://github.com/mlc-ai/mlc-llm.git, és nyomja meg a Return gombot. A git letölti az összes MLC-forrást a létrehozott mappába.

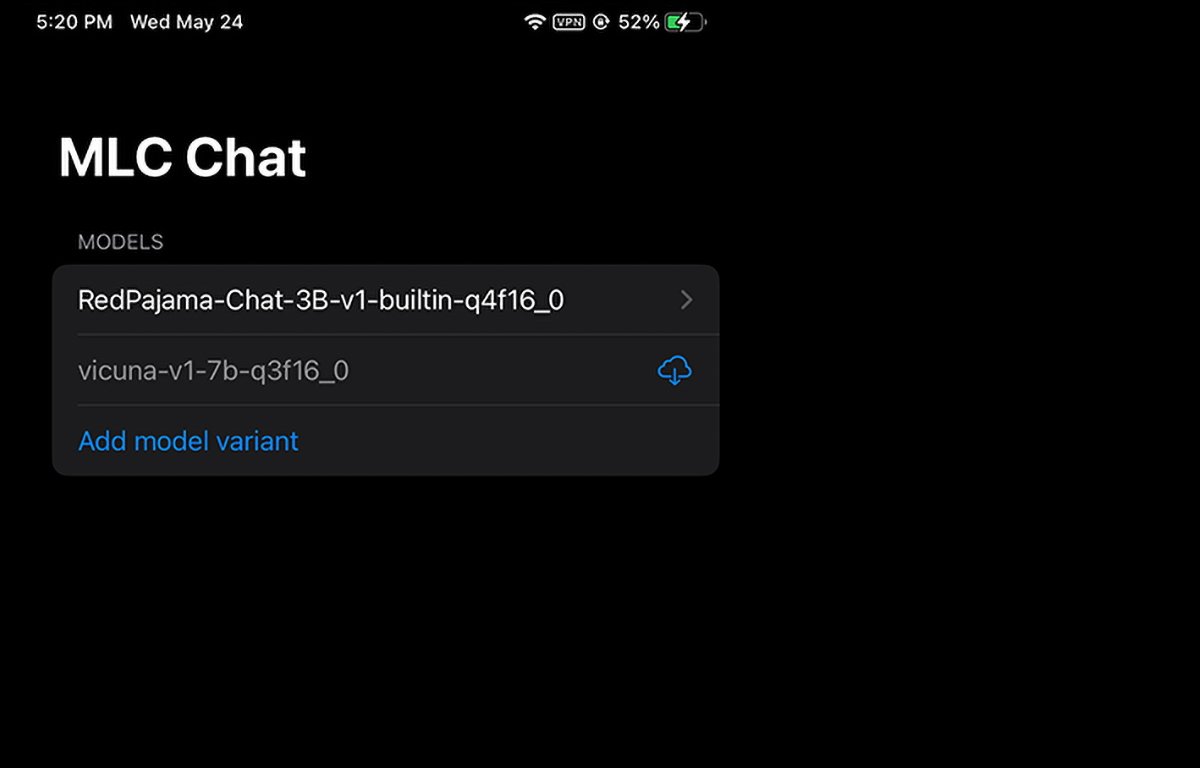

Az iPhone-on futó MLC. Kiválaszthatja vagy letöltheti a használni kívánt modellsúlyt.

A Mac előfeltételeinek telepítése

Mac és Linux számítógépeken az MLC parancssori felületről fut a Terminálban. A használatához először telepítenie kell néhány előfeltételt:

A Conda vagy Miniconda Package Manager Homebrew Vulkan grafikus könyvtár (csak Linux vagy Windows) nagy fájlok támogatása (LFS)

Az NVIDIA GPU-felhasználók számára az MLC utasításai kifejezetten azt írják elő, hogy manuálisan kell telepíteni a Vulkan illesztőprogramot alapértelmezett illesztőprogramként. Egy másik grafikus könyvtár NVIDIA GPU-khoz – a CUDA – nem fog működni.

Mac-felhasználók számára a Miniconda a Homebrew csomagkezelő használatával telepíthető. korábban foglalkoztam. Vegye figyelembe, hogy a Miniconda ütközik egy másik Homebrew Conda formulával, a miniforge-val.

Tehát ha a miniforge már telepítve van a Homebrew segítségével, először el kell távolítania.

Az MLC/LLM oldalon található utasításokat követve a telepítés hátralévő lépései nagyjából a következők:

Új Conda környezet létrehozása A git és a git LFS telepítése A parancssori chat alkalmazás telepítése a Condától Új helyi létrehozása mappát, töltse le az LLM-modell súlyait, és állítson be egy LOCAL_ID változót. Töltse le az MLC-könyvtárakat a GitHubról

Mindezt részletesen megemlítjük az utasítások oldalán, ezért itt nem térünk ki a beállítás minden szempontjára. Kezdetben ijesztőnek tűnhet, de ha rendelkezik alapvető macOS Terminal készségekkel, akkor ez valójában csak néhány egyszerű lépés.

A LOCAL_ID lépés csak úgy állítja be ezt a változót, hogy a három letöltött modellsúly egyikére mutasson.

A modellsúlyok a HuggingFace közösségi webhelyről tölthetők le, amely egyfajta GitHub AI-hoz.

Miután minden telepítve van a terminálban, az mlc_chat_cli használatával elérheti az MLC-t a terminálban

MLC használata webböngészőben

Az MLC-nek van webes verziója is, a Web LLM.

A Web LLM változat csak Apple Silicon Mac gépeken fut. Nem fog futni Intel Mac számítógépeken, és ha megpróbálja, hibát jelez a chatbot ablakában.

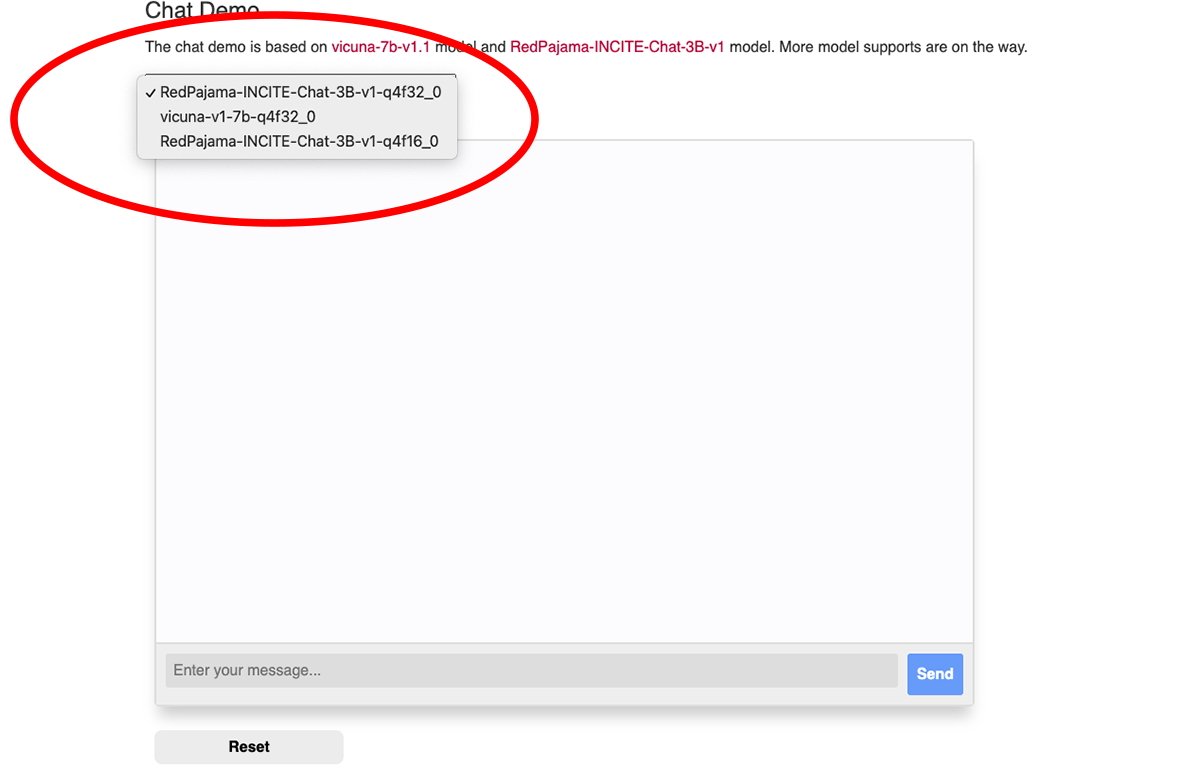

Az MLC webes csevegőablakának tetején található egy felugró menü, amelyből kiválaszthatja, hogy melyik letöltött modell súlyát szeretné használni:

Válasszon ki egy modellsúlyt.

A Web LLM használatához a Google Chrome böngészőre lesz szüksége (Chrome 113-as vagy újabb verzió). A korábbi verziók nem működnek.

A Chrome verziószámát a Mac verzió Chrome-menüjében ellenőrizheti, ha felkeresi a Chrome->A Google Chrome névjegye menüpontot. Ha elérhető frissítés, kattintson a Frissítés gombra a legújabb verzióra való frissítéshez.

Lehet, hogy a frissítés után újra kell indítania a Chrome-ot.

Ne feledje, hogy az MLC Web LLM oldala azt javasolja, hogy indítsa el a Chrome-ot a Mac terminálról a következő paranccsal:

/Applications/Google\ Chrome.app/Contents/MacOS/Google\ Chrome — enable-dawn-features=allow_unsafe_apis,disable_robustness

allow_unsafe_apis’és disable_robustness’a Chrome két indítási jelzője, amelyek lehetővé teszik a kísérleti funkciók használatát, amelyek instabilok vagy nem.

Ha mindent beállított, csak írjon be egy kérdést az Írja be az üzenetet mezőbe a Web LLM weboldal csevegőablakának alján, majd kattintson a Küldés gombra. erős> gombot.

A valódi mesterséges intelligencia és az intelligens asszisztensek korszaka csak most kezdődik. Bár a mesterséges intelligencia kockázatokat rejt magában, ez a technológia azt ígéri, hogy rengeteg időt takarít meg és sok munka kiküszöböli a jövőnket.