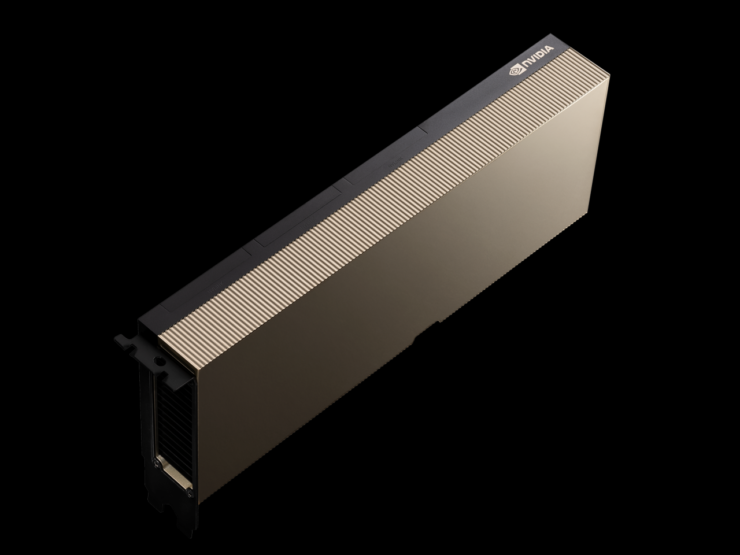

NVIDIA memiliki mengumumkan bahwa peluncuran hari ini sistem HGX A100 baru yang menggabungkan akselerator GPU PCIe A100 yang diperbarui dengan memori dua kali lipat & bandwidth lebih cepat untuk pengguna HPC.

NVIDIA Meningkatkan Sistem HGX A100 Dengan Akselerator GPU HPC A100 Berbasis Ampere Unggulan-Memori HBM2e 80 GB & Bandwidth 2 TB/dtk

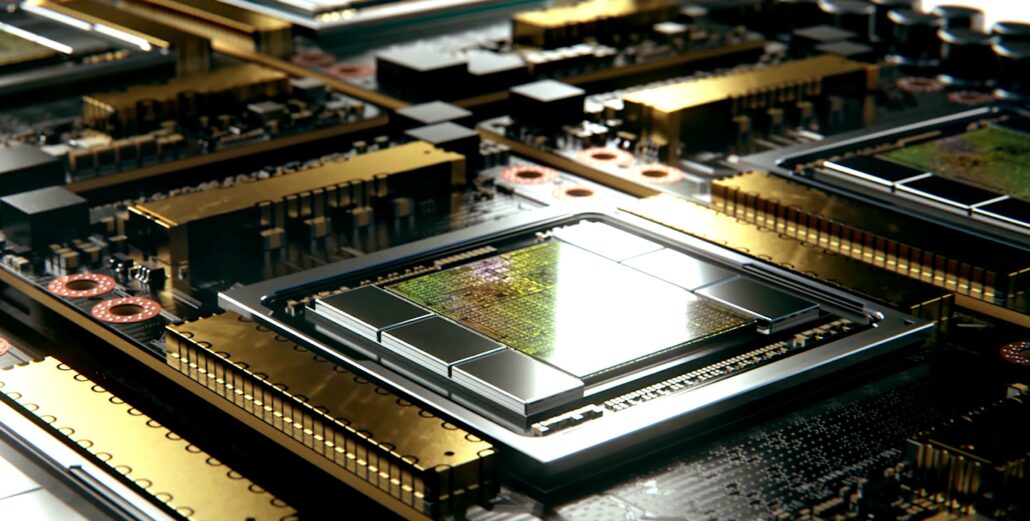

Akselerator NVIDIA A100 HPC yang ada diperkenalkan tahun lalu pada bulan Juni dan sepertinya tim hijau berencana untuk memberikan peningkatan spesifikasi utama. Chip ini didasarkan pada GPU Ampere terbesar NVIDIA, A100, yang berukuran 826mm2 dan menampung 54 miliar transistor. NVIDIA memberikan peningkatan spesifikasi pada akselerator HPC selama pertengahan siklus, yang berarti bahwa kita akan mendengar tentang akselerator generasi berikutnya di GTC 2022.

GPU NVIDIA A100 Tensor Core menghadirkan akselerasi HPC yang belum pernah ada sebelumnya untuk menyelesaikan AI kompleks, analisis data, pelatihan model, dan tantangan simulasi yang relevan dengan HPC industri. GPU PCIe A100 80GB meningkatkan bandwidth memori GPU 25 persen dibandingkan dengan A100 40GB, menjadi 2TB/dtk, dan menyediakan memori bandwidth tinggi HBM2e 80GB.

Kapasitas memori A100 80GB PCIe yang sangat besar dan bandwidth memori yang tinggi memungkinkan lebih banyak data dan jaringan saraf yang lebih besar disimpan dalam memori, meminimalkan komunikasi internode dan konsumsi energi. Dikombinasikan dengan bandwidth memori yang lebih cepat, memungkinkan peneliti untuk mencapai throughput yang lebih tinggi dan hasil yang lebih cepat, memaksimalkan nilai investasi TI mereka.

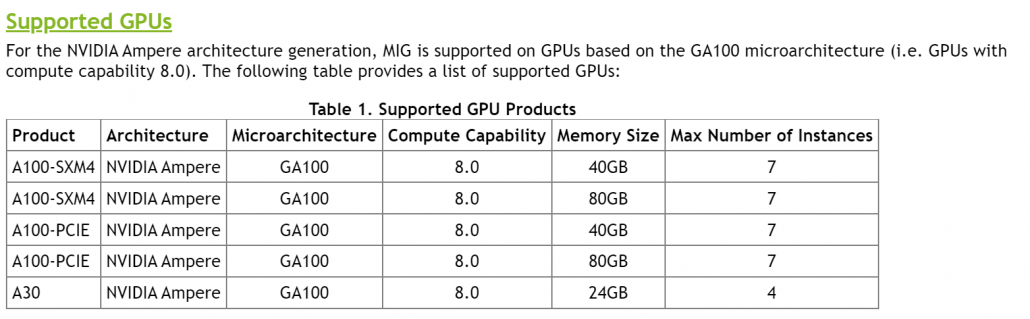

A100 80GB PCIe ditenagai oleh arsitektur NVIDIA Ampere, yang menampilkan teknologi Multi-Instance GPU (MIG) untuk memberikan akselerasi untuk beban kerja yang lebih kecil seperti inferensi AI. MIG memungkinkan sistem HPC untuk menurunkan skala komputasi dan memori dengan kualitas layanan yang terjamin. Selain PCIe, ada konfigurasi NVIDIA HGX A100 empat dan delapan arah.

Dukungan partner NVIDIA untuk A100 80GB PCIe termasuk Atos, Cisco, Dell Technologies, Fujitsu, H3C, HPE, Inspur, Lenovo, Komputasi Penguin, QCT, dan Supermicro. Platform HGX yang menampilkan GPU berbasis A100 yang saling terhubung melalui NVLink juga tersedia melalui layanan cloud dari Amazon Web Services, Microsoft Azure dan Infrastruktur Oracle Cloud.

Dalam hal spesifikasi, akselerator GPU PCIe A100 tidak banyak berubah dalam hal konfigurasi inti. GPU GA100 mempertahankan spesifikasi yang kami lihat pada varian 250W dengan 6912 core CUDA yang disusun dalam 108 unit SM, 432 Tensor Cores, dan memori HBM2e 80 GB yang memberikan bandwidth lebih tinggi 2,0 TB/dtk dibandingkan dengan 1,55 TB/dtk pada varian 40 GB.

Varian A100 SMX sudah dilengkapi dengan memori 80 GB tetapi tidak menampilkan HBM2e dies yang lebih cepat seperti varian A100 PCIe mendatang. Ini juga merupakan jumlah memori terbanyak yang pernah ditampilkan pada kartu grafis berbasis PCIe tetapi jangan berharap kartu grafis konsumen memiliki fitur kapasitas tinggi seperti itu dalam waktu dekat. Yang menarik adalah bahwa peringkat daya tetap tidak berubah, yang berarti bahwa kami mencari chip dengan kepadatan lebih tinggi untuk kasus penggunaan berkinerja tinggi.

Spesifikasi kartu grafis A100 PCIe 80 GB seperti yang tercantum di halaman web NVIDIA. (Kredit Gambar: Videocardz)

Kinerja FP64 masih dinilai pada 9,7/19,5 TFLOPs, kinerja FP32 dinilai pada 19,5/156/312 TFLOPs (Sparsity), kinerja FP16 dinilai pada 312/624 TFLOPs (Sparsity) dan INT8 dinilai pada 624/1248 TOP (Sparsitas). NVIDIA berencana untuk merilis akselerator HPC terbarunya minggu depan dan kami juga dapat memperkirakan harga lebih dari $20.000 AS mengingat varian A100 40 GB dijual seharga sekitar $15.000 AS.

Selain pengumuman ini, NVIDIA juga mengumumkan solusi InfiniBand barunya yang menyediakan konfigurasi hingga 2048 titik NDR 400 Gb/s (atau 4096 port NDR 200) dengan total throughput dua arah 1,64 Pb/s. Itu saja merupakan peningkatan 5x lipat dari generasi sebelumnya dan menawarkan akselerator AI 32x lebih tinggi.

Spesifikasi Tesla A100 Berbasis GPU NVIDIA Ampere GA100:

| Kartu Grafis Tesla NVIDIA | Tesla K40 (PCI-Express) |

Tesla M40 (PCI-Express) |

Tesla P100 (PCI-Express) |

Tesla P100 (SXM2) | Tesla V100 (SXM2) | Tesla V100S (PCIe) | NVIDIA A100 (SXM4) | NVIDIA A100 (PCIe4) |

|---|---|---|---|---|---|---|---|---|

| GPU | GK110 (Kepler) | GM200 (Maxwell) | GP100 (Pascal) | GP100 (Pascal) | GV100 (Volta) | GV100 (Volta) | GA100 (Ampere) | GA100 (Ampere) |

| Node Proses | 28nm | 28nm | 16nm | 16nm | 12nm | 12nm | 7nm | 7nm |

| Transistor | 7,1 Miliar | 8 Miliar | 15,3 Miliar | 15,3 Miliar | 21.1 Miliar | 21.1 Miliar | 54,2 Miliar | 54,2 Miliar |

| Ukuran Die GPU | 551 mm2 | 601 mm2 | 610 mm2 | 610 mm2 | 815mm2 | 815mm2 | 826mm2 | 826mm2 |

| SM | 15 | 24 | 56 | 56 | 80 | 80 | 108 | 108 |

| TPC | 15 | 24 | 28 | 28 | 40 | 40 | 54 | 54 |

| FP32 CUDA Cores Per SM | 192 | 128 | 64 | 64 | 64 | 64 | 64 | 64 |

| FP64 CUDA Cores/SM | 64 | 4 | 32 | 32 | 32 | 32 | 32 | 32 |

| Inti CUDA FP32 | 2880 | 3072 | 3584 | 3584 | 5120 | 5120 | 6912 | 6912 |

| Inti CUDA FP64 | 960 | 96 | 1792 | 1792 | 2560 | 2560 | 3456 | 3456 |

| Inti Tensor | T/A | T/A | T/A | T/A | 640 | 640 | 432 | 432 |

| Unit Tekstur | 240 | 192 | 224 | 224 | 320 | 320 | 432 | 432 |

| Boost Clock | 875 MHz | 1114 MHz | 1329MHz | 1480 MHz | 1530 MHz | 1601 MHz | 1410 MHz | 1410 MHz |

| TOP (DNN/AI) | T/A | T/A | T/A | T/A | 125 TOP | 130 TOP | 1248 TOPs 2496 TOPs dengan Sparsity |

1248 TOPs 2496 TOPs dengan Sparsity |

| Komputasi FP16 | T/A | T/A | 18,7 TFLOP | 21,2 TFLOP | 30,4 TFLOP | 32,8 TFLOP | 312 TFLOP 624 TFLOP dengan Ketersebaran |

312 TFLOP 624 TFLOP dengan Ketersebaran |

| Komputasi FP32 | 5,04 TFLOP | 6,8 TFLOP | 10,0 TFLOP | 10,6 TFLOP | 15,7 TFLOP | 16,4 TFLOP | 156 TFLOP (19,5 TFLOP standar) |

156 TFLOP (19,5 TFLOP standar) |

| Komputasi FP64 | 1,68 TFLOP | 0,2 TFLOP | 4,7 TFLOP | 5,30 TFLOP | 7,80 TFLOP | 8,2 TFLOP | 19,5 TFLOP (9,7 TFLOP standar) |

19,5 TFLOP (standar 9,7 TFLOP) |

| Antarmuka Memori | GDDR5 384-bit | 384-bit GDDR5 | 4096-bit HBM2 | 4096-bit HBM2 | 4096-bit HBM2 | 4096-bit HBM2 | 6144-bit HBM2e | 6144-bit HBM2e |

| Ukuran Memori | 12 GB GDDR5 @ 288 GB/dtk | 24 GB GDDR5 @ 288 GB/dtk | 16 GB HBM2 @ 732 GB/dtk 12 GB HBM2 @ 549 GB/dtk |

16 GB HBM2 @ 732 GB/dtk | 16 GB HBM2 @ 900 GB/dtk | 16 GB HBM2 @ 1134 GB/dtk | Hingga 40 GB HBM2 @ 1,6 TB/dtk Hingga 80 GB HBM2 @ 1,6 TB/s |

Hingga 40 GB HBM2 @ 1,6 TB/dtk Hingga 80 GB HBM2 @ 2,0 TB/dt |

| Ukuran Cache L2 | 1536 KB | 3072 KB | 4096 KB | 4096 KB | 6144 KB | 6144 KB | 40960 KB | 40960 KB |

| TDP | 235W | 250W | 250W | 300W | 300W | 250W | 400W | 250W |