https://br.atsit.in/it/wp-content/uploads/2021/06/lancio-dellacceleratore-pcie-nvidia-a100-da-80-gb-lammiraglia-ampere-ottiene-una-larghezza-di-banda-di-2-tb-s-per-i-nuovi-sistemi-hgx-a100-6.png”>

NVIDIA ha ha annunciato che lancia oggi i suoi nuovissimi sistemi HGX A100 che incorporano gli acceleratori GPU PCIe A100 aggiornati con il doppio della memoria e una larghezza di banda più veloce per gli utenti HPC.

NVIDIA aggiorna i sistemi HGX A100 con acceleratori GPU HPC A100 basati su ampere di punta: 80 GB di memoria HBM2e e larghezza di banda di 2 TB/s

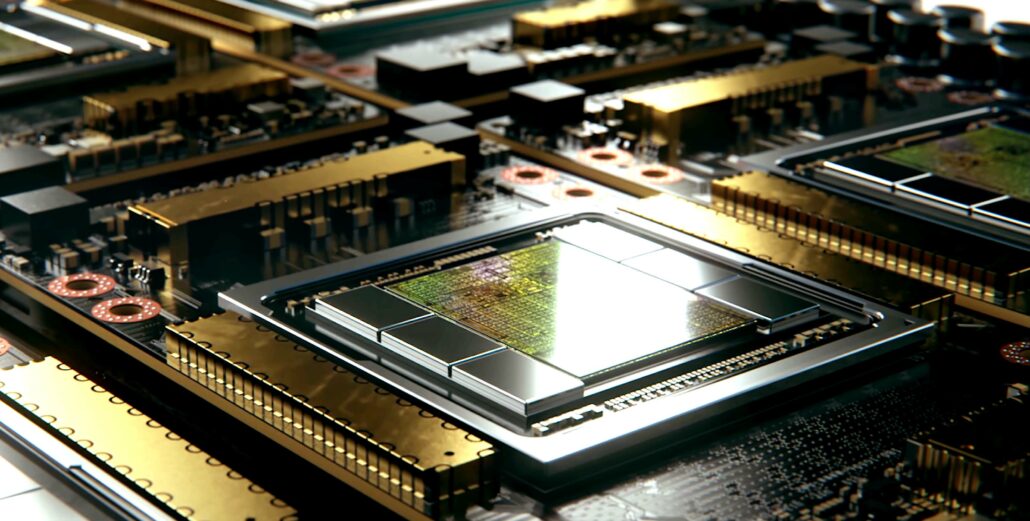

L’attuale acceleratore HPC NVIDIA A100 è stato introdotto lo scorso anno a giugno e sembra che il team verde stia pianificando di dargli un importante aggiornamento delle specifiche. Il chip è basato sulla GPU Ampere più grande di NVIDIA, l’A100, che misura 826 mm2 e ospita un folle 54 miliardi di transistor. NVIDIA offre ai suoi acceleratori HPC un potenziamento delle specifiche durante la metà del ciclo, il che significa che sentiremo parlare degli acceleratori di prossima generazione al GTC 2022.

Le GPU Tensor Core NVIDIA A100 offrono un’accelerazione HPC senza precedenti per risolvere complesse sfide di intelligenza artificiale, analisi dei dati, training di modelli e simulazione rilevanti per l’HPC industriale. Le GPU PCIe A100 da 80 GB aumentano la larghezza di banda della memoria GPU del 25% rispetto all’A100 da 40 GB, a 2 TB/s, e forniscono 80 GB di memoria HBM2e a larghezza di banda elevata.

L’enorme capacità di memoria del PCIe A100 da 80 GB e l’elevata larghezza di banda della memoria consentono di conservare in memoria più dati e reti neurali più grandi, riducendo al minimo la comunicazione internodo e il consumo energetico. In combinazione con una larghezza di banda della memoria più veloce, consente ai ricercatori di ottenere un throughput più elevato e risultati più rapidi, massimizzando il valore dei loro investimenti IT.

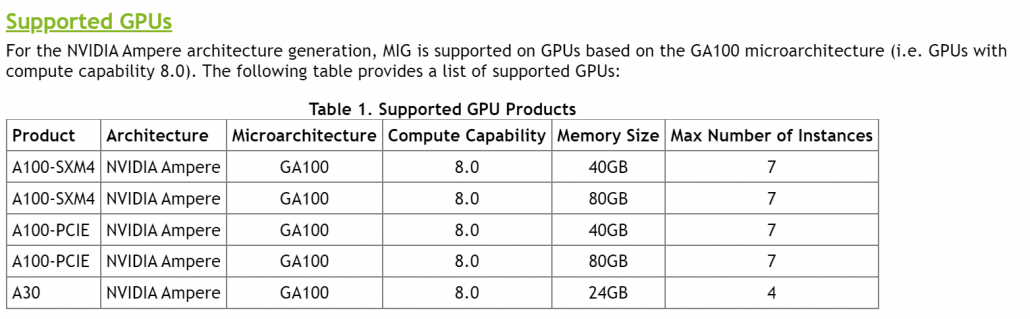

A100 PCIe da 80 GB è alimentato dall’architettura NVIDIA Ampere, che presenta la tecnologia Multi-Instance GPU (MIG) per fornire accelerazione per carichi di lavoro più piccoli come l’inferenza AI. MIG consente ai sistemi HPC di ridimensionare l’elaborazione e la memoria con una qualità del servizio garantita. Oltre a PCIe, esistono configurazioni NVIDIA HGX A100 a quattro e otto vie.

Il supporto dei partner NVIDIA per PCIe A100 da 80 GB include Atos, Cisco, Dell Technologies, Fujitsu, H3C, HPE, Inspur, Lenovo, Penguin Computing, QCT e Supermicro. La piattaforma HGX con GPU basate su A100 interconnesse tramite NVLink è disponibile anche tramite i servizi cloud di Amazon Web Services, Microsoft Azure e Infrastruttura cloud Oracle.

In termini di specifiche, l’acceleratore GPU PCIe A100 non cambia molto in termini di configurazione del core. La GPU GA100 mantiene le specifiche che abbiamo visto sulla variante da 250 W con 6912 core CUDA disposti in 108 unità SM, 432 Tensor Core e 80 GB di memoria HBM2e che offre una larghezza di banda maggiore di 2,0 TB/s rispetto a 1,55 TB/s su la variante da 40 GB.

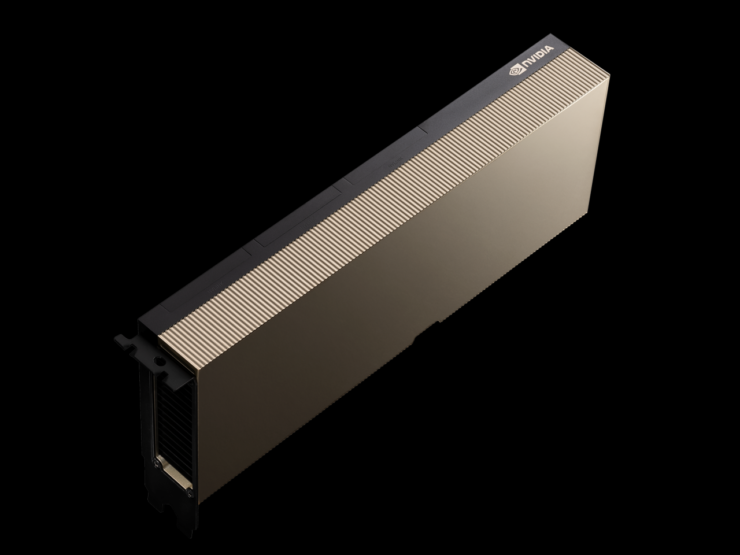

La variante A100 SMX è già dotata di 80 GB di memoria ma non presenta i più veloci die HBM2e come questa prossima variante A100 PCIe. Questa è anche la quantità di memoria più grande mai presente su una scheda grafica basata su PCIe, ma non aspettarti che le schede grafiche consumer presentino capacità così elevate in tempi brevi. La cosa interessante è che la potenza nominale rimane invariata, il che significa che stiamo cercando chip a densità più elevata per casi d’uso ad alte prestazioni.

Specifiche della scheda grafica A100 PCIe da 80 GB come elencato nella pagina web di NVIDIA. (Crediti immagine: Videocardz)

Le prestazioni dell’FP64 sono ancora valutate a 9,7/19,5 TFLOP, le prestazioni dell’FP32 sono valutate a 19,5/156/312 TFLOP (Sparsity), le prestazioni dell’FP16 sono valutate a 312/624 TFLOP (Sparsity) e l’INT8 è valutato a 624/1248 TOP (Sparsity). NVIDIA sta pianificando di rilasciare il suo ultimo acceleratore HPC la prossima settimana e possiamo anche aspettarci un prezzo di oltre $ 20.000 USA considerando che la variante A100 da 40 GB viene venduta per circa $ 15.000 USA.

Oltre a questi annunci, NVIDIA ha anche annunciato la sua nuova soluzione InfiniBand che fornisce configurazioni fino a 2048 punti di NDR 400 Gb/s (o 4096 porte di NDR 200) con un throughput bidirezionale totale di 1,64 Pb/S. Questo da solo è un aumento di 5 volte rispetto alla generazione precedente e offre un acceleratore AI 32 volte superiore.

Specifiche Tesla A100 basate su GPU NVIDIA Ampere GA100:

| Scheda grafica NVIDIA Tesla | Tesla K40 (PCI-Express) |

Tesla M40 (PCI-Express) |

Tesla P100 (PCI-Express) |

Tesla P100 (SXM2) | Tesla V100 (SXM2) | Tesla V100S (PCIe) | NVIDIA A100 (SXM4) | NVIDIA A100 (PCIe4) | |

|---|---|---|---|---|---|---|---|---|---|

| GPU | GK110 (Kepler) | GM200 (Maxwell) | GP100 (Pascal) | GP100 (Pascal) | GV100 (Volta) | GV100 (Volta) | GA100 (Ampere) | GA100 (Ampere) | |

| Nodo di processo | 28nm | 28nm | 16nm | 16nm | 12nm | 12nm | 7nm | 7nm | |

| Transistor | 7,1 miliardi | 8 miliardi | 15,3 miliardi | 15,3 miliardi | 21,1 miliardi | 21,1 miliardi | 54,2 miliardi | 54,2 miliardi | |

| Dimensione matrice GPU | 551 mm2 | 601 mm2 | 610 mm2 | 610 mm2 | 815 mm2 | 815 mm2 | 826 mm2 | 826mm2 | |

| SM | 15 | 24 | 56 | 56 | 80 | 80 | 108 | 108 | |

| TPC | 15 | 24 | 28 | 28 | 40 | 40 | 54 | 54 | |

| Core CUDA FP32 per SM | 192 | 128 | 64 | 64 | 64 | 64 | 64 | 64 | |

| FP64 CUDA Core/SM | 64 | 4 | 32 | 32 | 32 | 32 | 32 | 32 | |

| FP32 CUDA Core | 2880 | 3072 | 3584 | 3584 | 5120 | 5120 | 6912 | 6912 | |

| FP64 CUDA Core | 960 | 96 | 1792 | 1792 | 2560 | 2560 | 3456 | 3456 | |

| Nuclei tensori | N/D | N/D | N/D | N/D | 640 | 640 | 432 | 432 | |

| Unità di trama | 240 | 192 | 224 | 224 | 320 | 320 | 432 | 432 | |

| Boost clock | classe 875 MHz | 1329 MHz | 1480 MHz | 1530 MHz | 1601 MHz | 1410 MHz | 1410 MHz | ||

| TOP (DNN/AI) | N/D | N/D | N/D | N/D | 125 TOP | 130 TOP | 1248 TOP 2496 TOP con Sparsity |

1248 TOP 2496 TOP con Sparsity |

|

| Calcolo FP16 | N/A | N/D | 18.7 TFLOP | 21.2 TFLOP | 30,4 TFLOP | 32,8 TFLOP | 312 TFLOP 624 TFLOP con scarsità |

312 TFLOP 624 TFLOP con scarsità |

|

| Calcolo FP32 | 5.04 TFLOP | 5.04 TFLOPs | 6.8 TFLOP | 10.0 TFLOP | 10.6 TFLOP | 15.7 TFLOP | 16.4 TFLOP | 156 TFLOP (19.5 TFLOP standard) |

156 TFLOP (19.5 TFLOP standard) |

| Calcolo FP64 | 1.68 TFLOPs | 0.2 TFLOP | 4.7 TFLOP | 5.30 TFLOP | 7.80 TFLOP | 8.2 TFLOP | 19.5 TFLOP (9.7 TFLOP standard) |

19,5 TFLOP (9,7 TFLOP standard) |

|

| Interfaccia di memoria | GDDR5 a 384 bit | GDDR5 a 384 bit | HBM2 a 4096 bit | HBM2 a 4096 bit | HBM2 a 4096 bit | HBM2 a 4096 bit | 6144-bit HBM2e | 6144-bit HBM2e | |

| Dimensione memoria | 12 GB GDDR5 @ 288 GB/s | 24 GB GDDR5 a 288 GB/s | 16 GB HBM2 a 732 GB/s 12 GB HBM2 a 549 GB/s |

16 GB HBM2 a 732 GB/s | 16 GB HBM2 a 900 GB/s | 16 GB HBM2 a 1134 GB/s | Fino a 40 GB HBM2 a 1,6 TB/s Fino a 80 GB HBM2 a 1,6 TB/s |

Fino a 40 GB HBM2 a 1,6 TB/s Fino a 80 GB HBM2 a 2,0 TB/s |

|

| Dimensione cache L2 | 1536 KB | 3072 KB | 4096 KB | 4096 KB | 6144 KB | 6144 KB | 40960 KB | 40960 KB | |

| TDP | 235W | 250W | 250W | 300W | 300W | 250W | 400W | 250W |