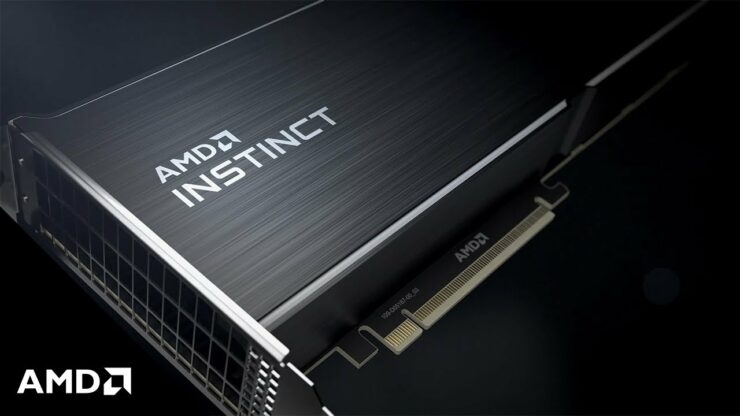

Il CEO di AMD ha confermato che il successore dell’acceleratore HPC per GPU Instinct basato sull’architettura CDNA verrà lanciato entro la fine dell’anno.

AMD Instinct MI200 con architettura GPU MCM CDNA 2 in arrivo entro la fine dell’anno, alimenterà i carichi di lavoro HPC

La conferma è arrivata durante la 49a conferenza annuale di JPMorgan Global Technology Communications and Media. Il CEO di AMD, Lisa Su, ha dichiarato che lancerà la prossima generazione di architettura CDNA entro la fine dell’anno. Di seguito è riportata la trascrizione della conferenza (Fonte: Seeking Alpha ).

L’anno scorso abbiamo parlato della nostra architettura CDNA di prima generazione. Quest’anno, come ho detto, stiamo mettendo insieme la nostra architettura CDNA di nuova generazione. Questo è in realtà un componente chiave che ci ha permesso di vincere le più grandi offerte per supercomputer negli Stati Uniti per la puntata di Frontier Oak Ridge National Labs e per la puntata di Lawrence Livermore National Labs con El Capitan e molti altri.

Ma è un’interconnessione coerente tra CPU e GPU che ci consente di ottimizzare completamente per HPC e per applicazioni AI e ML. E lanceremo la prossima generazione di quell’architettura, in realtà, entro la fine dell’anno. Ne siamo molto entusiasti. Penso che sia andato molto bene. È il prossimo grande passo verso una sorta di innovazione intorno alle architetture dei data center.

Dr. Lisa Su (CEO di AMD)

Ecco tutto ciò che sappiamo sugli acceleratori istinto basati sull’architettura CDNA 2 di AMD

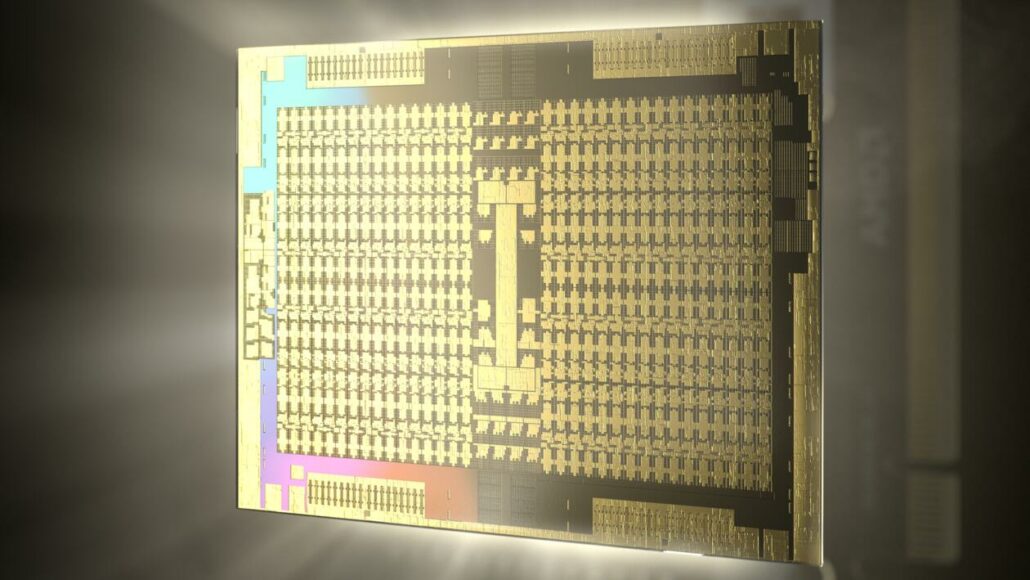

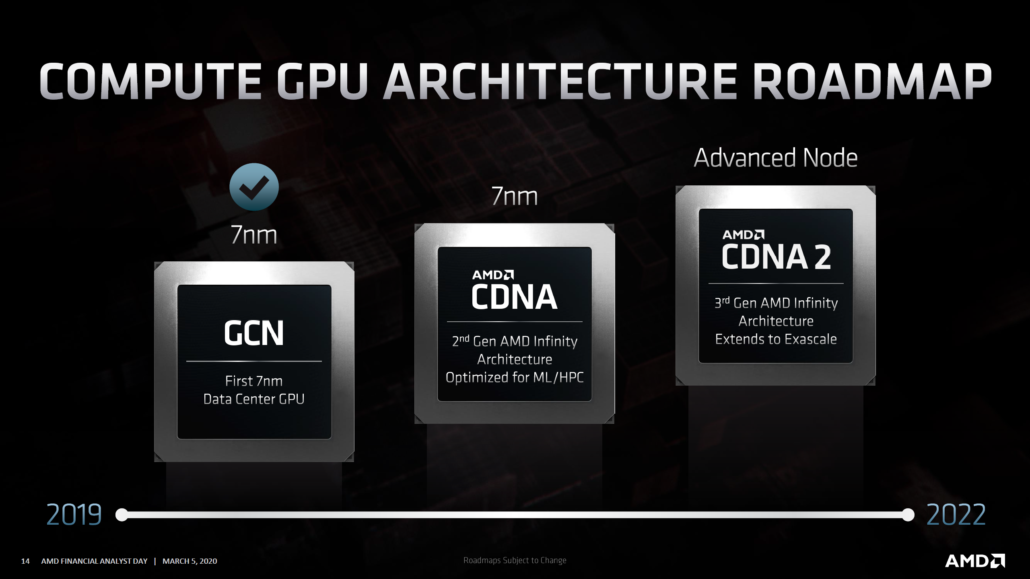

L’architettura AMD CDNA 2 alimenterà gli acceleratori AMD Instinct HPC di prossima generazione. Sappiamo che uno di questi acceleratori sarà l’MI200 che presenterà il target GPU Aldebaran . Sarà un chip molto potente e forse la prima GPU con un design MCM. L’Instinct MI200 competerà contro il Ponte Vecchio a 7nm di Intel e le parti aggiornate di Ampere di NVIDIA. Anche Intel e NVIDIA stanno seguendo il percorso MCM sui loro acceleratori HPC di nuova generazione, ma sembra che Ponte Vecchio sarà disponibile nel 2022 e lo stesso si può dire per acceleratore HPC di nuova generazione di NVIDIA come loro confermata la propria roadmap.

Nella precedente patch di Linux, è stato rivelato che la GPU AMD Instinct MI200″Aldebaran”presenterà il supporto della memoria HBM2E. NVIDIA è stata la prima a salire a bordo dello standard HBM2E e offrirà una bella spinta rispetto alla configurazione HBM2 standard utilizzata sull’acceleratore GPU MI100 basato su Arcturus. HBM2E consente fino a 16 GB di capacità di memoria per stack, quindi possiamo aspettarci fino a 64 GB di memoria HBM2E a velocità incredibilmente elevate per Aldebaran.

L’ultima patch del kernel Linux ha rivelato che la GPU trasporta 16 KB di cache L1 per CU, che costituisce 2 MB della cache L1 totale considerando che la GPU comprenderà 128 Compute Unit. La GPU trasporta anche 8 MB di cache L2 condivisa ma trasporta 14 CU per Shader Engine rispetto alle 16 CU per SE nella precedente formazione Instinct. Indipendentemente da ciò, si afferma che ogni CU sulle GPU Aldebaran avrà un output di calcolo significativamente più alto.

Altre funzionalità elencate includono il supporto SDMA (System Direct Memory Access) che consentirà il trasferimento dei dati sui sottosistemi PCIe e XGMI/Infinity Cache. Fino a Infinity Cache è preoccupato, sembra che non accadrà con le GPU HPC. Tieni presente che la GPU CDNA 2 di AMD sarà fabbricata su un nodo di processo nuovo di zecca e si conferma che sarà dotata di un’architettura AMD Infinity di terza generazione che si estende a Exascale consentendo una connettività GPU coerente fino a 8 vie.

AMD Radeon Instinct Accelerators 2020

| Nome acceleratore | AMD Radeon Instinct MI6 | AMD Radeon Instinct MI8 | AMD Radeon Instinct MI25 | AMD Radeon Instinct MI50 | AMD Radeon Instinct MI60 | AMD Instinct MI100 | AMD Instinct MI100 |

|---|---|---|---|---|---|---|---|

| Architettura GPU | Polaris 10 | Fiji XT | Vega 10 | Vega 20 | Vega 20 | Arcturus | TBA |

| GPU Process Node | 14nm FinFET | 28nm | 14nm FinFET | 7nm FinFET | 7nm FinFET | 7nm FinFET | Nodo di processo avanzato |

| Core GPU | 2304 | 4096 | 4096 | 3840 | 4096 | 7680 | 7680 x 2 (MCM)? |

| Velocità di clock GPU | 1237 MHz | 1000 MHz | 1500 MHz | 1725 MHz | 1800 MHz | ~ 1500 MHz | TBA |

| FP16 Compute | 5.7 TFLOP | 8,2 TFLOP | 24,6 TFLOP | 26,5 TFLOP | 29,5 TFLOP | 185 TFLOP | TBA |

| FP32 Compute | 5.7 TFLOP | 8.2 TFLOP | 12.3 TFLOP | 13.3 TFLOP | 14,7 TFLOP | 23,1 TFLOP | TBA |

| FP64 Compute | 384 GFLOP | 512 GFLOP | 768 GFLOP | 6,6 TFLOP | 7.4 TFLOP | 11.5 TFLOP | TBA |

| VRAM | 16 GB GDDR5 | 4 GB HBM1 | 16 GB HBM2 | 16 GB HBM2 | 32 GB HBM2 | 32 GB HBM2 | TBA |

| Memory Clock | 1750 MHz | 500 MHz | 945 MHz | 1000 MHz | 1000 MHz | 1200 MHz | TBA |

| Bus di memoria | Bus a 256 bit | bus a 4096 bit | bus a 2048 bit | bus a 4096 bit | bus a 4096 bit | bus a 4096 bit | TBA |

| Larghezza di banda della memoria | 224 GB/s | 512 GB/s | 484 GB/s | 1 TB/s | 1 TB/s | 1,23 TB/s | TBA |

| Fattore di forma | Slot singolo, lunghezza intera | Doppio slot, mezza lunghezza | Doppio slot, lunghezza intera | Doppio slot , Lunghezza intera | Doppio slot, lunghezza intera | Doppio slot, lunghezza intera | OAM |

| Raffreddamento | Raffreddamento passivo | Raffreddamento passivo | Raffreddamento passivo | Raffreddamento passivo | Raffreddamento passivo | Raffreddamento passivo | Raffreddamento passivo |

| TDP | 150 W | 175 W | 300 W | 300 W | 300 W | 300 W | TBA |