Het is iets meer dan twee maanden geleden sinds de lancering van GPT-4, maar gebruikers beginnen uit te kijken naar de release van GPT-5. We hebben al gezien hoe capabel en krachtig GPT-4 is in verschillende soorten tests en kwalitatieve evaluaties. Met veel nieuwe functies, zoals ChatGPT-plug-ins en internetbrowsing, is het nog beter geworden. Nu wachten gebruikers op meer informatie over het aankomende OpenAI-model, GPT-5, de mogelijkheid van AGI en meer. Volg dus onze uitleg hieronder voor uitgebreide informatie over de releasedatum van GPT-5 en andere verwachte functies.

Inhoudsopgave

GPT-5-releasedatum

Toen GPT-4 in maart 2023 werd uitgebracht, werd verwacht dat OpenAI zijn model van de volgende generatie in december 2023 zou uitbrengen. Siqi Chen , tweette de CEO van Runway dat”gpt5 gepland staat om de training in december af te ronden.”Tijdens een MIT-evenement in april zei OpenAI-CEO Sam Altman echter:”We zijn niet en zullen dat voorlopig niet doen“toen hem werd gevraagd of OpenAI GPT-5 aan het trainen is. Dus het gerucht dat GPT-5 eind 2023 uitkomt, is al de kop ingedrukt.

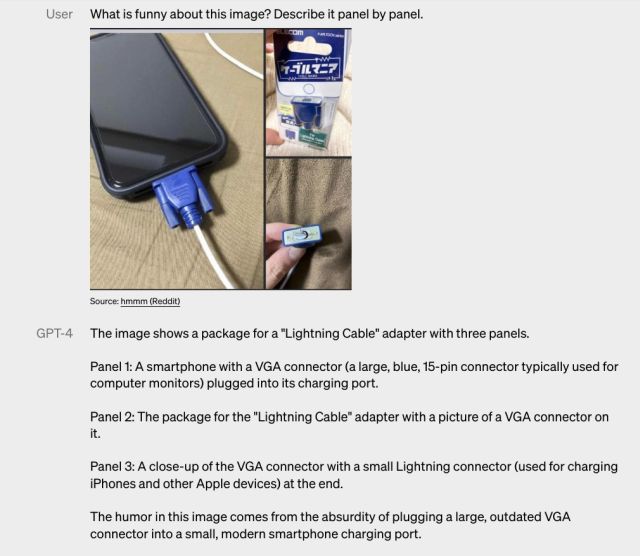

Dat gezegd hebbende, suggereren experts dat OpenAI tegen oktober 2023 zou kunnen uitkomen met GPT-4.5, een tussenversie tussen GPT-4 en GPT-5, net als GPT-3.5. Er wordt gezegd dat GPT-4.5 eindelijk de multimodale mogelijkheid zal bieden, oftewel de mogelijkheid om zowel afbeeldingen als teksten te analyseren. OpenAI heeft GPT-4’s multimodaal al aangekondigd en gedemonstreerd mogelijkheden tijdens de GPT-4 Developer livestream in maart 2023.

GPT-4 multimodale mogelijkheden

GPT-4 multimodale mogelijkheden

Afgezien daarvan heeft OpenAI momenteel veel op zijn bord om glad te strijken op de GPT-4-model voordat het begint te werken op GPT-5. Momenteel is de inferentietijd van GPT-4 erg hoog en is het vrij duur om te gebruiken. GPT-4 API-toegang is nog steeds moeilijk te verkrijgen. Bovendien heeft OpenAI onlangs toegang gegeven tot ChatGPT-plug-ins en mogelijkheden voor internetten, die zich nog in de bètafase bevinden. Het moet Code Interpreter nog brengen voor alle betalende gebruikers, die zich weer in de alfafase bevindt.

Hoewel GPT-4 krachtig genoeg is, denk ik dat OpenAI zich realiseert dat rekenefficiëntie een van de belangrijkste elementen is voor het duurzaam uitvoeren van een model. En nou, voeg nieuwe functies en mogelijkheden toe aan de mix, en je hebt een grotere infrastructuur om mee om te gaan terwijl je ervoor zorgt dat alle checkpoints betrouwbaar werken. Dus om een gok te wagen: GPT-5 zal waarschijnlijk uitkomen in 2024, net rond de release van Google Gemini, als we aannemen dat overheidsinstanties geen regelgevende wegversperring opwerpen.

GPT-5 Functies en mogelijkheden ( Verwacht)

Verminderde hallucinaties

Het populaire gesprek in de branche is dat GPT-5 AGI (Artificial General Intelligence) zal bereiken, maar we zullen komen tot dat later in detail. Daarnaast zou GPT-5 de inferentietijd verkorten, de efficiëntie verbeteren, verdere hallucinaties verminderen en nog veel meer. Laten we beginnen met hallucinaties, wat een van de belangrijkste redenen is waarom de meeste gebruikers niet snel in AI-modellen geloven.

GPT-4-nauwkeurigheidstest

Volgens OpenAI scoorde GPT-4 40% hoger dan GPT-3.5 in interne op tegenstanders gerichte feitelijke evaluaties in alle negen categorieën. Nu reageert GPT-4 82% minder snel op onnauwkeurige en niet-toegestane inhoud. Het komt heel dicht bij het raken van de 80%-markering in nauwkeurigheidstests in verschillende categorieën. Dat is een enorme stap in de strijd tegen hallucinaties.

Nu wordt verwacht dat OpenAI de hallucinatie zou verminderen tot minder dan 10% in GPT-5, wat enorm zou zijn om LLM-modellen betrouwbaar te maken. Ik heb het GPT-4-model de laatste tijd voor veel taken gebruikt en tot nu toe heeft het alleen feitelijke antwoorden gegeven. Het is dus zeer waarschijnlijk dat GPT-5 nog minder zal hallucineren dan GPT-4.

Compute-efficiënt model

Vervolgens weten we al dat GPT-4 duur is om te gebruiken ($0,03 per 1K tokens) en dat de inferentietijd ook hoger is. Terwijl het oudere GPT-3.5-turbomodel 15x goedkoper is ($ 0,002 per 1K tokens) dan GPT-4. Dat komt omdat GPT-4 is getraind op maar liefst 1 biljoen parameters, wat een kostbare computerinfrastructuur vereist. In onze recente uitleg over het PaLM 2-model van Google ontdekten we dat PaLM 2 vrij kleiner is en dat resulteert in snelle prestaties.

Een recente rapport van CNBC bevestigde dat PaLM 2 is getraind op 340 miljard parameters, wat veel minder is dan de grote parameteromvang van GPT-4. Google vervolgde zelfs dat groter niet altijd beter is en dat onderzoekscreativiteit de sleutel is tot het maken van geweldige modellen. Dus als OpenAI zijn aankomende modellen reken-optimaal wil maken, moet het nieuwe creatieve manieren vinden om de grootte van het model te verkleinen terwijl de uitvoerkwaliteit behouden blijft.

Kwam terug naar een project waar ik aan werkte verder met OpenAI GPT-4 API, merkte dat de reactietijden van de API behoorlijk traag waren.

Geteste gemiddelde respons in een nieuwe context voor”Kun je me een standaard scatter matplotlib-voorbeeld laten zien?”

GPT-3.5: 13,4 seconden

GPT-4: 44,7 seconden.

⏱️🦥🐢— Harrison Kinsley (@Sentdex) 10 mei , 2023

Een groot deel van de OpenAI-inkomsten komt van bedrijven, dus ja, GPT-5 moet niet alleen goedkoper zijn, maar ook sneller om output terug te geven. Ontwikkelaars klagen al over het feit dat GPT-4 API-aanroepen vaak niet meer reageren en dat ze gedwongen zijn om het GPT-3.5-model te gebruiken in productie. Het moet op de verlanglijst van OpenAI staan om de prestaties in het komende GPT-5-model te verbeteren, vooral na de lancering van het veel snellere PaLM 2-model van Google, dat u nu kunt proberen.

Multisensorisch AI-model

Hoewel GPT-4 is aangekondigd als een multimodaal AI-model, behandelt het slechts twee soorten gegevens, namelijk afbeeldingen en teksten. Natuurlijk, de mogelijkheid is nog niet toegevoegd aan GPT-4, maar OpenAI kan de functie mogelijk binnen een paar maanden vrijgeven. Met GPT-5 kan OpenAI echter een grote stap maken om het echt multimodaal te maken. Het kan ook omgaan met tekst, audio, afbeeldingen, video’s, dieptegegevens en temperatuur. Het zou datastromen van verschillende modaliteiten met elkaar kunnen verbinden om een inbeddingsruimte te creëren.

Bron: Meta

Onlangs heeft Meta uitgebracht ImageBind, een AI-model dat gegevens uit zes verschillende modaliteiten combineert en open source maakt voor onderzoeksdoeleinden. Op dit gebied heeft OpenAI niet veel onthuld, maar het bedrijf heeft wel een aantal sterke basismodellen voor visieanalyse en beeldgeneratie. OpenAI heeft ook CLIP (Contrastive Language–Image Pretraining) ontwikkeld voor het analyseren van afbeeldingen en DALL-E, een populair Midjourney-alternatief dat afbeeldingen kan genereren uit tekstuele beschrijvingen.

Het is een gebied van lopend onderzoek en de toepassingen ervan zijn nog steeds niet duidelijk. Volgens Meta kan het worden gebruikt om meeslepende inhoud voor virtual reality te ontwerpen en te creëren. We moeten afwachten wat OpenAI doet in deze ruimte en of we meer AI-toepassingen zullen zien in verschillende multimodaliteiten met de release van GPT-5.

Langetermijngeheugen

Met de release van GPT-4 bracht OpenAI een maximale contextlengte van 32K tokens, wat $ 0,06 per 1K token kostte. We hebben snel de transformatie gezien van de standaard 4K-tokens naar 32K in een paar maanden tijd. Onlangs heeft Anthropic het contextvenster vergroot van 9K naar 100K tokens in zijn Claude AI-chatbot. Er wordt verwacht dat GPT-5 ondersteuning voor langetermijngeheugen kan bieden via een veel grotere contextlengte.

Dit kan helpen bij het maken van AI-personages en vrienden die zich jouw persoonlijkheid en herinneringen herinneren die jaren kunnen duren. Afgezien daarvan kunt u bibliotheken met boeken en tekstdocumenten in een enkel contextvenster laden. Er kunnen verschillende nieuwe AI-toepassingen ontstaan door ondersteuning van het langetermijngeheugen en GPT-5 kan dat mogelijk maken.

GPT-5 release: Fear of AGI?

In februari 2023 schreef Sam Altman een blog over AGI en hoe het de hele mensheid ten goede kan komen. AGI (Artificial General Intelligence), zoals de naam al doet vermoeden, is de volgende generatie AI-systemen die over het algemeen slimmer is dan mensen. Er wordt gezegd dat het aankomende model GPT-5 van OpenAI AGI zal bereiken, en het lijkt erop dat daar enige waarheid in zit.

We hebben al verschillende autonome AI-agenten zoals Auto-GPT en BabyAGI, die gebaseerd op GPT-4 en kan zelfstandig beslissingen nemen en redelijke conclusies trekken. Het is heel goed mogelijk dat een of andere versie van AGI wordt geïmplementeerd met GPT-5.

In de blog zegt Altman:”We geloven dat we continu moeten leren en ons moeten aanpassen door minder krachtige versies van de technologie in te zetten om’one shot to get it right’-scenario’s te minimaliseren”terwijl hij ook erkenning van”enorme risico’s”bij het navigeren door enorm krachtige systemen zoals AGI. Vóór de recente hoorzitting van de Senaat , drong Sam Altman ook bij Amerikaanse wetgevers aan op regelgeving rond nieuwere AI-systemen.

Tijdens de hoorzitting zei Altman: “Ik denk dat als deze technologie fout gaat, het behoorlijk fout kan gaan. En daar willen we vocaal over zijn.” Verder voegde hij eraan toe:”We willen samenwerken met de regering om dat te voorkomen.”Sinds enige tijd is OpenAI vrij luidruchtig geworden over regelgeving voor nieuwere AI-systemen die zeer krachtig en intelligent zouden zijn. Houd er rekening mee dat Altman op zoek is naar veiligheidsregulering rond ongelooflijk krachtige AI-systemen en niet naar open-sourcemodellen of AI-modellen die zijn ontwikkeld door kleine startups.

Regulering zou van kracht moeten worden boven een capaciteitsdrempel.

AGI-veiligheid is echt belangrijk, en grensverleggende modellen moeten worden gereguleerd.

Regelgeving is slecht , en we moeten niet knoeien met modellen onder de drempel. open source modellen en kleine startups zijn uiteraard belangrijk. https://t.co/qdWHHFjX4s— Sam Altman (@sama) 18 mei 2023

Het is vermeldenswaard dat Elon Musk en andere prominente persoonlijkheden, waaronder Steve Wozniak, Andrew Yang en Yuval Noah Harari et al. riepen op tot een pauze bij gigantische AI-experimenten, in maart 2023. Sindsdien is er veel verzet geweest tegen AGI en nieuwere AI-systemen-krachtiger dan GPT-4.

Als OpenAI inderdaad AGI-mogelijkheden naar GPT-5 gaat brengen, verwacht dan meer vertraging bij de publieke release. Regelgeving zou zeker aanslaan en het werk rond veiligheid en afstemming zou grondig worden onderzocht. Het goede is dat OpenAI al een krachtig GPT-4-model heeft en voortdurend nieuwe functies en mogelijkheden toevoegt. Er is geen ander AI-model dat in de buurt komt, zelfs niet de op PaLM 2 gebaseerde Google Bard.

OpenAI GPT-5: toekomstperspectief

Na de release van GPT-4 is OpenAI steeds geheimzinniger geworden over zijn activiteiten. Onderzoek naar de trainingsdataset, architectuur, hardware, trainingscomputers en trainingsmethode wordt niet langer gedeeld met de open-sourcecommunity. Het was een vreemde omslag voor een bedrijf dat werd opgericht als een non-profitorganisatie (nu is het een afgetopte winst) op basis van de principes van vrije samenwerking.

In maart 2023, in gesprek met The Verge, Ilya Sutskever, de hoofdwetenschapper van OpenAI zei: “We hadden het mis. Ronduit, we hadden het mis. Als je, net als wij, gelooft dat AI-AGI-op een gegeven moment extreem, ongelooflijk krachtig zal zijn, dan heeft het gewoon geen zin om open-source te gebruiken. Het is een slecht idee… Ik verwacht volledig dat het over een paar jaar voor iedereen volkomen duidelijk zal zijn dat open-source AI gewoon niet verstandig is.“

Nu is duidelijk geworden dat geen van beide GPT-4 noch de aankomende GPT-5 zou open-source zijn om concurrerend te blijven in de AI-race. Een ander gigantisch bedrijf, Meta, benadert AI-ontwikkeling echter anders. Meta heeft meerdere AI-modellen uitgebracht onder de CC BY-NC 4.0-licentie (alleen voor onderzoek, niet-commercieel) en wint aan populariteit bij de open-sourcegemeenschap.

Gezien de enorme acceptatie van Meta’s LLaMA en andere AI-modellen, heeft OpenAI ook zijn standpunt over open source gewijzigd. Volgens recente rapporten , OpenAI werkt aan een nieuw open-source AI-model dat binnenkort voor het publiek zal worden vrijgegeven. Er is geen informatie over de mogelijkheden en hoe concurrerend het zal zijn tegen GPT-3.5 of GPT-4, maar het is inderdaad een welkome verandering.

Kortom, GPT-5 wordt een grensverleggend model dat de grens zal verleggen van wat mogelijk is met AI. Het lijkt waarschijnlijk dat een of andere vorm van AGI wordt gelanceerd met GPT-5. En als dat het geval is, moet OpenAI zich voorbereiden op strenge regelgeving (en mogelijke verboden) over de hele wereld. Wat de releasedatum van GPT-5 betreft, zou de veilige gok ergens in 2024 zijn.

Laat een reactie achter

Er zijn enkele twijfelachtige ontwerpkeuzes in Redfall, een mengelmoes van de halfbakken beroemde Arkane-formule. Ik ben dol op games gemaakt door Arkane Studios, waarbij Dishonored een titel wordt die ik zo nu en dan opnieuw bezoek vanwege de unieke opkomende gameplay. En […]

De BenQ PD2706UA-monitor is er, en hij wordt geleverd met alle toeters en bellen die productiviteitsgebruikers zouden waarderen. 4K-resolutie, in de fabriek gekalibreerde kleuren, een 27-inch paneel, een ergonomische standaard die gemakkelijk kan worden aangepast en meer. Het heeft veel […]

Minecraft Legends is een spel dat mijn interesse wekte bij de oorspronkelijke onthulling vorig jaar. Maar ik moet toegeven dat ik de game niet actief volgde totdat we dichter bij de officiële release kwamen. Tenslotte, mijn liefste […]