NVIDIA udostępnia dziś wiele szybsza wersja TensorRT, jego SDK do zoptymalizowanego wnioskowania głębokiego uczenia się na ich procesorach graficznych..

NVIDIA udostępnia dziś wiele szybsza wersja TensorRT, jego SDK do zoptymalizowanego wnioskowania głębokiego uczenia się na ich procesorach graficznych..

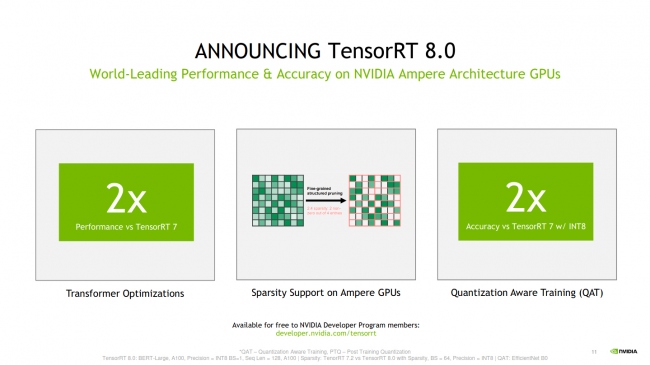

Po upublicznieniu TensorRT 8, NVIDIA zgłasza „podwójną wydajność” w porównaniu z istniejącą wersją TensorRT 7. Ta 2x wydajność dotyczy optymalizacji transformatorów, podczas gdy zapewniają one również 2x dokładność w stosunku do TensorRT 7 podczas korzystania z INT8 z treningiem świadomym kwantyzacji.

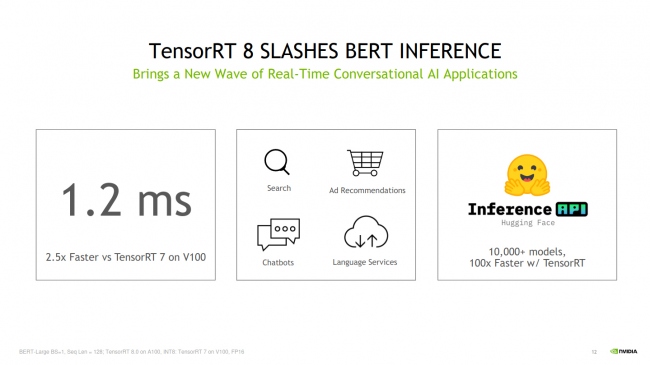

TensorRT 8 również skraca czas wnioskowania BERT-Large do 1,2 ms na V100, co jest 2,5 raza szybciej niż TensorRT 7. TensorRT 8 ma również wsparcie rzadkości dla układów GPU Ampere, między innymi ulepszeń.

TensorRT 8.0 powinien być wkrótce dostępny za pośrednictwem programisty. nvidia.com.