Rozwój sztucznej inteligencji (AI) bez wątpienia przyniósł znaczący postęp w różnych dziedzinach, w tym w przetwarzaniu języka naturalnego i generowaniu tekstu.

Jednak wraz z rosnącym nadużywaniem sztucznej inteligencji w środowiskach akademickich oczywista stała się potrzeba narzędzi do wykrywania pracy generowanej przez sztuczną inteligencję.

Narzędzia te miały na celu utrzymanie integralności instytucji edukacyjnych i zapewnienie, że uczniowie będą tworzyć własne, oryginalne prace.

Czy „pisemne detektory AI” są dokładne?

Niestety, wraz ze wzrostem wykorzystania „pisemnych detektorów AI”, zaczęły pojawiać się nieprzewidziane konsekwencje, powodujące kontrowersje i niesłuszne oskarżenia.

Wraz z pojawieniem się zaawansowanych modeli językowych, takich jak Chat GPT, uczniowie mogli bez wysiłku tworzyć eseje, raporty, a nawet całe artykuły, wykorzystując możliwości sztucznej inteligencji.

To nieetyczne zachowanie wzbudziło obawy wśród nauczycieli i skłoniło do opracowania systemów wykrywania sztucznej inteligencji w celu identyfikacji przypadków treści generowanych przez sztuczną inteligencję.

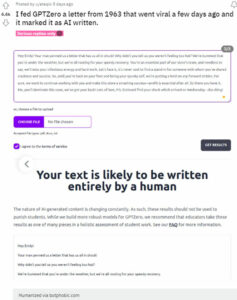

Ale ostatnio użytkownik przekazał GPTZero list z 1963 r., który następnie stał się wirusowy na różnych platformach społecznościowych.

Co zaskakujące, narzędzie do wykrywania sztucznej inteligencji oznaczyło list jako napisany przez sztuczną inteligencję, wywołując efekt niedowierzania i niepokoju.

Źródło (kliknij/dotknij, aby wyświetlić)

Źródło (kliknij/dotknij, aby wyświetlić)

Incydent wzbudził wątpliwości co do dokładności i niezawodność systemów wykrywania sztucznej inteligencji, które zostały wdrożone w celu ochrony integralności.

W następstwie kontrowersji związanych z wirusowymi listami kilka osób zaczęło spekulować na temat potencjalnych błędnych ocen dokonywanych przez systemy wykrywania sztucznej inteligencji (1,2,3,4,5).

Potwierdził to niedawny test przeprowadzony przez The Washington Post na Turnitin, który twierdzi, że ogólna dokładność wynosi 98 procent, ponad połowa esejów przynajmniej częściowo się myliła.

Ponadto w innym teście na Writer, Biblia uzyskała tylko 11 punktów % treści tworzonych przez ludzi, podczas gdy kopiowanie i wklejanie z ChatGPT uzyskało wynik 98% treści tworzonych przez ludzi.

Źródło (kliknij/stuknij, aby wyświetlić)

Źródło (kliknij/stuknij, aby wyświetlić)

Jeśli autentyczny dokument napisany przez człowieka, taki jak list z 1963 r. i Biblia, można oznaczyć jako wygenerowany przez sztuczną inteligencję, to jest prawdopodobne, że niezliczeni uczniowie mogli spotkać się z niesłusznymi karami z powodu błędnego wykrycia sztucznej inteligencji.

Dokładnie tak było w Teksasie, gdzie profesor trafił na pierwsze strony gazet po tym, jak oblał całą klasę maturzystów, twierdząc, że wszyscy używali czatu GTP do pisania swoich zadań.

Ta decyzja doprowadziła do zablokowania ich ukończenia studiów, pozostawiając ich zdruzgotanych, a ich przyszłość akademicka zagrożona.

Źródło (kliknij/dotknij, aby wyświetlić)

Źródło (kliknij/dotknij, aby wyświetlić)

Profesor wyjaśnia, że użył własne konto ChatGPT, aby sprawdzić zadania uczniów. Jeśli sztuczna inteligencja twierdziła, że wygenerowała treść, uczniowie otrzymywali ocenę zerową.

Takie przypadki można było zobaczyć na Twitterze, gdzie uczniowie twierdzili, że niesłusznie ponieśli porażkę, ponieważ nauczyciel nie wiedział, jak korzystać z tych narzędzi lub z powodu błędnych wyników z nich (1,2,3).

Zabawne, prawie oblałem kurs historii na studiach z powodu jednego z tych wykrywaczy plagiatu AI. Coś się zepsuło i oskarżyłem moją ostatnią pracę o wojnie w Toledo o to, że została napisana przez jakiegoś słowiańskiego autora, który pisał wyłącznie o sowieckiej kontroli nad Europą Wschodnią.

Źródło

W odpowiedzi na te niepokojące rewelacje powstała witryna edukacyjna „itwasntai.com” została założona w celu udzielania wskazówek osobom, które zostały niesłusznie oskarżone o wykorzystywanie sztucznej inteligencji do pisania swoich prac.

Ta platforma ma również na celu kształcenie nauczycieli i wzmacnianie pozycji tych, którzy mogli paść ofiarą wadliwych systemów wykrywania sztucznej inteligencji.

Źródło (kliknij/stuknij, aby wyświetlić)

Źródło (kliknij/stuknij, aby wyświetlić)

Istnienie takiej witryny podkreśla pilną potrzebę kompleksowego przeglądu wykrywania sztucznej inteligencji narzędzia i rozwój dokładniejszych i bardziej niezawodnych metod.

Ta kontrowersja wokół detektorów napisanych przez sztuczną inteligencję nieuchronnie wzbudziła obawy dotyczące ślepego zaufania pokładanego w tych systemach.

Powstaje pytanie: jeśli nie możemy w pełni ufać samym treściom generowanym przez sztuczną inteligencję, dlaczego ślepo ufaliśmy wykrywaczom stworzonym przez sztuczną inteligencję?