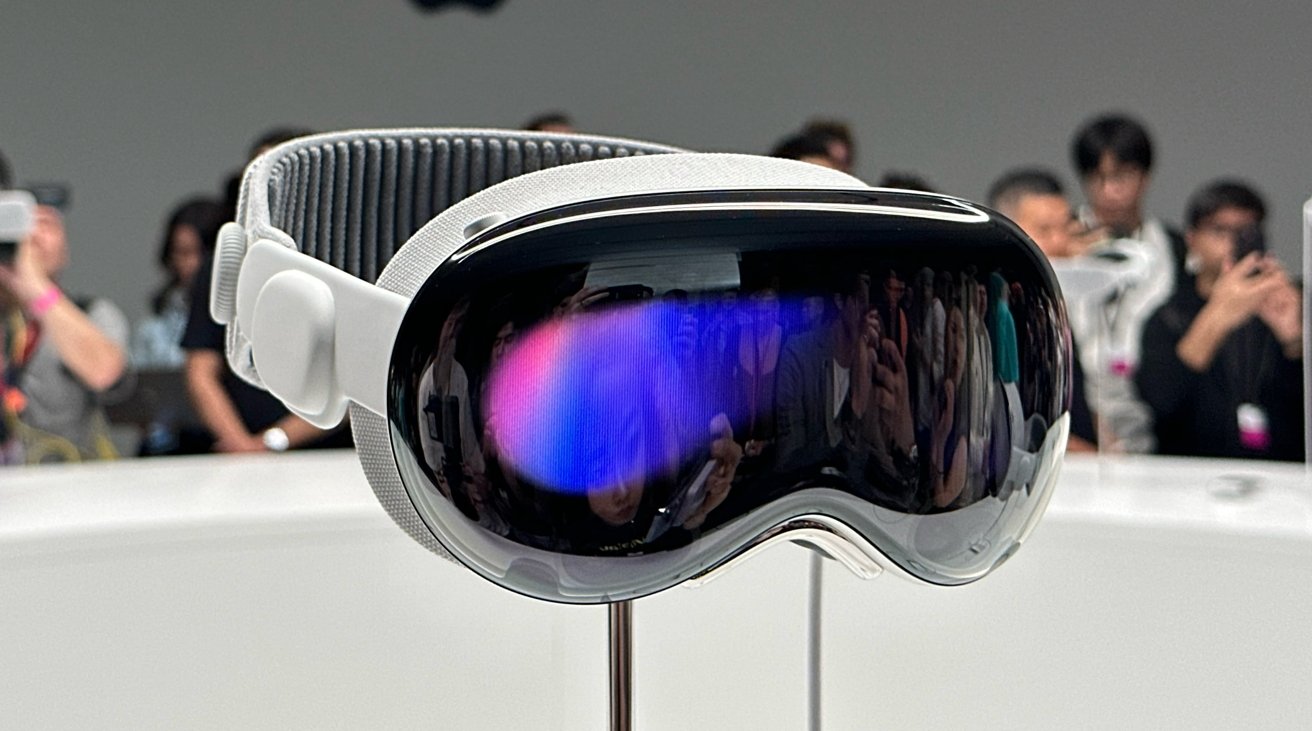

Apple Vision Pro wymagało wielu neuronauki, aby opracować niektóre z jego kluczowych funkcji, według byłego inżyniera Apple, opierając się na różnych sztuczkach, aby określić, co dana osoba może zrobić w interfejsie.

Główny interfejs zestawu słuchawkowego Apple Vision Pro opiera się na nawigacji za pomocą śledzenia wzroku i gestów, przy czym system musi jak najszybciej określić, na co patrzy użytkownik. W poniedziałkowym poście na Twitterze kurtyna zostaje odsłonięta, by ujawnić niektóre z wczesnych myśli, które weszły do projektu.

Sterling Crispin przez ponad trzy lata pracował jako badacz prototypów neurotechnologii w grupie ds. rozwoju technologii w firmie Apple, najdłużej „pracując nad pojedynczym przedsięwzięciem”. Tam pracował nad elementami, które wspierały fundamentalny rozwój zestawu słuchawkowego, w tym „doświadczeniami uważności” i innymi „ambitnymi badaniami nad księżycem z neurotechnologią”.

Crispin porównał to na przykład do „czytania w myślach”, np. przewidywanie, co użytkownik kliknie, zanim to zrobi.

Crispin, „dumny z wkładu w tworzenie wstępnej wizji” zestawu słuchawkowego, należał do niewielkiego zespołu, który „pomagał zapalić zielone światło dla tej ważnej kategorii produktów”, która jego zdaniem „pewnego dnia może mieć znaczący globalny wpływ.”

Chociaż większość jego prac jest nadal objęta NDA, Crispin może nadal omawiać szczegóły, które zostały upublicznione w patentach.

Stany psychiczne

Praca Crispina polegała na wykrywaniu stanu psychicznego użytkowników na podstawie danych zebranych „z ich ciała i mózgu, kiedy byli w immersyjnych doświadczeniach”.

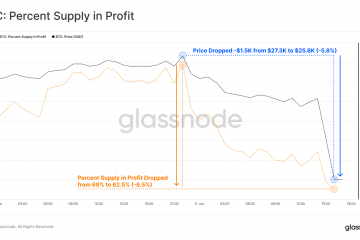

Korzystając ze śledzenia ruchu gałek ocznych, aktywności elektrycznej, bicia serca, aktywności mięśni, ciśnienia krwi, przewodnictwa skóry i innych wskaźników, modele sztucznej inteligencji mogą próbować przewidzieć myśli użytkownika. „Modele sztucznej inteligencji próbują przewidzieć, czy czujesz się ciekawy, błądzisz myślami, boisz się, zwracasz uwagę, pamiętasz przeszłe doświadczenia lub jakiś inny stan poznawczy” – pisze Crispin.

Jeden z „najfajniejsze wyniki” polegały na przewidywaniu, kiedy użytkownik coś kliknie, zanim to zrobi.

„Twój uczeń reaguje, zanim klikniesz, po części dlatego, że spodziewasz się, że coś się stanie po kliknięciu” — wyjaśnia Crispin. „Możesz więc tworzyć biologiczne sprzężenie zwrotne z mózgiem użytkownika, monitorując zachowanie jego oczu i przeprojektowując interfejs użytkownika w czasie rzeczywistym, aby uzyskać więcej przewidywalnej reakcji źrenicy”.

Porównuje to do „prymitywnego interfejsu komputerowego mózgu za pośrednictwem oczu”, który mógłby przejąć „inwazyjną operację mózgu każdego dnia”.

Wpływanie na użytkownika

Kolejna sztuczka służąca do określania stanu polega na wyświetlaniu użytkownikom migających obrazów lub odtwarzaniu dźwięków w sposób, którego nie postrzegają, a następnie mierzeniu reakcja na ten bodziec.

W jednym innym patencie wyjaśniono, w jaki sposób można wykorzystać uczenie maszynowe i sygnały ciała do przewidywania, na czym użytkownik się koncentruje, czy jest zrelaksowany, lub do określania, jak dobrze się uczy. Korzystając z tych informacji i stanu, system może dostosować środowisko wirtualne, aby poprawić wymagany stan.

Crispin dodaje, że jest „mnóstwo innych rzeczy Byłem zaangażowany w”, które nie pojawiły się w patentach i ma nadzieję, że pojawi się więcej w przyszłości.

Chociaż ogólnie jesteśmy zadowoleni z wpływu Vision Pro, nadal istnieje ostrzeżenie, że „jest to wciąż jeden krok naprzód na drodze do VR” i że może minąć jeszcze dekada, zanim branża całkowicie nadrobić zaległości.