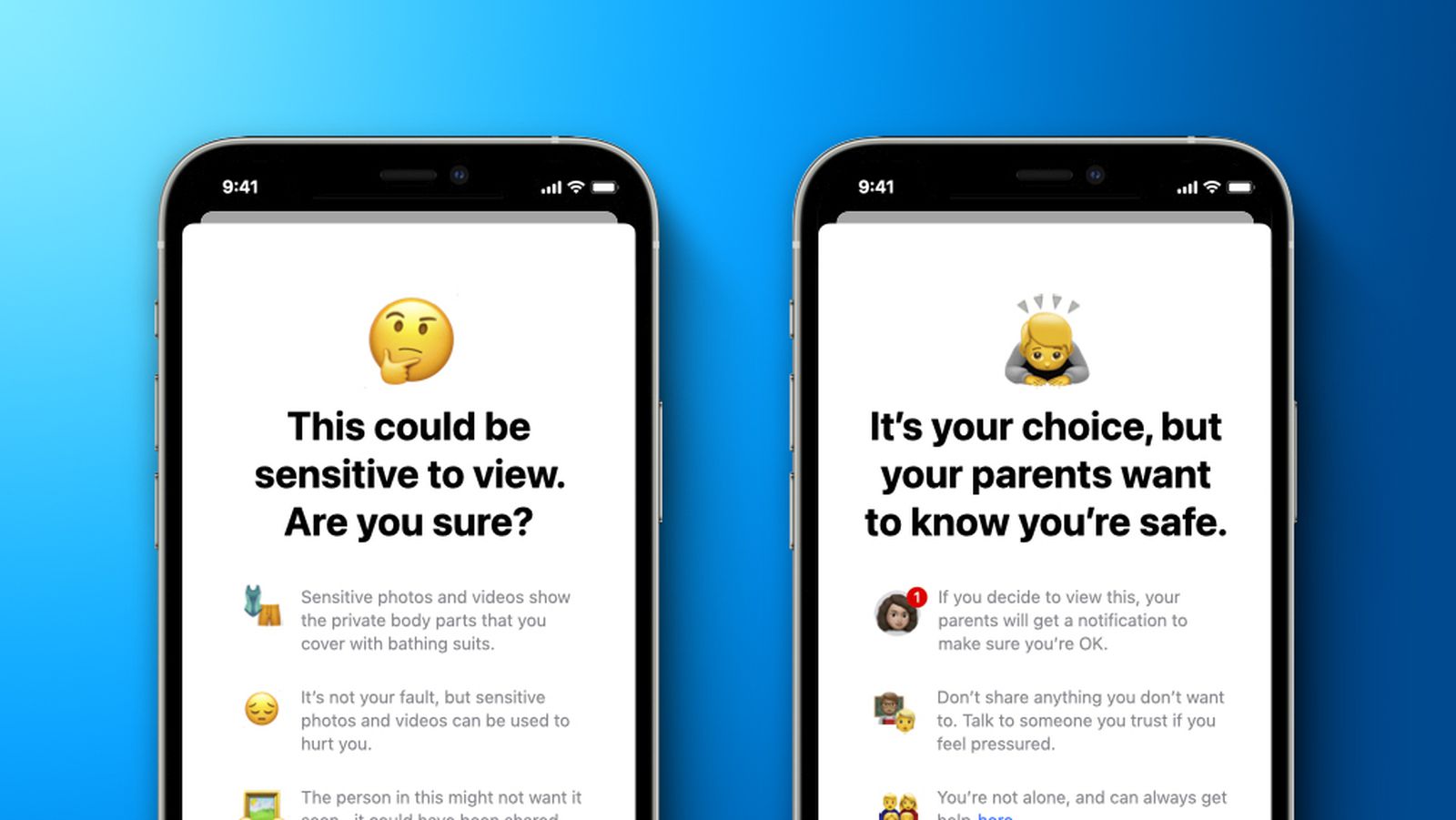

Во-первых, приложение”Сообщения”на iPhone, iPad и Mac получит новую функцию безопасности общения, чтобы предупреждать детей и их родители при получении или отправке фотографий откровенно сексуального характера. Apple заявила, что приложение «Сообщения» будет использовать машинное обучение на устройстве для анализа вложенных изображений, и если будет установлено, что фотография носит откровенно сексуальный характер, фотография будет автоматически размыта, а ребенок получит предупреждение.

Когда ребенок пытается просмотреть фотографию, помеченную как конфиденциальная в приложении «Сообщения», он будет предупрежден о том, что фотография может содержать личные части тела и что фотография может быть оскорбительной. В зависимости от возраста ребенка у родителей также будет возможность получать уведомление, если их ребенок перейдет к просмотру конфиденциальной фотографии или если они решат отправить откровенно сексуальную фотографию другому контакту после предупреждения.

Apple сообщила, что новая функция безопасности связи появится в обновлениях iOS 15, iPadOS 15 и macOS Monterey в конце этого года для учетных записей, созданных как семьи в iCloud. Apple гарантирует, что разговоры iMessage будут по-прежнему защищены с помощью сквозного шифрования, что сделало частные сообщения нечитаемыми для Apple.

Сканирование фотографий на предмет материалов о сексуальном насилии над детьми (CSAM)

Во-вторых, начиная с этого года с iOS 15 и iPadOS 15, Apple сможет обнаруживать известные изображения материалов о сексуальном насилии над детьми (CSAM), хранящиеся в iCloud Photos, что позволяет Apple сообщать об этих случаях в Национальный центр пропавших без вести и эксплуатируемых детей (NCMEC), некоммерческую организацию, которая работает в сотрудничестве с правоохранительными органами США.

Apple заявила, что ее метод обнаружения известных CSAM разработан с учетом конфиденциальности пользователей. Apple заявила, что вместо сканирования изображений в облаке система будет выполнять сопоставление на устройстве с базой данных известных хэшей изображений CSAM, предоставленной NCMEC и другими организациями по безопасности детей. Apple заявила, что в дальнейшем преобразует эту базу данных в нечитаемый набор хэшей, который будет надежно храниться на устройствах пользователей.

Технология хеширования, называемая NeuralHash, анализирует изображение и преобразует его в уникальный номер, соответствующий этому изображения, согласно Apple.

«Основная цель хэша-гарантировать, что идентичные и визуально похожие изображения приводят к одному и тому же хешу, в то время как изображения, которые отличаются друг от друга, приводят к разным хешам»,-сказал Apple в новом информационном документе «Расширенная защита детей». «Например, изображение, которое было слегка обрезано, изменено в размере или преобразовано из цветного в черно-белое, обрабатывается идентично исходному и имеет тот же хэш».

Перед сохранением изображения в Фото iCloud , Apple сообщила, что на устройстве выполняется процесс сопоставления этого изображения с нечитаемым набором известных хэшей CSAM. В случае совпадения устройство создает ваучер криптографической безопасности. Этот ваучер загружается в iCloud Photos вместе с изображением, и после превышения нераскрытого порога совпадений Apple может интерпретировать содержимое ваучеров для совпадений CSAM. Затем Apple вручную просматривает каждый отчет, чтобы подтвердить совпадение, отключает учетную запись iCloud пользователя и отправляет отчет в NCMEC. Apple не сообщает точный порог, но гарантирует «чрезвычайно высокий уровень точности», что учетные записи не помечаются неправильно.

Apple заявила, что ее метод обнаружения известного CSAM обеспечивает «значительные преимущества конфиденциальности» по сравнению с существующими методами:

• Эта система является эффективным способом идентификации известных CSAM, хранящихся в iCloud Photos. учетные записи, одновременно защищая конфиденциальность пользователей.

• В рамках этого процесса пользователи также не могут ничего узнать о наборе известных образов CSAM, которые используются для сопоставления. Это защищает содержимое базы данных от злонамеренного использования.

• Система очень точная, с чрезвычайно низким уровнем ошибок-менее одной на один триллион учетной записи в год.

• Система значительно более защищает конфиденциальность чем облачное сканирование, поскольку оно сообщает только о пользователях, у которых есть набор известных CSAM, хранящихся в iCloud Photos.

Базовая технология, лежащая в основе метода Apple обнаружения известных совпадений CSAM, довольно сложна, и Apple публикует техническое резюме с более подробной информацией. Apple также запускает новую целевую страницу по безопасности детей на своем веб-сайте.

«Расширенная защита Apple. для детей меняет правила игры. Поскольку так много людей используют продукты Apple, эти новые меры безопасности могут спасти жизнь детям, которых заманивают в сети и чьи ужасающие изображения распространяются в материалах о сексуальном насилии над детьми”,-сказал Джон Кларк, президент и Генеральный директор Национального центра пропавших без вести и эксплуатируемых детей. «В Национальном центре по делам пропавших без вести и эксплуатируемых детей мы знаем, что с этим преступлением можно бороться только в том случае, если мы будем непоколебимы в нашей приверженности защите детей. Мы можем сделать это только потому, что технологические партнеры, такие как Apple, активизируются и заявляют о своей приверженности. реальность такова, что конфиденциальность и защита детей могут сосуществовать. Мы аплодируем Apple и надеемся на совместную работу, чтобы сделать этот мир более безопасным для детей ».

Расширенное руководство CSAM в Siri и Поиске

В-третьих, Apple заявила, что будет расширять рекомендации в Siri и Spotlight Search на всех устройствах, предоставляя дополнительные ресурсы, чтобы помочь детям и родителям оставаться в безопасности в Интернете и получать помощь в небезопасных ситуациях. Например, пользователи, которые спрашивают Siri, как они могут сообщить об эксплуатации CSAM или детей, будут указаны в ресурсах, где и как отправить отчет.

Обновления Siri и поиска появятся позже в этом году в виде обновления. до iOS 15, iPadOS 15, watchOS 8 и macOS Monterey, согласно Apple.

Примечание. В связи с политическим или социальным характером обсуждения этой темы, ветка обсуждения находится в нашем Форум политических новостей . Все участники форума и посетители сайта могут читать и подписываться на эту тему, но публикация сообщений ограничена участниками форума, имеющими не менее 100 сообщений.