В четверг Apple объявила о трех новых усилиях, направленных на добавление новых функций защиты от детей на iPhone, iPad и Mac в США. Теперь компания решила проблемы во внутренней служебной записке.

В четверг Apple объявила о трех новых усилиях, направленных на добавление новых функций защиты от детей на iPhone, iPad и Mac в США. Теперь компания решила проблемы во внутренней служебной записке.

Apple заявляет, что продолжит объяснять и детализировать функции

Распространено среди команд, которые работали над инициативой и получено 9to5Mac , во внутренней заметке Apple подтверждает недавние «недоразумения» и опасения по поводу последствий использования технологии. Тем не менее, компания заявляет, что «продолжит объяснять и детализировать функции, чтобы люди понимали», что было создано. Между тем, Apple заявляет, что «впереди много тяжелой работы, чтобы реализовать функции в ближайшие несколько месяцев.. »

Критика до сих пор была сосредоточена в первую очередь на планах Apple сканировать фотографии iCloud на предмет материалов о сексуальном насилии над детьми (CSAM), при этом многие утверждали, что эта функция может открыть двери для других, более тревожных способов наблюдения.

Одним из самых громких критиков на данный момент является Эдвард Сноуден, который сказал следующее: «Какими бы благими намерениями Apple ни была, с помощью этого развертывает массовую слежку по всему миру. Не заблуждайтесь: если они могут сканировать детское порно сегодня, они могут сканировать что угодно завтра ».

Полная внутренняя памятка, отправленная сотрудникам Apple и написанная вице-президентом по программному обеспечению Себастьяном Марино-Месом, находится ниже:

Сегодня знаменует собой официальное публичное открытие Расширенной защиты детей, и я хотел воспользоваться моментом, чтобы поблагодарить каждого из вас за всю вашу тяжелую работу за последние несколько лет. Мы не достигли бы этого рубежа без вашей неустанной преданности делу и стойкости.

Обеспечение безопасности детей-такая важная задача. В истинном стиле Apple для достижения этой цели потребовалась глубокая кросс-функциональная приверженность, охватывающая инженерное дело, GA, HI, юриспруденцию, маркетинг продуктов и PR. То, что мы объявили сегодня, является продуктом этого невероятного сотрудничества, которое предоставляет инструменты для защиты детей, но также поддерживает глубокую приверженность Apple конфиденциальности пользователей.

Сегодня мы получили много положительных отзывов. Мы знаем, что у некоторых людей есть недопонимание, и многие обеспокоены последствиями, но мы продолжим объяснять и детализировать функции, чтобы люди понимали, что мы создали. И хотя впереди предстоит большая тяжелая работа по реализации функций в следующие несколько месяцев, я хотел бы поделиться этой запиской, которую мы получили сегодня от NCMEC. Я нашел это невероятно мотивирующим и надеюсь, что и вы тоже.

Я горжусь тем, что работаю в Apple с такой замечательной командой. Спасибо!

Из чего состоят функции Apple по защите детей?

iCloud

Для борьбы с распространением материалов о сексуальном насилии над детьми, контента, изображающего действия откровенно сексуального характера, связанные с ребенок, Apple добавляет функцию обнаружения CSAM в свой сервис iCloud Photos. Перед загрузкой фотографий в iCloud Photos устройства Apple теперь будут анализировать изображения, чтобы найти любые совпадения с базой данных изображений CSAM, предоставленной Национальным центром пропавших без вести и использованных. Дети.

Apple утверждает, что преобразовала базу данных в «нечитаемый набор хэшей, который надежно хранится на устройствах пользователей». Процесс сопоставления обеспечивается криптографическими сертификатами безопасности, которые кодируют результаты сопоставления.

Apple не может интерпретировать содержимое сертификатов безопасности, если не установлен определенный порог содержания CSAM. Если этот порог будет достигнут, Apple вручную проверит отчет, чтобы подтвердить любые совпадения и отключить учетную запись пользователя.

Кроме того, компания заявляет, что отправит отчет в Национальный центр пропавших без вести и эксплуатируемых детей.

Важно отметить, что эта функция в настоящее время ограничена Соединенными Штатами, хотя Apple надеется расширить ее в будущем. Кроме того, фотографии, хранящиеся только на устройстве, не включаются в процесс сканирования.

Сообщения

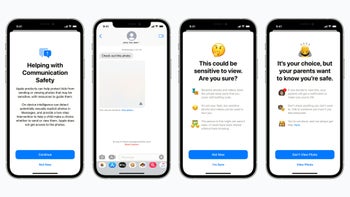

Наряду со спорными планами iCloud Photos, Apple представила новую функцию безопасности связи. в приложении”Сообщения”для детей, которые являются членами семьи iCloud.

Эта функция использует машинное обучение на устройстве для анализа содержимого фотографий. Если ребенок получает изображение откровенно сексуального характера, ребенок увидит предупреждение, и изображение будет размыто в приложении «Сообщения».

Если ребенок выберет «Просмотр фото», появится краткое всплывающее сообщение. Появится сообщение о том, почему изображение считается конфиденциальным. Если ребенок решит продолжить, его родительский элемент iCloud Family получит уведомление.

Это также будет объяснено во всплывающем сообщении. Ссылки на дополнительную помощь тоже будут присутствовать. Важно отметить, что уведомление для родителей доступно только детям младше 13 лет.

Siri и поиск

Последнее обновление, о котором объявила Apple, было расширением руководства в Siri и Поиске. В частности, сервисы предоставят дополнительные ресурсы, чтобы помочь детям и родителям оставаться в безопасности и получать помощь в случае необходимости.

Все эти функции появятся позже в этом году в обновлении iOS 15, iPadOS 15, watchOS 8 и macOS 12..