Ang kamakailang anunsyo sa kaligtasan ng bata ng Apple tungkol sa pagtatasa ng imahe ng iCloud Photos at mga abiso sa Mga Mensahe ay nakabuo ng maraming mga hot take, ngunit marami sa mga argumento ay nawawala ang konteksto, makasaysayang impormasyon-at ang katunayan na ang mga patakaran sa privacy ng Apple ay hindi nagbabago. Inanunsyo ng Apple ang isang bagong hanay ng mga tool noong Huwebes, na sinadya upang makatulong na protektahan ang mga bata sa online at mapigilan ang pagkalat ng materyal na pang-aabusong sekswal sa bata (CSAM). Nagsama ito ng mga tampok sa iMessage, Siri at Paghahanap, at isang mekanismo na sumusuri sa iCloud Mga Larawan para sa mga kilalang mga imahe ng CSAM.

Ang seguridad sa cyber, kaligtasan sa online, at mga eksperto sa privacy ay may magkahalong reaksyon sa anunsyo. Ginawa din ng mga gumagamit. Gayunpaman, marami sa mga argumento ay malinaw na hindi pinapansin kung gaano kalawak ang kasanayan sa pag-scan ng mga database ng imahe para sa CSAM talaga. Hindi rin nila pinapansin ang katotohanan na hindi pinabayaan ng Apple ang mga teknolohiyang nagpoprotekta sa privacy.

Narito ang dapat mong malaman.

Mga tampok sa privacy ng Apple

Ang slate ng mga tampok sa proteksyon ng bata na kasama ang nabanggit na pag-scan ng Larawan sa iCloud, pati na rin ang mga na-update na tool at mapagkukunan sa Siri at Paghahanap. Nagsasama rin ito ng tampok na nilalayong i-flag ang mga hindi naaangkop na imaheng ipinadala sa pamamagitan ng iMessage sa o mula sa mga menor de edad.

Tulad ng nabanggit ng Apple sa anunsyo nito, lahat ng mga tampok ay itinayo na may iniisip na privacy. Parehong tampok na iMessage at pag-scan ng iCloud Photo, halimbawa, gumamit ng on-device intelligence.

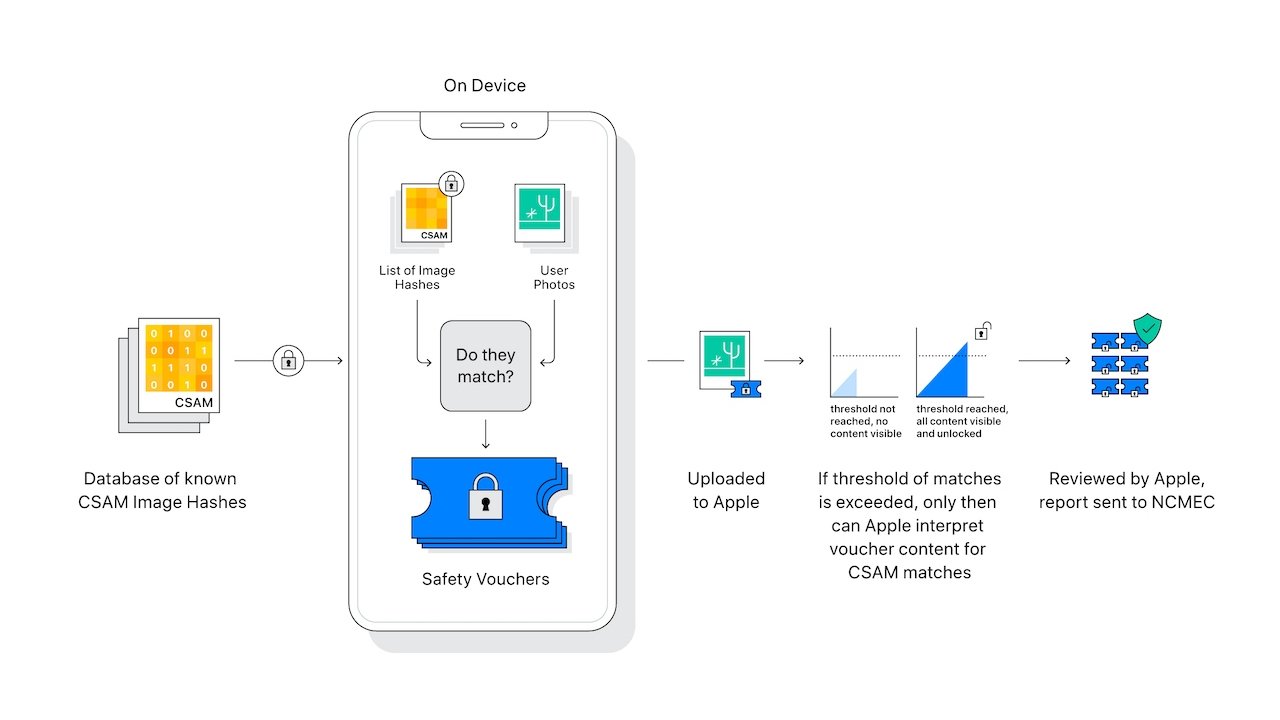

Bilang karagdagan, ang”Mga scanner”ng iCloud Mga Larawan ay hindi aktwal na pag-scan o pagsusuri ng mga imahe sa iPhone ng isang gumagamit. Sa halip, ihinahambing ang mga hash ng matematika ng kilalang CSAM sa mga imaheng nakaimbak sa iCloud. Kung ang isang koleksyon ng mga kilalang mga imahe ng CSAM ay nakaimbak sa iCloud, pagkatapos ay nai-flag ang account at ipinadala ang isang ulat sa National Center for Missing & Exploited Children (NCMEC).

May mga elemento sa system upang matiyak na ang mga maling positibo ay nakakatawang bihira. Sinabi ni Apple na ang mga pagkakataon ng isang maling positibo ay isa sa isang trilyon. Iyon ay dahil sa nabanggit na koleksyon na”threshold,”na tinanggihan ng Apple na idetalye.

Bilang karagdagan, gagana lang ang pag-scan sa mga Larawan sa iCloud. Ang mga imahe na mahigpit na nakaimbak sa-aparato ay hindi nai-scan, at hindi sila masuri kung naka-off ang Mga Larawan ng iCloud.

Ang sistemang Mga Mensahe ay mas pinapanatili ang privacy. Nalalapat lamang ito sa mga account na pagmamay-ari ng mga bata, at opt-in, hindi opt-out. Bukod dito, hindi ito bumubuo ng anumang mga ulat sa mga panlabas na entity-ang mga magulang lamang ng mga bata ang aabisuhan na isang hindi naaangkop na mensahe ang natanggap o naipadala.

Mayroong mga kritikal na pagkakaiba na gagawin sa pagitan ng pag-scan ng Mga Larawan sa iCloud at tampok na iMessage. Talaga, pareho ang ganap na walang kaugnayan sa kabila ng katotohanang nilalayon nila upang protektahan ang mga bata.

Ang pagtatasa ng Larawan ng iCloud ay nag-hash ng mga imahe nang hindi sinusuri ang konteksto, at ihinahambing ito sa mga kilalang koleksyon ng CSAM at bumubuo ng isang ulat upang mai-isyu sa tagapanatili ng koleksyon ng hash na NCMEC. Ang tampok na account ng bata na account na iMessage ay gumagamit ng pag-aaral sa machine na aparato, hindi ihinahambing ang mga imahe sa mga database ng CSAM, at hindi nagpapadala ng anumang mga ulat sa Apple-ang manager account lang ng Family Sharing ng magulang

Sa pag-iisip na ito, patakbuhin natin ang ilang mga potensyal na sitwasyon na nababahala ang mga gumagamit.

Ang maling aklatan ng iCloud-o”Paano kung ako ay maling naitugma sa matematika?”. Ngunit, para sa anuman ang dahilan, ang mga tao ay hindi maganda sa pagtatasa ng panganib-gantimpala. Tulad ng napansin na namin, sinabi ng Apple na ang posibilidad ng isang maling laban ay one-in-a-trilyon. One-in-1,000,000,000,000.

Sa buhay ng isang tao, mayroong isang 1-sa-15,000 pagkakataon na ma-hit ng kidlat, at hindi iyon isang pangkalahatang takot. Ang mga posibilidad na masaktan ng isang meteor sa buong buhay ay tungkol sa 1-in-250,000 at hindi rin iyon pang-araw-araw na takot. Ang anumang naibigay na mega-jackpot lottery ay higit sa 1-in-150,000,000 upang manalo, at milyun-milyong dolyar ang gugugol dito araw-araw sa buong US.

Ang isang one-in-a-trilyon na Apple ay hindi ang tatawagin mong malaking pagkakataon na ang buhay ng isang tao ay mapahamak ng isang maling positibo. At, si Apple ay hindi ang hukom, hurado, at berdugo, tulad ng paniniwala ng ilan.

Kung dapat makita ang materyal, ito ay susuriin ng tao bago ibigay sa pagpapatupad ng batas. At pagkatapos, at pagkatapos lamang, ibibigay ang potensyal na tugma sa pagpapatupad ng batas. Sa madaling salita, ang iyong mga larawan ng iyong mga anak sa paliguan, o ang iyong sariling mga hubad sa iCloud ay malalim na malamang na hindi makabuo ng isang maling tugma.

Kahit na nag-flag ito ng isang imahe na ipinadala sa pagitan ng dalawang pumapayag na mga may sapat na gulang, hindi ito masyadong nangangahulugan. Ang system, tulad ng nabanggit kanina, ay hindi nag-aabiso o bumuo ng isang panlabas na ulat. Sa halip, gumagamit ito ng pag-aaral sa makina sa aparato na tuklasin ang isang potensyal na sensitibong larawan at bigyan ng babala ang gumagamit tungkol dito. At, muli, nilalayon lamang na bigyan ng babala ang mga magulang na ang mga gumagamit na wala pang edad ay nagpapadala ng mga larawan. Ang pag-aalala na ito ay nagmumula sa hindi pagkakaunawa sa kung paano gumagana ang pag-scan sa iCloud Photos ng Apple. Hindi ito tumitingin sa mga indibidwal na imahe ayon sa konteksto upang matukoy kung ang isang larawan ay CSAM. Kinukumpara lamang ang imaheng mga hash ng mga larawan na nakaimbak sa iCloud laban sa isang database ng kilalang CSAM na pinapanatili ng NCMEC. Sa madaling salita, maliban kung ang mga imahe ng iyong mga anak ay kahit papaano na-hash sa database ng NCMEC, kung gayon hindi sila maaapektuhan ng system ng pag-scan ng Larawan ng iCloud. Higit pa rito, ang sistema ay dinisenyo lamang upang mahuli ang mga koleksyon ng kilalang CSAM. Kaya, kahit na ang isang solong imahe kahit papaano ay nagawang makabuo ng maling positibo (isang hindi malamang kaganapan, na napag-usapan na namin), kung gayon hindi pa rin i-flag ng system ang iyong account. Muli, nalalapat lamang ang system ng iCloud Photos sa mga koleksyon ng mga imaheng nakaimbak sa cloud photo system ng Apple. Kung may nagpadala sa iyo ng kilalang CSAM sa pamamagitan ng iMessage, kung gayon ang system ay hindi mailalapat maliban kung nai-save ito sa iyong iCloud. Maaari bang may isang taong mag-hack sa iyong account at mag-upload ng isang bungkos ng kilalang CSAM sa iyong iCloud Photos? Posible ito sa teknikal, ngunit malamang na hindi malamang kung gumagamit ka ng mahusay na mga kasanayan sa seguridad. Sa isang malakas na password at two-factor na pagpapatotoo, magiging maayos ka. Kung napagpasyahan mo kahit papaano na magawa ng mga kaaway ng isang tao o organisasyon na makalampas sa mga mekanismo ng seguridad, malamang na may higit kang higit na mga alalahanin na dapat magalala. Gayundin, pinapayagan ng system ng Apple ang mga tao na mag-apela kung ang kanilang mga account ay nai-flag at isinara para sa CSAM. Kung ang isang masamang entity ay namamahala upang makuha ang CSAM sa iyong iCloud account, palaging may posibilidad na maitakda mo nang maayos ang mga bagay. At, kakailanganin pa ring ilipat sa iyong Photo library upang ma-scan ito. ng privacy. Maraming mga eksperto sa cryptography at seguridad ay mayroon ding mga alalahanin. Halimbawa, nag-aalala ang ilang dalubhasa na ang pagkakaroon ng ganitong uri ng mekanismo ay maaaring gawing mas madali para sa mga awtoridad ng awtoridad na maiwasak ang pang-aabuso. Bagaman ang sistema ng Apple ay dinisenyo lamang upang makita ang CSAM, nag-aalala ang mga eksperto na ang mga mapang-api na gobyerno ay maaaring pilitin ang Apple na muling gawin ito upang makita ang mga hindi pagkakasundo o mga mensahe laban sa gobyerno. Mayroong mga wastong argumento tungkol sa”mission creep”sa mga teknolohiyang tulad nito. Ang kilalang mga digital na karapatan na hindi nagtatrabaho sa Electronic Frontier Foundation, halimbawa, ay nagsabi na ang isang katulad na sistema na orihinal na inilaan upang makita ang CSAM ay muling naiulat upang lumikha ng isang database ng nilalamang”terorista”. Mayroon ding mga wastong argumento na itinaas ng system ng pag-scan ng Mga mensahe. Kahit na ang mga mensahe ay naka-encrypt na end-to-end, ang pag-aaral ng machine na nasa aparato ay pang-teknikal na pag-scan ng mga mensahe. Sa kasalukuyan nitong form, hindi ito maaaring magamit upang matingnan ang nilalaman ng mga mensahe, at tulad ng nabanggit kanina, walang panlabas na mga ulat ang nabuo ng tampok. Gayunpaman, ang tampok ay maaaring makabuo ng isang classifier na maaaring teoretikal na magamit para sa mapang-aping mga layunin. Halimbawa, kinuwestiyon ng EFF kung ang tampok ay maaaring iakma sa watawat ang nilalaman ng LGBTQ + sa mga bansa kung saan labag sa batas ang homoseksuwalidad. Sa parehong oras, ito ay isang madulas na slope na lohikal na pagkakamali, ipinapalagay na ang layunin sa pagtatapos ay hindi maiiwasan ang mga pinakapangit na sitwasyong ito. Ito ang lahat ng magagandang debate na dapat gawin. Gayunpaman, ang pagpapataw ng pagpuna lamang sa Apple at mga system nito na ipinapalagay na ang pinakamasamang kaso ay darating ay hindi patas at hindi makatotohanang. Iyon ay dahil halos lahat ng serbisyo sa internet ay nahaba ang parehong uri ng pag-scan na ginagawa ngayon ng Apple para sa iCloud. Bilang Ang Verge iniulat noong 2014 , nai-scan ng Google ang mga inbox ng mga gumagamit ng Gmail para sa kilalang CSAM mula pa noong 2008. Ang ilan sa mga pag-scan na iyon ay humantong pa sa pag-aresto sa mga indibidwal na nagpapadala ng CSAM. Gumagawa din ang Google upang i-flag at alisin ang CSAM mula sa mga resulta ng paghahanap. Orihinal na binuo ng Microsoft ang system na ginagamit ng NCMEC. Ang sistema ng PhotoDNA, na ibinigay ng Microsoft, ay ginagamit upang i-scan ang mga hash ng imahe at makita ang CSAM kahit na ang isang larawan ay nabago. Sinimulang gamitin ito ng Facebook noong 2011, at pinagtibay ito ng Twitter noong 2013. Ginagamit ito ng Dropbox, at halos bawat repository ng internet file ay ginagawa din. Ay sinabi din ng Apple na ini-scan ito para sa CSAM. Noong 2019, na-update nito ang patakaran sa privacy upang sabihin na ini-scan nito ang”potensyal na iligal na nilalaman, kabilang ang materyal na pagsasamantala sa sekswal na bata.”Isang kwentong 2020 mula sa The Nabanggit ng Telegraph na na-scan ng Apple ang iCloud para sa mga imaheng pang-aabuso sa bata. Tulad ng anumang paglabas ng Apple, ang kalagitnaan lamang ng 75% ng pagtatalo ang matino. Ang mga taong nagsisisigaw na ang privacy ay sa anumang paraan ay nilabag, tila hindi gaanong nag-aalala tungkol sa katotohanang ang Twitter, Microsoft, Google, at bawat iba pang serbisyo sa pagbabahagi ng larawan ay gumagamit ng mga hash na ito sa isang dekada o higit pa. Ay hindi rin nila alintana na ang Apple ay nakakakuha ng zero na impormasyon tungkol sa pag-hash, o mga alerto ng Mga Mensahe sa mga magulang. Ang iyong library ng larawan na may 2500 mga larawan ng iyong aso, 1200 larawan ng isang Budweiser na dahan-dahang nag-iinit sa bow ng iyong bangka, at 250 na mga larawan ng lupa dahil na-hit mo nang hindi sinasadya ang pindutan ng lakas ng tunog habang ang camera app ay bukas pa rin sa opaque sa Apple tulad ng dati. At, bilang isang may sapat na gulang, ang Apple ay hindi i-flag o mag-aalala na nagpapadala ka ng mga larawan ng iyong genitalia sa ibang matanda. Ang mga pangangatwirang ipinapalagay nito sa paanuman ang patlang sa paglalaro ng privacy sa iba pang mga produkto ay lubos na nag-iiba sa kung paano mo personal na tinukoy ang privacy. Hindi pa rin gumagamit ang Apple ng Siri upang magbenta sa iyo ng mga produkto batay sa sinabi mo rito, hindi pa rin tumitingin ang Apple sa metadata ng email upang maihatid sa iyo ang mga ad, at iba pang mga talagang hakbang sa paglabag sa privacy. Ang mga katulad na argumento na dapat gawin ng Apple kung ano ang kailangan nitong gawin upang maprotektahan ang lipunan anuman ang gastos ay magkatulad na mura at walang katuturan. Ngunit, tulad ng dati sa anumang bagay mula sa Apple hanggang sa huli, ang pagmemensahe ay self-serving at hindi kumpleto. Bukod dito, ang kawalan ng transparency ay isang isyu tulad ng dati. Sa kakulangan ng transparency ng Apple, dumarating ang halatang pagtataka tungkol sa kung ginagawa ng Apple ang sinasabi nitong ginagawa nito, kung paano nito nasabing ginagawa ito. Walang magandang sagot sa katanungang iyon. Gumagawa kami ng mga desisyon araw-araw tungkol sa kung aling tatak ang dapat pagkatiwalaan, batay sa aming sariling mga pamantayan. Kung ang iyong pamantayan ay sa paanuman ang Apple ay mas masahol pa kaysa sa iba pang mga higanteng tech na nagawa ito nang mas matagal, o ang alalahanin ay maaaring pahintulutan ng Apple ang pagpapatupad ng batas na subpoena ang iyong mga tala ng iCloud kung may iligal na bagay dito tulad ng ginagawa nila simula pa. Ang iCloud ay inilunsad, pagkatapos ay maaaring oras na upang tuluyang gawin ang platform na ilipat na marahil ay nagbabanta kang gawin sa loob ng 15 taon o mas matagal. Kung pupunta ka, kailangan mong tanggapin na ang iyong ISP ay masayang ibibigay ang iyong data sa sinumang humihiling nito, para sa pinaka-bahagi. At dahil nauugnay ito sa hardware, ang natitirang mga vendor ng OS ay ginagawa ito, o mas maraming nagsasalakay na mga bersyon nito, para sa mas mahaba. At, lahat ng iba pang mga vendor ay may mas malalim na mga isyu sa privacy para sa mga gumagamit sa pang-araw-araw na pagpapatakbo. Mayroong palaging isang manipis na linya sa pagitan ng seguridad at kalayaan, at walang perpektong solusyon. Masasabi rin, ang solusyon ay higit pa sa pananagutan ng Apple kaysa sa anupaman dahil hindi ito maagap na abutin ang CSAM ayon sa konteksto-ngunit kung ginawa ito, talagang gagawin nito ang paglabag sa privacy na sinisigawan ng ilang mga tao ngayon, dahil ito malalaman ang mga larawan ayon sa konteksto at nilalaman. Habang ang privacy ay isang pangunahing karapatan ng tao, ang anumang teknolohiya na pumipigil sa pagkalat ng CSAM ay likas ding mabuti. Nagawa ng Apple na bumuo ng isang system na gagana patungo sa huling layunin nang hindi binibigyang peligro ang privacy ng average na tao. Ang mga alalahanin sa madulas na slope tungkol sa pagkawala ng privacy sa online ay nagkakahalaga ng pagkakaroon. Gayunpaman, ang mga pag-uusap na iyon ay kailangang isama ang lahat ng mga manlalaro sa larangan-kasama ang mga mas malinaw na lumalabag sa privacy ng kanilang mga gumagamit sa araw-araw. Kumusta naman ang mga larawan ng aking mga anak na naliligo?

Paano kung ang isang tao ay magpapadala sa akin ng iligal na materyal?

Ang Apple ay nakakita ng isang gitnang batayan