Você já se esforçou para encontrar as palavras-chave certas para uma pesquisa no Google? Bem, se você já fez, eu sei exatamente como você se sente. Mas o Google nos protege. Ele está introduzindo um novo recurso no Google Lens destinado a ajudá-lo a encontrar coisas que você não pode descrever facilmente, chamado Multipesquisa, relata 9to5Google. Ele está sendo lançado em versão beta para usuários dos EUA e permitirá que você tire uma foto de algo e faça uma pergunta sobre isso.

Você já se esforçou para encontrar as palavras-chave certas para uma pesquisa no Google? Bem, se você já fez, eu sei exatamente como você se sente. Mas o Google nos protege. Ele está introduzindo um novo recurso no Google Lens destinado a ajudá-lo a encontrar coisas que você não pode descrever facilmente, chamado Multipesquisa, relata 9to5Google. Ele está sendo lançado em versão beta para usuários dos EUA e permitirá que você tire uma foto de algo e faça uma pergunta sobre isso.

Google Lens Multisearch beta chegando aos Estados Unidos agora, tanto no Android quanto no iOS

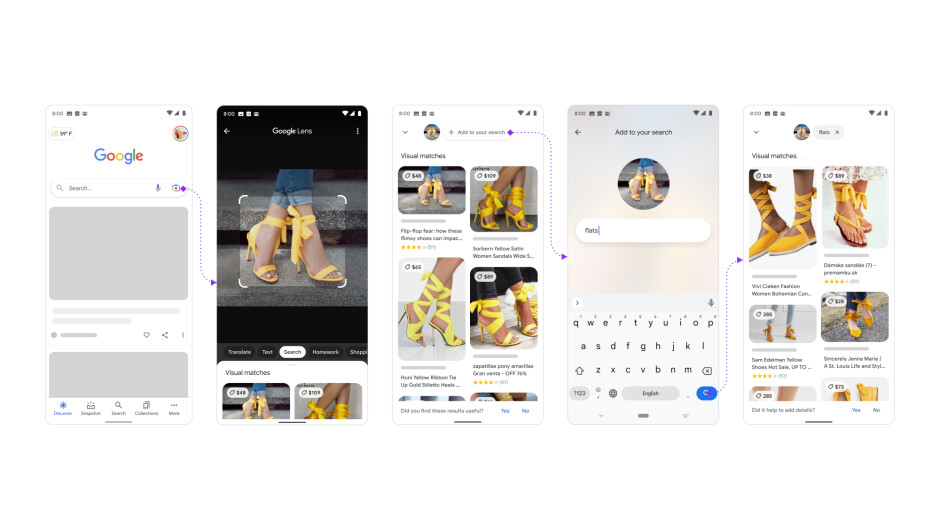

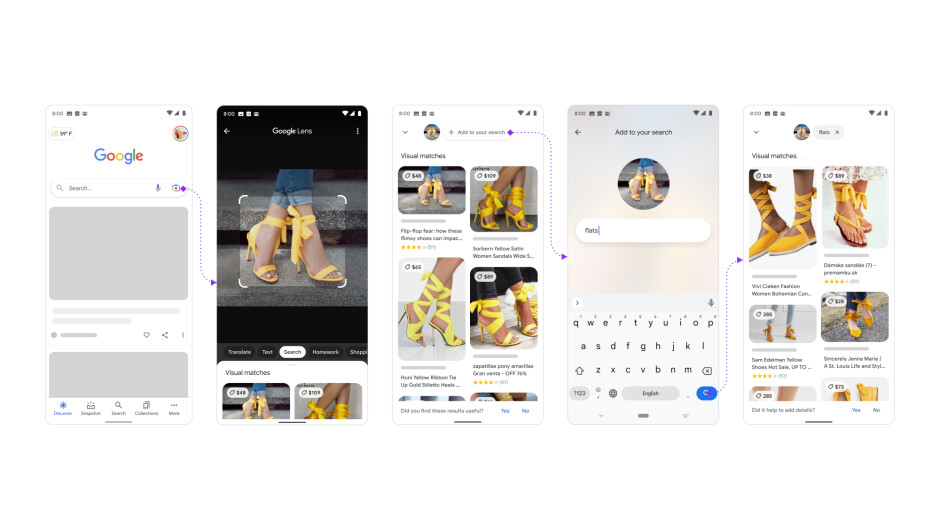

Em setembro do ano passado, o Google realizou sua palestra com foco em pesquisa, e uma das coisas mais legais que a gigante de tecnologia de Mountain View anunciou durante o evento foi uma grande atualização para o Google Lens. O recurso Multisearch está finalmente disponível para testadores beta no Android e iOS. Praticamente, Multisearch é uma maneira completamente nova de pesquisar no Google, e está focada em ajudá-lo com as coisas que você não tem todas as palavras para descrever. Basicamente, você tira uma foto da coisa indescritível (ou pode até importar uma existente) com o Google Lens e, em seguida, desliza para cima no painel de resultados e toca no novo botão”Adicionar à sua pesquisa”localizado no topo.

O botão permitirá que você insira uma pergunta sobre o objeto ou refine sua pesquisa por cor, marca ou qualquer outro atributo visual. Sim, mas o que isso significa exatamente? Bem, aqui estão alguns exemplos.

Você tirou uma foto ou uma captura de tela de um vestido laranja legal para dar de presente para sua garota, mas quer ver se está disponível em outra cor: basta adicionar”verde”à pesquisa e os resultados devem mostrar o vestido em verde (se tiver a opção verde, claro).

Outro exemplo é uma foto com seu aparelho de jantar, com uma consulta”mesa de centro”, e você pode encontrar uma tabela correspondente ou semelhante.

Ou… imagine que sua mãe lhe disse para cuidar da planta dela quando ela estiver viajando. Sim, não queremos matá-lo, mas e se você nem souber qual planta é? Simples: tire uma foto e adicione a consulta”instruções de cuidados”, e o Google Lens evitará constrangimentos.

Até agora, os destaques são para moda e decoração e, atualmente, os melhores resultados do Google Lens Multisearch estão relacionados às pesquisas de compras, mas podemos ver facilmente como esse recurso cresce e se torna cada vez mais útil no futuro. O exemplo que o Google deu com uma planta de alecrim na verdade mostra que você não precisa primeiro fazer uma pesquisa para identificar a planta e depois uma segunda para instruções de cuidados: as duas coisas estão unidas.

A IA e, mais especificamente, os avanços na IA, é o que está tornando o Google Lens Multisearch possível. No entanto, no momento ele não pode lidar com consultas mais complexas, pois ainda não utiliza o Modelo Unificado de Multitarefas. Caso você esteja se perguntando o que é isso, o Multitask Unified Model ou MUM foi apresentado durante uma demonstração. Ele permitia que você tirasse uma foto de engrenagens de bicicleta quebradas e recebesse instruções para repará-las.

O recurso Multipesquisa agora está sendo lançado oficialmente em versão beta para os EUA e pode ser acessado no aplicativo do Google em dispositivos Android e iOS.

O diretor de pesquisa da empresa, Lou Wang, afirmou que isso visa ajudar as pessoas a entender as perguntas com mais naturalidade. No futuro, Wang afirmou que o Multisearch será expandido para vídeos, mais imagens em geral e até mesmo”os tipos de respostas que você pode encontrar em uma pesquisa de texto tradicional do Google”(via TheVerge).