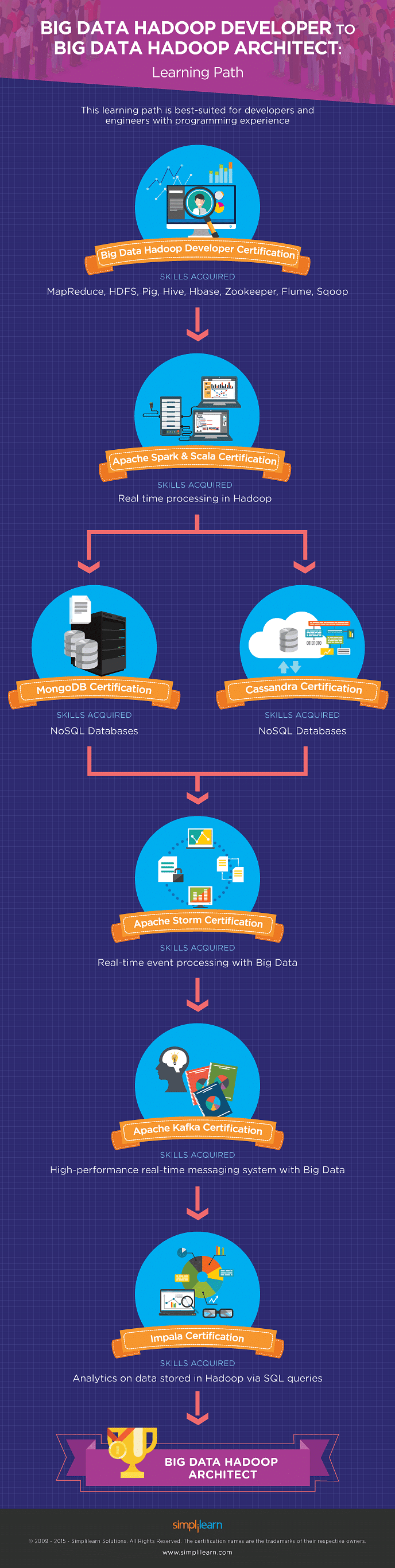

O seguinte caminho de aprendizagem é mais adequado para desenvolvedores e engenheiros com experiência em programação-

O que um Big Data Hadoop Architect faz?

Os arquitetos de Big Data Hadoop evoluíram para se tornarem elos vitais entre negócios e tecnologia. Eles são responsáveis por planejar e projetar sistemas de big data de próxima geração e gerenciar o desenvolvimento e implantação em grande escala de aplicativos Hadoop. Os arquitetos do Hadoop estão entre os profissionais mais bem pagos do setor de TI, ganhando em média entre $ 91.392 e $ 133.988 por ano e até $ 200.000 por ano.

Se você deseja seguir uma carreira nesta função, precisa entender as necessidades das organizações de TI, como os especialistas e engenheiros de Big Data operam e como servir como um elo entre essas duas entidades essenciais.

Qualquer organização que deseja construir um ambiente de Big Data exigirá um Big Data Architect que pode gerenciar o ciclo de vida completo de uma solução Hadoop-incluindo análise de requisitos, seleção de plataforma, design de arquitetura técnica, design de design de aplicativo e desenvolvimento, teste e implantação da solução proposta.

Parece interessante? Aqui está o que você precisa fazer para chegar lá!

Ansioso para se tornar um desenvolvedor Hadoop? Confira a Certificação de Big Data Hadoop Curso de treinamento e obtenha a certificação hoje

Certifique-se de atender a estes requisitos primários

Para ser um arquiteto de Big Data Hadoop, você deve ter mineração de dados e habilidades de análise de dados , que requerem anos de experiência profissional em Big Data campo. Se você tem as habilidades listadas aqui, está no caminho certo:

- Habilidades analíticas e de marketing: capacidade de processar e analisar dados para entender o comportamento do comprador/cliente.

- RDBMSs (Relational Database Management Systems) ou habilidades básicas de banco de dados

- A capacidade de implementar e usar NoSQL, Cloud Computing e MapReduce

- Habilidades em estatística e matemática aplicada

- Visualização de dados e migração de dados

Além disso, sua influência como arquiteto de dados continuará a crescer, como muitas empresas agora estão se voltando para arquitetos de dados (mais de analistas de dados ou engenheiros de banco de dados) para integrar e aplicar dados de diferentes fontes. Como arquiteto de dados, você desempenhará um papel essencial em trabalhar de perto com usuários, designers de sistema e desenvolvedores.

O que é toda essa confusão sobre o Hadoop, afinal?

Datamation tem isso a dizer sobre o Hadoop:“ Quando se trata de ferramentas para trabalhar com Big Data, as soluções de código aberto em geral e o Apache Hadoop, em particular, dominam o cenário. ” Analista da Forrester Mike Gualtieri previu recentemente que”100 por cento das grandes empresas”adotariam o Hadoop nos próximos dois anos.

Um relatório de Pesquisa de mercado prevê que o mercado Hadoop crescerá a uma taxa composta de crescimento anual (CAGR) de 58 por cento até 2022 e que valerá mais de US $ 1 bilhão em 2020. A IBM também acredita fortemente no código aberto Ferramentas de Big Data que designou 3.500 pesquisadores para trabalhar no Apache Spark , uma ferramenta que faz parte do ecossistema Hadoop.

O Hadoop do Apache se tornou sinônimo de Big Data porque seu ecossistema inclui várias ferramentas de código aberto que ajudam na “computação distribuída e altamente escalável”.

Quer começar sua carreira como engenheiro de dados? Confira o Treinamento de engenheiro de dados e obtenha a certificação.

Como faço para chegar lá?

Em um campo tão técnico e ultracompetitivo como Big Data e Hadoop, você está adquirindo uma certificação profissional credenciada e reconhecida globalmente pode ser a melhor maneira não apenas de aprender os meandros do domínio, mas também apoiá-lo com validação oficial.

Os cursos de Big Data da Simplilearn oferecem a você todo o conhecimento e as habilidades isso será necessário para acelerar sua carreira como um Big Data Arquiteto . O programa foi projetado para atender aos requisitos de alta demanda dos arquitetos de Big Data no campo. Este programa fornece acesso a mais de 200 horas de eLearning de alta qualidade, suporte sob demanda por especialistas do Hadoop, exames de simulação, uma comunidade moderada por especialistas e um certificado de mestrado após a conclusão do treinamento.

O infográfico no início deste artigo apresenta uma série de caminhos de aprendizagem para guiá-lo em sua jornada.

O que significam as várias certificações?

1. Desenvolvedor de Big Data e Hadoop

A melhor maneira de começar é usando o Curso de certificação Big Data e Hadoop Developer . Este curso tem como objetivo capacitar profissionais para realizar atribuições em Big Data. Além de cobrir os conceitos de Hadoop 2.7, o curso oferece treinamento prático em Big Data e Hadoop e envolve candidatos em projetos que exigem a implementação de conceitos de Big Data e Hadoop.

Depois de terminar este curso, você terá um conhecimento completo de MapReduce, HDFS, Pig, Hive, Hbase, Zookeeper, Flume e Sqoop.

Desenvolvedores e arquitetos de software, profissionais de análise, profissionais de gerenciamento de dados, profissionais de business intelligence, gerentes de projeto, aspirantes a cientistas de dados e qualquer pessoa com grande interesse em Big Data Analytics-incluindo graduados-podem se beneficiar significativamente deste curso.

2. Apache Spark e Scala

O que vem a seguir? Apache Spark e Scala. Este curso visa equipar os aspirantes com habilidades envolvidas no processamento em tempo real do Hadoop.

Apache Spark é uma estrutura de computação em cluster de código aberto que oferece suporte aos conceitos de “transformação” e “mapeamento” de dados. Esta estrutura funciona bem com Scala (ou “Scalable Language,”), que é uma linguagem robusta preferida para sistemas de servidor de missão crítica.

Quando terminar de usar este Apache Curso Spark e Scala , você pode escolher qualquer um dos dois bancos de dados NoSQL-MongoDB ou Cassandra.

- MongoDB: MongoDB é um banco de dados de plataforma cruzada orientado a documentos que suporta modelagem de dados, ingestão, consulta e compartilhamento, replicação de dados e muito mais. É o banco de dados NoSQL mais popular do setor.

Um curso de certificação em MongoDB criará seu experiência em escrever aplicativos Java e Node JS usando MongoDB; aprimore suas habilidades de replicação e compartilhamento de dados para otimizar o desempenho de leitura/gravação; ensina a instalação, configuração e manutenção de um ambiente MongoDB; e desenvolver sua proficiência na configuração do MongoDB, métodos de backup e estratégias de monitoramento e operacionais.

Ele também lhe dará experiência na criação e gerenciamento de diferentes tipos de índices no MongoDB para execução de consultas e oferece uma compreensão mais profunda do gerenciamento de notas de banco de dados, conjunto de réplicas e conceitos mestre-escravo.

Para resumir, você será capaz de processar grandes quantidades de dados usando ferramentas do MongoDB e armazenar com proficiência dados não estruturados no MongoDB.

- Cassandra: Apache Cassandra é um sistema de gerenciamento de banco de dados distribuído de código aberto que funciona no mecanismo “mestre e escravo”. O Cassandra funciona melhor com aplicativos de gravação pesada.

O Cassandra oferece maior escalabilidade e, portanto, é capaz de armazenar petabytes de dados. Ele é cuidadosamente projetado para lidar com enormes cargas de trabalho em vários data centers sem um único ponto de falha.

Um curso de certificação em Apache Cassandra incluirá detalhes sobre os fundamentos de bancos de dados Big Data e NoSQL; Cassandra e suas características; a arquitetura e o modelo de dados do Cassandra; instalação, configuração e monitoramento do Cassandra; e o ecossistema de produtos Hadoop em torno de Cassandra.

3. Apache Storm

Apache Storm foi projetado para processamento de eventos em tempo real com Big Data. Para implementar o Apache Storm com eficácia, você precisa dominar os conceitos fundamentais do Apache Storm, bem como sua arquitetura. Uma compreensão do plano de instalação e configuração com Apache Storm também é necessária.

Este curso dará a você uma compreensão completa da ingestão e processamento de eventos em tempo real com o Storm e os fundamentos das extensões do Trident para o Apache Storm. Você aprenderá sobre agrupamento e inserção de dados no Apache Storm e desenvolverá uma compreensão dos fundamentos das interfaces do Storm com Kafka, Cassandra e Java.

4. Apache Kafka

Apache Kafka é um projeto Apache de código aberto, destacado por o fato de ser um sistema de mensagens em tempo real de alto desempenho que pode processar milhões de mensagens por segundo. Ele fornece um sistema de mensagens distribuído e particionado e é altamente tolerante a falhas.

Antes de começar, você precisa ter um bom conhecimento da arquitetura, instalação, interfaces e configuração do Kafka.

Com mais empresas ao redor do mundo se adaptando ao Kafka, ele se tornou a plataforma de mensagens preferida para processamento de Big Data em tempo real. Com esta certificação, você se tornará um mestre no manuseio de grandes quantidades de dados.

5. Impala

Esta é a última da linha de certificações que o levará a se tornar um arquiteto de Big Data Hadoop. O conhecimento do Impala-“um mecanismo SQL de código aberto para Hadoop”-irá equipá-lo com a compreensão dos conceitos básicos do Processamento Paralelo Massivo (MPP), o mecanismo de consulta SQL que é executado no Apache Hadoop. Com esta certificação, você será capaz de interpretar o papel do Impala no ecossistema de Big Data.

O Impala oferece vantagens em sua capacidade de consultar dados no Apache Hadoop e pular as demoradas etapas de carregamento e reconhecimento de dados. Você também poderá obter conhecimento de bancos de dados, SQL, data warehouse e outras linguagens de programação de banco de dados.

Você está ansioso para se tornar um especialista em Big Data? Este guia de carreira é uma leitura perfeita para você começar no próspero campo de Big Data. Baixe o e-book agora !

Conclusão

Seguir este caminho permitirá que você chegue ao seu destino como um Big Data Professional . Em seu caminho, você desenvolverá uma compreensão abrangente do panorama geral de TI e sua variedade de tecnologias e, acima de tudo, será capaz de analisar como diferentes tecnologias funcionam juntas. Há muito o que absorver no seu caminho, mas paciência e trabalho duro irão recompensá-lo com o trabalho de arquiteto de dados de amanhã.

Se você está interessado em se tornar um especialista em Big Data, temos o guia certo para você. O Guia de carreira de Big Data fornecerá insights sobre as tecnologias mais populares, as principais empresas que estão contratando, as habilidades necessárias para alavancar sua carreira no campo próspero de Big Data e oferece a você um roteiro personalizado para se tornar um especialista em Big Data de sucesso.