自從像 ChatGPT 這樣的生成式人工智能誕生以來,專家和政府就一直對該領域不受監管的發展感到擔憂。現在,為了解決這些問題,OpenAI 正在組建一個專門團隊,旨在管理潛力與超級人工智能相關的風險。

該團隊由 OpenAI 聯合創始人 Ilya Sutskever 和 OpenAI 聯盟團隊的傑出成員 Jan Leike 領導,將開發方法來處理以下假設場景:超級智能人工智能係統超越人類智能並開始自主運行。儘管這種情況可能看起來有些牽強,但專家認為,超級智能人工智能可能在未來十年內成為現實,這凸顯了當今開發保障措施的重要性。

“目前,我們還沒有轉向解決方案宣布這一決定的博客文章中寫道:“或者控制潛在的超級人工智能並防止其失控。”

Superalignment 團隊

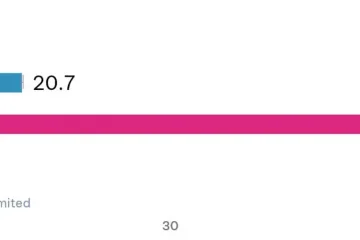

OpenAI 建立的 Superalignment 團隊將能夠使用當前約 20% 的計算資源,以及來自 OpenAI 之前團隊的科學家和工程師。對齊部門開發“人類水平的自動對齊研究員”,主要協助評估其他人工智能係統並進行對齊研究。

“隨著我們在這方面取得進展,我們的人工智能係統可以接管更多以及我們更多的對齊工作,並最終構思、實施、研究和開發比我們現在更好的對齊技術。”另一位博客文章。

一個用於檢查其他 AI 的 AI 系統

雖然開發一個用於檢查其他 AI 的 AI 系統的提議可能看起來像不同尋常的是,OpenAI 認為,與人類相比,人工智能係統在對齊研究方面可以取得更快的進展。這種方法不僅可以為人類研究人員節省時間,還可以讓他們專注於審查 AI 進行的比對研究,而不是自己生成比對研究。

但是,需要注意的是,OpenAI 承認存在潛在風險。以及與此方法相關的危險。此外,該公司還計劃發布路線圖,概述其未來的研究方向。