.fb-comments,.fb-comments span,.fb-comments span iframe[style]{min-width:100%! wichtig;Breite:100%!wichtig}  Quelle: https://github.com/facebookresearch/theseus

Quelle: https://github.com/facebookresearch/theseus

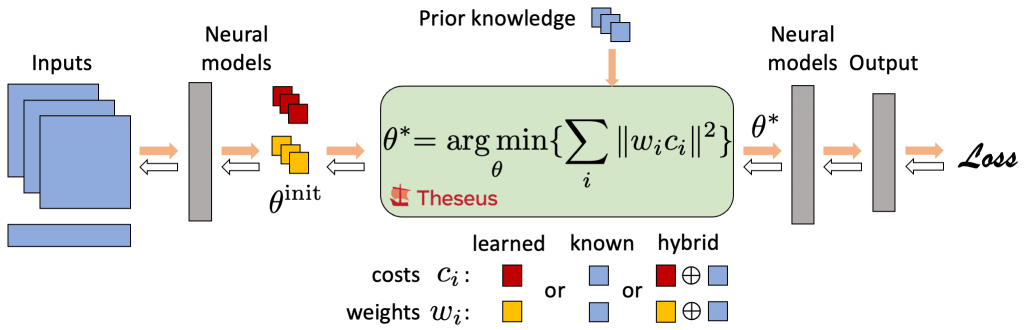

Neue Erkundung durch Meta AI entwickelt Theseus, eine Bibliothek für eine Optimierungsmethode, die als differenzierbare nichtlineare bezeichnet wird minimale Quadrate (NLS). Forscher könnten das Gebietsbewusstsein sofort in KI-Frameworks integrieren, indem sie Theus, ein hauptsächlich auf PyTorch basierendes Gerät, verwenden. Als modularer „Optimierungslayer“ fügt es dem Layout Daten hinzu und charakterisiert Know-how als Optimierungssituation. Individuell aus Unterrichtsdaten können diese Bereichsfähigkeiten die Modellgenauigkeit erhöhen. Dieser Ansatz ist praktisch für die Entwicklung von Stilen für Datensätze mit nichtlinearen Fähigkeiten. Mit Theseus können Wissenschaftler beispielsweise ein Kinematikmodell als Schicht integrieren, indem sie einem Roboterarm beibringen, sich zu bewegen, um die geschmeidigen Bewegungen eines Roboters sicherzustellen.

Theseus ist die anfängliche nichtlineare Optimierungsbibliothek, die von Apps unabhängig ist. Im Gegensatz zu Googles C++ Ceres Solver ist es viermal schneller. Um die Berechnung und den Speicher zu beschleunigen, bietet Theseus Batching, GPU-Beschleunigung, Sparse Solver und implizite Differenzierung.

Theseus vereint die besten Aspekte zweier sehr anerkannter KI-Wissensinjektionsmethoden. Vor dem gründlichen Studium verwendeten Robotikforscher viel einfachere KI-Optimierungstechniken wie die, dass die Roboterprogramme Befehle ausführen, indem sie die geringste Menge an Gelenkbewegungen und Stromverbrauch vorhersagen. Diese Strategie war effektiv, aber dank der Software-spezifischen Optimierungsansätze steif. Obwohl Deep Discovery-Methoden weiter skalierbar sind, benötigen sie viele Fakten und können hilfreiche, aber instabile Lösungen außerhalb der Bildungsatmosphäre schaffen. Da Theseus nicht anwendungsspezifisch ist, kann KI schnell weitere Erkenntnisse gewinnen, indem spezifische Produkte für spezielle Aufgaben und Fälle entwickelt werden.

Wissenschaftler verwenden einen richtig gewählten Ablehnungszweck, um ein Deep-Learning-Modell für einen bestimmten Prozess zu trainieren. Den Forschern zufolge muss nahezu jede Schicht für Backpropagation differenzierbar sein, um Modellgewichte zu aktualisieren und den Fluss von Fehlerdaten zu ermöglichen. Wissenschaftler erleben einen Kompromiss, einfach weil reguläre Optimierungsalgorithmen nicht von Stopp zu Stopp differenzierbar sind. Entweder geben sie die Optimierung zugunsten einer gründlichen, auf die jeweilige Situation zugeschnittenen Suche auf, wodurch die Nützlichkeit und Allgemeingültigkeit der Optimierung verloren geht. Das Produkt kann auch offline erlernt und zum Zeitpunkt der Inferenz hinzugefügt werden. Die zweite Methode kombiniert tiefes Verständnis und vorheriges Verständnis, aber ihre Vorhersagen können ungenau sein, einfach weil das Deep-Finding-Out-Modell ohne den prozessspezifischen Fehlerzweck geschickt ist.

Quelle: https://github.com/facebookresearch/theseus

Quelle: https://github.com/facebookresearch/theseus

Absolut kostenlos-2 Min AI E-NewsletterWerden Sie Teil von über 500.000 KI-Leuten

Um diese Taktiken zu integrieren, wandelt Theseus Optimierungsergebnisse in eine Ebene um, die jeder neuronalen Netzwerkarchitektur hinzugefügt werden kann. Als Teil der abschließenden eingehenden Studienarchitektur ermöglicht dies den Wissenschaftlern, die endgültige Prozessreduktion unter Anwendung eines bereichsspezifischen Verständnisses optimal abzustimmen.

Die Abweichung der nichtlinearen Funktion vom projizierten Wissen wird mit NLS gemessen. Wenig wertvolle Hinweise auf die großartige Leistung der Leistung. In der Robotik und im Sehvermögen wird NLS zum Abbilden, Schätzen, Planen und Regulieren verwendet.

Durch die Integration nichtlinearer Optimierung in neuronale Netze wird Theseus NLS differenzierbar machen. Eine objektive Funktion der Summe gewichteter Quadrate wird durch Eingabetensoren beschrieben, und Ausgabetensoren erzeugen ihr Minimum im Gegensatz zu neuronalen Ebenen, die eine nichtlineare Aktivierungsfunktion komponentensensibel implementieren und Eingabetensoren linear interpretieren. Die Berechnung des Abschluß-zu-Abschluss-Gradienten wird bei der Differenzierung durch den Optimierer beibehalten.

Als Ergebnis können Typen Bereichsbewusstsein kodieren und aus der Stellenreduzierung lernen, wie z. Zum Beispiel könnten Wissenschaftler im Optimierer auf anerkannte Roboterkinematik zurückgreifen, um flüssige Roboterbewegungen zu versprechen. Das Deep Mastering-Modell wird den tieferen Sinn aus der Vorstellung oder dem Sprachunterricht im Unterricht herausholen. Unter Verwendung des perfekt anerkannten kinematischen Designs konnten Wissenschaftler das Absichtsvorhersagemodell von Anfang bis Ende konstruieren. Schließlich ermöglicht die Bibliothek die Codierung von Bereichsinformationen in Schlussfolgerung-zu-Ende-KI-Typen. Wissensökonomisches System und Verallgemeinerung werden verbessert, wenn anerkannte Priors mit neuronalen Elementen gemischt werden.

Sparse Solver, automatisierte Vektorisierung, Batching, GPU-Beschleunigung und implizite Gradientenberechnung werden alle von Theseus unterstützt. Theseus übertrifft Löser wie Ceres (die nur bei Sparsity helfen), indem sie implizite Differenzierung, Sparsity, Auto-Diff und GPU-Beschleunigung ermöglichen. Auf einer gängigen GPU arbeitet Theseus schneller und verbraucht viel weniger Speicher. Beim Lösen eines Teams anspruchsvoller Probleme ist der Advance Pass von Theseus bis zu 4 Instanzen schneller als der von Ceres. Durch implizites Differenzieren entstehen größere Gradienten als durch Abrollen. Im Gegensatz zum Entrollen behält die implizite Differenzierung einen konstanten Speicher-und Berechnungsfußabdruck bei, wenn die Anzahl der Optimierungsrunden zunimmt, wodurch vergleichsweise verbesserte Gradienten erzeugt werden.

Die Mitarbeiter glauben, dass ihre Methodik eine weitere Untersuchung der Funktion und Entwicklung von Strukturen in komplexen Robotertechniken, ein umfassendes Studium dieser Art von Methoden und ein kontinuierliches Verständnis durch Interaktionen mit ernsthaften Globus-Objekte.

Dieser Artikel wurde als zusammenfassender Beitrag von Marktechpost-Mitarbeitern erstellt, der hauptsächlich auf dem Explorationspapier’Theseus: Eine Bibliothek für differenzierbare nichtlineare Optimierung‘. Die gesamte Kredithistorie für diese Untersuchung geht an Wissenschaftler dieses Unternehmens. Schauen Sie sich das Papier an, Github-Website-Link, Aufgabe und Tutorials. Bitte vergessen Sie nicht, Teil von unserem ML-Subreddit zu sein. Bewerten Sie diesen Beitrag

Sharing is caring!