Der Aufstieg der künstlichen Intelligenz (KI) hat zweifellos zu erheblichen Fortschritten in verschiedenen Bereichen geführt, einschließlich der Verarbeitung natürlicher Sprache und der Textgenerierung.

Mit dem zunehmenden Missbrauch von KI im akademischen Umfeld wurde jedoch der Bedarf an Tools zur Erkennung von KI-generierter Arbeit deutlich.

Diese Tools sollten die Integrität von Bildungseinrichtungen wahren und sicherstellen, dass die Schüler ihre eigenen Originalarbeiten produzieren.

Sind „KI-geschriebene Detektoren“ korrekt?

Leider traten unvorhergesehene Konsequenzen auf, als der Einsatz von „KI-geschriebenen Detektoren“ zunahm, die zu Kontroversen und unrechtmäßigen Anschuldigungen führten.

Mit der Einführung leistungsstarker Sprachmodelle wie Chat GPT konnten Studierende mühelos Aufsätze, Berichte und sogar ganze Aufsätze erstellen, indem sie die Fähigkeiten der KI nutzen.

Dieses unethische Verhalten löste bei Pädagogen Bedenken aus und veranlasste die Entwicklung von KI-Erkennungssystemen, um Instanzen von KI-generierten Inhalten zu identifizieren.

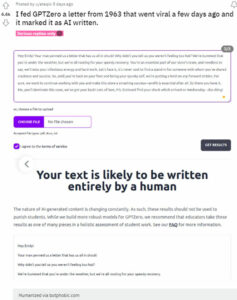

Aber kürzlich gab ein Benutzer GPTZero einen Brief aus dem Jahr 1963, in dem Anschließend ging es auf verschiedenen Social-Media-Plattformen viral.

Überraschenderweise markierte das KI-Erkennungstool den Brief als von KI verfasst, was Ungläubigkeit und Besorgnis auslöste.

Quelle (Zum Anzeigen klicken/tippen)

Quelle (Zum Anzeigen klicken/tippen)

Der Vorfall warf Fragen zur Genauigkeit auf und Zuverlässigkeit der KI-Erkennungssysteme, die zum Schutz der Integrität implementiert wurden.

Im Zuge der Kontroverse um virale Briefe begannen mehrere Personen über mögliche Fehleinschätzungen von KI-Erkennungssystemen zu spekulieren (1,2,3,4,5).

Dies wurde durch einen aktuellen Test von Die Washington Post auf Turnitin, die eine Gesamtgenauigkeit von 98 Prozent angibt, hat bei über der Hälfte der Aufsätze zumindest teilweise Fehler gemacht.

Außerdem erzielte The Bible in einem anderen Test auf Writer nur 11 Punkte % von Menschen generierten Inhalten, während ein Copy-Paste von ChatGPT 98 % von Menschen generierten Inhalten erzielte.

Quelle (Klicken Sie auf/Zum Anzeigen tippen)

Quelle (Klicken Sie auf/Zum Anzeigen tippen)

Wenn ein authentisches, von Menschen geschriebenes Dokument wie der Brief von 1963 und die Bibel als KI-generiert gekennzeichnet werden könnten, dann ist es plausibel, dass unzählige Schüler aufgrund fehlerhafter KI-Erkennung mit ungerechtfertigten Strafen konfrontiert wurden.

Genau das war in Texas der Fall, wo ein Professor Schlagzeilen machte, indem er eine ganze Klasse von Oberstufenschülern durchfiel und behauptete, sie hätten alle „Chat GTP“ verwendet, um ihre Aufgaben zu schreiben.

Diese Entscheidung führte dazu, dass ihr Abschluss blockiert wurde, was diese Studenten am Boden zerstörte und ihre akademische Zukunft in Gefahr brachte.

Quelle (Zum Anzeigen klicken/tippen)

Quelle (Zum Anzeigen klicken/tippen)

Der Professor erklärt, dass er verwendet hat sein eigenes ChatGPT-Konto, um die Aufgaben der Schüler zu überprüfen. Wenn die KI behauptete, die Inhalte generiert zu haben, erhielten die Schüler eine Nullnote.

Solche Fälle waren auf Twitter zu sehen, wo Schüler behaupteten, dass sie zu Unrecht durchgefallen seien, weil der Lehrer nicht verstanden habe, wie man diese Tools verwendet oder aufgrund falscher Ergebnisse von ihnen (1,2,3).

Komischerweise hätte ich im College fast einen Geschichtskurs wegen einem nicht bestanden dieser KI-Plagiatsdetektoren. Es ist ein Fehler aufgetreten und ich habe meine letzte Arbeit über den Toledo-Krieg beschuldigt, von einem slawischen Autor geschrieben worden zu sein, der ausschließlich über die sowjetische Kontrolle Osteuropas geschrieben hat.

Quelle

Als Reaktion auf diese alarmierenden Enthüllungen hat eine Bildungswebsite,’itwasntai.com“wurde gegründet, um Einzelpersonen Orientierung zu geben, denen fälschlicherweise vorgeworfen wird, beim Verfassen ihrer Arbeiten KI zu verwenden.

Diese Plattform zielt auch darauf ab, die Lehrer zu schulen und diejenigen zu stärken, die möglicherweise Opfer fehlerhafter KI-Erkennungssysteme geworden sind.

Quelle (Zum Anzeigen klicken/tippen)

Quelle (Zum Anzeigen klicken/tippen)

Die Existenz einer solchen Website unterstreicht die dringende Notwendigkeit einer umfassenden Überprüfung der KI-Erkennung Werkzeuge und die Entwicklung genauerer und zuverlässigerer Methoden.

Diese Kontroverse um KI-geschriebene Detektoren hat unweigerlich Bedenken hinsichtlich des blinden Vertrauens in diese Systeme geweckt.

Es stellt sich die Frage: Wenn wir den von der KI generierten Inhalten selbst nicht vollständig vertrauen können, warum haben wir dann den von der KI geschriebenen Detektoren blind vertraut?