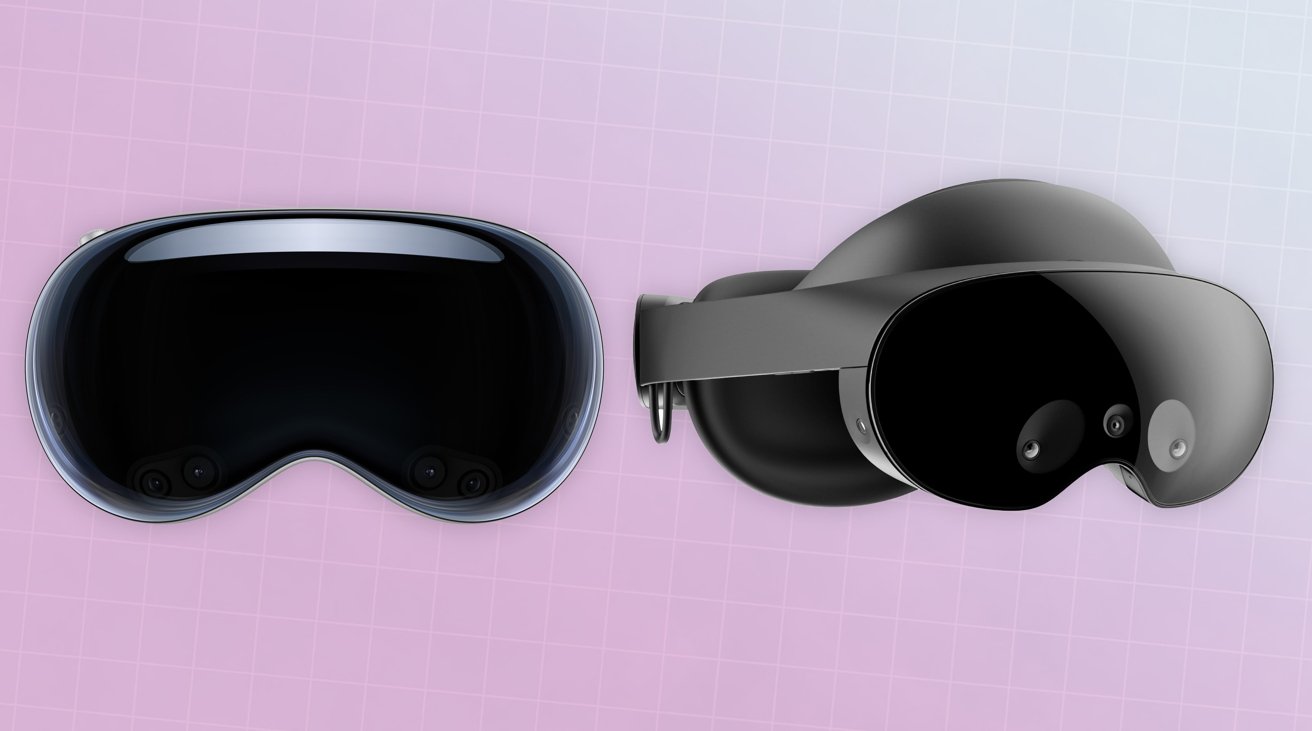

Apple Vision Pro [links], Meta Quest Pro [rechts]

Die bestehenden Headset-Bemühungen von Apple Vision Pro und Meta unterscheiden sich nicht nur in der Hardware, sondern auch in der Philosophie. So variieren die Ansätze.

Apples erster Schritt in den Mixed-Reality-Bereich, das Vision Pro, ist ein großer Schritt für den iPhone-Hersteller. Nach Jahren der Gerüchte und Spekulationen schließt sich das Unternehmen endlich der Headset-Party an und produziert eine völlig neue Plattform, die von der bestehenden Liste an Mobilgeräten und Macs abweicht.

Der Schritt hat offensichtlich die Aufmerksamkeit der Menschen auf sich gezogen und verspricht ein Hoch-Qualitäts-AR-Erlebnis und ein einfach zu navigierendes System. Hochauflösende Displays zum Anzeigen von Inhalten und sogar eine nach außen gerichtete Version, damit andere Personen sie sehen können.

Ein Ort, der den Anträgen von Apple sicherlich Aufmerksamkeit geschenkt hat, ist Meta, das begonnen hat, Apples Headset zu bekämpfen. Tage vor der WWDC versuchte Meta, Apple mit einer Anspielung auf das Meta Quest 3 den Wind aus den Segeln zu nehmen.

Nach der Ankündigung von Apple entließ Mark Zuckerberg, CEO von Meta, den Mitarbeitern den Vision Pro, dass Apple nichts bringe Neu auf dem Tablet, das von Meta noch nicht „erforscht“ wurde. Er wies auch darauf hin, dass Apple immer wieder Leute einsetze, die „allein auf der Couch sitzen“, und betonte, dass dies zwar Apples „Vision der Zukunft des Computerwesens“ sei, aber nicht „die, die ich will“.

Zuckerberg sagte außerdem zu seinen Mitarbeitern: „Ich denke, dass ihre Ankündigung den Unterschied in den Werten und der Vision, die unsere Unternehmen dabei einbringen, wirklich auf eine Art und Weise zeigt, die ich für wirklich wichtig halte.“

Eine Untersuchung der Art und Weise, wie die Headsets der einzelnen Unternehmen hergestellt werden, sowie ihrer Verwendung kann sicherlich einige der Denkunterschiede zwischen den beiden Unternehmen aufzeigen, die darum kämpfen, die Aufmerksamkeit der Zukunft in diesem Bereich zu erobern.

Der offensichtlichste Weg, um zu sehen, wie jedes Unternehmen über die Zukunft der Mixed-Reality-Welträume denkt, ist das Design der Headsets selbst. Obwohl sie im Wesentlichen sehr ähnlich sind, unterscheiden sie sich doch sehr stark.

Von außen betrachtet scheint das Vision Pro ein sehr hochwertiges Gerät zu sein, denn sein dreidimensional geformtes Verbundglas ist an einem Rahmen aus Aluminiumlegierung befestigt und sorgt für ein elegantes Erscheinungsbild. Auch die Verwendung von gewebten Materialien für das Light Seal sowie das austauschbare Kopfband mit einem Fit Dial für individuellen Komfort passen in den gleichen Stil.

Dies sind charakteristische Elemente der Designsprache von Apple und machen sie sehr unverwechselbar.

Apple Vision Pro ist ein wunderschönes Headset

Im Gegensatz dazu geht es bei den Headsets von Meta weniger um ein Premium-Angebot als vielmehr um die Ausstattung mit Funktionen, während gleichzeitig versucht wird, den Preis niedrig oder zumindest für Verbraucher erschwinglich zu halten.

Der Meta Quest Pro verfügt zwar über einen großen Frontschutz, ist jedoch an einer mit Kunststoff beladenen Konstruktion befestigt, die um den Kopf herum bis zu einem hinteren Element reicht. Kunststoff macht das Headset zwar leicht zu tragen, aber es fühlt sich tendenziell billig an, und das lässt sich nicht vermeiden.

Das Meta Quest 2 und das angekündigte Pro gehen noch einen Schritt weiter und verzichten überhaupt auf eine glänzende, glasartige Front. Offensichtlich bietet das glänzende Schutzschild des Meta Quest Pro außer der Aufnahme von Sensoren keinen Nutzen, aber für die günstigeren Consumer-Editionen gibt es überhaupt keinen Anspruch.

Die günstigeren Modelle setzen außerdem auf einfachere Gummibänder, um das Headset am Kopf des Benutzers zu halten. Anpassungen sind möglich, aber Sie suchen immer noch nach dem kostengünstigsten Ansatz, um die Aufgabe zu erfüllen.

Der Erfolg von Meta liegt in der Platzierung des Akkus des Quest Pro, da dieser im hinteren Element am Hinterkopf des Benutzers integriert ist.

Meta Quest Pro platziert den Akku um die Rückseite herum Gleichgewicht.

Während bei den Quest 2 und 3 der Akku im Hauptgehäuse des Headsets integriert ist, erhöht sich dadurch das Gewicht auf der Vorderseite des Geräts, was das Tragen des Headsets über längere Zeiträume weniger komfortabel macht. Durch die Verlagerung des Akkus hinter den Kopf beim Quest Pro wird das Gewicht der Stromversorgungskomponente nicht verringert, es wird jedoch ausgeglichen, sodass das Headset nicht so stark von vorne nach unten drückt.

Das Apple Vision Pro umgeht das Problem der Batterieplatzierung, da es nicht in die übliche Design-Erzählung von Apple passt.

Andere Apple-Hardware verfügt über integrierte Batterien, was dem Designstil des Meta Quest 2 und 3 ähneln würde. Dies kann jedoch zu Unannehmlichkeiten führen und ein bereits potenziell schweres Gerät aufgrund der Verwendung von Glas belasten und Aluminium musste Apple darüber nachdenken, es woanders unterzubringen.

Mit dem Akku hätte es den Weg des Quest Pro nehmen können, aber Apple hat es nicht getan. Stattdessen widersprach es der üblichen Designsprache und fügte einen anschließbaren Akku hinzu, der in die Tasche gesteckt werden sollte.

Dies ist eine unelegante Lösung von Apple, insbesondere wenn Meta mit der bereits verfügbaren Version des Quest Pro scheinbar die richtige Antwort hat. Natürlich könnte der allgegenwärtige Apple-Zubehörmarkt die Initiative ergreifen und ein Holster für das Stirnband herstellen, das den Akku aufnehmen kann, aber das hätte Apple vermeiden können.

Man kann durchaus sagen, dass neuere und teurere Geräte im Allgemeinen über bessere Anzeigesysteme verfügen. Bei Headsets ist es grundsätzlich dasselbe.

In den Spezifikationen von Meta für das Quest Pro sind zwei LCD-Panels aufgeführt, die eine Auflösung von 1.800 x 1.920 Pixel pro Auge bieten, wobei die Hintergrundbeleuchtung lokal gedimmt wird, um das Bild zu verbessern. Benutzerdefinierte Pancake-Objektive werden verwendet, um das optimale Bild für den Benutzer zu erhalten, aber das ist zu erwarten, wenn man bedenkt, dass es die Sehkraft des Benutzers beeinträchtigt, etwas aus einem Zentimeter Entfernung so zu sehen, als ob es mehrere Meter entfernt wäre.

Seltsamerweise unterscheidet sich die Auflösung der LCD-Panels nicht wesentlich von der des Quest 2, dessen LCD-Displays eine Auflösung von 1.832 x 1.920 pro Auge haben.

Apple hat nicht viele Einzelheiten zu seinem internen Anzeigesystem bekannt gegeben, abgesehen von der Verwendung eines Mikro-OLED-Anzeigefelds für jedes Auge, wobei zwei Felder dem Benutzer zusammen über 23 Millionen Pixel liefern.

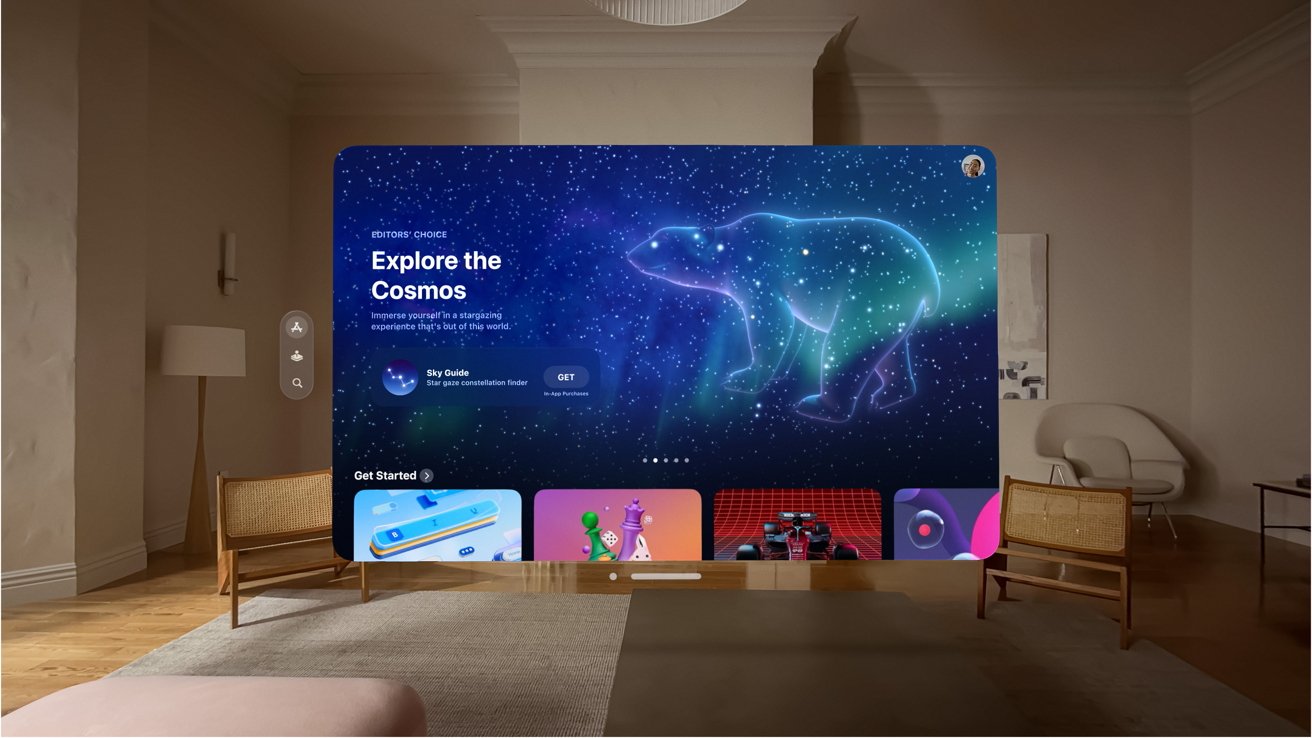

Die Benutzeroberfläche von Apple ist sauber und grafisch schön, unterstützt durch hochauflösende Displays.

Die Verwendung von Mikro-OLED verschafft Apple einen erheblichen Vorteil, da OLED für jedes Pixel selbstleuchtend ist. Dies erspart Apple die Notwendigkeit einer Hintergrundbeleuchtung und bietet im Vergleich zu LCD-basierten Systemen eine hervorragende Bildqualität.

Was die Auflösung betrifft, so entsprechen 23 Millionen Pixel etwa 11,5 Millionen Pixel pro Auge. Angesichts der Tatsache, dass ein 4K-Fernseher etwa 8 Millionen Pixel bietet, sind die 11,5 Millionen pro Auge natürlich deutlich höher.

Dies kann bedeuten, dass Probleme wie der „Screen Door“-Effekt, unter dem einige Displays leiden können, erheblich gemildert werden können. Ganz zu schweigen davon, dass gestochen scharfe Bilder möglich sind, die den Benutzern ein stärkeres Gefühl des Eintauchens vermitteln können als alles mit einer leicht verpixelten Kontur.

Allerdings ist das noch nicht alles, wenn es um Displays geht, zumindest auf Seiten von Apple.

Auf der Außenseite des Vision Pro befindet sich ein größeres OLED-Panel, das der Öffentlichkeit zugewandt ist. Es ist dort ausgerichtet, wo die Augen wären, wenn der Headset-Träger andere anschauen würde. Mithilfe einiger Tricks des maschinellen Lernens und der Generierung einer digitalen Form des Benutzers werden die Augen des Benutzers angezeigt und angezeigt, wohin er schaut, wenn er sich auf Dinge in seiner lokalen Umgebung konzentriert.

Für Apple ist dies eine kleine Umstellung, da bereits viel Arbeit geleistet wurde, um sicherzustellen, dass das Benutzererlebnis im Kern so gut wie möglich ist.

Ein modernes Headset verfügt über viele externe Sensoren und Kameras, um ordnungsgemäß zu funktionieren. Es muss den Raum und seinen Inhalt sowie in einigen Fällen auch den Benutzer erfassen.

Es gibt offensichtlich viele Überschneidungen zwischen den Geräten, aber auch einige erhebliche Unterschiede.

Das kostengünstige Meta Quest 2 verfügt über einige kleine Sensoren, die die Umgebung sowie die Hände des Benutzers zur Fingerverfolgung erfassen können. Die Controller verfügen über integrierte Infrarot-LEDs, die dabei helfen, sie in der virtuellen Welt in der richtigen Position zu halten.

Sie erhalten jedoch keine ordnungsgemäße AR-Ansicht, da alle Erlebnisse zu Graustufen und einer nicht ganz schönen Ansicht Ihrer Umgebung führen.

Metas Quest Pro verbessert dies durch den Einsatz hochauflösender Farbkameras und ermöglicht so ein viel besseres Erlebnis in AR-Situationen. Darüber hinaus gibt es Eye-und Face-Tracking-Sensoren, die vor allem für Avatar-Funktionen eingesetzt werden.

Sie können die Sensoren auf Metas Quest Pro deutlich sehen

Beim Vision Pro ist Apple einen ähnlichen Weg gegangen und hat ein Paar hochauflösender Kameras für die Bereitstellung des Hauptbilds eingebaut. Die übrigen Sensoren decken Elemente wie Kopf-und Handverfolgung sowie Echtzeit-3D-Kartierung ab.

Im Rahmen der Vereinbarung wird laut Apple eine an der Vorderseite montierte TrueDepth-Kamera verwendet. Außerdem werden ein LiDAR-Scanner und Infrarot-Flutlichter für eine verbesserte Leistung bei schlechten Lichtverhältnissen erwähnt.

Apple hat viel dafür getan, die Sensoren zu verstecken und die meisten davon unter der Oberfläche des Frontglases versteckt zu halten, aber es gibt zwei markante, nach unten gerichtete Sensoren, die zur Verfolgung der Hände dienen.

Im Inneren umgeben LEDs und Infrarotkameras jedes Auge, um unsichtbare Lichtmuster zu projizieren und zu lesen und so die Eye-Tracking-Funktionen zu ermöglichen.

Apple Vision Pro hat viel Äußeres-zugewandte Sensoren

Um diesen Berg an Informationen zu verarbeiten, verwendet Apple zwei Chips im Vision Pro. Der M2 wird für das Hauptrendering und die App-bezogene Verarbeitung verwendet, die Verarbeitung aller Eingaben wird jedoch an einen neuen R1-Chip übergeben.

Da es für die Verarbeitung von Eingaben von Kameras, Sensoren und Mikrofonen konzipiert ist, trägt der R1 dazu bei, die Verarbeitung zu reduzieren, um die Eingangsverzögerung auf bis zu 12 Millisekunden zu minimieren.

Meta hat die Verarbeitungsaufgaben an die Lösung eines anderen Unternehmens übergeben, anstatt eine eigene Lösung zu entwickeln. Der Quest Pro setzt auf Qualcomms Snapdragon XR2+, einen Chip, der für den Einsatz in VR-und MR-Erlebnissen konzipiert ist.

Obwohl wir den Snapdragon nicht wirklich mit der Zwei-Chip-Lösung von Apple vergleichen können, scheint es, dass Apples Entscheidung, ein äußerst fesselndes Erlebnis mit dem Bedarf an hoher Leistung zu schaffen, die Existenz seines Multi-Chip-Systems rechtfertigt.

Ein großer Unterschied zwischen den beiden Unternehmen besteht darin, wie ihre Geräte gesteuert werden. Die Art und Weise, wie der Benutzer miteinander interagiert, ist ein wichtiges Element von MR als Ganzes.

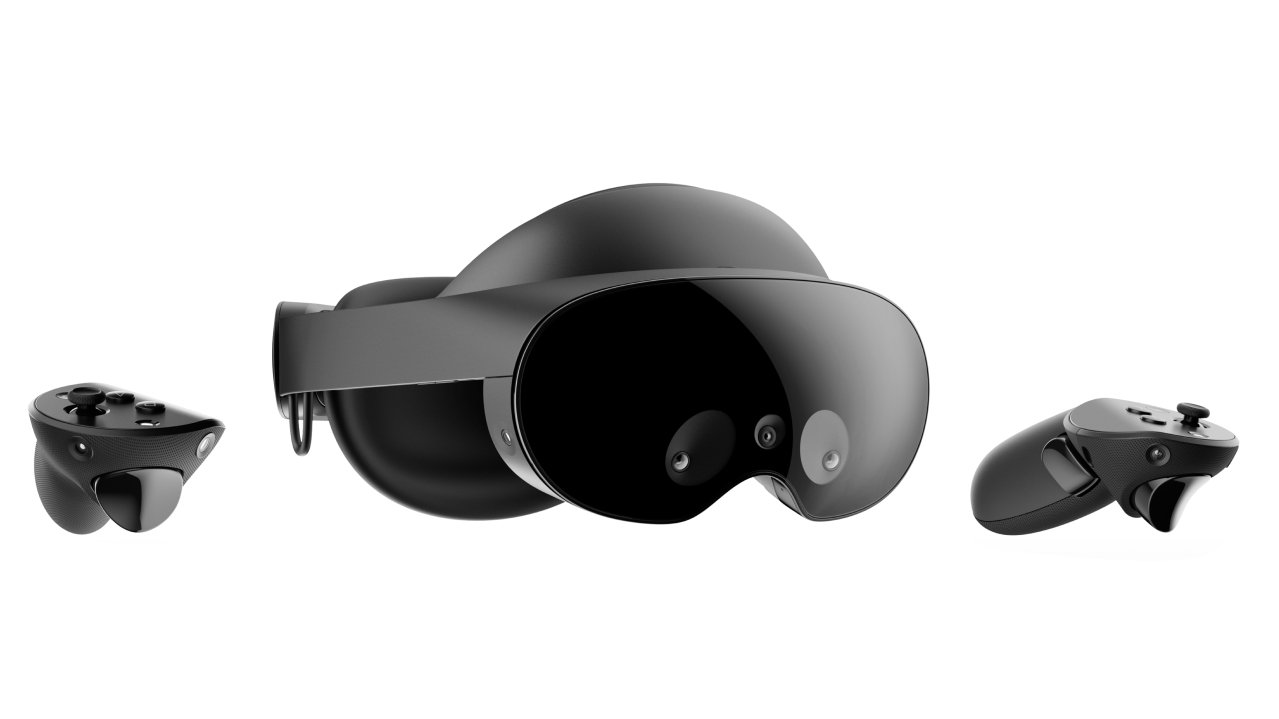

Meta verlässt sich immer noch stark auf Controller, wobei sowohl beim Meta Quest 2 als auch beim Quest Pro linke und rechte Controller verwendet werden. Das Quest Pro-Paar ist mit Sensoren ausgestattet, um die Position selbst zu bestimmen, während die Quest 2 eher wie Beacons sind, die direkt vom Headset verfolgt werden.

Im Fall von Meta sind die Controller die wichtigste Art der Interaktion, aber sie sind nicht die einzige Möglichkeit. Die integrierten Sensoren sind in der Lage, die Hände des Benutzers zu erkennen, sodass eine Art Handverfolgung möglich ist.

Apple setzt auf Hand-Tracking statt auf Controller

Im Gegensatz dazu verfolgt Apple einen Controller-freien Ansatz und setzt eher auf eine Kombination aus Hand-und Eye-Tracking. Der Vision Pro kann zunächst die Hände des Benutzers erkennen, feststellen, womit er interagiert, und entsprechend handeln.

Wenn das Eye-Tracking aktiviert ist, kann Vision Pro Benutzeroberflächenelemente ermitteln, auf die sich die Augen des Benutzers aktiv konzentrieren. Die Handverfolgung kann dann einen kurzen Pinch-Befehl als Bestätigung verwenden, um auszuwählen, was die Augen des Benutzers ausgewählt haben.

Dies scheint insgesamt eine intuitivere Benutzeroberfläche zu sein, da Sie nicht daran denken, Ihre Hand an Ort und Stelle zu bewegen, sondern stattdessen nur hinsehen.

Was die Verwaltung des Immersivitätsgrads angeht, verfügt Apple mit der Digital Crown wohl über ein saubereres System. Benutzer können damit granular zwischen AR-und VR-Ansichten wechseln, sodass sie ihre Umgebung so wenig oder so viel wahrnehmen, wie sie möchten.

Diese Granularität ist auf den Meta-Plattformen nicht verfügbar, es gibt jedoch Möglichkeiten, zwischen AR-ähnlichen Ansichten der Umgebung und der verwendeten Haupt-App zu wechseln.

Viele Aufgaben und Anwendungen, die Sie mit den einzelnen Headsets erledigen können, sind im Großen und Ganzen gleich. Dem kann man kaum widersprechen, da das Ökosystem im Allgemeinen sehr gut versorgt ist.

Wenn man sich anschaut, wie jede Plattform die Aufgaben selbst erledigt und wie sie genutzt werden, werden Unterschiede im Ethos deutlich.

Nehmen Sie zum Beispiel die Verwendung eines Computers. Ja, es ist durchaus möglich, jeden an einen Desktop-Mac anzuschließen und den Mac-Desktop selbst zu verwenden, aber jeder macht das anders.

Meta ist auf eine Server-App angewiesen, die auf dem Mac ausgeführt wird und Anzeigen in einer virtuellen Umgebung präsentiert. Aufgrund technischer Einschränkungen gibt es einige Zugeständnisse, wie zum Beispiel bei Horizon Workrooms in Quest 2, bei dem die Displays größtenteils in einer Cartoon-ähnlichen Umgebung und nicht in der realen Welt platziert werden.

Horizon Workrooms‘ privat Büro mit Mac-Anzeigen auf einem Meta Quest 2

Sie sind sich sehr bewusst, dass Sie immer noch am Gerät selbst arbeiten und das Headset lediglich als Kanal für die Ansicht vom Mac verwenden. Dies liegt vor allem daran, dass die Verbindung vorher bewusst hergestellt werden muss.

Apples Lösung beginnt mit der hochwertigen AR-Ansicht, ermöglicht dann aber schnell, das Display vom Mac in den virtuellen Raum hochzuziehen. Im Gegensatz zum Quest 2, das die Interaktion mit Ihren Peripheriegeräten erschwert, da diese nicht sichtbar sind oder durch ein körniges AR-Fenster in Ihrer Schreibtischoberfläche behindert werden, können Sie bei Apple stattdessen die Tasten ungehindert sehen, wenn Sie dies wünschen.

Wenn Sie in einem Videoanruf mit anderen kommunizieren, möchten Sie sichtbar sein, aber das Headset überhaupt nicht zeigen. Auch hier gibt es unterschiedliche Meinungen.

Meta verlässt sich bei einer solchen Kommunikation auf cartoonartige Avatare des Benutzers, was in Ordnung, aber nicht ideal ist. Sie werden keine so persönliche Verbindung aufbauen, wie Sie es könnten, wenn die Leute Ihr tatsächliches Gesicht sehen würden.

Apples Alternative ist eine Persona, eine digitale Nachbildung des Gesichts des Benutzers, die mit der vorderen TrueDepth-Kamera erstellt wurde. Sobald die Persona erstellt wurde, erscheint sie für den Benutzer als realistisch aussehende Annäherung, einschließlich der Augen-, Hand-und Kopfbewegungen, die von allen integrierten Sensoren erfasst werden.

Persona von Apple Vision Pro

Es ist weder cartoonhaft noch perfekt, aber für einen FaceTime-Anruf ist es besser, als einen Cartoon-Avatar oder jemanden mit Headset anzusehen.

Ein Bereich, den wir nicht ohne weiteres abdecken können, sind Spiele und immersive Apps. Während wir viel darüber wissen, was die Quest-Reihe von Meta im Gaming-Bereich bieten kann, hat Apple nur sehr wenig darüber berichtet, was wir in diesem Bereich vom Vision Pro erwarten können.

Es ist möglich, dass Drittentwickler am Ende viele Apps für das Vision Pro erstellen, was zum Teil auf die Zusicherungen von Apple zurückzuführen ist, dass iPad-Apps relativ einfach darauf konvertiert werden könnten. Viele davon können auch Spiele sein.

Zumindest im Moment scheint es jedoch, dass Apple mehr auf die Produktivitätsseite setzt, insbesondere wenn es um die Zusammenarbeit mit anderen geht.

Ein Punkt, bei dem Apple die Führung übernimmt, besteht darin, dem Benutzer den Umgang mit Menschen zu ermöglichen, die sich in seiner physischen Anwesenheit befinden. VR-und AR-Headsets sind nicht für den Einsatz in der Öffentlichkeit konzipiert, auch nicht für eigenständige Geräte, und das aus einigen guten Gründen, die jedes Unternehmen für sich selbst zu lösen versucht.

Erstens einmal können Sie die Außenwelt möglicherweise nicht unbedingt gut sehen, selbst in einer AR-Ansicht. Das Quest 2 ist eine körnige Graustufenwelt, in der dies nicht möglich ist. Das Quest Pro schneidet mit seinen höherwertigen Kameras besser ab, aber die 3D-Kartensysteme sowie die Displays des Vision Pro sollten zu einer besseren Standardansicht führen, bevor Sie Apps berücksichtigen.

Sie hätten keine Ahnung, wenn ein Meta Quest 3-Benutzer Sie in AR ansehen würde.

Es ist wichtig, die Welt sehen zu können, und zwar aus Gründen, die von der persönlichen Sicherheit bis hin zur einfachen Fähigkeit reichen, zu erkennen, dass sich jemand in der Nähe aufhält.

Die Fähigkeit, nach außen zu sehen, ist nicht unbedingt dasselbe wie die Fähigkeit, von anderen gesehen zu werden, und dies führt zu einem weiteren Problem, das andere Menschen betrifft.

Ein typisches AR-fähiges Headset ermöglicht es dem Benutzer, seine Umgebung zu sehen, es sei denn, er gibt eine äußerliche Bestätigung, z. B. indem er einem Besucher „Hallo“ sagt oder seinen Kopf dreht, um ihn, die andere Person, anzusehen werden nicht unbedingt wissen, dass der Benutzer sie ansieht. Selbst eine Kopfdrehung ist nicht besonders nützlich, da sie von einem Außenstehenden als Teil des App-Erlebnisses angesehen werden könnte und nicht unbedingt absichtlich für ihn ausgeführt wird.

Apples EyeSight, der externe Bildschirm, ist eine Möglichkeit, mit der Apple dieses Problem behebt, indem er der Person in der Nähe sichtbares Feedback gibt. Durch die Darstellung einer Persona-Version der Augen des Benutzers, komplett mit Elementen, die über Eye-Tracking zeigen, wo sich seine Augenlinie befindet, kann das externe Display dem Außenstehenden zumindest das Bewusstsein vermitteln, dass der Benutzer weiß, dass er dort ist.

Apple EyeSight

Es ist sogar ein Grad an Privatsphäre integriert, denn wenn sich der Benutzer auf eine App statt auf die Umgebung konzentriert, kann der Vision Pro stattdessen ein Muster anzeigen. Aber sobald der Benutzer erneut mit Menschen in der Nähe interagiert, kehren die Augen zurück.

Diese von außen sichtbaren Augen mögen wie ein Wegwerfmerkmal erscheinen, aber sie sind tatsächlich entscheidend für die Verwendung des Vision Pro in der Öffentlichkeit.

Für andere Menschen ist der Vision Pro-Träger nicht nur jemand, der scheinbar blind für die Welt ist. Mit EyeSight wissen die Menschen, dass der Benutzer sich auf die Umgebung einlässt, anstatt sich in ihrer eigenen kleinen Welt zu befinden.

Im Gegensatz zu Zuckerbergs Kommentar kann Vision Pro den Benutzern nicht nur ermöglichen, von ihren Sitzen aufzustehen und ihre Umgebung zu nutzen, sondern indem es eine digitale Version der Augen des Benutzers für die Welt öffnet, macht es es für alle einfacher Das Headset nicht für die Arbeit mit Personen verwenden, die es tragen.

Man könnte sagen, dass dies dem Apple Vision Pro die Funktion der menschlichen Verbindung verleiht. Etwas, das Facebook der Welt wohl nicht bieten konnte.

Es ist noch früh

Es ist wahrscheinlich, dass wir kurz vor der Veröffentlichung Anfang 2024 ein besseres Bild von den Spezifikationen haben werden Funktionen des Vision Pro, die über das hinausgehen, was Apple bei seinen Demonstrationen und der Markteinführung sorgfältig inszeniert hat.

Was wir jedoch sagen können ist, dass Meta und Apple im selben Pool sind, aber auf unterschiedliche Weise schwimmen.

Mit einiger Sicherheit ist klar, dass Apple mit dem Vision Pro den technologischen Vorsprung hat.

Aber Meta hat einen starken Vorsprung: Das Unternehmen ist bereits seit einigen Jahren auf diesem Gebiet tätig. Es hat die nötige Zeit, um echten Benutzern zu zeigen, was sie von einem Headset erwarten oder benötigen, und es wurden auch beträchtliche Summen in die Entwicklung neuer Generationen von Headsets gesteckt.

Obwohl Apple mit seinem Headset auf den metaphorischen Schultern von Giganten und Meta selbst steht, handelt es sich immer noch um eine Erstveröffentlichung, die die meisten Leute vom Kauf abhält.

Man kann auch davon ausgehen, dass sich die nächste Headset-Version von Apple in der Entwicklung befindet und preislich verbraucherfreundlicher sein wird als das 3.499 US-Dollar teure Vision Pro.

Was Apple getan hat, zeigt, dass es weiß, wovon es im VR-und AR-Bereich spricht. Mit der Vorstellung seines ersten Versuchs eines Headsets hat es für Aufsehen gesorgt, und zukünftige Veröffentlichungen werden wahrscheinlich genauso wichtig sein.

Es könnte auch Meta und Konkurrenten dazu zwingen, ihr Spiel zu verbessern und ihre eigenen Entwicklungsbemühungen ernsthaft zu überdenken.

Apple hat möglicherweise bereits mit einem Produkt eine ganze Branche verändert, und es ist noch über ein halbes Jahr von der Markteinführung entfernt.