KI erobert die Welt im Sturm, und Sie können zwar Google Bard oder ChatGPT verwenden, Sie können aber auch eine lokal gehostete Lösung auf Ihrem Mac verwenden. So verwenden Sie die neue MLC LLM-Chat-App.

Künstliche Intelligenz (KI) ist die neue Spitzentechnologie der Informatik und sorgt in der Computerwelt für großen Hype.

Chatbots – KI-basierte Apps, mit denen sich Benutzer als Fachexperten unterhalten können – erfreuen sich gelinde gesagt wachsender Beliebtheit.

Chatbots verfügen scheinbar über Expertenwissen zu einer Vielzahl allgemeiner und spezieller Themen und werden überall in rasantem Tempo eingesetzt. Eine Gruppe – OpenAI-hat einige ChatGPT veröffentlicht vor Monaten in eine schockierte Welt.

ChatGPT verfügt über scheinbar grenzenloses Wissen zu praktisch jedem Thema und kann Fragen in Echtzeit beantworten, die sonst Stunden oder Tage der Recherche erfordern würden. Sowohl Unternehmen als auch Arbeitnehmer haben erkannt, dass KI zur Beschleunigung der Arbeit durch Verkürzung der Recherchezeit eingesetzt werden kann.

Die Kehrseite

In Anbetracht all dessen gibt es jedoch auch eine Kehrseite einiger KI-Apps. Der Hauptnachteil der KI besteht darin, dass die Ergebnisse noch überprüft werden müssen.

Obwohl KI in der Regel größtenteils korrekt ist, kann sie fehlerhafte oder irreführende Daten liefern, die zu falschen Schlussfolgerungen oder Ergebnissen führen können.

Softwareentwickler und Softwareunternehmen haben sich für „Copiloten“ entschieden – spezialisierte Chatbots, die Entwicklern beim Schreiben von Code helfen können KI lässt die Gliederung von Funktionen oder Methoden automatisch schreiben – was dann von einem Entwickler überprüft werden kann.

Copiloten können zwar viel Zeit sparen, aber auch falschen Code schreiben. Microsoft, Amazon, GitHub und NVIDIA haben alle Copiloten für Entwickler veröffentlicht.

Erste Schritte mit Chatbots

Um zumindest weitgehend zu verstehen, wie Chatbots funktionieren, müssen Sie zunächst die Grundlagen der KI und insbesondere des maschinellen Lernens verstehen (ML) und Large Language Models (LLMs).

Maschinelles Lernen ist ein Zweig der Informatik, der sich der Erforschung und Entwicklung von Versuchen widmet, Computern das Lernen beizubringen.

Ein LLM ist im Wesentlichen ein Programm zur Verarbeitung natürlicher Sprache (NLP), das riesige Datenmengen und neuronale Netze (NNs) verwendet, um Text zu generieren. LLMs funktionieren, indem sie KI-Code auf großen Datenmodellen trainieren, die dann im Laufe der Zeit von ihnen „lernen“ und im Wesentlichen auf der Grundlage der Genauigkeit der Eingabedaten zu einem Domänenexperten in einem bestimmten Bereich werden.

Je mehr (und genauer) die Eingabedaten, desto präziser und korrekter wird ein Chatbot sein, der das Modell verwendet. Auch LLMs setzen beim Training anhand von Datenmodellen auf Deep Learning.

Wenn Sie einem Chatbot eine Frage stellen, fragt er sein LLM nach der am besten geeigneten Antwort ab – basierend auf seinem Lern-und gespeicherten Wissen zu allen Themen im Zusammenhang mit Ihrer Frage.

Im Wesentlichen verfügen Chatbots über vorberechnetes Wissen über ein Thema und können bei einem ausreichend genauen LLM und ausreichender Lernzeit viel schneller korrekte Antworten liefern als die meisten Menschen.

Mit einem Chatbot steht Ihnen sofort ein automatisiertes Team von Doktoranden zur Verfügung.

Im Januar 2023 veröffentlichte Meta AI sein eigenes LLM namens LLaMA. Einen Monat später stellte Google seinen eigenen KI-Chatbot Bard vor, der auf seinem eigenen LLM LaMDA basiert. Seitdem sind weitere Chatbots entstanden.

Generative KI

In jüngerer Zeit haben einige LLMs gelernt, nicht-textbasierte Daten wie Grafiken, Musik und sogar ganze Bücher zu generieren. Unternehmen sind an generativer KI interessiert, um beispielsweise Unternehmensgrafiken, Logos, Titel und sogar digitale Filmszenen zu erstellen, die Schauspieler ersetzen.

Das Miniaturbild für diesen Artikel wurde beispielsweise von KI generiert.

Als Nebeneffekt der generativen KI haben Arbeitnehmer Angst davor, ihren Arbeitsplatz durch die durch KI-Software vorangetriebene Automatisierung zu verlieren.

Chatbot-Assistenten

Der weltweit erste kommerzielle, für Benutzer verfügbare Chatbot (BeBot) wurde 2019 von Bespoke Japan für Tokyo Station City veröffentlicht.

BeBot wurde als iOS-und Android-App veröffentlicht und weiß, wie Sie zu jedem Punkt rund um die labyrinthartige Station geleitet werden. helfen Ihnen, Ihr Gepäck aufzubewahren und abzuholen, schicken Sie zu einem Infoschalter oder finden Zugfahrzeiten, Bodentransportmittel oder Lebensmittel und Geschäfte im Bahnhof.

Es kann Ihnen sogar anhand der Fahrtdauer sagen, zu welchen Bahnsteigen Sie fahren müssen, um am schnellsten zu einem Ziel in der Stadt zu gelangen – und das alles in wenigen Sekunden.

Die MLC-Chat-App

Das Projekt Machine Learning Compilation (MLC) ist die Idee des Deep-Learning-Forschers der Apache Foundation Siyuan Feng und Hongyi Jin sowie andere mit Sitz in Seattle und Shanghai, China.

Die Idee hinter MLC besteht darin, vorkompilierte LLMs und Chatbots auf Verbrauchergeräten und Webbrowsern bereitzustellen. MLC nutzt die Leistung von Consumer-Grafikprozessoren (GPUs), um KI-Ergebnisse und-Suchen zu beschleunigen – und macht KI für die meisten modernen Consumer-Computergeräte erreichbar.

Ein weiteres MLC-Projekt – Web LLM – bringt die gleiche Funktionalität in Webbrowser und basiert wiederum darauf ein anderes Projekt-WebGPU. In Web LLM werden nur Maschinen mit bestimmten GPUs unterstützt, da es auf Code-Frameworks basiert, die diese GPUs unterstützen.

Die meisten KI-Assistenten basieren auf einem Client-Server-Modell, bei dem Server den Großteil der KI-Schwerarbeit übernehmen, aber MLC bindet LLMs in lokalen Code ein, der direkt auf dem Gerät des Benutzers ausgeführt wird, sodass keine LLM-Server erforderlich sind.

Einrichten von MLC

Um MLC auf Ihrem Gerät auszuführen, muss es die auf den Projekt-und GitHub-Seiten aufgeführten Mindestanforderungen erfüllen.

Um es auf einem iPhone auszuführen, benötigen Sie ein iPhone 14 Pro Max, iPhone 14 Pro oder iPhone 12 Pro mit mindestens 6 GB freiem RAM. Sie müssen außerdem die TestFlight-App von Apple installieren, um die App zu installieren. Die Installation ist jedoch auf die ersten 9.000 Benutzer beschränkt.

Wir haben versucht, MLC auf einem Basis-iPad 2021 mit 64 GB Speicher auszuführen, aber es ließ sich nicht initialisieren. Ihre Ergebnisse können auf dem iPad Pro variieren.

Sie können MLC auch aus Quellen erstellen und direkt auf Ihrem Telefon ausführen, indem Sie den Anweisungen auf der MLC-LLM-GitHub-Seite folgen. Um die Quellen abzurufen, muss auf Ihrem Mac das Git-Quellcodeverwaltungssystem installiert sein.

Erstellen Sie dazu einen neuen Ordner im Finder auf Ihrem Mac, navigieren Sie im Terminal mit dem UNIX-Befehl cd dorthin und starten Sie dann den Befehl „git clone“ im Terminal, wie auf dem MLC-LLM-GitHub aufgeführt Seite:

https://github.com/mlc-ai/mlc-llm.git und drücken Sie Return. git lädt alle MLC-Quellen in den von Ihnen erstellten Ordner herunter.

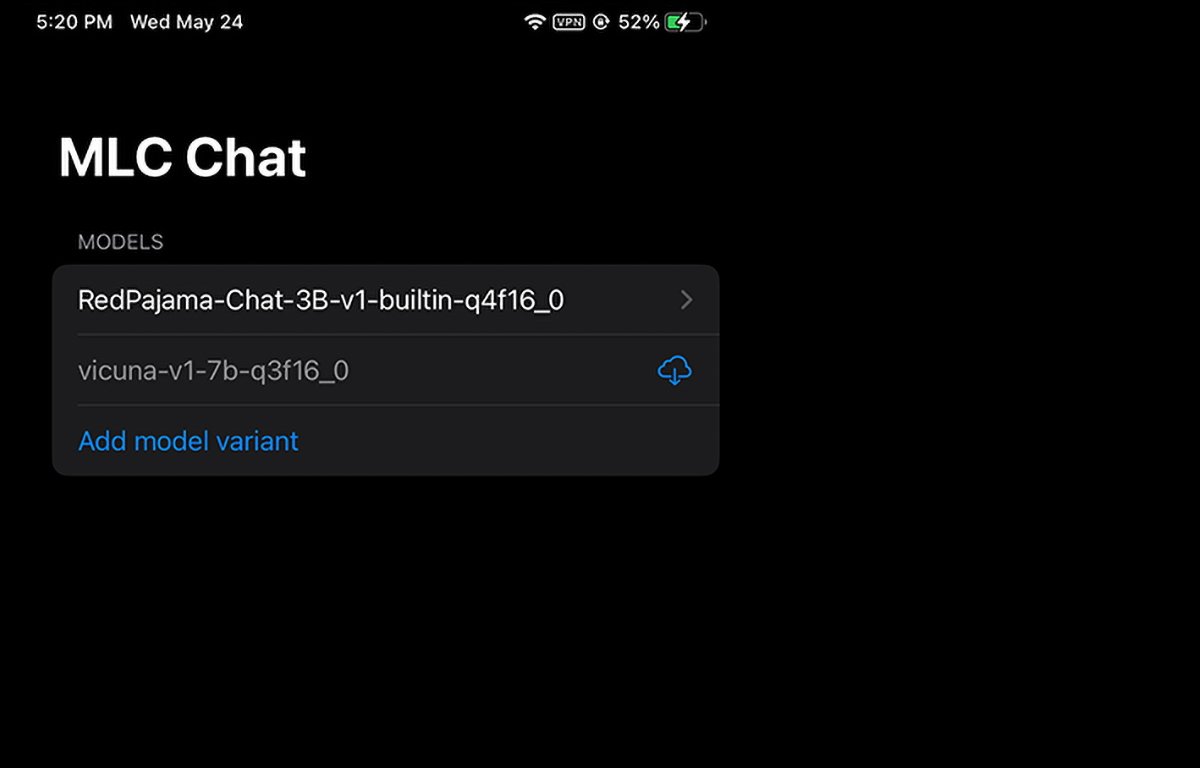

MLC läuft auf dem iPhone. Sie können auswählen oder herunterladen, welches Modellgewicht Sie verwenden möchten.

Mac-Voraussetzungen installieren

Für Mac-und Linux-Computer wird MLC über eine Befehlszeilenschnittstelle ausgeführt im Terminal. Sie müssen zunächst einige Voraussetzungen installieren, um es verwenden zu können:

Die Conda oder Miniconda Package Manager Homebrew Vulkan-Grafikbibliothek (nur Linux oder Windows) Git Large File Support (LFS)

Für NVIDIA-GPU-Benutzer heißt es in den MLC-Anweisungen ausdrücklich, dass Sie Vulkan-Treiber als Standardtreiber. Eine andere Grafikbibliothek für NVIDIA-GPUs – CUDA – funktioniert nicht.

Für Mac-Benutzer können Sie Miniconda mithilfe des von uns bereitgestellten Homebrew-Paketmanagers installieren Habe bereits darüber berichtet. Beachten Sie, dass Miniconda mit einer anderen Homebrew-Conda-Formel, Miniforge, in Konflikt steht.

Wenn Sie also Miniforge bereits über Homebrew installiert haben, müssen Sie es zuerst deinstallieren.

Befolgen Sie die Anweisungen auf der MLC/LLM-Seite. Die verbleibenden Installationsschritte lauten ungefähr:

Erstellen Sie eine neue Conda-Umgebung. Installieren Sie Git und Git LFS. Installieren Sie die Befehlszeilen-Chat-App von Conda. Erstellen Sie eine neue lokale Umgebung Ordner, laden Sie LLM-Modellgewichte herunter und legen Sie eine LOCAL_ID-Variable fest. Laden Sie die MLC-Bibliotheken von GitHub herunter

All dies wird auf der Anleitungsseite ausführlich erwähnt, daher werden wir hier nicht auf jeden Aspekt der Einrichtung eingehen. Es mag zunächst entmutigend erscheinen, aber wenn Sie über grundlegende Kenntnisse im macOS-Terminal verfügen, sind es eigentlich nur ein paar einfache Schritte.

Der Schritt LOCAL_ID legt diese Variable einfach so fest, dass sie auf eine der drei Modellgewichtungen verweist, die Sie heruntergeladen haben.

Die Modellgewichte werden von der HuggingFace-Community-Website heruntergeladen, die eine Art GitHub für KI ist.

Sobald alles im Terminal installiert ist, können Sie im Terminal auf MLC zugreifen, indem Sie mlc_chat_cli verwenden

MLC in Webbrowsern verwenden

MLC verfügt auch über eine Webversion, Web LLM.

Die Web-LLM-Variante läuft nur auf Apple Silicon Macs. Es läuft nicht auf Intel-Macs und erzeugt einen Fehler im Chatbot-Fenster, wenn Sie es versuchen.

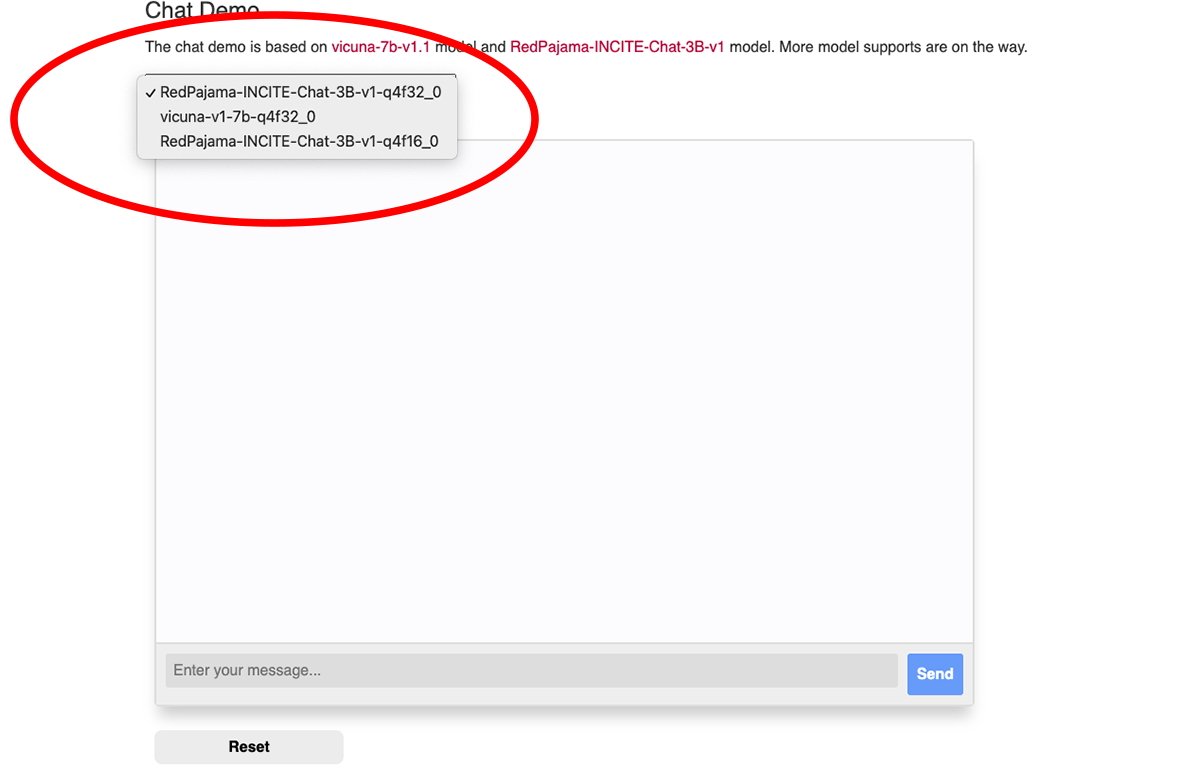

Oben im MLC-Webchat-Fenster gibt es ein Popup-Menü, aus dem Sie auswählen können, welches heruntergeladene Modellgewicht Sie verwenden möchten:

Wählen Sie eine der Modellgewichtungen aus.

Sie benötigen den Google Chrome-Browser, um Web LLM zu verwenden (Chrome-Version 113 oder höher). Frühere Versionen funktionieren nicht.

Sie können Ihre Chrome-Versionsnummer im Chrome-Menü in der Mac-Version überprüfen, indem Sie zu Chrome->Über Google Chrome gehen. Wenn ein Update verfügbar ist, klicken Sie auf die Schaltfläche Aktualisieren, um auf die neueste Version zu aktualisieren.

Möglicherweise müssen Sie Chrome nach dem Update neu starten.

Beachten Sie, dass auf der MLC Web LLM-Seite empfohlen wird, Chrome über das Mac-Terminal mit diesem Befehl zu starten:

/Applications/Google\ Chrome.app/Contents/MacOS/Google\ Chrome – „enable-dawn-features=allow_unsafe_apis,disable_robustness

allow_unsafe_apis“ und „disable_robustness“ sind zwei Chrome-Startflags, die die Verwendung experimenteller Funktionen ermöglichen, die möglicherweise instabil sind oder nicht.

Sobald alles eingerichtet ist, geben Sie einfach eine Frage in das Feld Geben Sie Ihre Nachricht ein unten im Chat-Bereich der Web LLM-Webseite ein und klicken Sie auf Senden-Taste.

Die Ära echter KI und intelligenter Assistenten beginnt gerade erst. Obwohl KI Risiken birgt, verspricht diese Technologie, unsere Zukunft zu verbessern, indem sie viel Zeit spart und viel Arbeit eliminiert.