El Centro Nacional de Seguridad Cibernética (NCSC) del Reino Unido está alertando al público sobre los peligros de ChatGPT. Este modelo de inteligencia artificial ganó popularidad tras su lanzamiento hace unos meses. Después de que estuvo disponible para el público, un montón de personas acudieron en tropel para probar sus habilidades de varias maneras.

Algunas personas pidieron recetas para platos específicos, respuestas a preguntas asignadas y otras preguntas aleatorias. La respuesta de este modelo de inteligencia artificial a varias preguntas que se le formularon asombró a mucha gente. Por esta razón, más personas querían probar ChatGPT, lo que aumentó su popularidad.

Ahora, el sistema en el que se ejecuta este modelo de inteligencia artificial ha recibido una actualización. El sistema GPT-4 trae mejoras a las habilidades de conversación de varios modelos de inteligencia artificial que se basan en él. Con la creciente adopción de este modelo de inteligencia artificial, ¿existe algún peligro que represente para la sociedad? Una actualización reciente destaca algunas, echemos un vistazo de cerca a estos peligros.

Según el Centro Nacional de Seguridad Cibernética (NCSC), estos son los peligros de ChatGPT

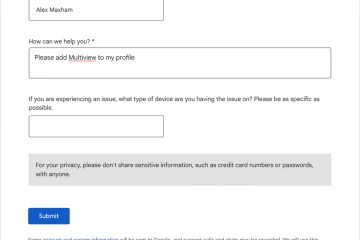

El Centro Nacional de Seguridad Cibernética (NCSC) del Reino Unido ha alertado al público sobre los peligros de ChatGPT. Lo hicieron con un blog reciente post en su sitio web oficial, donde profundizaron en ChatGPT y modelos de lenguaje extenso (LLM).

Con el aumento de la popularidad de estos modelos de inteligencia artificial, existe la necesidad de conocer el riesgo que podría posar. Bueno, el Centro Nacional de Seguridad Cibernética del Reino Unido (NCSC) ha realizado la investigación para ayudar a informar al público. A partir de sus hallazgos, los usuarios de ChatGPT y otros LLM sabrán qué especializaciones tomar con estos modelos de inteligencia artificial.

Una de las primeras observaciones a tener en cuenta con los modelos de inteligencia artificial es que podrían ser engañoso. Parte de la información que brindan a las solicitudes de los usuarios puede ser incorrecta, sesgada, violenta, etc. Por esta razón, los usuarios de ChatGPT y otros LLM deben tener en cuenta el contenido que consumen de estos modelos de inteligencia artificial.

Hay es también la necesidad de tener cuidado con el tipo de información que comparte con estas plataformas. El Centro Nacional de Seguridad Cibernética (NCSC) desaconseja compartir información confidencial con ChatGPT u otros LLM. Es posible que estas plataformas no revelen la información del usuario, pero tienen acceso a las consultas de los usuarios y pueden ser pirateadas, por lo tanto, revelan estas consultas al público.

Por esta razón, trate de no hacer preguntas a dichas plataformas que son bastante sensibles. a su vida personal o laboral. Los peligros de ChatGPT y otros LLM también abarcan cómo los ciberdelincuentes y los malos actores pueden usarlo. Por lo tanto, mientras prueba modelos de lenguaje grande nuevos o existentes, es importante comprender los riesgos que plantean.