La IA está arrasando en el mundo y, si bien puedes usar Google Bard o ChatGPT, también puedes usar uno alojado localmente en tu Mac. Aquí se explica cómo usar la nueva aplicación de chat MLC LLM.

La inteligencia artificial (IA) es la nueva frontera de vanguardia de la informática y está generando un gran revuelo en el mundo de la informática.

Los chatbots, aplicaciones basadas en inteligencia artificial con las que los usuarios pueden conversar como expertos en el dominio, están creciendo en popularidad, por decir lo menos.

Los chatbots tienen un conocimiento aparentemente experto en una amplia variedad de temas genéricos y especializados y se están desplegando por todas partes a un ritmo rápido. Un grupo, OpenAI, lanzó ChatGPT algunos hace meses a un mundo conmocionado.

ChatGPT tiene un conocimiento aparentemente ilimitado sobre prácticamente cualquier tema y puede responder preguntas en tiempo real que, de otro modo, requerirían horas o días de investigación. Tanto las empresas como los trabajadores se han dado cuenta de que la IA se puede utilizar para acelerar el trabajo al reducir el tiempo de investigación.

La desventaja

Sin embargo, teniendo en cuenta todo eso, algunas aplicaciones de IA tienen una desventaja. El principal inconveniente de la IA es que los resultados aún deben verificarse.

Aunque suele ser correcto en su mayor parte, la IA puede proporcionar datos erróneos o engañosos que pueden llevar a conclusiones o resultados falsos.

Los desarrolladores de software y las empresas de software recurrieron a los”copilots“, chatbots especializados que pueden ayudar a los desarrolladores a escribir código hacer que AI escriba el esquema de funciones o métodos automáticamente, que luego puede ser verificado por un desarrollador.

Si bien es un gran ahorro de tiempo, los copilotos también pueden escribir código incorrecto. Microsoft, Amazon, GitHub y NVIDIA han lanzado copilotos para desarrolladores.

Primeros pasos con los chatbots

Para comprender, al menos en un nivel alto, cómo funcionan los chatbots, primero debe comprender los conceptos básicos de IA y, en particular, el aprendizaje automático. (ML) y modelos de lenguaje grande (LLM).

Machine Learning es una rama de la informática dedicada a la investigación y desarrollo de intentar enseñar a las computadoras a aprender.

Un LLM es esencialmente un programa de procesamiento de lenguaje natural (NLP) que utiliza grandes conjuntos de datos y redes neuronales (NN) para generar texto. Los LLM funcionan entrenando código de IA en grandes modelos de datos, que luego”aprende”de ellos con el tiempo, esencialmente convirtiéndose en un experto en un campo en particular en función de la precisión de los datos de entrada.

Cuanto más (y más precisos) sean los datos de entrada, más preciso y correcto será un chatbot que utilice el modelo. Los LLM también se basan en Deep Learning mientras se capacitan en modelos de datos.

Cuando le haces una pregunta a un chatbot, consulta a su LLM para obtener la respuesta más adecuada, en función de su aprendizaje y conocimiento almacenado de todos los temas relacionados con tu pregunta.

Esencialmente, los chatbots tienen un conocimiento precomputado de un tema y, con un LLM lo suficientemente preciso y suficiente tiempo de aprendizaje, pueden proporcionar respuestas correctas mucho más rápido que la mayoría de las personas.

Usar un chatbot es como tener un equipo automatizado de doctores a tu disposición al instante.

En enero de 2023, Meta AI lanzó su propio LLM llamado LLaMA. Un mes después, Google presentó su propio chatbot de IA, Bard, que se basa en su propio LLM, LaMDA. Desde entonces, se han producido otros chatbots.

IA generativa

Más recientemente, algunos LLM han aprendido a generar datos no basados en texto, como gráficos, música e incluso libros completos. Las empresas están interesadas en la IA generativa para crear cosas como gráficos corporativos, logotipos, títulos e incluso escenas de películas digitales que reemplazan a los actores.

Por ejemplo, la imagen en miniatura de este artículo fue generada por IA.

Como efecto secundario de la IA generativa, a los trabajadores les preocupa perder sus trabajos debido a la automatización impulsada por el software de IA.

Asistentes de chatbot

El primer chatbot comercial disponible para usuarios del mundo (BeBot) fue lanzado por Bespoke Japan para Tokyo Station City en 2019.

Lanzado como una aplicación para iOS y Android, BeBot sabe cómo dirigirte a cualquier punto alrededor de la estación laberíntica. ayudarlo a almacenar y recuperar su equipaje, enviarlo a un mostrador de información o encontrar horarios de trenes, transporte terrestre o alimentos y tiendas dentro de la estación.

Incluso puede decirle a qué plataformas de tren debe dirigirse para el viaje en tren más rápido a cualquier destino de la ciudad por duración del viaje, todo en unos pocos segundos.

La aplicación de chat MLC

El proyecto Compilación de aprendizaje automático (MLC) es una creación del investigador de aprendizaje profundo de la Fundación Apache Siyuan Feng y Hongyi Jin, así como otros con sede en Seattle y Shanghái, China.

La idea detrás de MLC es implementar LLM y chatbots precompilados en dispositivos de consumo y navegadores web. MLC aprovecha el poder de las unidades de procesamiento de gráficos (GPU) de consumo para acelerar los resultados y las búsquedas de IA, lo que hace que la IA esté al alcance de la mayoría de los dispositivos informáticos de consumo modernos.

Otro proyecto de MLC, Web LLM, brinda la misma funcionalidad a los navegadores web y se basa a su vez en otro proyecto-WebGPU. Solo las máquinas con GPU específicas son compatibles con Web LLM, ya que se basa en marcos de código que admiten esas GPU.

La mayoría de los asistentes de IA se basan en un modelo cliente-servidor en el que los servidores realizan la mayor parte del trabajo pesado de la IA, pero MLC integra los LLM en un código local que se ejecuta directamente en el dispositivo del usuario, lo que elimina la necesidad de servidores LLM.

Configuración de MLC

Para ejecutar MLC en su dispositivo, debe cumplir con los requisitos mínimos enumerados en las páginas del proyecto y de GitHub.

Para ejecutarlo en un iPhone, necesitará un iPhone 14 Pro Max, iPhone 14 Pro o iPhone 12 Pro con al menos 6 GB de RAM libre. También deberá instalar la aplicación TestFlight de Apple para instalar la aplicación, pero la instalación está limitada a los primeros 9,000 usuarios.

Intentamos ejecutar MLC en un iPad base 2021 con 64 GB de almacenamiento, pero no se inicializó. Sus resultados pueden variar en iPad Pro.

También puede compilar MLC a partir de fuentes y ejecutarlo en su teléfono directamente siguiendo las instrucciones en la página MLC-LLM GitHub. Necesitará el sistema de control de código fuente git instalado en su Mac para recuperar las fuentes.

Para hacerlo, cree una nueva carpeta en Finder en su Mac, use el comando UNIX cd para navegar hasta ella en Terminal, luego ejecute el comando git clone en Terminal como se indica en MLC-LLM GitHub página:

https://github.com/mlc-ai/mlc-llm.git y presione Volver. git descargará todas las fuentes de MLC en la carpeta que creó.

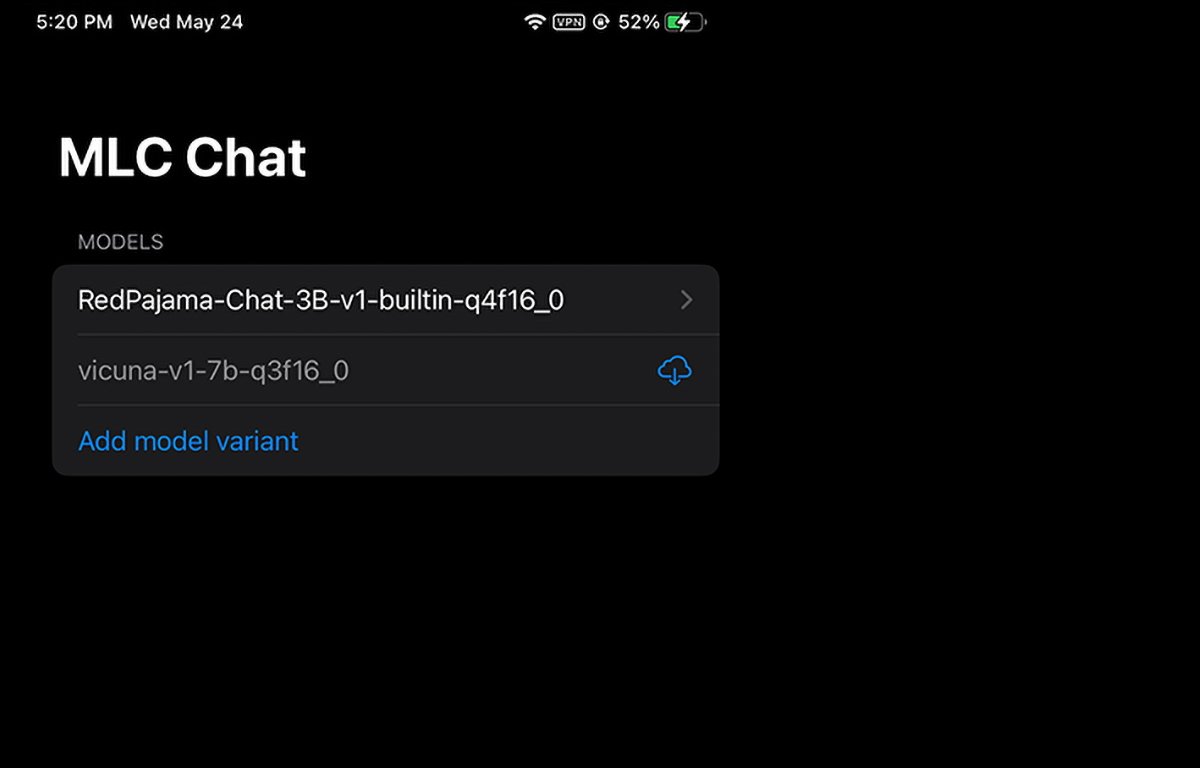

MLC ejecutándose en iPhone. Puede seleccionar o descargar qué peso de modelo usar.

Instalación de requisitos previos de Mac

Para computadoras Mac y Linux, MLC se ejecuta desde una interfaz de línea de comandos en Terminal. Primero deberá instalar algunos requisitos previos para usarlo:

El Conda o Miniconda Package Manager Biblioteca de gráficos Homebrew Vulkan (Linux o Windows solamente) git soporte de archivos grandes (LFS).com/vulkan-driver”>Vulkan como controlador predeterminado. Otra biblioteca de gráficos para GPU NVIDIA, CUDA, no funcionará.

Para usuarios de Mac, puede instalar Miniconda mediante el administrador de paquetes Homebrew, que he cubierto anteriormente. Tenga en cuenta que Miniconda entra en conflicto con otra fórmula de Homebrew Conda, miniforge.

Entonces, si ya tiene miniforge instalado a través de Homebrew, primero deberá desinstalarlo.

Siguiendo las instrucciones en la página de MLC/LLM, los pasos de instalación restantes son aproximadamente:

Cree un nuevo entorno de Conda Instale git y git LFS Instale la aplicación de chat de línea de comandos de Conda Cree un nuevo entorno local descargar las ponderaciones del modelo LLM y establecer una variable LOCAL_ID Descargar las bibliotecas MLC de GitHub

Todo esto se menciona en detalle en la página de instrucciones, por lo que no entraremos en todos los aspectos de la configuración aquí. Puede parecer abrumador al principio, pero si tiene conocimientos básicos de macOS Terminal, en realidad son solo unos pocos pasos sencillos.

El paso LOCAL_ID simplemente establece esa variable para que apunte a uno de los tres pesos del modelo que descargó.

Los pesos de los modelos se descargan del sitio web de la comunidad HuggingFace, que es una especie de GitHub para IA.

Una vez que todo esté instalado en la Terminal, puede acceder a MLC en la Terminal usando mlc_chat_cli

Usando MLC en navegadores web

MLC también tiene una versión web, Web LLM.

La variante Web LLM solo se ejecuta en Apple Silicon Mac. No se ejecutará en Intel Mac y producirá un error en la ventana del chatbot si lo intenta.

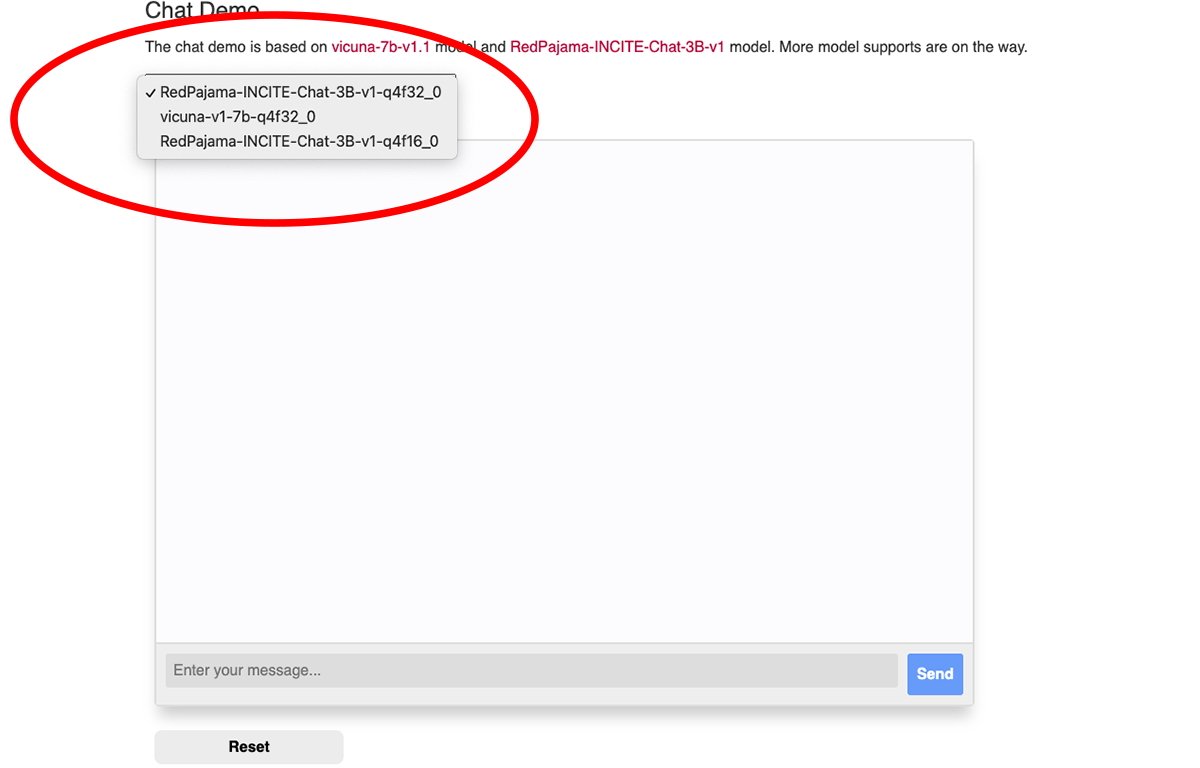

Hay un menú emergente en la parte superior de la ventana de chat web de MLC desde el que puede seleccionar el peso del modelo descargado que desea usar:

Seleccione uno de los pesos del modelo.

Necesitará el navegador Google Chrome para usar Web LLM (Chrome versión 113 o posterior). Las versiones anteriores no funcionarán.

Puede comprobar su número de versión de Chrome desde el menú de Chrome en la versión para Mac yendo a Chrome->Acerca de Google Chrome. Si hay una actualización disponible, haga clic en el botón Actualizar para actualizar a la última versión.

Puede que tengas que reiniciar Chrome después de actualizar.

Tenga en cuenta que la página Web LLM de MLC recomienda que inicie Chrome desde la terminal Mac usando este comando:

/Applications/Google\ Chrome.app/Contents/MacOS/Google\ Chrome — enable-dawn-features=allow_unsafe_apis,disable_robustness

allow_unsafe_apis’y disabled_robustness’son dos banderas de lanzamiento de Chrome que le permiten usar funciones experimentales, que pueden o no ser inestables.

Una vez que todo esté configurado, simplemente escriba una pregunta en el campo Ingrese su mensaje en la parte inferior del panel de chat de la página web de Web LLM y haga clic en Enviar. botón fuerte>.

La era de la verdadera IA y los asistentes inteligentes apenas comienza. Si bien existen riesgos con la IA, esta tecnología promete mejorar nuestro futuro al ahorrar una gran cantidad de tiempo y eliminar una gran cantidad de trabajo.