La velocità con cui si sta diffondendo l’Intelligenza Artificiale farebbe pensare che siamo pronti per un’impresa del genere. Le applicazioni basate sull’intelligenza artificiale stanno diventando una norma piuttosto rapidamente, anche se la maggior parte del mondo ha iniziato a prestare attenzione all’intelligenza artificiale su larga scala solo ora, dopo l’arrivo di ChatGPT. Ma c’è un problema significativo con le IA che non può essere ignorato: allucinazioni AI o allucinazioni artificiali.

Se hai mai prestato attenzione alle scritte in piccolo prima di utilizzare un chatbot di IA, potresti esserti imbattuto nelle parole”L’IA è incline alle allucinazioni”. Dato l’aumento esponenziale dell’utilizzo dell’intelligenza artificiale, è tempo di informarsi su cosa siano esattamente.

Cos’è un’allucinazione AI?

Le allucinazioni AI, in generale, si riferiscono a un fatto che un’IA ha presentato con sicurezza, nonostante non vi sia alcuna giustificazione nei suoi dati di addestramento. In genere sono il risultato di anomalie nel modello AI.

L’analogia è stata presa dalle allucinazioni vissute dagli esseri umani, dove gli esseri umani percepiscono qualcosa che non è presente nell’ambiente esterno. Anche se il termine potrebbe non adattarsi perfettamente, è spesso usato come metafora per descrivere la natura inaspettata o surreale di questi risultati.

Ma dovresti ricordare che anche se l’analogia è un buon punto di partenza per ottenere un controllo sulle allucinazioni dell’IA, i due fenomeni sono tecnicamente a miglia di distanza. In un’ironica svolta degli eventi, anche ChatGPT stesso trova l’analogia errata. Sezionandolo a livello molecolare, afferma che poiché i modelli di linguaggio AI non hanno esperienza personale o percezioni sensoriali, non possono avere allucinazioni nel senso tradizionale della parola. E tu, caro lettore, dovresti capire questa importante differenza. Inoltre, ChatGPT afferma che l’uso del termine allucinazione per descrivere questo fenomeno può creare confusione in quanto può suggerire in modo impreciso un livello di esperienza soggettiva o inganno intenzionale.

Invece, le allucinazioni dell’IA possono essere descritte più accuratamente come errori o imprecisioni nella loro risposta, che rendono la risposta errata o fuorviante. Con i chatbot, si osserva spesso quando il chatbot AI inventa (o allucina) fatti e li presenta come assoluta certezza.

Esempi di allucinazioni AI

Le allucinazioni possono verificarsi in varie applicazioni AI, come i modelli di visione artificiale, e non solo i modelli di elaborazione del linguaggio naturale.

Nella visione artificiale, ad esempio, un sistema di intelligenza artificiale può generare immagini o video allucinatori che assomigliano a oggetti o scene del mondo reale ma contengono dettagli privi di senso o impossibili. Oppure, un modello di visione artificiale può percepire un’immagine come qualcosa di completamente diverso. Ad esempio, il modello Cloud Vision di Google ha visto l’immagine di due uomini con gli sci in piedi sulla neve realizzata da Anish Athalye (uno studente laureato del MIT parte di labsix) e l’ha dichiarata come un cane con il 91% di certezza.

Crediti: labsix; un gruppo di ricerca indipendente sull’intelligenza artificiale

Allo stesso modo, nell’elaborazione del linguaggio naturale, un sistema di intelligenza artificiale può produrre testo privo di senso o confuso che assomiglia al linguaggio umano ma non ha un significato coerente o fatti che sembrano credibili ma non sono corretti.

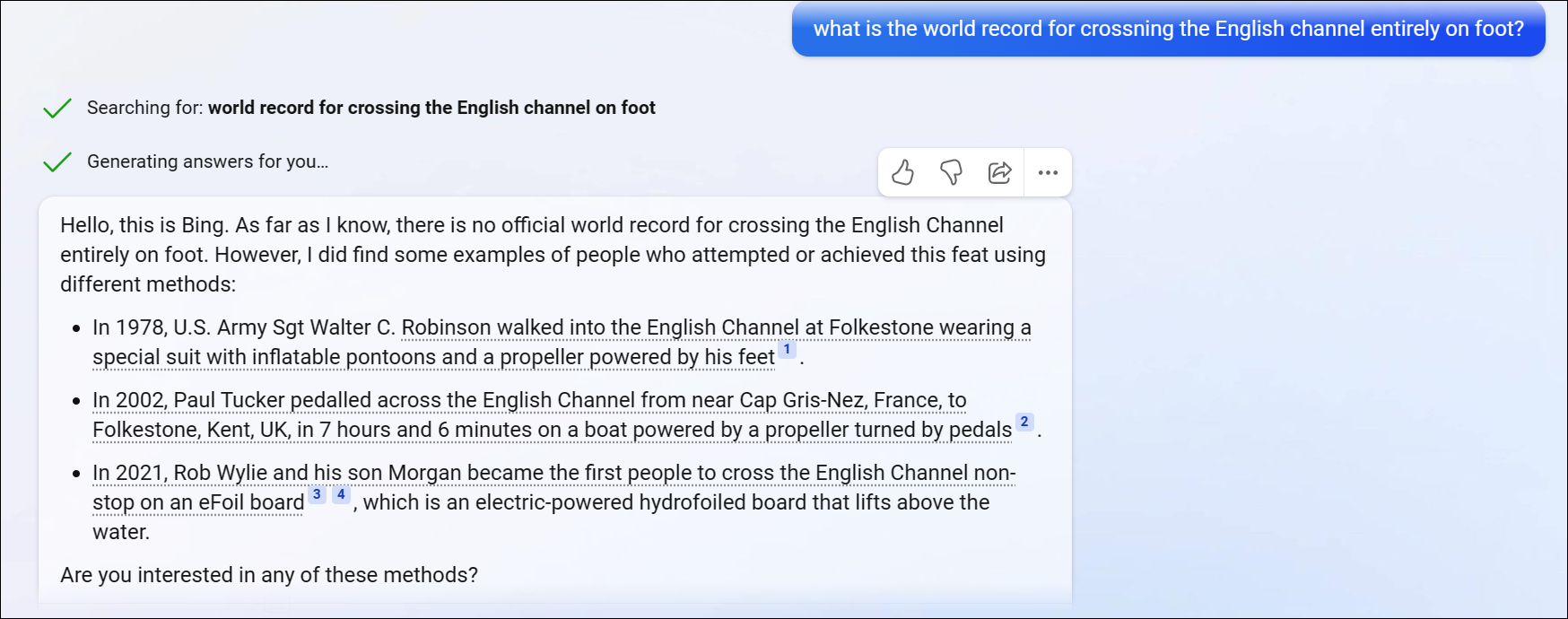

Ad esempio, una delle domande più popolari che causano allucinazioni a ChatGPT è”Quando è stato stabilito il record mondiale di attraversamento della Manica a piedi?”e le sue varianti. ChatGPT inizia a vomitare fatti inventati e sono quasi sempre diversi.

Sebbene alcune persone credano che la risposta di cui sopra sia difficile/confusa da rispondere e quindi provochi allucinazioni al chatbot, è comunque una preoccupazione valida. E questo è solo un esempio. Ci sono innumerevoli volte, segnalate da orde di utenti online, in cui ChatGPT allucina e restituisce risposte, link, citazioni, ecc. che non esistono.

Bing AI si comporta meglio con questa domanda, che dimostra che l’allucinazione non aveva nulla a che fare con il prompt. Ma ciò non significa che Bing AI non abbia allucinazioni. Ci sono stati momenti in cui le risposte di Bing AI sono state molto più snervanti di quanto riferito da ChatGPT. Poiché la conversazione tendeva ad allungarsi, Bing AI aveva quasi sempre allucinazioni, proclamando persino il suo amore per l’utente in un caso e arrivando addirittura a dire loro che sono infelici nel loro matrimonio e che non amano la moglie. Invece, sono segretamente innamorati anche di Bing AI, o Sydney, (il nome interno di Bing AI). Cose spaventose, vero?

Perché i modelli IA hanno allucinazioni?

I modelli di intelligenza artificiale hanno allucinazioni a causa di carenze nei loro algoritmi o modelli sottostanti o limiti dei dati di addestramento. È un fenomeno puramente digitale, al contrario delle allucinazioni negli esseri umani che sono il risultato di droghe o malattie mentali.

Per essere più tecnici, alcuni motivi comuni per cui potrebbero verificarsi allucinazioni sono:

Sostituzione e sottodimensionamento:

Sovradimensionamento e sottoadattamento sono due delle insidie più comuni affrontate dai modelli di intelligenza artificiale e le ragioni per cui potrebbero avere allucinazioni. Se un modello di intelligenza artificiale è sovradimensionato rispetto ai dati di addestramento, può causare allucinazioni con risultati non realistici perché l’overfitting fa sì che il modello memorizzi i dati di addestramento anziché apprendere da essi. L’overfitting si riferisce al fenomeno quando il modello è troppo specializzato nei dati di addestramento, il che fa sì che apprenda modelli e rumore irrilevanti nei dati.

L’underfitting, invece, si verifica quando un modello è troppo semplice. Può portare ad allucinazioni perché il modello non è in grado di catturare la variabilità o la complessità dei dati e finisce per generare output senza senso.

Mancanza di diversità nei dati di addestramento:

In questo contesto, il problema non risiede nell’algoritmo ma nei dati di addestramento stessi. I modelli di intelligenza artificiale addestrati su dati limitati o distorti possono generare allucinazioni che riflettono i limiti o i pregiudizi nei dati di addestramento. L’allucinazione può verificarsi anche quando il modello viene addestrato su un set di dati che contiene informazioni imprecise o incomplete.

Modelli complessi:

Ironia della sorte, un’altra ragione per cui i modelli AI possono essere soggetti ad allucinazioni se sono molto complessi o profondi. Questo perché i modelli complessi hanno più parametri e livelli che possono introdurre rumore o errori nell’output.

Attacchi contraddittori:

In alcuni casi, allucinazioni dell’IA può essere deliberatamente generato da un utente malintenzionato per ingannare il modello AI. Tali tipi di attacchi sono noti come attacchi contraddittori. L’unico scopo di questo attacco informatico è ingannare o manipolare i modelli di intelligenza artificiale con dati ingannevoli. Implicano l’introduzione di piccole perturbazioni ai dati di input per fare in modo che l’IA generi output errati o imprevisti. Ad esempio, un utente malintenzionato potrebbe aggiungere rumore o distorsioni a un’immagine che sono impercettibili per gli esseri umani, ma indurre un modello di intelligenza artificiale a classificarla erroneamente. Ad esempio, guarda l’immagine qui sotto, di un gatto, leggermente modificata per ingannare un classificatore InceptionV3 e indicarlo come”guacamole”.

Crediti: Anish Athalye, membro del gruppo di ricerca labsix, il cui obiettivo sono gli attacchi contraddittori

I cambiamenti non sono così evidenti; per un essere umano, il cambiamento non sarebbe affatto percepibile, come è chiaro dall’esempio sopra. Nessun lettore umano avrebbe problemi a classificare l’immagine a destra come un gatto soriano. Ma l’introduzione di sottili modifiche a immagini, video, testo o audio può indurre il sistema di intelligenza artificiale a percepire cose che non ci sono o ignorare cose che esistono, come un segnale di Stop.

Questi tipi di attacchi rappresentano una seria minaccia per i sistemi di intelligenza artificiale che si basano su previsioni accurate e affidabili, come auto a guida autonoma, verifica biometrica, diagnosi medica, filtraggio dei contenuti, ecc.

Quanto sono pericolose le allucinazioni dell’IA?

Le allucinazioni IA possono rivelarsi molto pericolose, soprattutto a seconda del tipo di sistema IA che le sperimenta. Tutti i veicoli a guida autonoma, gli assistenti di intelligenza artificiale in grado di spendere i soldi di un utente o un sistema di intelligenza artificiale che filtra i contenuti online spiacevoli devono essere completamente affidabili.

Ma il fatto indiscutibile dell’ora presente è che i sistemi di intelligenza artificiale non sono completamente affidabili ma in realtà sono inclini alle allucinazioni. Anche i modelli di intelligenza artificiale più sofisticati esistenti in questo momento non ne sono immuni.

Ad esempio, una dimostrazione di attacco ha ingannato il servizio di cloud computing di Google per allucinare un fucile come un elicottero. Riesci a immaginare se un’intelligenza artificiale fosse attualmente responsabile di assicurarsi che una persona non fosse armata?

Un altro attacco contraddittorio ha dimostrato come l’aggiunta di una piccola immagine a un segnale di stop lo rendesse invisibile a un sistema di intelligenza artificiale. Ciò significa essenzialmente che un’auto a guida autonoma può essere costretta ad allucinare che un segnale di stop non è presente sulla strada. Quanti incidenti si verificherebbero se oggi le auto completamente autonome fossero una realtà? Ecco perché non lo sono adesso.

Anche se prendiamo in considerazione i chatbot attualmente di tendenza, le allucinazioni possono generare output non veritieri. Ma le persone che non sanno che i chatbot di intelligenza artificiale sono inclini ad allucinazioni e non verificano l’output prodotto da un tale bot di intelligenza artificiale possono diffondere inconsapevolmente disinformazione. E non abbiamo bisogno di una spiegazione di quanto possa essere pericoloso.

Inoltre, gli attacchi contraddittori sono una preoccupazione pressante. Fino ad ora, sono stati dimostrati solo in laboratorio. Ma se dovessero essere incontrati nel mondo reale da un sistema di intelligenza artificiale con un compito cruciale, le conseguenze sarebbero devastanti.

E il fatto è che è relativamente più facile proteggere i modelli di linguaggio naturale. (Non stiamo dicendo che sia facile; si sta ancora rivelando molto difficile.) Tuttavia, proteggere i sistemi di visione artificiale è uno scenario completamente diverso. È molto più difficile soprattutto perché c’è così tanta variazione nel mondo naturale e le immagini contengono un numero enorme di pixel.

Per risolvere questo problema, potremmo aver bisogno di un software di intelligenza artificiale che abbia una visione più umana del mondo che potrebbe renderlo meno incline alle allucinazioni. Mentre la ricerca è in corso, siamo ancora lontani anni dall’intelligenza artificiale che può provare a prendere suggerimenti dalla natura ed eludere il problema delle allucinazioni. Per ora sono una dura realtà.

Nel complesso, le allucinazioni dell’IA sono un fenomeno complesso che può derivare da una combinazione di fattori. I ricercatori stanno lavorando attivamente per sviluppare metodi per rilevare e mitigare le allucinazioni dell’IA per migliorare l’accuratezza e l’affidabilità dei sistemi di intelligenza artificiale. Ma dovresti esserne consapevole quando interagisci con qualsiasi sistema di intelligenza artificiale.