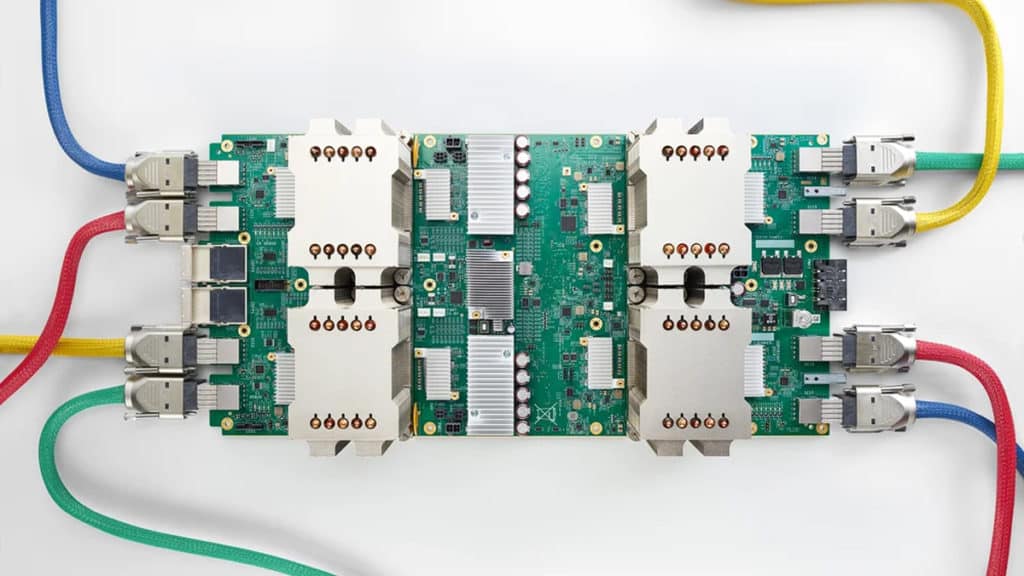

Immagine: Google

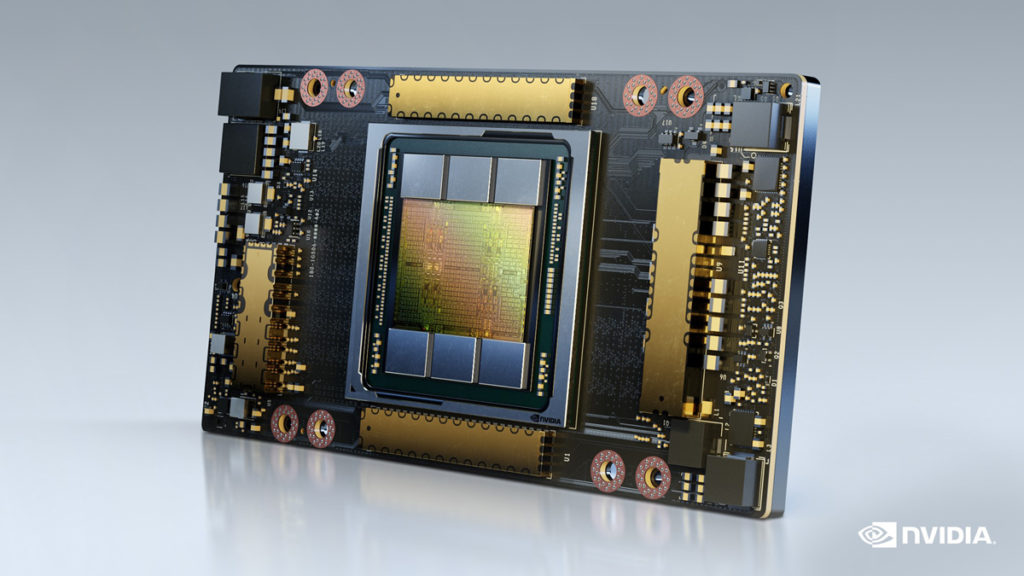

Qualcuno faccia alzare Jensen dal letto. Google ha pubblicato un documento scientifico che descrive in dettaglio l’ultima versione del suo chip personalizzato che viene messo insieme per creare supercomputer AI, la Tensor Processing Unit (TPU) e, a quanto pare, è migliore del A100, uno dei chip leader di NVIDIA per IA, analisi dei dati e HPC. Secondo un estratto del documento, gli utenti troveranno non solo prestazioni da 1,2 a 1,7 volte più veloci rispetto all’A100, ma anche un’efficienza superiore, con affermazioni da 1,3 a 1,9 volte in meno di consumo energetico. TPU v4 è una piattaforma scelta dai principali ricercatori mondiali di intelligenza artificiale e presenta efficienza leader del settore, ha affermato Google in un articolo separato che discute di ciò che i suoi ingegneri hanno raggiunto.

Dal arXiv.org:

In risposta alle innovazioni nei modelli di machine learning (ML), i carichi di lavoro di produzione sono cambiati radicalmente e rapidamente. TPU v4 è la quinta architettura specifica del dominio (DSA) di Google e il suo terzo supercomputer per tali modelli ML. Gli switch di circuiti ottici (OCS) riconfigurano dinamicamente la topologia di interconnessione per migliorare la scalabilità, la disponibilità, l’utilizzo, la modularità, l’implementazione, la sicurezza, l’alimentazione e le prestazioni; gli utenti possono scegliere una topologia toroidale 3D se lo desiderano. Molto più economici, a basso consumo e più veloci di Infiniband, gli OCS e i componenti ottici sottostanti sono <5% del costo del sistema e <3% della potenza del sistema. Ogni TPU v4 include SparseCores, processori di flusso di dati che accelerano i modelli che si basano su incorporamenti di 5x-7x ma utilizzano solo il 5% dell'area del die e della potenza. Implementato dal 2020, TPU v4 supera TPU v3 di 2,1 volte e migliora le prestazioni/Watt di 2,7 volte. Il supercomputer TPU v4 è 4 volte più grande con 4096 chip e quindi circa 10 volte più veloce in generale, che insieme alla flessibilità OCS aiuta i modelli di linguaggio di grandi dimensioni. Per sistemi di dimensioni simili, è ~4,3x-4,5x più veloce rispetto a Graphcore IPU Bow ed è 1,2x-1,7x più veloce e utilizza 1,3x-1,9x meno energia rispetto a Nvidia A100. Le TPU v4 all'interno dei computer su scala di magazzino ottimizzati dal punto di vista energetico di Google Cloud utilizzano ~3 volte meno energia e producono ~20 volte meno CO2e rispetto ai DSA contemporanei in un tipico data center on-premise.

Immagine: NVIDIA

Immagine: NVIDIA

Partecipa alla discussione per questo post sui nostri forum…