Con la Worldwide Developers Conference (WWDC) di Apple che inizierà tra meno di tre settimane, non dovremo aspettare molto per scoprire cosa accadrà in iOS 17, la prossima importante versione del software per iPhone di Apple. Tuttavia, Apple ci sta dando una sorpresa anticipata sotto forma di un’anteprima di alcune delle nuove fantastiche funzionalità di accessibilità che iOS 17 porterà sul tavolo.

C’è uno scopo in Apple che offre questa sbirciatina in anticipo in alcune delle funzionalità di iOS 17. Questo giovedì, 18 maggio, ricorrerà la Global Accessibility Awareness Day (GAAD), un’occasione intesa a”far parlare, pensare e imparare tutti sull’accesso digitale e inclusione e più di un miliardo di persone con disabilità/menomazioni”.

Quindi, Apple aggiunge la sua voce al coro, condividendo gli sforzi che sta compiendo per facilitare l’accesso inclusivo ai suoi dispositivi. Non è nemmeno la prima volta; Apple ha preannunciato un enorme elenco di nuove impressionanti funzionalità di accessibilità per iOS 15 nella stessa occasione due anni fa e poi ha fatto lo stesso per iOS 16 l’anno scorso.

Questa volta, Apple afferma che possiamo aspettarci un altro elenco di potenti miglioramenti dell’accessibilità in iOS 17, più alcuni altre iniziative per promuovere l’accessibilità all’interno dei servizi Apple.

‘Making Products for Everyone’

Secondo annuncio della redazione, le nuove funzioni di accessibilità coprono un’ampia gamma di esigenze, tra cui quelle cognitive, visive, udito e accessibilità alla mobilità, nonché persone non parlanti.

Ciò include Assistive Access per fornire interfacce utente più chiare per le persone con disabilità cognitive, Live Speech per consentire alle persone non parlanti di digitare per parlare durante le conversazioni, Voce personale per coloro che rischiano di perdere la capacità di parlare e Indica e parla con la lente d’ingrandimento per aiutare le persone con disabilità visive interagire con oggetti fisici che hanno più etichette di testo.

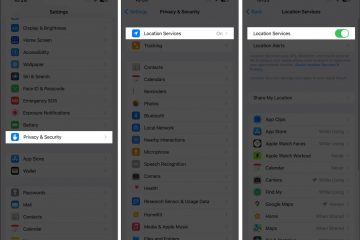

Apple osserva che la nuova raccolta di funzionalità di accessibilità si basa su”progressi nell’hardware e nel software, incluso l’apprendimento automatico sul dispositivo per garantire la privacy degli utenti”, utilizzando più funzionalità dell’iPhone in tandem.

Ad esempio, la funzione Indica e parla utilizza l’app Fotocamera, lo scanner LiDAR e la potenza del Neural Engine della serie A di Apple per aiutare gli utenti a interagire con dispositivi come un forno a microonde che potrebbe avere più pulsanti ed etichette. Mentre la persona muove il dito sulla tastiera, il suo iPhone può identificare su quale pulsante sta puntando il dito e annunciare il testo su quel pulsante. Questo sarà integrato nell’app Magnifier esistente e potrà essere utilizzato insieme alle funzionalità di accessibilità Rilevamento persone, Rilevamento porte e Descrizioni immagini che Apple ha aggiunto negli ultimi anni.

Progettato per le persone con difficoltà cognitive, Assistive Access“distillerà app ed esperienze nelle loro caratteristiche essenziali per alleggerire il carico cognitivo”. Questa modalità presenta un’interfaccia utente semplificata progettata sulla base del feedback degli utenti di iPhone con disabilità cognitive e dei loro fidati sostenitori per concentrarsi sulle funzionalità principali di iPhone come”connettersi con i propri cari, scattare e godersi foto e ascoltare musica”.

In una delle applicazioni più potenti dell’apprendimento automatico, Apple aggiunge anche la possibilità per gli utenti di creare un modello AI della propria voce. Progettato per coloro che rischiano di perdere la capacità di parlare, Voce personale registra circa 15 minuti di audio guidato da una persona e lo utilizza per costruire una voce che suoni come loro. Questo può quindi essere utilizzato per portare avanti conversazioni di sintesi vocale con quella che è effettivamente la propria voce piuttosto che sintetizzata.

Poiché questa è fondamentalmente una funzione di accessibilità per aiutare coloro che potrebbero eventualmente perdere la capacità di parlare, è improbabile che la vedremo applicata in altri modi: non aspettarti che Siri inizi a parlare con te in la tua stessa voce. Invece, la voce personale dell’utente farà parte della funzione di accessibilità Live Speech, che consente a una persona di digitare durante una telefonata, una chat video o una conversazione di persona e di far pronunciare il proprio testo ad alta voce al altra persona. Non è difficile immaginare come la possibilità di far pronunciare quei messaggi con la propria voce sarebbe una caratteristica straordinaria per coloro che un giorno potrebbero non essere in grado di parlare da soli.

“Alla fine della giornata, la cosa più importante è essere in grado di comunicare con amici e familiari”, ha affermato Philip Green, membro del consiglio e sostenitore della SLA presso l’organizzazione no profit Team Gleason, che ha subito cambiamenti significativi nella sua voce da quando ha ricevuto la diagnosi di SLA nel 2018.”Se puoi digli che li ami, con una voce che suona come te, fa tutta la differenza del mondo — ed essere in grado di creare la tua voce sintetica sul tuo iPhone in soli 15 minuti è straordinario.”

Inoltre , Apple fa notare che presto sarà possibile associare gli apparecchi acustici Made for iPhone direttamente a un Mac e personalizzarli nello stesso modo in cui possono essere quando si utilizza un iPhone o un iPad. Presumibilmente questo arriverà in macOS 14. Sono in arrivo anche molti altri piccoli miglioramenti dell’accessibilità, inclusi suggerimenti fonetici per la modifica del testo in Controllo vocale, utilizzo di Controllo interruttori per creare controller di gioco virtuali per persone con disabilità fisiche e motorie, regolazione della dimensione del testo nelle app Mac per utenti ipovedenti e immagini in pausa con elementi in movimento per coloro che sono sensibili alle animazioni rapide.

Celebrazione della Giornata mondiale della consapevolezza dell’accessibilità

Oltre a ciò che è in arrivo in iOS 17 e altri, Apple sta anche introducendo diverse nuove iniziative in tutti i suoi servizi per commemorare la Giornata mondiale della consapevolezza dell’accessibilità.

La funzione di assistenza clienti SignTime di Apple si estenderà a Germania, Italia, Spagna e Corea del Sud il 18 maggio per mettere in contatto i clienti Apple con interpreti di lingua dei segni su richiesta. La funzione è già disponibile negli Stati Uniti, Canada, Regno Unito, Francia, Australia e Giappone.

Apple offrirà anche sessioni in diversi Apple Store in tutto il mondo per aiutare a informare ed educare i clienti sulle funzionalità di accessibilità. Anche la Apple Carnegie Library di Washington, DC, terrà una sessione Today at Apple con Justina Miles, interprete e interprete del linguaggio dei segni.

Questa settimana arriveranno anche sui servizi Apple nuovi podcast, spettacoli, libri e persino allenamenti sul tema dell’accessibilità, tra cui Being Heumann: An Unrepentant Memoir of a Disability Rights Activist in Apple Books,”film e serie curate da noti narratori della comunità dei disabili”nell’app Apple TV e”video musicali in lingua dei segni americana (ASL) di genere diverso”in Apple Music. L’allenatore Jamie-Ray Hartshorne incorporerà anche ASL e metterà in evidenza utili funzioni di accessibilità durante gli allenamenti di Apple Fitness+ questa settimana, e l’App Store metterà in luce tre leader della comunità di disabili che condivideranno le loro esperienze come individui non parlanti e gli effetti trasformativi che la comunicazione aumentativa e alternativa ( AAC) hanno avuto nella loro vita.