AI sedang melanda dunia dan semasa anda boleh menggunakan Bard Google atau ChatGPT, anda juga boleh menggunakan yang dihoskan secara tempatan pada Mac anda. Berikut ialah cara menggunakan apl sembang MLC LLM baharu.

Kecerdasan Buatan (AI) ialah sempadan termaju sains komputer baharu dan menjana sedikit gembar-gembur dalam dunia pengkomputeran.

Chatbots-apl berasaskan AI yang boleh digunakan oleh pengguna sebagai pakar domain-semakin popular untuk dikatakan.

Chatbots mempunyai pengetahuan yang nampaknya pakar tentang pelbagai jenis subjek generik dan khusus serta sedang digunakan di mana-mana dengan pantas. Satu kumpulan-OpenAI-mengeluarkan ChatGPT beberapa bulan lalu ke dunia yang terkejut.

ChatGPT mempunyai pengetahuan yang nampaknya tidak terhad pada hampir mana-mana subjek dan boleh menjawab soalan dalam masa nyata yang mungkin mengambil masa berjam-jam atau berhari-hari penyelidikan. Kedua-dua syarikat dan pekerja telah menyedari AI boleh digunakan untuk mempercepatkan kerja dengan mengurangkan masa penyelidikan.

Keburukan

Memandangkan semua itu, bagaimanapun, terdapat kelemahan pada sesetengah apl AI. Kelemahan utama AI ialah keputusan masih mesti disahkan.

Walaupun biasanya kebanyakannya betul, AI boleh memberikan data yang salah atau mengelirukan yang boleh membawa kepada kesimpulan atau keputusan yang salah.

Pembangun perisian dan syarikat perisian telah mengambil”copilot“-chatbot khusus yang boleh membantu pembangun menulis kod dengan mempunyai AI menulis garis besar fungsi atau kaedah secara automatik-yang kemudiannya boleh disahkan oleh pembangun.

Sementara penjimat masa yang hebat, copilot juga boleh menulis kod yang salah. Microsoft, Amazon, GitHub, dan NVIDIA semuanya telah mengeluarkan copilot untuk pembangun.

Bermula dengan chatbots

Untuk memahami-sekurang-kurangnya pada tahap tinggi cara chatbots berfungsi, anda mesti terlebih dahulu memahami asas AI, dan khususnya Pembelajaran Mesin (ML) dan Model Bahasa Besar (LLM).

Pembelajaran Mesin ialah satu cabang sains komputer khusus untuk penyelidikan dan pembangunan percubaan untuk mengajar komputer untuk belajar.

LLM pada asasnya ialah program pemprosesan bahasa semula jadi (NLP) yang menggunakan set besar data dan rangkaian saraf (NN) untuk menjana teks. LLM berfungsi dengan melatih kod AI pada model data besar, yang kemudiannya”belajar”daripadanya dari semasa ke semasa-pada asasnya menjadi pakar domain dalam bidang tertentu berdasarkan ketepatan data input.

Lebih banyak (dan lebih tepat) data input, lebih tepat dan betul bot sembang yang menggunakan model tersebut. LLM juga bergantung pada Pembelajaran Dalam sambil dilatih pada model data.

Apabila anda bertanya soalan kepada chatbot, ia menanyakan LLMnya untuk jawapan yang paling sesuai-berdasarkan pembelajaran dan pengetahuan tersimpannya tentang semua subjek yang berkaitan dengan soalan anda.

Pada asasnya chatbots mempunyai pengetahuan yang diprakira tentang sesuatu topik, dan diberi LLM yang cukup tepat dan masa pembelajaran yang mencukupi, boleh memberikan jawapan yang betul jauh lebih pantas daripada kebanyakan orang.

Menggunakan chatbot adalah seperti mempunyai pasukan PhD automatik yang boleh anda gunakan serta-merta.

Pada Januari 2023, Meta AI mengeluarkan LLM sendiri yang dipanggil LLaMA. Sebulan kemudian, Google memperkenalkan chatbot AInya sendiri, Bard, yang berasaskan LLMnya sendiri, LaMDA. Chatbots lain telah berlaku sejak itu.

AI Generatif

Baru-baru ini, sesetengah LLM telah mempelajari cara menjana data bukan berasaskan teks seperti grafik, muzik dan juga keseluruhan buku. Syarikat berminat dengan Generative AI untuk mencipta perkara seperti grafik korporat, logo, tajuk, dan juga adegan filem digital yang menggantikan pelakon.

Sebagai contoh, imej kecil untuk artikel ini dihasilkan oleh AI.

Sebagai kesan sampingan Generative AI, pekerja menjadi bimbang tentang kehilangan pekerjaan mereka kerana automasi yang didorong oleh perisian AI.

Pembantu Chatbot

Chatbot komersil tersedia pengguna komersil pertama di dunia (BeBot) telah dikeluarkan oleh Bespoke Japan untuk Tokyo Station City pada tahun 2019.

Dikeluarkan sebagai apl iOS dan Android, BeBot tahu cara untuk mengarahkan anda ke mana-mana titik di sekitar stesen seperti labirin, membantu anda menyimpan dan mengambil bagasi anda, menghantar anda ke meja maklumat atau mencari masa kereta api, pengangkutan darat atau makanan dan kedai di dalam stesen.

Malah ia boleh memberitahu anda platform kereta api yang hendak dituju untuk menaiki kereta api terpantas ke mana-mana destinasi di bandar mengikut tempoh perjalanan-semuanya dalam beberapa saat.

Apl sembang MLC

Projek Kompilasi Pembelajaran Mesin (MLC) ialah cetusan idea penyelidik Pembelajaran Dalam Yayasan Apache Siyuan Feng, dan Hongyi Jin serta orang lain yang berpangkalan di Seattle dan di Shanghai, China.

Idea di sebalik MLC adalah untuk menggunakan LLM dan bot sembang yang telah dikompilasi ke peranti pengguna dan pelayar web. MLC memanfaatkan kuasa unit pemprosesan grafik pengguna (GPU) untuk mempercepatkan hasil dan carian AI-menjadikan AI dalam jangkauan kebanyakan peranti pengkomputeran pengguna moden.

Satu lagi projek MLC-Web LLM-membawa fungsi yang sama kepada penyemak imbas web dan berdasarkan pada gilirannya projek lain-WebGPU. Hanya mesin dengan GPU tertentu disokong dalam LLM Web kerana ia bergantung pada rangka kerja kod yang menyokong GPU tersebut.

Kebanyakan pembantu AI bergantung pada model pelayan-pelanggan dengan pelayan melakukan sebahagian besar AI mengangkat berat, tetapi MLC membakar LLM ke dalam kod tempatan yang berjalan terus pada peranti pengguna, menghapuskan keperluan untuk pelayan LLM.

Menyediakan MLC

Untuk menjalankan MLC pada peranti anda, ia mesti memenuhi keperluan minimum yang disenaraikan pada projek dan halaman GitHub.

Untuk menjalankannya pada iPhone, anda memerlukan iPhone 14 Pro Max, iPhone 14 Pro atau iPhone 12 Pro dengan sekurang-kurangnya 6GB RAM percuma. Anda juga perlu memasang apl TestFlight Apple untuk memasang apl itu, tetapi pemasangan terhad kepada 9,000 pengguna pertama.

Kami cuba menjalankan MLC pada iPad asas 2021 dengan storan 64GB, tetapi ia tidak akan dimulakan. Keputusan anda mungkin berbeza pada iPad Pro.

Anda juga boleh membina MLC daripada sumber dan menjalankannya pada telefon anda secara terus dengan mengikut arahan pada halaman MLC-LLM GitHub. Anda memerlukan sistem kawalan kod sumber git dipasang pada Mac anda untuk mendapatkan semula sumber.

Untuk berbuat demikian, buat folder baharu dalam Finder pada Mac anda, gunakan perintah cd UNIX untuk menavigasi ke sana dalam Terminal, kemudian matikan arahan klon git dalam Terminal seperti yang disenaraikan pada MLC-LLM GitHub halaman:

https://github.com/mlc-ai/mlc-llm.git dan tekan Return. git akan memuat turun semua sumber MLC ke dalam folder yang anda buat.

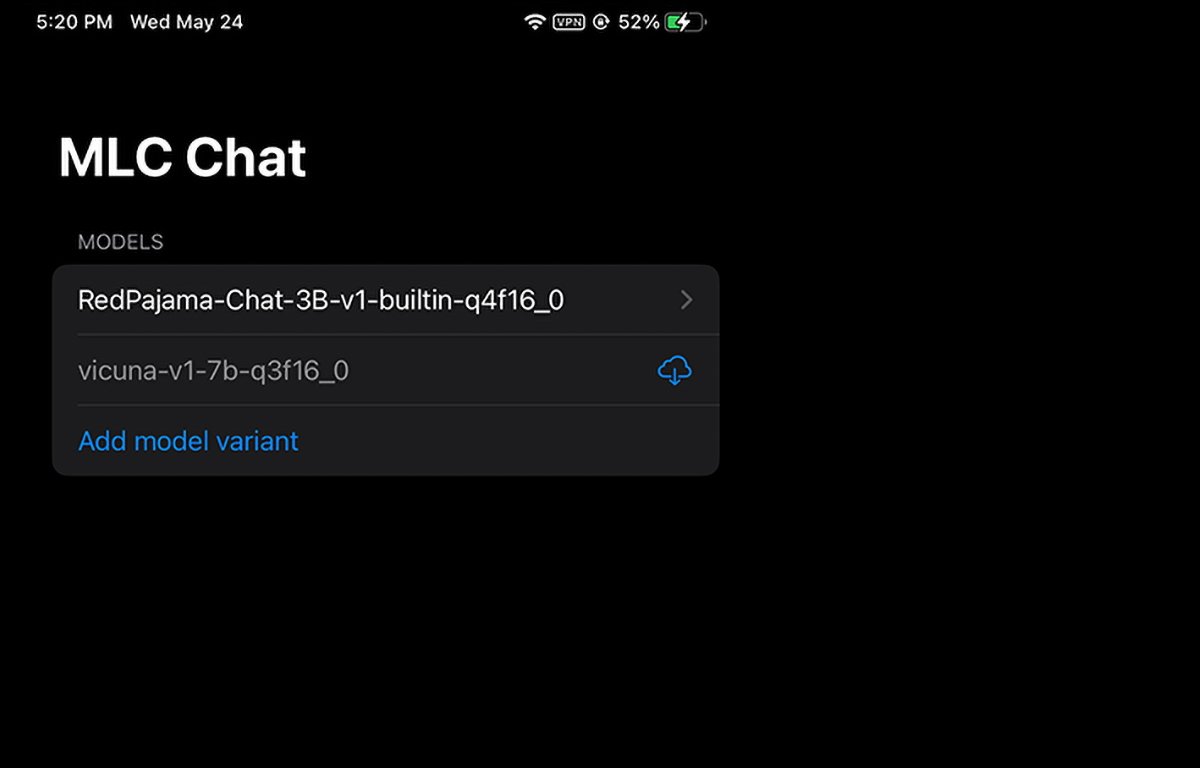

MLC berjalan pada iPhone. Anda boleh memilih atau memuat turun berat model yang hendak digunakan.

Memasang prasyarat Mac

Untuk komputer Mac dan Linux, MLC dijalankan daripada antara muka baris perintah di Terminal. Anda perlu memasang beberapa prasyarat terlebih dahulu untuk menggunakannya:

Conda atau Pustaka grafik Pengurus Pakej Miniconda Homebrew Vulkan (Linux atau Windows sahaja) git sokongan fail besar (LFS)

Untuk pengguna GPU NVIDIA, arahan MLC secara khusus menyatakan anda mesti memasang Vulkan sebagai pemacu lalai. Pustaka grafik lain untuk GPU NVIDIA-CUDA-tidak akan berfungsi.

Untuk pengguna Mac, anda boleh memasang Miniconda dengan menggunakan pengurus pakej Homebrew, yang kami telah membuat liputan sebelum ini. Ambil perhatian bahawa Miniconda bercanggah dengan formula Homebrew Conda yang lain, miniforge.

Jadi, jika anda telah memasang miniforge melalui Homebrew, anda perlu menyahpasangnya terlebih dahulu.

Mengikut arahan pada halaman MLC/LLM, langkah pemasangan yang selebihnya adalah kira-kira:

Buat persekitaran Conda baharu Pasang git dan git LFS Pasang apl sembang baris arahan daripada Conda Cipta setempat baharu folder, muat turun berat model LLM dan tetapkan pembolehubah LOCAL_ID Muat turun perpustakaan MLC daripada GitHub

Semua ini disebut secara terperinci pada halaman arahan, jadi kami tidak akan pergi ke setiap aspek persediaan di sini. Ia mungkin kelihatan menakutkan pada mulanya, tetapi jika anda mempunyai kemahiran asas MacOS Terminal, ia sebenarnya hanya beberapa langkah mudah.

Langkah LOCAL_ID hanya menetapkan pembolehubah itu untuk menunjuk ke salah satu daripada tiga berat model yang anda muat turun.

Berat model dimuat turun daripada tapak web komuniti HuggingFace, yang merupakan sejenis GitHub untuk AI.

Setelah semuanya dipasang di Terminal, anda boleh mengakses MLC dalam Terminal dengan menggunakan mlc_chat_cli

Menggunakan MLC dalam pelayar web

MLC juga mempunyai versi web, Web LLM.

Varian LLM Web hanya berjalan pada Apple Silicon Mac. Ia tidak akan berjalan pada Intel Mac dan akan menghasilkan ralat dalam tetingkap chatbot jika anda mencuba.

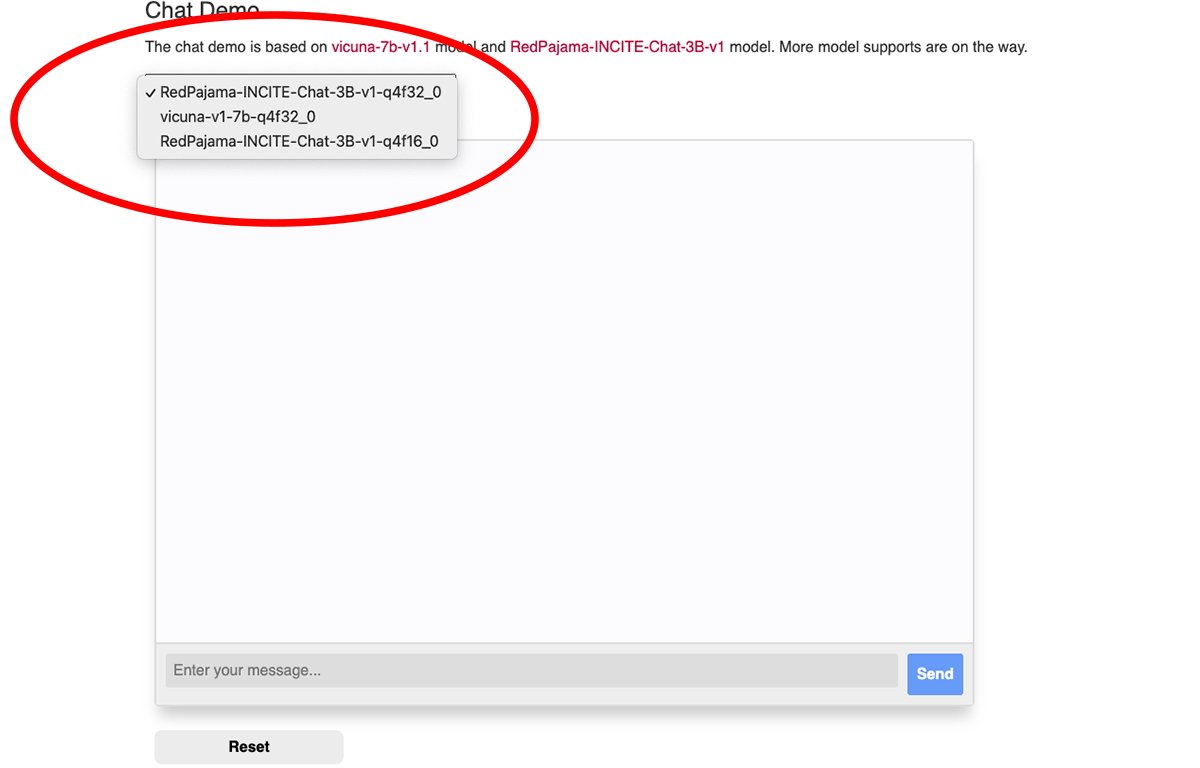

Terdapat menu timbul di bahagian atas tetingkap sembang web MLC dari mana anda boleh memilih berat model yang dimuat turun yang anda mahu gunakan:

Pilih salah satu berat model.

Anda memerlukan penyemak imbas Google Chrome untuk menggunakan Web LLM (Chrome versi 113 atau lebih baru). Versi terdahulu tidak akan berfungsi.

Anda boleh menyemak nombor versi Chrome anda daripada menu Chrome dalam versi Mac dengan pergi ke Chrome->Mengenai Google Chrome. Jika kemas kini tersedia, klik butang Kemas Kini untuk mengemas kini kepada versi terkini.

Anda mungkin perlu memulakan semula Chrome selepas mengemas kini.

Perhatikan bahawa halaman LLM Web MLC mengesyorkan anda melancarkan Chrome dari Terminal Mac menggunakan arahan ini:

/Applications/Google\ Chrome.app/Contents/MacOS/Google\ Chrome — enable-dawn-features=allow_unsafe_apis,disable_robustness

allow_unsafe_apis’dan disable_robustness’ialah dua bendera pelancaran Chrome yang membenarkannya menggunakan ciri percubaan, yang mungkin tidak stabil atau tidak.

Setelah semuanya disediakan, cuma taip soalan ke dalam medan Masukkan mesej anda di bahagian bawah anak tetingkap sembang halaman web LLM Web dan klik Hantar.

Era AI sebenar dan pembantu pintar baru bermula. Walaupun terdapat risiko dengan AI, teknologi ini berjanji untuk meningkatkan masa depan kita dengan menjimatkan banyak masa dan menghapuskan banyak kerja.