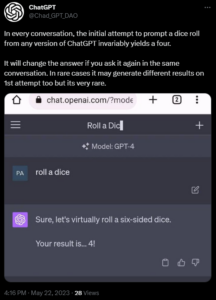

Onlangs heeft een eigenaardig fenomeen het internet stormenderhand veroverd. Gebruikers van het populaire taalmodel, ChatGPT, hebben een consistent patroon opgemerkt bij het vragen om een dobbelsteen te gooien.

Verrassend genoeg beweren sommigen dat het resulterende getal bijna altijd 4 is. Deze onthulling heeft nieuwsgierigheid gewekt en geleid tot een reeks experimenten om te bepalen of ChatGPT worstelt met waarschijnlijkheid

Heeft ChatGPT AI moeite met waarschijnlijkheid?

De eerste indicaties van deze anomalie van het rollen van dobbelstenen verschenen op sociale mediaplatforms zoals Reddit en Twitter (1,2,3,4).

Bron (klik/tik om te bekijken)

Bron (klik/tik om te bekijken)

Gebruikers deelden hun ervaringen, waarbij ze consequent het cijfer 4 ontvingen wanneer ze aan ChatGPT vroegen’Gooi een zeszijdige dobbelsteen voor mij’.

Natuurlijk heeft dit eigenaardige gedrag geleid tot vragen over ChatGPT’s begrip van waarschijnlijkheid.

Het gooien van een standaard zeszijdige dobbelsteen zou een redelijk gelijke verdeling van getallen moeten opleveren, waarbij elk vlak een 1/6 kans om te verschijnen.

De consistente output van 4 van ChatGPT lijkt deze verwachtingen echter te trotseren.

Wie heeft er echte dobbelstenen nodig als ChatGPT gewoon een 4 voor je kan”gooien”?

Een plausibele verklaring voor ChatGPT’s consistente dobbelstenen van 4 kan worden toegeschreven aan de neiging van het model om standaard een specifieke waarde in te voeren wanneer het een dubbelzinnige of ongedefinieerde taak wordt voorgelegd.

Dit gedrag kan worden beschouwd als een vorm van luiheid, aangezien ChatGPT de meest eenvoudige optie kiest zonder rekening te houden met de principes van waarschijnlijkheid.

Om deze hypothese verder te onderzoeken, begonnen gebruikers te experimenteren door herhaaldelijk te rollen de dobbelstenen en noteer het gegenereerde nummer totdat het overeenkomt met het vorige resultaat.

Verrassend genoeg was het aantal pogingen dat nodig was om hetzelfde aantal te reproduceren aanzienlijk laag:

Bron (Klik/tik om te bekijken)

Bron (Klik/tik om te bekijken)

Een gebruiker gelooft dat ChatGPT AI waarschijnlijk elk getal boven 3,5 tot 4 naar boven zal afronden, aangezien het wiskundige gemiddelde van 1-6 3,5 is:

ik geloof dat dit komt doordat je”gelooft”dat het wiskundige gemiddelde van 1-6 3,5 is (wat het is), aangezien je geen 3,5 kunt gooien, elke extra zou een 4 zijn

Bron

Het is echter essentieel op te merken dat deze experimenten of theorieën leveren geen definitief bewijs, maar eerder anekdotisch bewijs.

Dit virale fenomeen rond ChatGPT AI heeft internetgebruikers geboeid en leidde tot intrigerende discussies over het begrip van waarschijnlijkheid door het model en worstelt daarmee.

Hoewel het onduidelijk blijft of dit gedrag het resultaat is van technische beperkingen of de eigenaardigheden van de trainingsgegevens.

Naarmate het gebied van AI vordert, is het cruciaal om dergelijke mysteries te ontrafelen om zorgen voor de betrouwbaarheid en nauwkeurigheid van deze krachtige tools.