Sinds het ontstaan van generatieve AI’s zoals ChatGPT, hebben experts en regeringen hun zorgen geuit over de ongereguleerde ontwikkeling in het veld. In een poging om deze zorgen weg te nemen, vormt OpenAI een toegewijd team gericht op het beheren van de potentiële risico’s verbonden aan superintelligente AI’s.

Het team, geleid door Ilya Sutskever, mede-oprichter van OpenAI, zal samen met Jan Leike, een prominent lid van het afstemmingsteam van OpenAI, methoden ontwikkelen om het hypothetische scenario aan te pakken waarin superintelligente AI-systemen overtreffen de menselijke intelligentie en beginnen autonoom te werken. Hoewel dit scenario misschien vergezocht lijkt, beweren experts dat superintelligente AI’s binnen het komende decennium werkelijkheid kunnen worden, wat het belang onderstreept van het ontwikkelen van beveiligingen vandaag.

“Momenteel hebben we geen oplossing voor het sturen of het besturen van een potentieel superintelligente AI en voorkomen dat deze schurkenstaten wordt”, luidt de blogpost die de beslissing aankondigt.

Het Superalignment-team

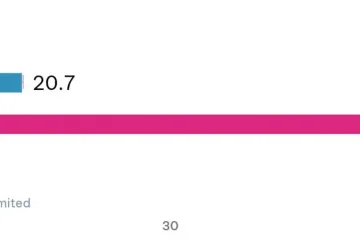

Het Superalignment-team, opgericht door OpenAI, krijgt toegang tot ongeveer 20% van de huidige rekenbronnen, samen met wetenschappers en ingenieurs van OpenAI’s vorige uitlijningsdivisie om een ”geautomatiseerde uitlijningsonderzoeker op menselijk niveau”te ontwikkelen, die voornamelijk zou helpen bij het evalueren van andere AI-systemen en het uitvoeren van uitlijningsonderzoek.

“Naarmate we hierin vooruitgang boeken, kunnen onze AI-systemen meer overnemen en meer van ons uitlijningswerk en uiteindelijk betere uitlijningstechnieken bedenken, implementeren, bestuderen en ontwikkelen dan we nu hebben”, luidt een ander blogbericht.

Een AI-systeem om andere AI’s te controleren

Terwijl het voorstel om een AI-systeem te ontwikkelen om andere AI’s te controleren, lijkt ongebruikelijk, stelt OpenAI dat AI-systemen sneller vooruitgang kunnen boeken in afstemmingsonderzoek in vergelijking met mensen. Deze benadering zou niet alleen tijd besparen voor menselijke onderzoekers, maar hen ook in staat stellen zich te concentreren op het beoordelen van afstemmingsonderzoek uitgevoerd door AI in plaats van het alleen zelf te genereren.

Het is echter belangrijk op te merken dat OpenAI de potentiële risico’s erkent en gevaren verbonden aan deze aanpak. Daarnaast is het bedrijf van plan een roadmap uit te brengen waarin de onderzoeksrichting in de toekomst wordt geschetst.