Apple stawia na realizm fotografii obliczeniowej

Kontrowersje wokół aparatów telefonicznych Samsunga odnowiły dyskusję wokół fotografii obliczeniowej i uwydatniły różnicę między nią a podejściem Apple do systemu iOS.

To nie jest wielka tajemnica że Apple opiera się na zaawansowanych algorytmach i fotografii obliczeniowej w prawie wszystkich funkcjach aparatu iPhone’a. Jednak użytkownicy zaczynają pytać, gdzie wytyczyć granicę między tymi algorytmami a czymś bardziej inwazyjnym, takim jak zmiana pikseli po przechwyceniu.

W tym artykule przyjrzymy się kontrowersjom wokół zdjęć księżyca Samsunga, temu, w jaki sposób firma zajmuje się fotografią obliczeniową i co to oznacza dla Apple i jego konkurentów w przyszłości.

Fotografia komputerowa

Fotografia komputerowa nie jest nową koncepcją. Stało się to konieczne, ponieważ ludzie chcieli większej wydajności od swoich małych aparatów w smartfonach.

Podstawowa idea polega na tym, że komputery mogą wykonywać miliardy operacji w ciągu jednej chwili, na przykład po naciśnięciu migawki aparatu, aby zastąpić potrzebę podstawowych edycji lub zastosować bardziej zaawansowane poprawki. Im więcej możemy zaprogramować komputer do wykonania po naciśnięciu migawki, tym lepsze może być zdjęcie.

Zaczęło się to od systemu Apple z dwoma aparatami w iPhonie 7. Inne innowacje fotograficzne, takie jak Live Photos, można było uznać za fotografię obliczeniową, ale tryb portretowy był punktem zwrotnym dla Apple.

Apple wprowadziło tryb portretowy w 2016 r., który pobierał dane dotyczące głębi z dwóch aparatów iPhone’a 7 Plus, aby stworzyć sztuczny efekt bokeh. Firma twierdziła, że było to możliwe dzięki systemowi dwóch aparatów i zaawansowanemu procesorowi sygnału obrazu, który przeprowadzał 100 miliardów operacji na jednym zdjęciu.

Nie trzeba dodawać, że nie było to idealne, ale był to krok w przyszłość fotografii. Technologia aparatów nadal dostosowywałaby się do kształtu smartfona, układy scalone byłyby szybsze, a czujniki obrazu miałyby większą moc w przeliczeniu na cal kwadratowy.

Tryb portretowy wykorzystuje fotografię komputerową do oddzielenia pierwszy plan

W 2023 r. nagrywanie kinowo rozmytego wideo przy użyciu zaawansowanych silników obliczeniowych nie jest niczym niezwykłym, co daje różne wyniki. Fotografia komputerowa jest wszędzie, od silnika fotonicznego po style fotograficzne — algorytm przetwarza każde zdjęcie zrobione iPhonem. Tak, nawet ProRAW.

To wszystko było spowodowane pragnieniem ludzi, by uchwycić swoje życie za pomocą urządzenia, które mieli pod ręką — iPhone’a. Dedykowane kamery mają fizykę po swojej stronie z dużymi czujnikami i gigantycznymi obiektywami, ale przeciętny człowiek nie chce wydawać setek lub tysięcy dolarów na dedykowany sprzęt.

Tak więc fotografia obliczeniowa wkroczyła, aby ulepszyć możliwości małych czujników smartfonów. Zaawansowane algorytmy zbudowane na dużych bazach danych informują procesor sygnału obrazu, jak uchwycić idealny obraz, przetworzyć szum i naświetlić obiekt.

Istnieje jednak duża różnica między używaniem fotografii komputerowej do zwiększania możliwości aparatu a zmienianiem obrazu na podstawie danych, których czujnik nigdy nie zarejestrował.

Mocny strzał Samsunga

Żeby było jasne: Apple używa modeli uczenia maszynowego — lub „AI, Artificial Intelligence” dla tych, którzy używają słabo ukutego popularnego nowego modnego hasła — do fotografii komputerowej. Algorytmy dostarczają informacji na temat kontrolowania przechwytywania wielu obrazów w celu uzyskania najlepszych wyników lub tworzenia profili głębi ostrości.

Procesor obrazu analizuje odcień skóry, niebo, rośliny, zwierzęta domowe i inne elementy, aby zapewnić odpowiednie kolory i ekspozycję, a nie zastępować piksele. Nie szuka obiektów, takich jak księżyc, aby zapewnić określone ulepszenia w oparciu o informacje spoza czujnika aparatu.

Wskazujemy na to, ponieważ osoby dyskutujące na temat zdjęć księżyca Samsunga wykorzystały fotografię komputerową Apple jako przykład tego, jak inne firmy dokonują tych zmian fotograficznych. Tak po prostu nie jest.

Algorytm księżycowy Samsunga w akcji. Źródło: u/ibreakphotos na Reddit

Samsung udokumentował, w jaki sposób telefony Samsung, począwszy od Galaxy S10, przetwarzają obrazy za pomocą rozpoznawania i modyfikacji obiektów. Optymalizator sceny zaczął rozpoznawać księżyc w Galaxy S21.

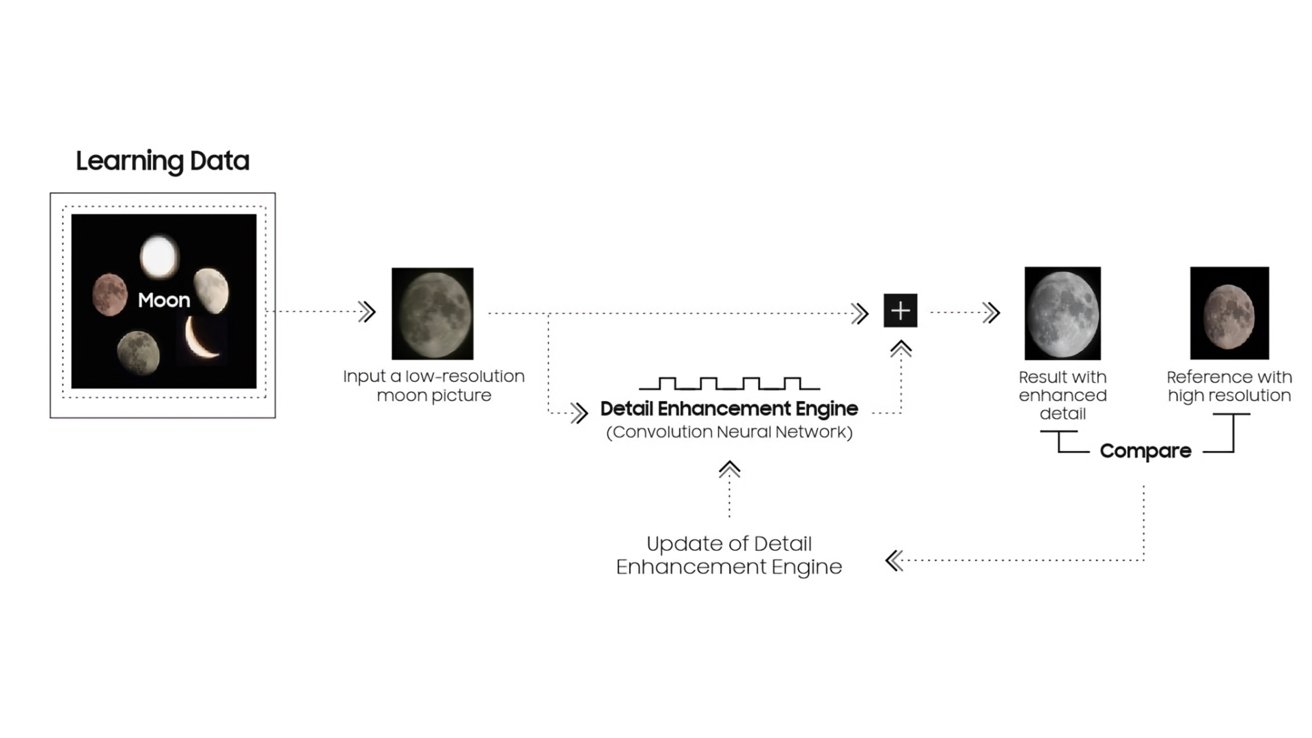

Jak opisano w niedawno opublikowanym dokumencie, „AI” rozpoznaje księżyc na podstawie wyuczonych danych, a funkcja silnika poprawiania szczegółów jest stosowana, aby zdjęcie było wyraźniejsze dzięki syntezie wielu klatek i uczeniu maszynowemu.

Zasadniczo urządzenia Samsung rozpoznają niezasłonięty księżyc, a następnie wykorzystują inne obrazy o wysokiej rozdzielczości i dane o księżycu, aby zsyntetyzować lepsze wyniki. Rezultatem nie jest obraz przechwycony przez aparat urządzenia, ale coś nowego i sfabrykowanego.

Ogólnie rzecz biorąc, ten system jest sprytny, ponieważ księżyc wygląda tak samo bez względu na to, gdzie jest oglądany na Ziemi. Jedyne, co się zmienia, to kolor światła odbijanego od jego powierzchni oraz faza samego księżyca. Uwydatnienie księżyca na zdjęciu zawsze będzie prostą kalkulacją.

Zarówno urządzenia Samsung, jak i Apple wykonują ekspozycję wielu zdjęć do zaawansowanych obliczeń. Oba analizują wiele przechwyconych obrazów pod kątem najlepszej części każdego z nich i łączą je w jeden doskonały obraz. Jednak Samsung dodaje dodatkowy krok dla rozpoznanych obiektów, takich jak księżyc, który wprowadza nowe dane z innych zdjęć księżyca w wysokiej rozdzielczości, aby skorygować księżyc na ostatecznym przechwyconym obrazie.

Wyjaśnienie algorytmu księżyca Samsunga. Źródło: Samsung

To niekoniecznie jest złe. To po prostu nie jest coś, czego Samsung nie wyjaśnił w swoich reklamach lub marketingu produktów, co może prowadzić do dezorientacji klientów.

Problem z tym procesem i powód, dla którego toczy się debata, polega na tym, jak wpływa on na przyszłość fotografii.

Krótko mówiąc, ostateczny obraz nie przedstawia tego, co wykrył czujnik i przetworzył algorytm. Przedstawia wyidealizowaną wersję tego, co może być możliwe, ale nie jest, ponieważ czujnik aparatu i obiektyw są za małe.

Zbliżająca się bitwa o realizm

Z naszego punktu widzenia kluczową zasadą fotografii iPhone’a zawsze był realizm i dokładność. Jeśli istnieje idealny środek w nasyceniu, ostrości i ekspozycji, Apple w ciągu ostatniej dekady zbliżał się do centrum, nawet jeśli nie zawsze pozostawał idealnie spójny.

Zdajemy sobie sprawę, że fotografia jest niezwykle subiektywna, ale wygląda na to, że fotografia na Androida, a konkretnie Samsunga, odeszła od realizmu. Ponownie, niekoniecznie negatywny, ale opiniotwórczy wybór dokonany przez Samsunga, do którego klienci muszą się odnieść.

Jeśli chodzi o tę dyskusję, urządzenia Samsung i Pixel powoli oddalają się od tego idealnego realistycznego centrum reprezentacyjnego. Walczą o większe nasycenie, ostrość lub dzienną ekspozycję w nocy.

Powyższy przykład pokazuje, jak Galaxy S22 Ultra faworyzował większą ekspozycję i nasycenie, co prowadziło do utraty szczegółów. Niewinne i uparte wybory, ale w tym przypadku iPhone 13 Pro wraca do domu z bardziej szczegółowym zdjęciem, które można później edytować.

Ta różnica w sposobie robienia zdjęć jest ustawiona w opiniotwórczych algorytmach używanych przez każde urządzenie. Wraz z postępem tych algorytmów przyszłe decyzje dotyczące fotografii mogą prowadzić do bardziej przemyślanych wyborów, których później nie będzie można cofnąć.

Na przykład zmieniając wygląd księżyca za pomocą zaawansowanych algorytmów bez powiadamiania użytkownika, ten obraz jest na zawsze zmieniany, aby pasował do tego, co Samsung uważa za idealne. Jasne, jeśli użytkownicy wiedzą, jak wyłączyć tę funkcję, mogą, ale prawdopodobnie tego nie zrobią.

Jesteśmy podekscytowani przyszłością fotografii, ale jako entuzjaści fotografii mamy nadzieję, że nie jest ona tak niewidoczna. Podobnie jak tryb portretowy firmy Apple, zdjęcia na żywo i inne techniki przetwarzania — włącz je za pomocą oczywistych przełączników. Spraw też, aby był odwracalny.

Dotknięcie migawki w głównej aplikacji aparatu urządzenia powinno zrobić reprezentatywne zdjęcie tego, co widzi czujnik. Jeśli użytkownik chce więcej, niech wybierze dodanie go za pomocą przełączników przed lub edytując po.

Na razie spróbuj robić zdjęcia nocnego nieba tylko iPhonem i statywem. To działa.

Dlaczego to ma znaczenie

Należy podkreślić, że nie ma żadnego problemu z zastąpieniem brzydkiej świecącej kuli na niebie prawdziwym księżycem, nie ma też problemu z usunięciem ludzi lub śmieci (lub śmieci ludzi) ze zdjęcia. Jednak musi to być kontrolowany, przełączalny i widoczny dla użytkownika proces.

Fotografia komputerowa to przyszłość, lepsza lub gorsza

Wraz z postępem algorytmów zobaczymy więcej wyidealizowanych i przetworzonych zdjęć ze smartfonów z Androidem. Najgorsi przestępcy natychmiast usuną lub wymienią przedmioty bez uprzedzenia.

Apple nieuchronnie udoskonali swoje algorytmy i przetwarzanie obrazu na urządzeniu. Ale biorąc pod uwagę dotychczasowe podejście firmy do fotografii, spodziewamy się, że zrobi to z poszanowaniem pragnienia użytkownika dotyczącego realizmu.

Trybalizm w społeczności technologicznej zawsze wywoływał debaty wśród użytkowników. Obejmowały one Maca lub PC, iPhone’a lub Androida, a wkrótce prawdziwe lub idealne zdjęcia.

Mamy nadzieję, że Apple nadal będzie wybierać realizm i kontrolę użytkownika nad zdjęciami w przyszłości. Dawanie firmie pełnej kontroli nad tym, co użytkownik rejestruje w aparacie, aż do zmiany obrazu w celu dopasowania do ideału, nie wydaje się przyszłością, której chcemy być częścią.