Sztuczna inteligencja szturmem podbija świat i chociaż możesz korzystać z Google Bard lub ChatGPT, możesz też korzystać z lokalnie hostowanego na komputerze Mac. Oto jak korzystać z nowej aplikacji do czatu MLC LLM.

Sztuczna inteligencja (AI) to nowy przełom w informatyce, który generuje sporo szumu w świecie komputerów.

Chatboty – aplikacje oparte na sztucznej inteligencji, z którymi użytkownicy mogą rozmawiać jako eksperci w danej dziedzinie – co najmniej zyskują na popularności.

Chatboty mają pozornie specjalistyczną wiedzę na wiele ogólnych i specjalistycznych tematów oraz są wdrażane wszędzie w szybkim tempie. Jedna grupa – OpenAI-wydała kilka ChatGPT miesięcy temu do zszokowanego świata.

ChatGPT ma pozornie nieograniczoną wiedzę na praktycznie każdy temat i może odpowiadać na pytania w czasie rzeczywistym, które w przeciwnym razie wymagałyby godzin lub dni badań. Zarówno firmy, jak i pracownicy zdali sobie sprawę, że sztuczna inteligencja może przyspieszyć pracę poprzez skrócenie czasu badań.

Wady

Biorąc pod uwagę to wszystko, niektóre aplikacje AI mają wady. Główną wadą sztucznej inteligencji jest to, że wyniki nadal muszą być weryfikowane.

Chociaż sztuczna inteligencja jest zwykle w większości poprawna, może dostarczać błędnych lub zwodniczych danych, które mogą prowadzić do fałszywych wniosków lub wyników.

Twórcy oprogramowania i firmy programistyczne przyjęły „kopilotów” — wyspecjalizowane chatboty, które mogą pomóc programistom w pisaniu kodu przez mając sztuczną inteligencję do automatycznego pisania konspektu funkcji lub metod-który następnie może zostać zweryfikowany przez programistę.

Dopiero piloci to świetna oszczędność czasu, ale mogą też napisać nieprawidłowy kod. Microsoft, Amazon, GitHub i NVIDIA wydały piloty dla programistów.

Pierwsze kroki z chatbotami

Aby zrozumieć-przynajmniej na wysokim poziomie, jak działają chatboty, musisz najpierw zrozumieć podstawy AI, a w szczególności Machine Learning (ML) i duże modele językowe (LLM).

Uczenie maszynowe to dziedzina informatyki zajmująca się badaniami i rozwojem prób nauczenia komputerów uczenia się.

LLM to zasadniczo program do przetwarzania języka naturalnego (NLP), który wykorzystuje ogromne zbiory danych i sieci neuronowe (NN) do generowania tekstu. LLM działają poprzez szkolenie kodu AI na dużych modelach danych, które następnie „uczą się” od nich w miarę upływu czasu – zasadniczo stając się ekspertem w określonej dziedzinie w oparciu o dokładność danych wejściowych.

Im więcej (i dokładniejsze) danych wejściowych, tym bardziej precyzyjny i poprawny będzie chatbot korzystający z modelu. LLM polegają również na głębokim uczeniu się podczas szkolenia na modelach danych.

Kiedy zadajesz chatbotowi pytanie, wysyła on zapytanie do swojego LLM o najwłaściwszą odpowiedź – w oparciu o swoją wiedzę i zgromadzoną wiedzę na wszystkie tematy związane z Twoim pytaniem.

Zasadniczo chatboty mają wstępnie obliczoną wiedzę na dany temat, a mając wystarczająco dokładne LLM i wystarczający czas na naukę, mogą udzielić poprawnych odpowiedzi znacznie szybciej niż większość ludzi.

Korzystanie z chatbota jest jak natychmiastowy dostęp do zautomatyzowanego zespołu doktorów.

W styczniu 2023 r. Meta AI wydała własny LLM o nazwie LLaMA. Miesiąc później Google wprowadził własnego chatbota AI, Bard, który jest oparty na własnym LLM, LaMDA. Od tego czasu pojawiły się inne chatboty.

Generacyjna sztuczna inteligencja

Niedawno niektóre LLM nauczyły się generować dane nietekstowe, takie jak grafika, muzyka, a nawet całe książki. Firmy są zainteresowane generatywną sztuczną inteligencją do tworzenia takich rzeczy, jak grafika korporacyjna, logo, tytuły, a nawet cyfrowe sceny filmowe, które zastępują aktorów.

Na przykład obraz miniatury tego artykułu został wygenerowany przez sztuczną inteligencję.

Efektem ubocznym generatywnej sztucznej inteligencji pracownicy zaczęli się niepokoić utratą pracy na skutek automatyzacji napędzanej oprogramowaniem sztucznej inteligencji.

Asystenci chatbota

Pierwszy na świecie komercyjny chatbot dostępny dla użytkowników (BeBot) został wydany przez Bespoke Japan dla Tokyo Station City w 2019 roku.

Wydany jako aplikacja na iOS i Androida, BeBot wie, jak skierować Cię do dowolnego punktu wokół przypominającej labirynt stacji, pomóc Ci przechować i odzyskać bagaż, wysłać Cię do punktu informacyjnego lub znaleźć rozkład jazdy pociągów, transport naziemny lub jedzenie i sklepy na stacji.

Może nawet powiedzieć, na które perony kolejowe należy się udać, aby najszybciej pojechać pociągiem do dowolnego miejsca w mieście według czasu trwania podróży — a wszystko to w ciągu kilku sekund.

Aplikacja do czatu MLC

Projekt Machine Learning Compilation (MLC) jest pomysłem badacza Deep Learning Fundacji Apache Siyuan Feng i Hongyi Jin, a także inni z Seattle i Szanghaju w Chinach.

Ideą MLC jest wdrożenie prekompilowanych LLM i chatbotów na urządzenia konsumenckie i przeglądarki internetowe. MLC wykorzystuje moc konsumenckich procesorów graficznych (GPU) w celu przyspieszenia wyników i wyszukiwania AI, sprawiając, że sztuczna inteligencja jest w zasięgu większości nowoczesnych konsumenckich urządzeń komputerowych.

Inny projekt MLC — Web LLM — wprowadza tę samą funkcjonalność do przeglądarek internetowych i jest z kolei oparty na kolejny projekt-WebGPU. W Web LLM obsługiwane są tylko maszyny z określonymi procesorami GPU, ponieważ opiera się on na strukturach kodu obsługujących te procesory GPU.

Większość asystentów sztucznej inteligencji opiera się na modelu klient-serwer, przy czym serwery wykonują większość zadań związanych ze sztuczną inteligencją, ale MLC wypala LLM w lokalnym kodzie, który działa bezpośrednio na urządzeniu użytkownika, eliminując potrzebę stosowania serwerów LLM.

Konfiguracja MLC

Aby uruchomić MLC na swoim urządzeniu, musi ono spełniać minimalne wymagania wymienione na stronach projektu i GitHub.

Aby uruchomić ją na iPhonie, potrzebujesz iPhone’a 14 Pro Max, iPhone’a 14 Pro lub iPhone’a 12 Pro z co najmniej 6 GB wolnej pamięci RAM. Aby zainstalować aplikację, musisz także zainstalować aplikację Apple TestFlight, ale instalacja jest ograniczona do pierwszych 9 000 użytkowników.

Próbowaliśmy uruchomić MLC na podstawowym iPadzie 2021 z 64 GB pamięci, ale nie udało się go zainicjować. Twoje wyniki mogą się różnić na iPadzie Pro.

Możesz także zbudować MLC ze źródeł i uruchomić go bezpośrednio na swoim telefonie, postępując zgodnie ze wskazówkami na stronie MLC-LLM GitHub. Będziesz potrzebował systemu kontroli kodu źródłowego git zainstalowanego na komputerze Mac, aby pobrać źródła.

Aby to zrobić, utwórz nowy folder w Finderze na komputerze Mac, użyj polecenia UNIX cd, aby przejść do niego w Terminalu, a następnie odpal polecenie git clone w Terminalu zgodnie z listą w MLC-LLM GitHub stronę:

https://github.com/mlc-ai/mlc-llm.git i naciśnij Return. git pobierze wszystkie źródła MLC do utworzonego folderu.

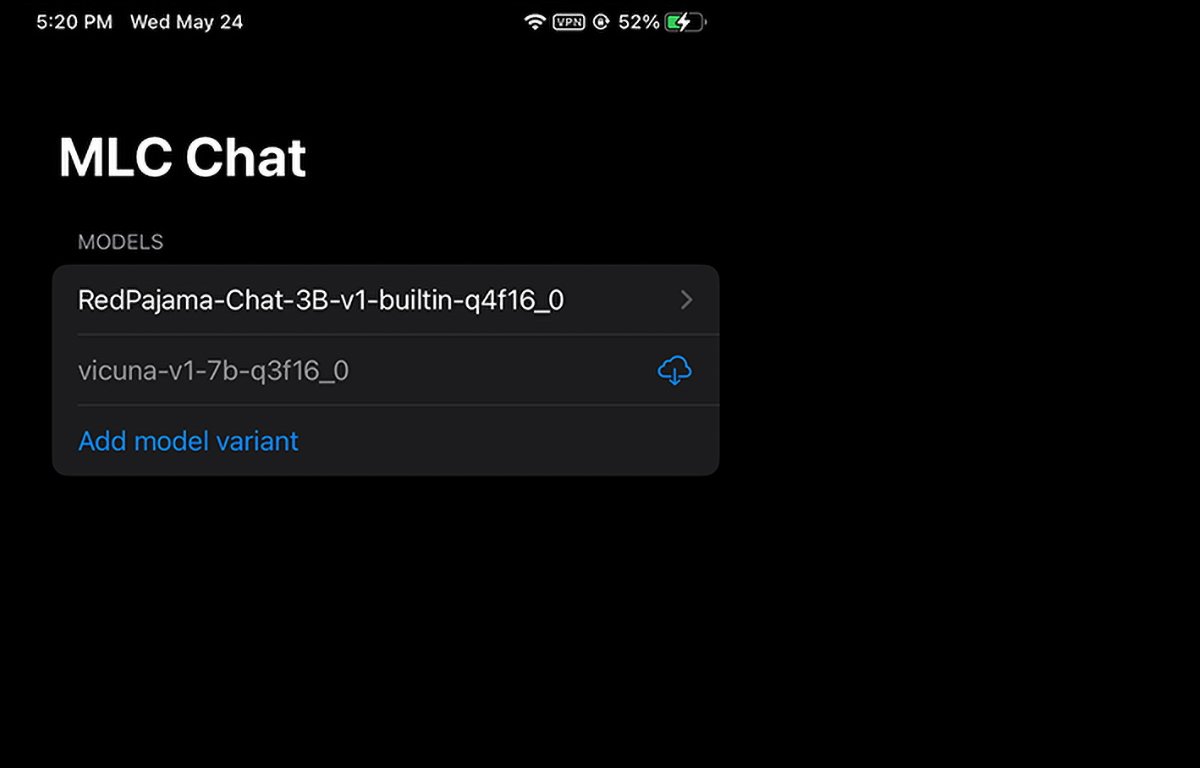

MLC działający na iPhonie. Możesz wybrać lub pobrać wagę modelu, którego chcesz użyć.

Instalowanie wymagań wstępnych dla komputerów Mac

W przypadku komputerów Mac i Linux program MLC jest uruchamiany z poziomu wiersza poleceń w Terminalu. Aby z niego korzystać, musisz najpierw zainstalować kilka wymagań wstępnych:

Conda lub Menedżer pakietów Miniconda Biblioteka graficzna Homebrew Vulkan (tylko Linux lub Windows) obsługa dużych plików git (LFS)

W przypadku użytkowników procesorów graficznych NVIDIA instrukcje MLC wyraźnie stwierdzają, że należy ręcznie zainstalować Vulkan sterownik jako sterownik domyślny. Kolejna biblioteka graficzna dla procesorów graficznych NVIDIA-CUDA-nie będzie działać.

Użytkownicy komputerów Mac mogą zainstalować Miniconda za pomocą menedżera pakietów Homebrew, którego omówiłem wcześniej. Zauważ, że Miniconda koliduje z inną formułą Homebrew Conda, miniforge.

Jeśli więc masz już zainstalowaną miniforge przez Homebrew, musisz ją najpierw odinstalować.

Postępując zgodnie ze wskazówkami na stronie MLC/LLM, pozostałe kroki instalacji są z grubsza następujące:

Utwórz nowe środowisko Conda Zainstaluj git i git LFS Zainstaluj aplikację do czatu wiersza poleceń z Conda Utwórz nową lokalną folder, pobierz wagi modelu LLM i ustaw zmienną LOCAL_ID Pobierz biblioteki MLC z GitHub

Wszystko to jest szczegółowo opisane na stronie z instrukcjami, więc nie będziemy tutaj omawiać każdego aspektu konfiguracji. Na początku może się to wydawać zniechęcające, ale jeśli masz podstawowe umiejętności obsługi terminala macOS, to naprawdę wystarczy kilka prostych kroków.

Krok LOCAL_ID po prostu ustawia tę zmienną tak, aby wskazywała jedną z trzech pobranych wag modelu.

Wagi modeli są pobierane ze strony internetowej społeczności HuggingFace, która jest czymś w rodzaju GitHub dla sztucznej inteligencji.

Gdy wszystko jest już zainstalowane w Terminalu, możesz uzyskać dostęp do MLC w Terminalu za pomocą mlc_chat_cli

Korzystanie z MLC w przeglądarkach internetowych

MLC ma również wersję internetową Web LLM.

Wariant Web LLM działa tylko na komputerach Apple Silicon Mac. Nie będzie działać na komputerach Mac z procesorem Intel i jeśli spróbujesz, wyświetli się błąd w oknie chatbota.

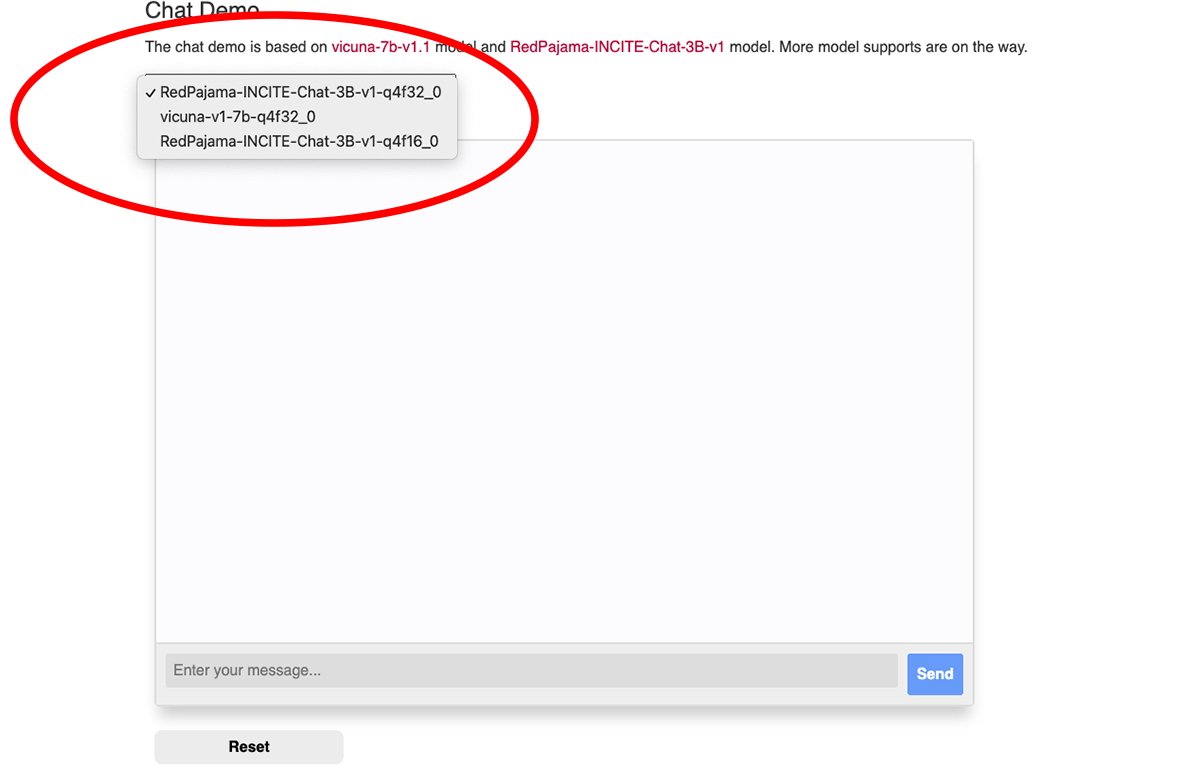

W górnej części okna czatu internetowego MLC znajduje się wyskakujące menu, w którym możesz wybrać wagę pobranego modelu, którego chcesz użyć:

Wybierz jeden z modeli o wadze.

Do korzystania z Web LLM potrzebna jest przeglądarka Google Chrome (Chrome w wersji 113 lub nowszej). Wcześniejsze wersje nie będą działać.

Możesz sprawdzić numer wersji Chrome w menu Chrome w wersji dla Maca, przechodząc do Chrome->Google Chrome — informacje. Jeśli dostępna jest aktualizacja, kliknij przycisk Aktualizuj, aby zaktualizować do najnowszej wersji.

Po aktualizacji może być konieczne ponowne uruchomienie Chrome.

Pamiętaj, że strona MLC Web LLM zaleca uruchamianie Chrome z terminala Mac za pomocą tego polecenia:

/Applications/Google\ Chrome.app/Contents/MacOS/Google\ Chrome — enable-dawn-features=allow_unsafe_apis,disable_robustness

allow_unsafe_apis’i disable_robustness’to dwie flagi uruchamiania Chrome, które pozwalają Chrome na korzystanie z funkcji eksperymentalnych, które mogą być niestabilne lub nie.

Gdy wszystko jest skonfigurowane, po prostu wpisz pytanie w polu Wpisz wiadomość u dołu okienka czatu strony internetowej Web LLM i kliknij Wyślij przycisk.

Era prawdziwej sztucznej inteligencji i inteligentnych asystentów dopiero się zaczyna. Chociaż sztuczna inteligencja wiąże się z ryzykiem, technologia ta obiecuje poprawę naszej przyszłości, oszczędzając ogromne ilości czasu i eliminując wiele pracy.