การถ่ายภาพด้วยคอมพิวเตอร์ของ Apple มีจุดมุ่งหมายเพื่อความสมจริง

ข้อโต้แย้งเกี่ยวกับกล้องโทรศัพท์ของ Samsung ได้เปลี่ยนการสนทนาเกี่ยวกับการถ่ายภาพด้วยคอมพิวเตอร์ และเน้นย้ำถึงความแตกต่างระหว่างกล้องกับแนวทางของ Apple ใน iOS

ไม่ใช่ความลับที่ยิ่งใหญ่ Apple อาศัยอัลกอริทึมขั้นสูงและการถ่ายภาพด้วยคอมพิวเตอร์สำหรับคุณสมบัติกล้อง iPhone เกือบทั้งหมด อย่างไรก็ตาม ผู้ใช้เริ่มสงสัยว่าควรวาดเส้นแบ่งระหว่างอัลกอริทึมเหล่านี้กับบางสิ่งที่ล่วงล้ำเช่นการแก้ไขพิกเซลหลังการจับภาพ

ในส่วนนี้ เราจะตรวจสอบข้อโต้แย้งเกี่ยวกับภาพถ่ายดวงจันทร์ของ Samsung บริษัทจัดการกับการถ่ายภาพด้วยคอมพิวเตอร์อย่างไร และสิ่งนี้มีความหมายต่อ Apple และคู่แข่งในอนาคตอย่างไร

การถ่ายภาพด้วยคอมพิวเตอร์

การถ่ายภาพด้วยคอมพิวเตอร์ไม่ใช่แนวคิดใหม่ กลายเป็นสิ่งจำเป็นเนื่องจากผู้คนต้องการประสิทธิภาพที่มากขึ้นจากกล้องสมาร์ทโฟนขนาดเล็กของพวกเขา

แนวคิดพื้นฐานคือคอมพิวเตอร์สามารถดำเนินการนับพันล้านรายการในช่วงเวลาหนึ่ง เช่น หลังจากกดชัตเตอร์ของกล้อง เพื่อแทนที่ความจำเป็นในการแก้ไขพื้นฐานหรือใช้การแก้ไขขั้นสูงเพิ่มเติม ยิ่งเราสามารถตั้งโปรแกรมให้คอมพิวเตอร์ทำหลังจากกดชัตเตอร์ได้มากเท่าไหร่ ภาพก็จะยิ่งดีขึ้นเท่านั้น

สิ่งนี้เริ่มต้นจากระบบกล้องคู่ของ Apple บน iPhone 7 นวัตกรรมการถ่ายภาพอื่นๆ ก่อนหน้านั้น เช่น Live Photos อาจถือเป็นการถ่ายภาพด้วยคอมพิวเตอร์ แต่โหมดภาพถ่ายบุคคลเป็นจุดเปลี่ยนสำหรับ Apple

Apple เปิดตัวโหมดภาพถ่ายบุคคลในปี 2559 ซึ่งนำข้อมูลเชิงลึกจากกล้องสองตัวใน iPhone 7 Plus มาสร้างโบเก้เทียม บริษัทอ้างว่าเป็นไปได้ด้วยระบบกล้องคู่และตัวประมวลผลสัญญาณภาพขั้นสูง ซึ่งดำเนินการ 100 พันล้านครั้งต่อภาพถ่าย

ไม่จำเป็นต้องพูดว่านี่ไม่ได้สมบูรณ์แบบ แต่เป็นก้าวสู่อนาคตของการถ่ายภาพ เทคโนโลยีกล้องจะยังคงปรับให้เข้ากับฟอร์มแฟคเตอร์ของสมาร์ทโฟน ชิปจะเร็วขึ้น และเซ็นเซอร์ภาพจะมีประสิทธิภาพมากขึ้นต่อตารางนิ้ว

โหมดภาพบุคคลใช้การถ่ายภาพด้วยคอมพิวเตอร์เพื่อแยก เบื้องหน้า

ในปี 2023 ไม่ใช่เรื่องแปลกที่จะถ่ายวิดีโอเบลอในโรงภาพยนตร์โดยใช้เครื่องมือคำนวณขั้นสูงที่ให้ผลลัพธ์แบบผสม การถ่ายภาพด้วยคอมพิวเตอร์มีอยู่ทุกที่ ตั้งแต่ Photonic Engine ไปจนถึง Photographic Styles — อัลกอริทึมจะประมวลผลทุกภาพที่ถ่ายบน iPhone ใช่ แม้แต่ ProRAW

ทั้งหมดนี้เป็นสิ่งที่จำเป็นสำหรับผู้คนที่ต้องการบันทึกชีวิตของพวกเขาด้วยอุปกรณ์ที่พวกเขามี ซึ่งก็คือ iPhone ของพวกเขา กล้องเฉพาะมีฟิสิกส์ที่ด้านข้างของพวกเขาด้วยเซ็นเซอร์ขนาดใหญ่และเลนส์ยักษ์ แต่คนทั่วไปไม่ต้องการใช้เงินหลายร้อยหรือหลายพันดอลลาร์กับอุปกรณ์เฉพาะ

ดังนั้น การถ่ายภาพด้วยคอมพิวเตอร์จึงเข้ามาช่วยปรับปรุงสิ่งที่เซ็นเซอร์ขนาดเล็กของสมาร์ทโฟนสามารถทำได้ อัลกอริธึมขั้นสูงที่สร้างขึ้นบนฐานข้อมูลขนาดใหญ่จะแจ้งให้ตัวประมวลผลสัญญาณภาพทราบวิธีการจับภาพในอุดมคติ ประมวลผลสัญญาณรบกวน และเปิดเผยวัตถุ

อย่างไรก็ตาม มีความแตกต่างอย่างมากระหว่างการใช้การถ่ายภาพด้วยคอมพิวเตอร์เพื่อเพิ่มขีดความสามารถของกล้องและการปรับเปลี่ยนภาพตามข้อมูลที่เซ็นเซอร์ไม่เคยจับได้

ภาพพระจันทร์ของ Samsung

เพื่อความชัดเจน: Apple กำลังใช้โมเดลการเรียนรู้ของเครื่อง — หรือ”AI, ปัญญาประดิษฐ์”สำหรับผู้ที่ใช้คำศัพท์ใหม่ที่เป็นที่นิยม — สำหรับการถ่ายภาพด้วยคอมพิวเตอร์ อัลกอริทึมให้ข้อมูลเกี่ยวกับการควบคุมการถ่ายภาพหลายภาพเพื่อให้ได้ผลลัพธ์ที่ดีที่สุดหรือสร้างโปรไฟล์ระยะชัดลึก

ตัวประมวลผลภาพจะวิเคราะห์โทนสีผิว ท้องฟ้า พืช สัตว์เลี้ยง และอื่นๆ เพื่อให้ได้สีและค่าแสงที่เหมาะสม ไม่ใช่การแทนที่พิกเซล มันไม่ได้มองหาวัตถุ เช่น ดวงจันทร์ เพื่อเพิ่มประสิทธิภาพเฉพาะตามข้อมูลภายนอกเซ็นเซอร์ของกล้อง

เราชี้ประเด็นนี้เนื่องจากภาพถ่ายดวงจันทร์ของ Samsung ที่เป็นที่โต้เถียงกันนั้นใช้การถ่ายภาพด้วยคอมพิวเตอร์ของ Apple เป็นตัวอย่างว่าบริษัทอื่นๆ ดำเนินการแก้ไขภาพถ่ายเหล่านี้อย่างไร นั่นไม่ใช่กรณี

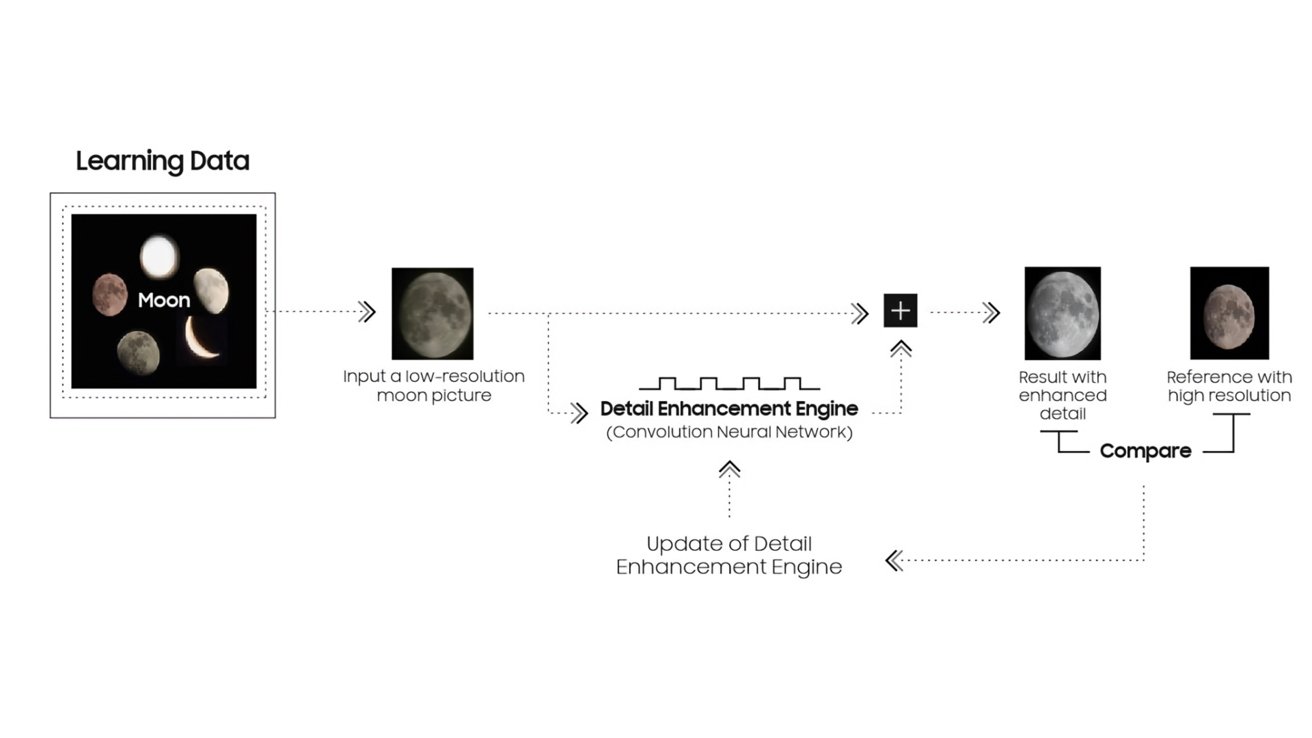

การทำงานของอัลกอริทึมดวงจันทร์ของ Samsung เครดิต: u/ibreakphotos บน Reddit

Samsung ได้บันทึกว่าโทรศัพท์ Samsung ตั้งแต่ Galaxy S10 ประมวลผลภาพโดยใช้การจดจำและดัดแปลงวัตถุอย่างไร เครื่องมือเพิ่มประสิทธิภาพฉากเริ่มจดจำดวงจันทร์ด้วย Galaxy S21

ตามที่เอกสารเผยแพร่เมื่อเร็วๆ นี้อธิบาย”AI”จดจำดวงจันทร์ผ่านข้อมูลที่เรียนรู้ และมีการใช้ฟังก์ชันเครื่องมือปรับปรุงรายละเอียดเพื่อทำให้ภาพถ่ายชัดเจนขึ้นด้วยการสังเคราะห์แบบหลายเฟรมและการเรียนรู้ของเครื่อง

โดยพื้นฐานแล้ว อุปกรณ์ Samsung จะจดจำดวงจันทร์ที่ไม่บดบัง จากนั้นใช้ภาพความละเอียดสูงและข้อมูลอื่นๆ เกี่ยวกับดวงจันทร์เพื่อสังเคราะห์ผลลัพธ์ที่ดีขึ้น ผลลัพธ์ไม่ใช่ภาพที่ถ่ายด้วยกล้องของอุปกรณ์ แต่เป็นของใหม่และประดิษฐ์ขึ้น

โดยรวมแล้ว ระบบนี้ฉลาด เพราะดวงจันทร์มีลักษณะเหมือนเดิมไม่ว่าจะมองจากที่ใดบนโลก สิ่งเดียวที่เปลี่ยนไปคือสีของแสงที่สะท้อนจากพื้นผิวและเฟสของดวงจันทร์ การปรับปรุงดวงจันทร์ในภาพถ่ายจะเป็นการคำนวณที่ตรงไปตรงมาเสมอ

ทั้งอุปกรณ์ Samsung และ Apple เปิดรับแสงหลายภาพสำหรับการคำนวณขั้นสูง ทั้งสองวิเคราะห์ภาพที่ถ่ายไว้หลายภาพเพื่อหาส่วนที่ดีที่สุดของแต่ละภาพ แล้วรวมเข้าด้วยกันเป็นภาพที่เหนือกว่าเพียงภาพเดียว อย่างไรก็ตาม Samsung ได้เพิ่มขั้นตอนเพิ่มเติมสำหรับวัตถุที่รู้จัก เช่น ดวงจันทร์ ซึ่งแนะนำข้อมูลใหม่จากภาพดวงจันทร์ความละเอียดสูงอื่นๆ เพื่อแก้ไขดวงจันทร์ในภาพสุดท้ายที่ถ่าย

อธิบายอัลกอริทึมดวงจันทร์ของ Samsung เครดิต: Samsung

นี่ไม่ใช่เรื่องเลวร้ายเสมอไป ไม่ใช่สิ่งที่ Samsung ไม่ได้ระบุอย่างชัดเจนในการโฆษณาหรือการตลาดของผลิตภัณฑ์ ซึ่งอาจนำไปสู่ความสับสนของลูกค้า

ปัญหาของกระบวนการนี้และเหตุผลของการถกเถียงคือสิ่งนี้ส่งผลต่ออนาคตของการถ่ายภาพอย่างไร

เรื่องสั้นสั้นๆ ภาพสุดท้ายไม่ได้แสดงถึงสิ่งที่เซ็นเซอร์ตรวจพบและอัลกอริทึมประมวลผล มันแสดงถึงสิ่งที่อาจเป็นไปได้ในอุดมคติ แต่ไม่ใช่เพราะเซ็นเซอร์กล้องและเลนส์มีขนาดเล็กเกินไป

การต่อสู้เพื่อความสมจริงที่ใกล้จะเกิดขึ้น

จากมุมมองของเรา หลักการสำคัญของการถ่ายภาพด้วย iPhone คือความสมจริงและความแม่นยำมาโดยตลอด หากมีความอิ่มตัว ความคมชัด และการเปิดรับแสงตรงกลางที่สมบูรณ์แบบ Apple มีแนวโน้มที่จะเข้าใกล้กึ่งกลางในช่วงทศวรรษที่ผ่านมา แม้ว่าจะไม่ได้คงเส้นคงวาอย่างสมบูรณ์เสมอไปก็ตาม

เราทราบดีว่าการถ่ายภาพเป็นเรื่องส่วนตัวอย่างไม่น่าเชื่อ แต่ดูเหมือนว่าการถ่ายภาพของ Android ซึ่งก็คือ Samsung จะเอนเอียงไปจากความสมจริง อีกครั้ง ไม่จำเป็นต้องเป็นแง่ลบ แต่เป็นทางเลือกที่มีความคิดเห็นซึ่งจัดทำโดย Samsung ซึ่งลูกค้าต้องจัดการ

สำหรับหัวข้อของการสนทนานี้ อุปกรณ์ Samsung และ Pixel ได้ค่อยๆ เอียงออกจากศูนย์กลางการแสดงภาพเสมือนจริงในอุดมคตินั้น พวกเขากำลังแย่งชิงความอิ่มตัวของสี ความคมชัด หรือการเปิดรับแสงเหมือนกลางวันในตอนกลางคืน

ตัวอย่างด้านบนแสดงให้เห็นว่า Galaxy S22 Ultra ให้ความสำคัญกับการเปิดรับแสงและความอิ่มตัวของสีมากขึ้น ซึ่งทำให้สูญเสียรายละเอียดไปได้อย่างไร ตัวเลือกที่ไร้เดียงสาและไร้เหตุผล แต่ในกรณีนี้ iPhone 13 Pro กลับมาพร้อมกับภาพถ่ายที่มีรายละเอียดมากขึ้นซึ่งสามารถแก้ไขได้ในภายหลัง

ความแตกต่างในวิธีการถ่ายภาพนี้ถูกกำหนดไว้ในอัลกอริทึมการให้คะแนนซึ่งใช้โดยอุปกรณ์แต่ละเครื่อง เมื่ออัลกอริทึมเหล่านี้ก้าวหน้าไป การตัดสินใจถ่ายภาพในอนาคตอาจนำไปสู่การเลือกที่มีความคิดเห็นมากขึ้นซึ่งไม่สามารถย้อนกลับได้ในภายหลัง

ตัวอย่างเช่น เมื่อเปลี่ยนลักษณะที่ปรากฏของดวงจันทร์โดยใช้อัลกอริธึมขั้นสูงโดยไม่แจ้งเตือนผู้ใช้ รูปภาพนั้นจะถูกเปลี่ยนแปลงตลอดไปเพื่อให้เหมาะกับสิ่งที่ Samsung คิดว่าเหมาะสมที่สุด แน่นอน ถ้าผู้ใช้รู้วิธีปิดคุณลักษณะนี้ พวกเขาทำได้ แต่มีแนวโน้มว่าจะไม่ทำ

เราตื่นเต้นกับอนาคตของการถ่ายภาพ แต่ในฐานะผู้ที่ชื่นชอบการถ่ายภาพ เราหวังว่าสิ่งนี้จะไม่ถูกมองข้าม เช่นเดียวกับโหมดภาพถ่ายบุคคล, Live Photos และเทคนิคการประมวลผลอื่นๆ ของ Apple — ทำให้เลือกใช้ได้ด้วยการสลับที่ชัดเจน นอกจากนี้ยังทำให้สามารถย้อนกลับได้

การแตะชัตเตอร์ในแอปกล้องหลักของอุปกรณ์ควรถ่ายภาพแทนสิ่งที่เซ็นเซอร์เห็น หากผู้ใช้ต้องการมากกว่านี้ ให้พวกเขาเลือกที่จะเพิ่มผ่านการสลับก่อนหรือแก้ไขหลัง

สำหรับตอนนี้ ลองถ่ายภาพท้องฟ้ายามค่ำคืนด้วย iPhone และขาตั้งกล้อง มันได้ผล.

เหตุใดจึงสำคัญ

สิ่งสำคัญคือต้องเน้นว่าไม่มีปัญหาใดๆ ในการแทนที่ลูกบอลเรืองแสงน่าเกลียดบนท้องฟ้าด้วยดวงจันทร์ที่เหมาะสม และไม่มีปัญหาในการลบคนหรือขยะ (หรือคนขยะ) ออกจากรูปภาพ อย่างไรก็ตาม จะต้องเป็นกระบวนการที่ควบคุมได้ สลับได้ และมองเห็นได้สำหรับผู้ใช้

การถ่ายภาพด้วยคอมพิวเตอร์คืออนาคต ไม่ว่าจะดีขึ้นหรือแย่ลง

เมื่ออัลกอริทึมก้าวหน้า เราจะเห็นภาพในอุดมคติและผ่านการประมวลผลมากขึ้นจากสมาร์ทโฟน Android ผู้กระทำผิดที่เลวร้ายที่สุดจะลบหรือเปลี่ยนวัตถุทันทีโดยไม่ต้องแจ้งให้ทราบล่วงหน้า

Apple จะปรับปรุงการประมวลผลภาพและอัลกอริทึมบนอุปกรณ์ของตนอย่างหลีกเลี่ยงไม่ได้ แต่จากแนวทางที่บริษัทเข้าถึงการถ่ายภาพจนถึงตอนนี้ เราคาดว่าบริษัทจะทำเช่นนั้นด้วยความเคารพต่อความต้องการความสมจริงของผู้ใช้

ลัทธิชนเผ่าในชุมชนเทคโนโลยีทำให้เกิดการถกเถียงในหมู่ผู้ใช้อยู่เสมอ สิ่งเหล่านี้รวมถึง Mac หรือ PC, iPhone หรือ Android และในไม่ช้าจะเป็นภาพถ่ายจริงหรือในอุดมคติ

เราหวังว่า Apple จะยังคงเลือกความสมจริงและการควบคุมโดยผู้ใช้สำหรับภาพถ่ายนับจากนี้เป็นต้นไป การให้บริษัทควบคุมความคิดเห็นอย่างสมบูรณ์ต่อสิ่งที่ผู้ใช้จับภาพในกล้อง ไปจนถึงการปรับเปลี่ยนภาพให้ตรงกับอุดมคติ ดูเหมือนจะไม่ใช่อนาคตที่เราต้องการมีส่วนร่วม