Ang AI ay kumukuha ng mundo sa pamamagitan ng bagyo, at habang maaari mong gamitin ang Google Bard o ChatGPT, maaari ka ring gumamit ng lokal na naka-host sa iyong Mac. Narito kung paano gamitin ang bagong MLC LLM chat app.

Ang Artificial Intelligence (AI) ay ang bagong cutting-edge na hangganan ng computer science at nakakagawa ng medyo hype sa mundo ng computing.

Chatbots-mga app na nakabatay sa AI na maaaring kausapin ng mga user bilang mga eksperto sa domain-ay lumalaki sa kasikatan.

Ang mga Chatbot ay may tila ekspertong kaalaman sa iba’t ibang uri ng generic at espesyal na mga paksa at ay inilalagay sa lahat ng dako sa mabilis na bilis. Isang grupo-OpenAI-naglabas ng ChatGPT ng ilan buwan na ang nakalipas sa isang nagulat na mundo.

Ang ChatGPT ay may tila walang limitasyong kaalaman sa halos anumang paksa at maaaring sagutin ang mga tanong sa real-time na kung hindi man ay tatagal ng mga oras o araw ng pananaliksik. Parehong napagtanto ng mga kumpanya at manggagawa ang AI ay maaaring gamitin upang mapabilis ang trabaho sa pamamagitan ng pagbawas ng oras ng pananaliksik.

Ang downside

Gayunpaman, dahil sa lahat ng iyon, may downside sa ilang AI app. Ang pangunahing disbentaha sa AI ay dapat pa ring ma-verify ang mga resulta.

Bagama’t kadalasan ay tama, ang AI ay maaaring magbigay ng mali o mapanlinlang na data na maaaring humantong sa mga maling konklusyon o resulta.

Ang mga developer ng software at mga kumpanya ng software ay dinala sa”mga copilot“-mga dalubhasang chatbot na makakatulong sa mga developer na magsulat ng code sa pamamagitan ng pagkakaroon ng AI na awtomatikong isulat ang outline ng mga function o pamamaraan-na maaaring ma-verify ng isang developer.

Habang isang mahusay na timesaver, ang mga copilot ay maaari ding magsulat ng maling code. Ang Microsoft, Amazon, GitHub, at NVIDIA ay naglabas lahat ng mga copilot para sa mga developer.

Pagsisimula sa mga chatbot

Upang maunawaan-kahit sa mataas na antas kung paano gumagana ang mga chatbot, kailangan mo munang maunawaan ang mga pangunahing kaalaman sa AI, at partikular na ang Machine Learning (ML) at Large Language Models (LLMs).

Ang Machine Learning ay isang sangay ng computer science na nakatuon sa pagsasaliksik at pagpapaunlad ng pagtatangkang magturo ng mga computer upang matuto.

Ang LLM ay isang natural na programa sa pagpoproseso ng wika (NLP) na gumagamit ng malalaking hanay ng data at mga neural network (NN) upang makabuo ng text. Gumagana ang mga LLM sa pamamagitan ng pagsasanay sa AI code sa malalaking modelo ng data, na pagkatapos ay”natututo”mula sa mga ito sa paglipas ng panahon-mahalagang maging eksperto sa domain sa isang partikular na larangan batay sa katumpakan ng data ng input.

Kung mas (at mas tumpak) ang data ng pag-input, magiging mas tumpak at tama ang isang chatbot na gumagamit ng modelo. Umaasa din ang mga LLM sa Deep Learning habang sinasanay sa mga modelo ng data.

Kapag nagtanong ka sa isang chatbot, kine-query nito ang LLM nito para sa pinakaangkop na sagot-batay sa pagkatuto nito at nakaimbak na kaalaman sa lahat ng paksang nauugnay sa iyong tanong.

Sa totoo lang, ang mga chatbot ay may paunang nakalkula na kaalaman sa isang paksa, at binigyan ng sapat na tumpak na LLM at sapat na oras ng pag-aaral, ay makakapagbigay ng mga tamang sagot nang mas mabilis kaysa sa magagawa ng karamihan sa mga tao.

Ang paggamit ng chatbot ay parang pagkakaroon ng isang automated na pangkat ng mga PhD sa iyong pagtatapon kaagad.

Noong Enero 2023, inilabas ng Meta AI ang sarili nitong LLM na tinatawag na LLaMA. Pagkalipas ng isang buwan, ipinakilala ng Google ang sarili nitong AI chatbot, Bard, na batay sa sarili nitong LLM, LaMDA. Ang iba pang mga chatbot ay nagsimula na.

Generative AI

Higit pang mga kamakailan, natutunan ng ilang LLM kung paano bumuo ng hindi nakabatay sa text na data gaya ng mga graphics, musika, at maging ang mga buong aklat. Interesado ang mga kumpanya sa Generative AI upang lumikha ng mga bagay tulad ng corporate graphics, logo, pamagat, at maging ang mga digital na eksena ng pelikula na pumapalit sa mga aktor.

Halimbawa, ang thumbnail na larawan para sa artikulong ito ay binuo ng AI.

Bilang side effect ng Generative AI, ang mga manggagawa ay nababahala tungkol sa pagkawala ng kanilang mga trabaho sa automation na hinimok ng AI software.

Chatbot assistants

Ang unang komersyal na user-available na chatbot sa mundo (BeBot) ay inilabas ng Bespoke Japan para sa Tokyo Station City noong 2019.

Inilabas bilang isang iOS at Android app, alam ng BeBot kung paano ka idirekta sa anumang punto sa paligid ng parang labirint na istasyon, tulungan kang mag-imbak at kunin ang iyong bagahe, ipadala ka sa isang info desk, o maghanap ng mga oras ng tren, transportasyon sa lupa, o pagkain at mga tindahan sa loob ng istasyon.

Maaari pa nitong sabihin sa iyo kung aling mga platform ng tren ang pupuntahan para sa pinakamabilis na biyahe sa tren papunta sa anumang destinasyon sa lungsod ayon sa tagal ng biyahe-lahat sa loob ng ilang segundo.

Ang MLC chat app

Ang proyektong Machine Learning Compilation (MLC) ay ang brainchild ng Apache Foundation Deep Learning researcher Siyuan Feng, at Hongyi Jin pati na rin ang iba pang nakabase sa Seattle at sa Shanghai, China.

Ang ideya sa likod ng MLC ay ang pag-deploy ng mga precompiled na LLM at chatbots sa mga consumer device at web browser. Ginagamit ng MLC ang kapangyarihan ng mga consumer graphics processing unit (GPU) para mapabilis ang mga resulta at paghahanap ng AI-na ginagawang maabot ng karamihan sa mga modernong consumer computing device ang AI.

Ang isa pang proyekto ng MLC-Web LLM-ay nagdadala ng parehong functionality sa mga web browser at nakabatay sa turn on isa pang proyekto-WebGPU. Ang mga machine lang na may mga partikular na GPU ang sinusuportahan sa Web LLM dahil umaasa ito sa mga framework ng code na sumusuporta sa mga GPU na iyon.

Karamihan sa mga AI assistant ay umaasa sa isang client-server model na ang mga server ay gumagawa ng karamihan sa AI heavy lifting, ngunit ang MLC ay nagluluto ng mga LLM sa lokal na code na direktang tumatakbo sa device ng user, na inaalis ang pangangailangan para sa mga LLM server.

Pagse-set up ng MLC

Upang patakbuhin ang MLC sa iyong device, dapat nitong matugunan ang mga minimum na kinakailangan na nakalista sa proyekto at mga pahina ng GitHub.

Upang patakbuhin ito sa isang iPhone, kakailanganin mo ng iPhone 14 Pro Max, iPhone 14 Pro, o iPhone 12 Pro na may hindi bababa sa 6GB ng libreng RAM. Kakailanganin mo ring i-install ang TestFlight app ng Apple upang mai-install ang app, ngunit limitado ang pag-install sa unang 9,000 user.

Sinubukan naming patakbuhin ang MLC sa isang base 2021 iPad na may 64GB na storage, ngunit hindi ito magsisimula. Maaaring mag-iba ang iyong mga resulta sa iPad Pro.

Maaari ka ring bumuo ng MLC mula sa mga pinagmulan at direktang patakbuhin ito sa iyong telepono sa pamamagitan ng pagsunod sa mga direksyon sa MLC-LLM GitHub page. Kakailanganin mo ang git source-code control system na naka-install sa iyong Mac upang makuha ang mga source.

Upang gawin ito, gumawa ng bagong folder sa Finder sa iyong Mac, gamitin ang UNIX cd command upang mag-navigate dito sa Terminal, pagkatapos ay paganahin ang git clone command sa Terminal gaya ng nakalista sa MLC-LLM GitHub pahina:

https://github.com/mlc-ai/mlc-llm.git at pindutin ang Bumalik. Ida-download ng git ang lahat ng mga mapagkukunan ng MLC sa folder na iyong nilikha.

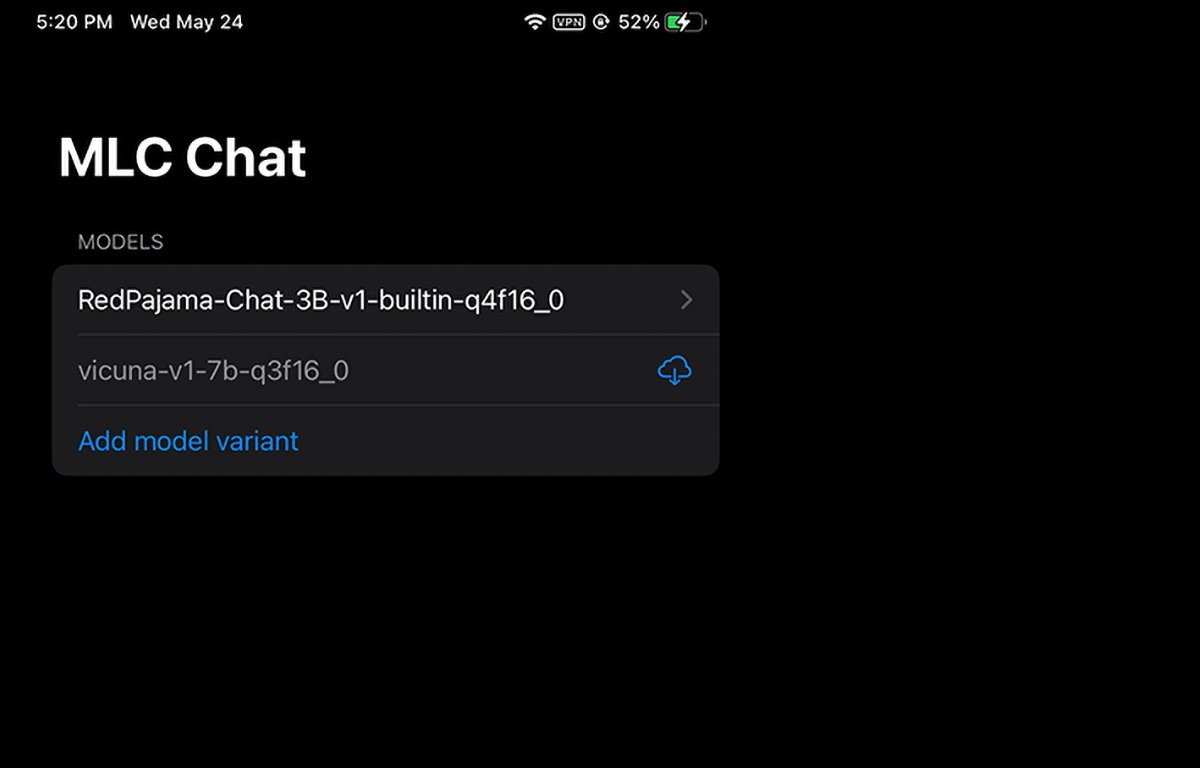

MLC na tumatakbo sa iPhone. Maaari mong piliin o i-download kung aling timbang ng modelo ang gagamitin.

Pag-install ng mga kinakailangan sa Mac

Para sa mga Mac at Linux na computer, ang MLC ay pinapatakbo mula sa isang command-line interface sa Terminal. Kakailanganin mo munang mag-install ng ilang paunang kinakailangan para magamit ito:

Ang Conda o Miniconda Package Manager Homebrew Vulkan graphics library (Linux o Windows lang) git large file support (LFS)

Para sa mga user ng NVIDIA GPU, ang mga tagubilin sa MLC ay partikular na nagsasaad na dapat mong manual na i-install ang Vulkan na driver bilang default na driver. Ang isa pang library ng graphics para sa mga NVIDIA GPU-CUDA-ay hindi gagana.

Para sa mga user ng Mac, maaari mong i-install ang Miniconda sa pamamagitan ng paggamit ng Homebrew package manager, na aming tinakpan na dati. Tandaan na sumasalungat ang Miniconda sa isa pang formula ng Homebrew Conda, miniforge.

Kaya kung na-install mo na ang miniforge sa pamamagitan ng Homebrew, kakailanganin mo muna itong i-uninstall.

Sumusunod sa mga direksyon sa pahina ng MLC/LLM, ang natitirang mga hakbang sa pag-install ay humigit-kumulang:

Gumawa ng bagong kapaligiran ng Conda I-install ang git at git LFS I-install ang command-line chat app mula sa Conda Lumikha ng bagong lokal folder, mag-download ng mga timbang ng modelo ng LLM, at magtakda ng LOCAL_ID variable I-download ang mga library ng MLC mula sa GitHub

Lahat ng ito ay binanggit nang detalyado sa pahina ng mga tagubilin, kaya hindi na kami pupunta sa bawat aspeto ng pag-setup dito. Maaaring mukhang nakakatakot sa simula, ngunit kung mayroon kang mga pangunahing kasanayan sa macOS Terminal, ito ay talagang ilang diretsong hakbang.

Itinakda lang ng LOCAL_ID na hakbang ang variable na iyon upang tumuro sa isa sa tatlong timbang ng modelo na iyong na-download.

Ang mga timbang ng modelo ay dina-download mula sa website ng komunidad ng HuggingFace, na isang uri ng GitHub para sa AI.

Kapag na-install na ang lahat sa Terminal, maa-access mo ang MLC sa Terminal sa pamamagitan ng paggamit ng mlc_chat_cli

Paggamit ng MLC sa mga web browser

Mayroon ding bersyon ng web ang MLC, Web LLM.

Gumagana lang ang variant ng Web LLM sa mga Apple Silicon Mac. Hindi ito tatakbo sa mga Intel Mac at gagawa ng error sa window ng chatbot kung susubukan mo.

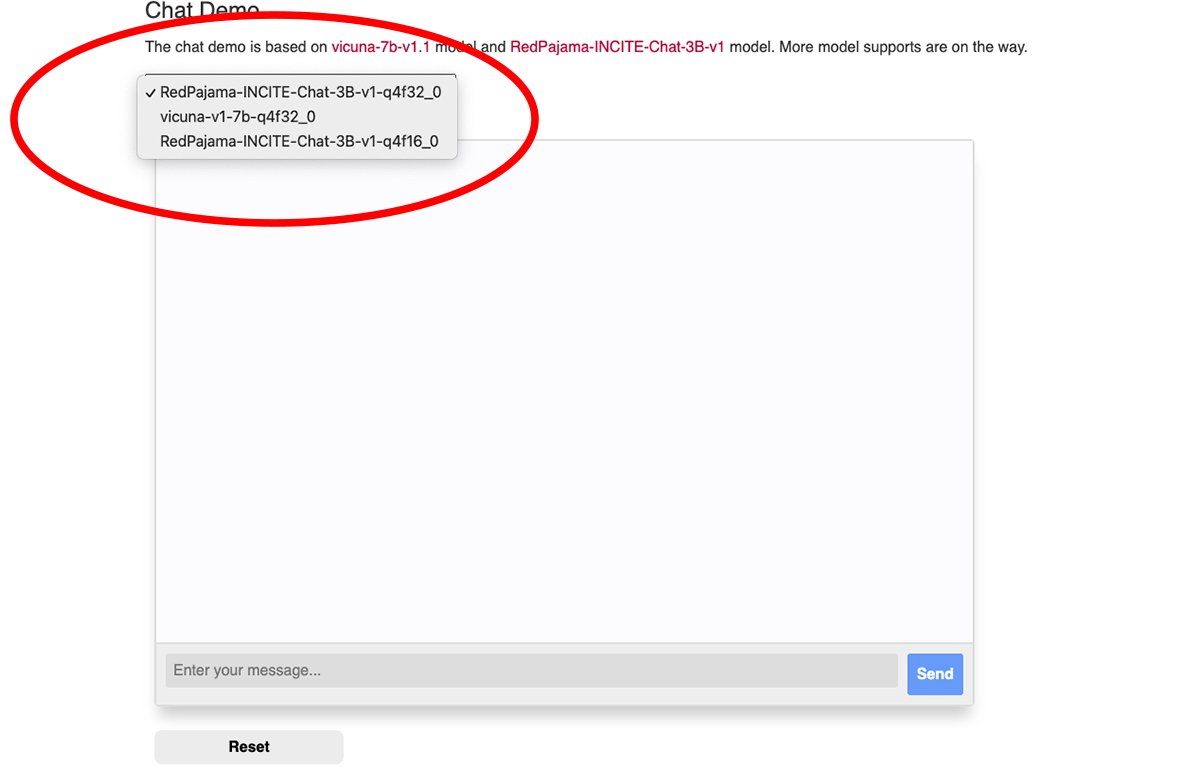

May popup menu sa tuktok ng MLC web chat window kung saan maaari mong piliin kung aling na-download na timbang ng modelo ang gusto mong gamitin:

Pumili ng isa sa mga timbang ng modelo.

Kakailanganin mo ang Google Chrome browser upang magamit ang Web LLM (Bersyon ng Chrome 113 o mas bago). Hindi gagana ang mga naunang bersyon.

Maaari mong tingnan ang numero ng bersyon ng iyong Chrome mula sa menu ng Chrome sa bersyon ng Mac sa pamamagitan ng pagpunta sa Chrome->Tungkol sa Google Chrome. Kung available ang isang update, i-click ang button na I-update upang mag-update sa pinakabagong bersyon.

Maaaring kailanganin mong i-restart ang Chrome pagkatapos mag-update.

Tandaan na inirerekomenda ng MLC Web LLM page na ilunsad mo ang Chrome mula sa Mac Terminal gamit ang command na ito:

/Applications/Google\ Chrome.app/Contents/MacOS/Google\ Chrome — enable-dawn-features=allow_unsafe_apis,disable_robustness

allow_unsafe_apis’at disable_robustness’ay dalawang flag ng paglulunsad ng Chrome na nagbibigay-daan dito na gumamit ng mga pang-eksperimentong feature, na maaaring hindi matatag o hindi.

Kapag na-set up na ang lahat, mag-type lang ng tanong sa field na Ipasok ang iyong mensahe sa ibaba ng chat pane ng Web LLM web page at i-click ang Ipadala na pindutan.

Nagsisimula pa lang ang panahon ng totoong AI at matatalinong katulong. Bagama’t may mga panganib sa AI, nangangako ang teknolohiyang ito na pagandahin ang ating kinabukasan sa pamamagitan ng pagtitipid ng maraming oras at pag-aalis ng maraming trabaho.