De acordo com um relatório recém-publicado pela iCulture, a Apple em breve expandirá sua Recurso iOS Communications Safety para mais seis países. O recurso será lançado na Holanda, Bélgica, Suécia, Japão, Coreia do Sul e Brasil.

O Communications Safety está atualmente disponível nos Estados Unidos, Reino Unido, Canadá, Nova Zelândia e Austrália. Esse recurso foi incluído nas atualizações do macOS 12.1, iOS 15.2 e iPadOS 15.2 e exige que as contas sejam configuradas como “famílias” no iCloud.

É um recurso opcional com foco na privacidade que deve ser ativado para as contas das crianças no plano de Compartilhamento Familiar dos pais. Toda a detecção de imagens é feita diretamente no dispositivo, sem que nenhum dado seja enviado do iPhone.

O recurso foi lançado inicialmente como parte do iOS 15.2 nos Estados Unidos e agora é um recurso do iMessage. O recurso examina as mensagens de entrada e saída de um usuário em busca de nudez em dispositivos usados por crianças.

Como Funciona?

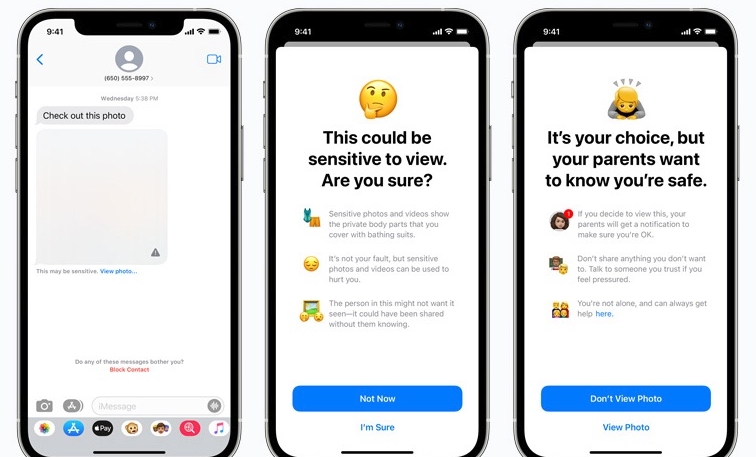

Ao receber conteúdo com nudez, a foto é automaticamente desfocada e um aviso será apresentado à criança, que inclui recursos úteis e garante que não há problema em não ver a foto. A criança também pode ser avisada de que, para garantir sua segurança, os pais receberão uma mensagem se optarem por visualizá-la.

Avisos semelhantes estarão disponíveis se usuários menores de idade tentarem enviar fotos sexualmente explícitas. O menor será avisado antes do envio da foto, e os pais também receberão uma mensagem caso a criança opte por enviar a imagem.

Em ambos os casos, a criança terá a opção de enviar uma mensagem a alguém de sua confiança para pedir ajuda, se assim o desejar.

O sistema analisará os anexos de imagem e determinará se uma foto contém ou não nudez. A criptografia de ponta a ponta das mensagens é mantida durante o processo. Nenhuma indicação da detecção deixa o dispositivo. A Apple não vê as mensagens e nenhuma notificação é enviada aos pais ou a qualquer outra pessoa se a imagem não for aberta ou enviada.

Acréscimos e reação da Apple a preocupações anteriores

A Apple também forneceu recursos adicionais em Siri, Spotlight e Safari Search para ajudar crianças e pais a permanecerem seguros online e para ajudar em situações inseguras. Por exemplo, os usuários que perguntam à Siri como podem denunciar a exploração infantil serão informados sobre como e onde podem registrar uma denúncia.

Siri, Spotlight e Safari Search também foram atualizados para lidar com quando um usuário realiza uma consulta relacionada à exploração infantil. Os usuários serão informados de que o interesse nesses tópicos é problemático e fornecerão recursos para obter ajuda para esse problema.

Em dezembro, a Apple abandonou discretamente seus planos de detectar material de abuso sexual infantil (CSAM) nas fotos do iCloud, após críticas de grupos políticos, pesquisadores de segurança e políticos sobre preocupações com a possibilidade de falsos positivos, bem como como possíveis “portas dos fundos” que permitiriam aos governos ou à aplicação da lei monitorar a atividade dos usuários, verificando também outros tipos de imagens. Os críticos também afirmaram que o recurso era menos eficaz na identificação de imagens reais de abuso sexual infantil.

A Apple disse que a decisão de abandonar o recurso foi “baseada no feedback de clientes, grupos de defesa, pesquisadores e outros… recursos de segurança infantil extremamente importantes”.