Logo após a Samsung anunciar novos recursos de acessibilidade para o Galaxy Buds 2 Pro, a Apple anunciou alguns recursos de acessibilidade para iPhones. Pouco antes do Dia Global de Conscientização sobre Acessibilidade (18 de maio de 2023), a Apple anunciou recursos para melhorar a acessibilidade em iPhones, e parece que esses recursos foram inspirados nos recursos da Samsung.

O Assistive Access da Apple é semelhante ao Easy Mode da Samsung, enquanto o Live Speech é semelhante ao Bixby Text Call

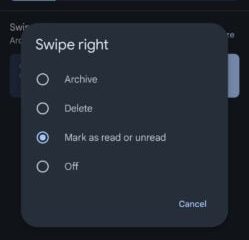

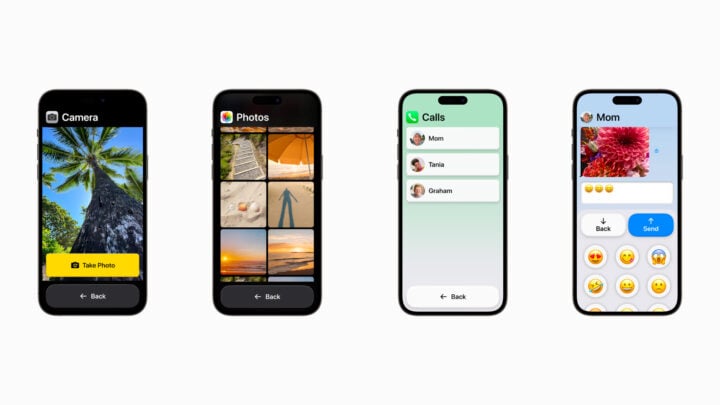

Apple revelado Acesso assistido, fala ao vivo e voz pessoal. O Acesso Assistivo é para pessoas com deficiências cognitivas e oferece elementos e layouts de interface do usuário maiores para que as pessoas possam acessar os recursos essenciais com facilidade. Esse recurso é semelhante ao Modo Fácil da Samsung, que simplifica a interface do usuário para um acesso mais fácil que ajuda os idosos ou pessoas com deficiências cognitivas. O recurso da Apple funcionará em iPhones e iPads com aplicativos essenciais como Chamadas, Câmera, Mensagens, Música e Fotos, oferecendo alvos de toque e elementos de interface do usuário maiores. Esse recurso será lançado ainda este ano como parte da atualização do iOS 17.

Com o Live Speech, os usuários podem digitar o que têm a dizer durante uma chamada de voz. Um iPhone, iPad ou Mac converterá esse texto em fala e o retransmitirá para o outro lado da chamada. Os usuários também podem salvar frases rápidas para usar durante as chamadas. Esse recurso é semelhante ao recurso Bixby Text Call da Samsung, que transcreve vozes em texto e vice-versa durante as chamadas.

O recurso Personal Voice da Apple é semelhante ao Bixby Custom Voice Creator da Samsung

O recurso de acessibilidade Personal Voice da Apple foi projetado para usuários que correm o risco de perder a voz. Eles podem criar uma voz que soe como eles lendo um conjunto aleatório de prompts de texto para gravar 15 minutos de áudio em um iPhone ou iPad. Esse recurso parece inspirado no Bixby Custom Voice Creator, que Samsung lançou no início deste ano.

Além de todos esses recursos, a Apple também anunciou o Modo de Detecção na Lupa que os usuários do iPhone com baixa visão podem usar para ler o texto dos objetos. Os usuários podem simplesmente apontar a câmera do iPhone para um objeto ou texto que estão olhando, e o Modo de Detecção lerá esse texto e o dirá em voz alta. Isso é semelhante a Bixby Vision da Samsung Recursos de detector de cores, identificador de objeto, descritor de cena e leitor de texto.

Outros novos recursos incluem a certificação’Made for iPhone Hearing Devices’para aparelhos auditivos, melhorias no controle de voz, mais opções de tamanho de texto em aplicativos essenciais para Mac, imagens de pausa com elementos em movimento (para aqueles sensíveis a animações rápidas), e vozes mais naturais para Voice Over.