A IA está conquistando o mundo e, embora você possa usar o Google Bard ou o ChatGPT, também pode usar um hospedado localmente no seu Mac. Veja como usar o novo aplicativo de bate-papo MLC LLM.

Inteligência Artificial (IA) é a nova fronteira de ponta da ciência da computação e está gerando bastante publicidade no mundo da computação.

Chatbots-aplicativos baseados em IA com os quais os usuários podem conversar como especialistas de domínio-estão crescendo em popularidade, para dizer o mínimo.

Os chatbots têm conhecimento aparentemente especializado em uma ampla variedade de assuntos genéricos e especializados e estão sendo implantados em todos os lugares em um ritmo rápido. Um grupo-OpenAI-lançou ChatGPT alguns meses atrás para um mundo chocado.

O ChatGPT tem conhecimento aparentemente ilimitado sobre praticamente qualquer assunto e pode responder a perguntas em tempo real que, de outra forma, levariam horas ou dias de pesquisa. Tanto as empresas quanto os trabalhadores perceberam que a IA pode ser usada para acelerar o trabalho, reduzindo o tempo de pesquisa.

A desvantagem

Dado tudo isso, no entanto, há uma desvantagem em alguns aplicativos de IA. A principal desvantagem da IA é que os resultados ainda devem ser verificados.

Embora geralmente correta, a IA pode fornecer dados errôneos ou enganosos que podem levar a conclusões ou resultados falsos.

Desenvolvedores de software e empresas de software adotaram”copilotos“-chatbots especializados que podem ajudar os desenvolvedores a escrever códigos fazer com que a IA escreva o esboço de funções ou métodos automaticamente-o que pode ser verificado por um desenvolvedor.

Embora seja uma grande economia de tempo, os copilotos também podem escrever códigos incorretos. Microsoft, Amazon, GitHub e NVIDIA lançaram copilotos para desenvolvedores.

Introdução aos chatbots

Para entender-pelo menos em alto nível como os chatbots funcionam, você deve primeiro entender os fundamentos da IA e, em particular, o aprendizado de máquina (ML) e modelos de linguagem grandes (LLMs).

Machine Learning é um ramo da ciência da computação dedicado à pesquisa e desenvolvimento de tentativas de ensinar computadores a aprender.

Um LLM é essencialmente um programa de processamento de linguagem natural (NLP) que usa grandes conjuntos de dados e redes neurais (NNs) para gerar texto. Os LLMs trabalham treinando o código de IA em grandes modelos de dados, que então”aprendem”com eles ao longo do tempo-tornando-se essencialmente um especialista em um campo específico com base na precisão dos dados de entrada.

Quanto mais (e mais precisos) os dados de entrada, mais preciso e correto será um chatbot que usa o modelo. Os LLMs também contam com Deep Learning enquanto são treinados em modelos de dados.

Quando você faz uma pergunta a um chatbot, ele consulta seu LLM para obter a resposta mais adequada-com base em seu aprendizado e conhecimento armazenado de todos os assuntos relacionados à sua pergunta.

Essencialmente, os chatbots têm conhecimento pré-computado de um tópico e, com um LLM preciso o suficiente e tempo de aprendizado suficiente, podem fornecer respostas corretas muito mais rapidamente do que a maioria das pessoas.

Usar um chatbot é como ter uma equipe automatizada de PhDs à sua disposição instantaneamente.

Em janeiro de 2023, a Meta AI lançou seu próprio LLM chamado LLaMA. Um mês depois, o Google lançou seu próprio chatbot AI, Bard, baseado em seu próprio LLM, LaMDA. Outros chatbots surgiram desde então.

IA generativa

Mais recentemente, alguns LLMs aprenderam a gerar dados não baseados em texto, como gráficos, música e até mesmo livros inteiros. As empresas estão interessadas na IA generativa para criar coisas como gráficos corporativos, logotipos, títulos e até mesmo cenas de filmes digitais que substituem os atores.

Por exemplo, a imagem em miniatura deste artigo foi gerada por AI.

Como efeito colateral da IA generativa, os trabalhadores ficaram preocupados em perder seus empregos para a automação impulsionada pelo software de IA.

Assistentes de chatbot

O primeiro chatbot comercial do mundo disponível para o usuário (BeBot) foi lançado pela Bespoke Japan para Tokyo Station City em 2019.

Lançado como um aplicativo iOS e Android, o BeBot sabe como direcioná-lo para qualquer ponto ao redor da estação labiríntica, ajudá-lo a guardar e recuperar sua bagagem, encaminhá-lo para um balcão de informações ou encontrar horários de trem, transporte terrestre ou comida e lojas dentro da estação.

Ele pode até dizer a você quais plataformas de trem seguir para a viagem de trem mais rápida para qualquer destino na cidade por duração da viagem-tudo em alguns segundos.

O aplicativo de bate-papo MLC

O projeto Machine Learning Compilation (MLC) é uma criação do pesquisador da Apache Foundation Deep Learning Siyuan Feng e Hongyi Jin, bem como outros com sede em Seattle e em Xangai, na China.

A ideia por trás do MLC é implantar LLMs e chatbots pré-compilados em dispositivos de consumo e navegadores da web. O MLC aproveita o poder das unidades de processamento gráfico (GPUs) do consumidor para acelerar os resultados e pesquisas de IA-tornando a IA ao alcance da maioria dos dispositivos de computação de consumo modernos.

Outro projeto MLC-Web LLM-traz a mesma funcionalidade para navegadores da web e é baseado em outro projeto-WebGPU. Apenas máquinas com GPUs específicas são suportadas no Web LLM, pois ele depende de estruturas de código que suportam essas GPUs.

A maioria dos assistentes de IA depende de um modelo cliente-servidor com servidores fazendo a maior parte do trabalho pesado de IA, mas o MLC transforma os LLMs em código local que é executado diretamente no dispositivo do usuário, eliminando a necessidade de servidores LLM.

Configuração do MLC

Para executar o MLC em seu dispositivo, ele deve atender aos requisitos mínimos listados no projeto e nas páginas do GitHub.

Para executá-lo em um iPhone, você precisará de um iPhone 14 Pro Max, iPhone 14 Pro ou iPhone 12 Pro com pelo menos 6 GB de RAM livre. Você também precisará instalar o aplicativo TestFlight da Apple para instalar o aplicativo, mas a instalação é limitada aos primeiros 9.000 usuários.

Tentamos executar o MLC em um iPad 2021 básico com 64 GB de armazenamento, mas ele não inicializou. Seus resultados podem variar no iPad Pro.

Você também pode criar MLC a partir de fontes e executá-lo diretamente em seu telefone seguindo as instruções na página MLC-LLM GitHub. Você precisará do sistema de controle de código-fonte git instalado em seu Mac para recuperar as fontes.

Para fazer isso, crie uma nova pasta no Finder no seu Mac, use o comando UNIX cd para navegar até ela no Terminal e, em seguida, dispare o comando git clone no Terminal conforme listado no MLC-LLM GitHub página:

https://github.com/mlc-ai/mlc-llm.git e pressione Return. git irá baixar todas as fontes MLC para a pasta que você criou.

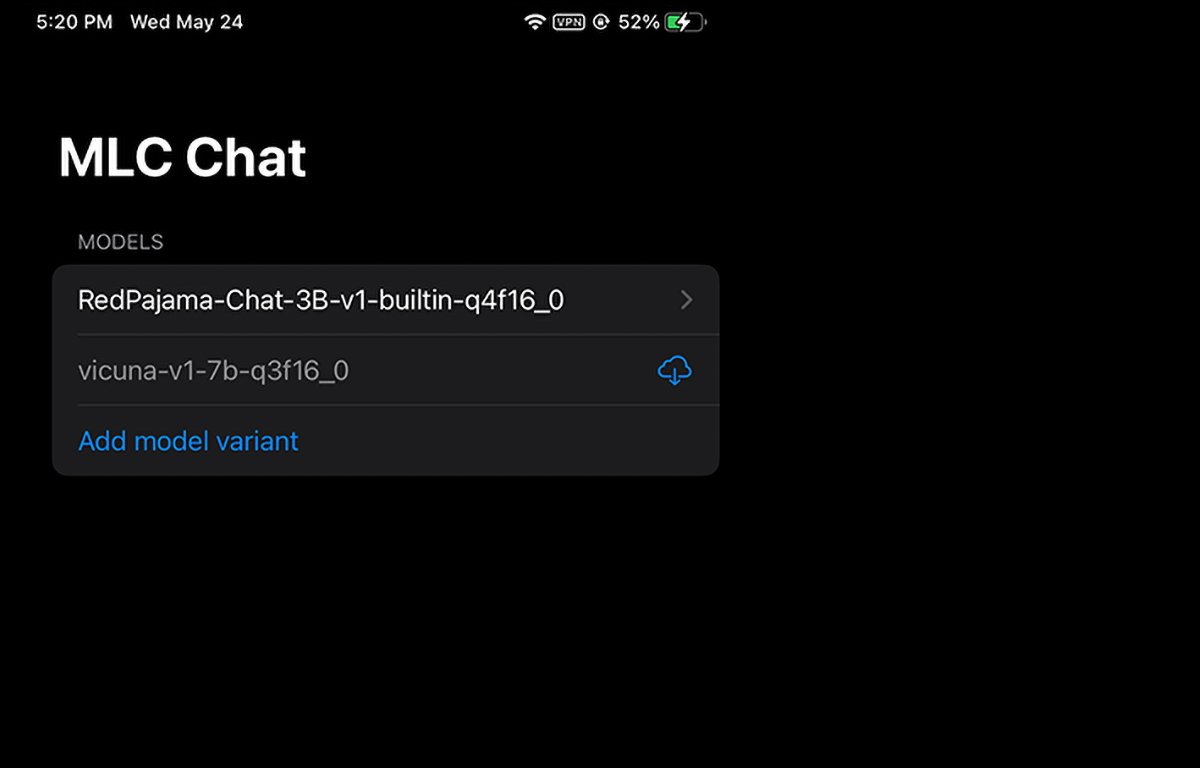

MLC rodando no iPhone. Você pode selecionar ou baixar qual peso de modelo usar.

Instalando os pré-requisitos do Mac

Para computadores Mac e Linux, o MLC é executado a partir de uma interface de linha de comando em Terminal. Você precisará instalar alguns pré-requisitos primeiro para usá-lo:

O Conda ou Biblioteca de gráficos Miniconda Package Manager Homebrew Vulkan (somente Linux ou Windows) git large file support (LFS)

Para usuários de GPU NVIDIA, as instruções do MLC declaram especificamente que você deve instalar manualmente o Vulkan driver como o driver padrão. Outra biblioteca gráfica para GPUs NVIDIA-CUDA-não funcionará.

Para usuários de Mac, você pode instalar Miniconda usando o gerenciador de pacotes Homebrew, que nós já cobri anteriormente. Observe que Miniconda entra em conflito com outra fórmula Homebrew Conda, miniforge.

Portanto, se você já tiver o miniforge instalado via Homebrew, precisará desinstalá-lo primeiro.

Seguindo as instruções na página MLC/LLM, as etapas de instalação restantes são aproximadamente:

Criar um novo ambiente Conda Instalar git e git LFS Instalar o aplicativo de bate-papo de linha de comando do Conda Criar um novo local pasta, baixe os pesos do modelo LLM e defina uma variável LOCAL_ID Baixe as bibliotecas MLC do GitHub

Tudo isso é mencionado em detalhes na página de instruções, portanto, não entraremos em todos os aspectos da configuração aqui. Pode parecer assustador inicialmente, mas se você tiver habilidades básicas do macOS Terminal, são apenas algumas etapas diretas.

A etapa LOCAL_ID apenas define essa variável para apontar para um dos três pesos de modelo que você baixou.

Os pesos do modelo são baixados do site da comunidade HuggingFace, que é uma espécie de GitHub para IA.

Depois que tudo estiver instalado no Terminal, você pode acessar o MLC no Terminal usando o mlc_chat_cli

Usando o MLC em navegadores da web

MLC também tem uma versão web, Web LLM.

A variante Web LLM funciona apenas em Apple Silicon Macs. Ele não funcionará em Macs Intel e produzirá um erro na janela do chatbot se você tentar.

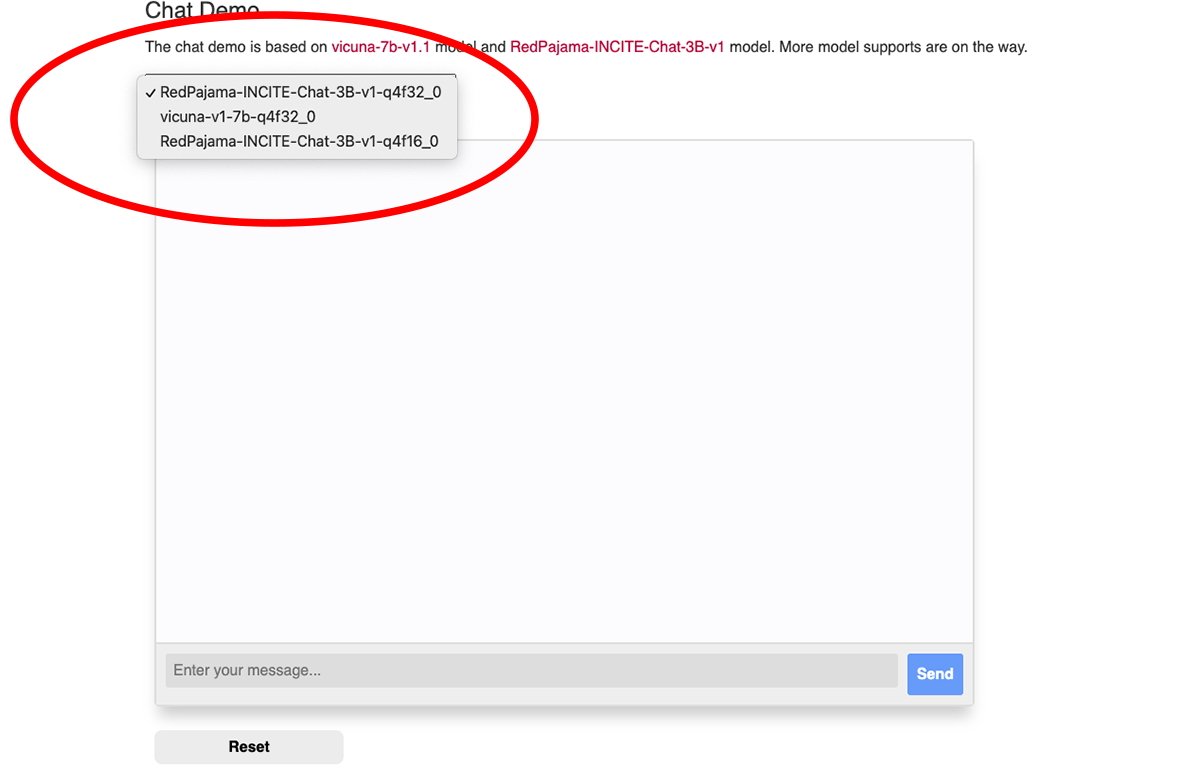

Existe um menu pop-up na parte superior da janela de bate-papo da Web do MLC, no qual você pode selecionar o peso do modelo baixado que deseja usar:

Selecione um dos pesos do modelo.

Você precisará do navegador Google Chrome para usar o Web LLM (Chrome versão 113 ou posterior). Versões anteriores não funcionarão.

Você pode verificar o número da versão do Chrome no menu do Chrome na versão para Mac acessando Chrome->Sobre o Google Chrome. Se uma atualização estiver disponível, clique no botão Atualizar para atualizar para a versão mais recente.

Talvez seja necessário reiniciar o Chrome após a atualização.

Observe que a página MLC Web LLM recomenda que você inicie o Chrome a partir do Mac Terminal usando este comando:

/Applications/Google\ Chrome.app/Contents/MacOS/Google\ Chrome — enable-dawn-features=allow_unsafe_apis,disable_robustness

allow_unsafe_apis’e disable_robustness’são dois sinalizadores de inicialização do Chrome que permitem o uso de recursos experimentais, que podem ou não ser instáveis.

Depois que tudo estiver configurado, basta digitar uma pergunta no campo Digite sua mensagem na parte inferior do painel de bate-papo da página Web LLM e clique no botão Enviar.

A era da verdadeira IA e assistentes inteligentes está apenas começando. Embora existam riscos com a IA, essa tecnologia promete melhorar nosso futuro, economizando muito tempo e eliminando muito trabalho.