AI 正在風靡全球,您可以使用 Google Bard 或 ChatGPT,也可以在 Mac 上使用本地託管的。以下是如何使用新的 MLC LLM 聊天應用程序。

人工智能 (AI) 是計算機科學的新前沿,正在計算世界中引起相當大的炒作。

聊天機器人——用戶可以作為領域專家與之交談的基於人工智能的應用程序——至少可以說越來越受歡迎。

聊天機器人似乎擁有廣泛的通用和專業主題的專業知識,並且正在快速部署到各地。一個小組-OpenAI-發布了一些 ChatGPT幾個月前,一個震驚的世界。

ChatGPT 似乎對幾乎任何主題都有無限的知識,並且可以實時回答問題,否則需要數小時或數天的研究。公司和工人都意識到人工智能可以通過減少研究時間來加快工作速度。

缺點

儘管如此,一些 AI 應用程序也有缺點。 AI 的主要缺點是結果仍需驗證。

雖然通常大部分是正確的,但 AI 可以提供錯誤或欺騙性的數據,從而導致錯誤的結論或結果。

軟件開發人員和軟件公司已經採用“copilots”——專門的聊天機器人,可以幫助開發人員編寫代碼讓人工智能自動編寫函數或方法的大綱——然後由開發人員驗證。

雖然可以節省大量時間,但副駕駛也可能會編寫不正確的代碼。微軟、亞馬遜、GitHub 和 NVIDIA 都為開發者發布了 copilots。

開始使用聊天機器人

要了解-至少在較高層次上聊天機器人是如何工作的,您必須首先了解 AI 基礎知識,尤其是機器學習(ML) 和大型語言模型 (LLM)。

機器學習是計算機科學的一個分支,致力於研究和開發嘗試教計算機學習。

LLM 本質上是一種自然語言處理 (NLP) 程序,它使用大量數據和神經網絡 (NN) 來生成文本。 LLM 通過在大數據模型上訓練 AI 代碼來工作,然後隨著時間的推移從中“學習”——本質上是根據輸入數據的準確性成為特定領域的領域專家。

輸入數據越多(也越準確),使用該模型的聊天機器人就會越準確和正確。法學碩士在接受數據模型訓練時也依賴於深度學習。

當您向聊天機器人提問時,它會根據與您的問題相關的所有主題的學習和存儲知識,向其 LLM 查詢最合適的答案。

本質上,聊天機器人已經預先計算了某個主題的知識,並提供了足夠準確的 LLM 和足夠的學習時間,可以比大多數人更快地提供正確答案。

使用聊天機器人就像擁有一個自動化的博士團隊,隨時供您使用。

2023 年 1 月,Meta AI 發布了自己的 LLM,名為 LLaMA。一個月後,谷歌推出了自己的人工智能聊天機器人 Bard,它基於自己的法學碩士 LaMDA。隨後出現了其他聊天機器人。

生成式 AI

最近,一些 LLM 學習瞭如何生成非文本數據,例如圖形、音樂,甚至整本書。公司對生成式 AI 感興趣,可以創建公司圖形、徽標、標題,甚至是代替演員的數字電影場景。

比如這篇文章的縮略圖就是AI生成的。

作為生成式 AI 的副作用,工人開始擔心他們的工作會因 AI 軟件驅動的自動化而失去。

聊天機器人助手

世界上第一個商業用戶可用的聊天機器人 (BeBot) 由 Bespoke Japan 於 2019 年為東京車站城發布。

作為 iOS 和 Android 應用程序發布,BeBot 知道如何將您引導到迷宮般的車站周圍的任何地點,幫助您存放和取回行李,將您送到問訊處,或查找火車時間、地面交通或車站內的食品和商店。

它甚至可以在幾秒鐘內告訴您前往哪個火車站台,以便以最快的速度搭乘火車到達城市中的任何目的地(按行程持續時間)。

MLC 聊天應用

機器學習編譯 (MLC) 項目是 Apache 基金會深度學習研究員的心血結晶Siyuan Feng、Hongyi Jin 以及其他常駐西雅圖和中國上海的人。

MLC 背後的想法是將預編譯的 LLM 和聊天機器人部署到消費者設備和網絡瀏覽器。 MLC 利用消費類圖形處理單元 (GPU) 的強大功能來加速 AI 結果和搜索——使 AI 觸手可及大多數現代消費類計算設備。

另一個 MLC 項目-Web LLM-為網絡瀏覽器帶來相同的功能,並且基於 turn on另一個項目——WebGPU。 Web LLM 僅支持具有特定 GPU 的機器,因為它依賴於支持這些 GPU 的代碼框架。

大多數 AI 助手都依賴客戶端-服務器模型,其中服務器承擔大部分 AI 繁重工作,但 MLC 將 LLM 烘焙成直接在用戶設備上運行的本地代碼,從而消除了對 LLM 服務器的需求。

設置 MLC

要在您的設備上運行 MLC,它必須滿足項目和 GitHub 頁面上列出的最低要求。

要在 iPhone 上運行它,您需要配備至少 6GB 可用內存的 iPhone 14 Pro Max、iPhone 14 Pro 或 iPhone 12 Pro。您還需要安裝 Apple 的 TestFlight 應用程序才能安裝該應用程序,但安裝僅限於前 9,000 名用戶。

我們嘗試在具有 64GB 存儲空間的基本 2021 iPad 上運行 MLC,但它無法初始化。您在 iPad Pro 上的結果可能會有所不同。

您還可以按照 MLC-LLM GitHub 頁面上的說明從源代碼構建 MLC 並直接在手機上運行它。您需要在 Mac 上安裝 git 源代碼控制系統來檢索源代碼。

為此,請在 Mac 上的 Finder 中創建一個新文件夾,使用 UNIX cd 命令在終端中導航到它,然後在終端中啟動 git clone 命令,如 MLC-LLM GitHub 上所列頁面:

https://github.com/mlc-ai/mlc-llm.git 並按 Return。 git 會將所有 MLC 源下載到您創建的文件夾中。

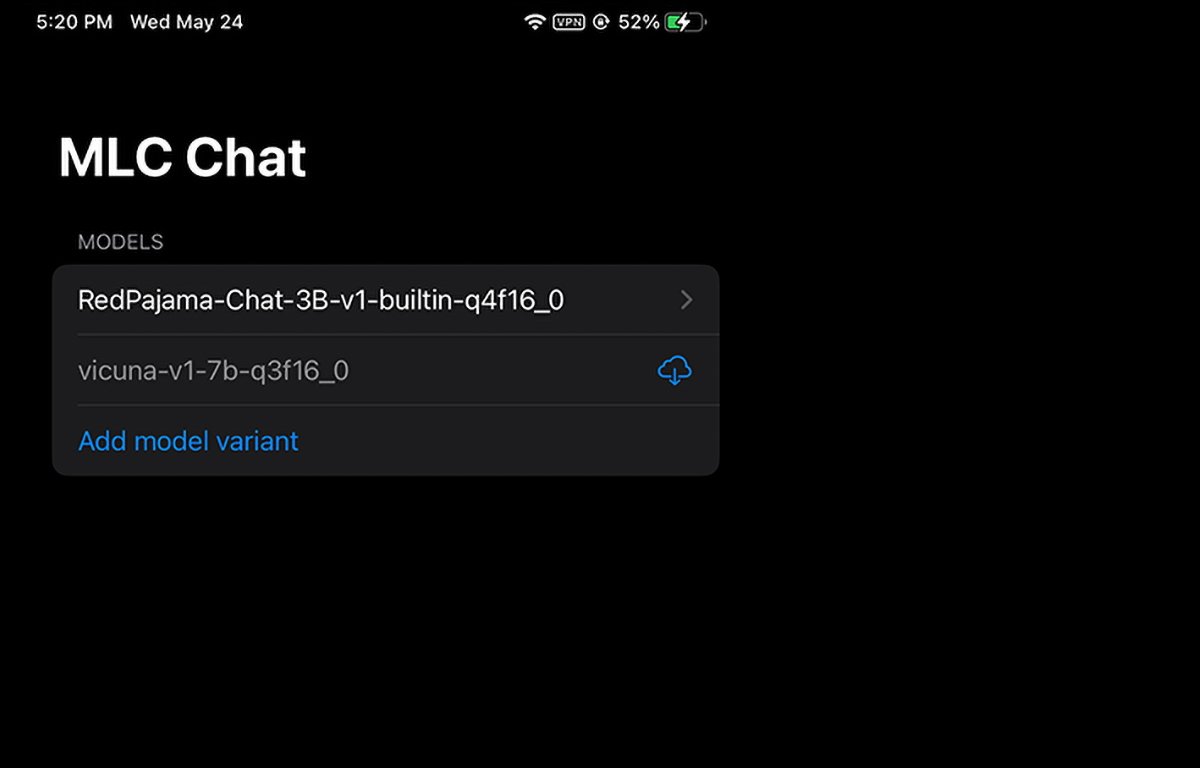

MLC 在 iPhone 上運行。您可以選擇或下載要使用的模型重量。

安裝 Mac 先決條件

對於 Mac 和 Linux 計算機,MLC 從命令行界面運行在終端。您需要先安裝一些先決條件才能使用它:

Conda 或Miniconda Package Manager Homebrew Vulkan 圖形庫(僅限 Linux 或 Windows) git 大文件支持 (LFS)

對於 NVIDIA GPU 用戶,MLC 說明明確指出您必須手動安裝 Vulkan 驅動程序作為默認驅動程序。 NVIDIA GPU 的另一個圖形庫-CUDA-將無法運行。

對於 Mac 用戶,您可以使用 Homebrew 包管理器安裝 Miniconda之前已經介紹過。請注意,Miniconda 與另一個 Homebrew Conda 公式 miniforge 衝突。

所以如果你已經通過 Homebrew 安裝了 miniforge,你需要先卸載它。

按照 MLC/LLM 頁面上的說明,剩下的安裝步驟大致是:

創建一個新的 Conda 環境安裝 git 和 git LFS 從 Conda 安裝命令行聊天應用程序創建一個新的本地文件夾,下載 LLM 模型權重,並設置 LOCAL_ID 變量 從 GitHub 下載 MLC 庫

所有這些都在說明頁面上詳細提到,因此我們不會在這裡詳細介紹設置的各個方面。最初看起來可能令人望而生畏,但如果您具備基本的 macOS 終端技能,那麼這實際上只是幾個簡單的步驟。

LOCAL_ID 步驟只是將該變量設置為指向您下載的三個模型權重之一。

模型權重是從 HuggingFace 社區網站下載的,該網站有點像 AI 的 GitHub。

在終端中安裝所有內容後,您可以使用 mlc_chat_cli 在終端中訪問 MLC

在網絡瀏覽器中使用 MLC

MLC 還有一個網絡版本,Web LLM。

Web LLM 變體只能在 Apple Silicon Mac 上運行。它不會在 Intel Mac 上運行,如果您嘗試,它會在聊天機器人窗口中產生錯誤。

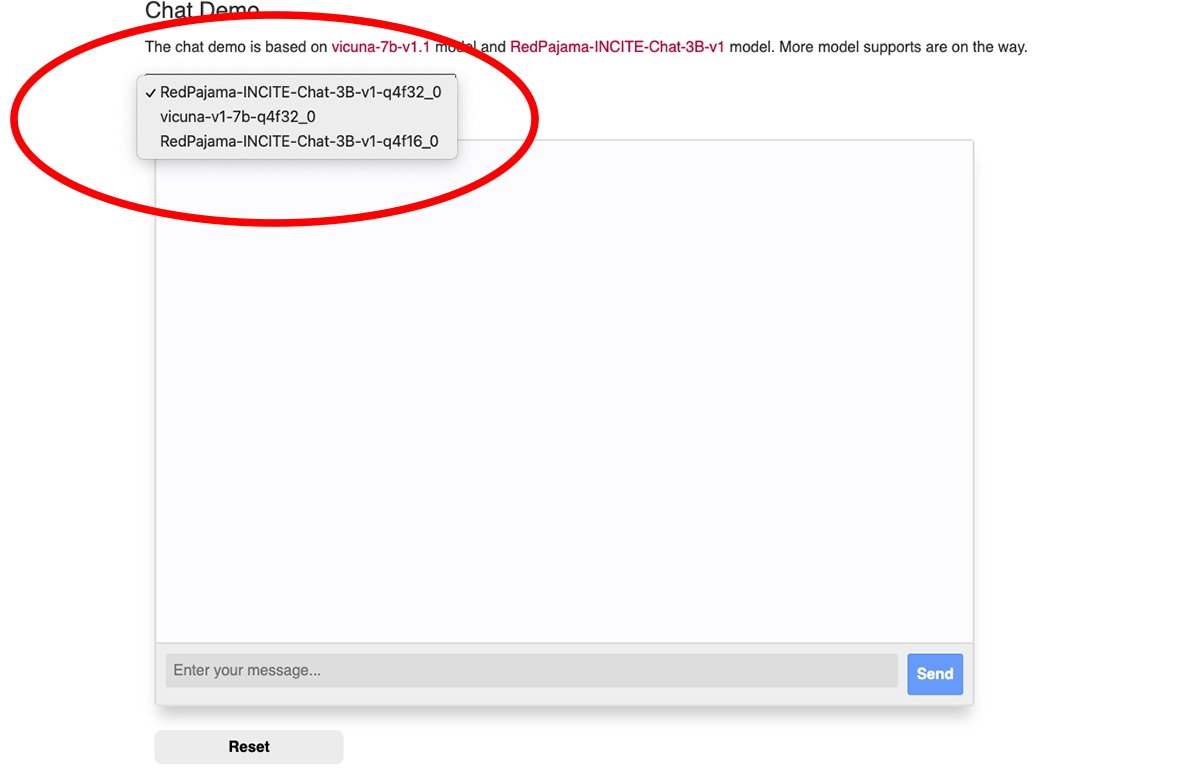

MLC 網絡聊天窗口頂部有一個彈出菜單,您可以從中選擇要使用的下載模型權重:

選擇一個模型權重。

您需要使用 Google Chrome 瀏覽器才能使用 Web LLM (Chrome 版本 113 或更高版本)。早期版本將無法使用。

您可以從 Mac 版本的 Chrome 菜單中轉到 Chrome->關於 Google Chrome 查看您的 Chrome 版本號。如果有可用更新,請單擊更新 按鈕以更新到最新版本。

您可能需要在更新後重新啟動 Chrome。

請注意,MLC Web LLM 頁面建議您使用以下命令從 Mac 終端啟動 Chrome:

/Applications/Google\ Chrome.app/Contents/MacOS/Google\ Chrome — enable-dawn-features=allow_unsafe_apis,disable_robustness

allow_unsafe_apis’和 disable_robustness’是兩個 Chrome 啟動標誌,允許它使用實驗性功能,這些功能可能不穩定也可能不穩定。

一切設置完畢後,只需在 Web LLM 網頁聊天窗格底部的輸入您的消息字段中輸入問題,然後點擊發送按鈕。

真正的人工智能和智能助手的時代才剛剛開始。雖然人工智能存在風險,但這項技術有望通過節省大量時間和減少大量工作來改善我們的未來。