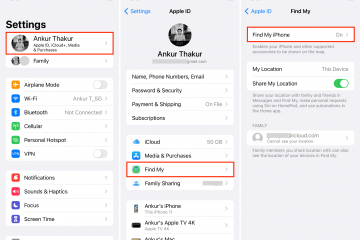

Apple hoy Presentó una vista previa de algunas nuevas funciones de accesibilidad que aparecerán en iOS 17. El acceso asistido filtra ciertas aplicaciones a sus”funciones más esenciales”para ayudar a las personas con discapacidades cognitivas. Con Assistive Access, las experiencias personalizadas de Teléfono, FaceTime, Mensajes, Cámara, Fotos y Música se combinan en una sola aplicación de Llamadas. Se utilizan botones de alto contraste y etiquetas de texto grandes. Para los usuarios de iPhone que prefieren comunicarse visualmente, la aplicación Mensajes incluye un QWERTY solo para emoji y la capacidad de grabar un mensaje de video para enviar a sus seres queridos. Además, con Assistive Access, los usuarios pueden seleccionar entre un diseño de pantalla de inicio basado en cuadrícula que es más visual y un diseño basado en filas para aquellos a quienes les resulta más fácil procesar el texto.

Assistive Access hace que el iPhone sea más fácil de usar para aquellos con problemas cognitivos

Con Live Speech, que estará disponible en iPhone, iPad y Mac, durante las llamadas telefónicas y FaceTime, un usuario puede escribir lo que quiere decir y hacer que su dispositivo lo diga en voz alta para que las otras partes puedan escucharlo en la llamada de voz o videollamada. Las frases que el usuario repite a menudo se pueden guardar e insertar rápidamente en conversaciones con amigos, familiares y compañeros de trabajo. Apple señala que Live Speech está”diseñado para ayudar a millones de personas en todo el mundo que no pueden hablar o que han perdido el habla con el tiempo”.

Live Speech permite que las personas con discapacidades para hablar escriban lo que quieran para decir en una llamada de voz o FaceTime y el teléfono lo anunciará

Para aquellos en peligro de perder la voz (como señala Apple, podría ser una persona a la que se le haya diagnosticado recientemente ELA (esclerosis lateral amiotrófica ) o tiene una enfermedad que le dificulta progresivamente hablar, una función llamada Voz personal hará que lean un conjunto de texto aleatorio durante aproximadamente 15 minutos en un iPhone o iPad. Esta función se integra con el Live Speech antes mencionado para que un iPhone o El usuario de iPad que ha perdido la voz aún puede hablar con otras personas utilizando una versión grabada de su voz.

Personal Voice permite que un usuario de iPhone grabe textos y frases en el dispositivo para usar con la función Live Speech antes mencionada.

Otra función de accesibilidad llamada”Apuntar y hablar en la lupa”ayuda a las personas con discapacidades visuales a leer las etiquetas de texto en los botones que se usan para ejecutar los artículos del hogar. Usando la cámara trasera, el escáner LiDAR y el aprendizaje automático en el dispositivo, el usuario puede enfocar la cámara de su iPhone en el panel de control de un horno de microondas, por ejemplo, y mientras el usuario mueve sus dedos sobre la imagen de un botón en la pantalla táctil, el iPhone anunciará el texto asociado con ese botón. Esto ayudará a aquellos que no pueden ver bien a tener control sobre algunas partes de sus vidas.

Estas son todas funciones útiles de las que podríamos escuchar más cuando Apple muestre iOS 17 en WWDC el 5 de junio. El CEO de Apple, Tim Cook, dice:”En Apple, siempre hemos creído que la mejor tecnología es la tecnología creada para todos. Hoy, nos complace compartir nuevas características increíbles que se basan en nuestra larga historia de hacer que la tecnología sea accesible, para que todos tiene la oportunidad de crear, comunicarse y hacer lo que ama”.