NVIDIA vient de annoncé son tout nouveau serveur DGX Station 320G AI basé sur le GPU Ampere A100 Tensor Core . La DGX Station 320G est équipée des GPU NVIDIA A100 Tensor Core mis à jour qui contiennent le double de la mémoire et des multi-pétaflops de puissance d’IA à sa disposition.

NVIDIA dévoile le serveur DGX Station 320G AI avec 320 Go de mémoire et quatre GPU NVIDIA Ampere A100

La NVIDIA DGX Station 320G est destinée au marché de l’IA, accélérant les performances de l’apprentissage automatique et de la science des données pour les bureaux d’entreprise, les centres de recherche, les laboratoires ou les bureaux à domicile partout. Selon NVIDIA, le DGX Station 320G est conçu pour être le serveur le plus rapide dans un boîtier dédié à la recherche sur l’IA.

La DGX Station 320G de NVIDIA alimente les organisations d’innovation en IA du monde entier ont adopté la DGX Station pour alimenter l’IA et la science des données dans des secteurs tels que l’éducation, les services financiers, le gouvernement, la santé et la vente au détail. Ces leaders de l’IA comprennent:

- BMW Group Production utilise les stations NVIDIA DGX pour explorer plus rapidement des informations tout en développant et déployant des modèles d’IA qui améliorent les opérations.

- DFKI, le centre de recherche allemand sur l’intelligence artificielle, utilise la DGX Station pour créer des modèles qui relèvent des défis critiques pour la société et l’industrie, y compris des systèmes de vision par ordinateur qui aident les services d’urgence à réagir rapidement aux catastrophes naturelles.

- Lockheed Martin utilise DGX Station pour développer des modèles d’intelligence artificielle qui utilisent les données des capteurs et les journaux de service pour prédire le besoin de maintenance afin d’améliorer la disponibilité de la fabrication, d’augmenter la sécurité des travailleurs et de réduire les coûts d’exploitation.

- NTT Docomo, le premier opérateur mobile japonais avec plus de 79 millions d’abonnés, utilise DGX Station pour développer des services innovants basés sur l’IA, comme sa solution de reconnaissance d’image.

- Le Pacific Northwest National Laboratory utilise les stations NVIDIA DGX pour mener des recherches financées par le gouvernement fédéral à l’appui de la sécurité nationale. Axé sur l’innovation technologique en matière de résilience énergétique et de sécurité nationale, PNNL est un centre HPC américain de premier plan pour la découverte scientifique, la résilience énergétique, la chimie, les sciences de la Terre et l’analyse de données.

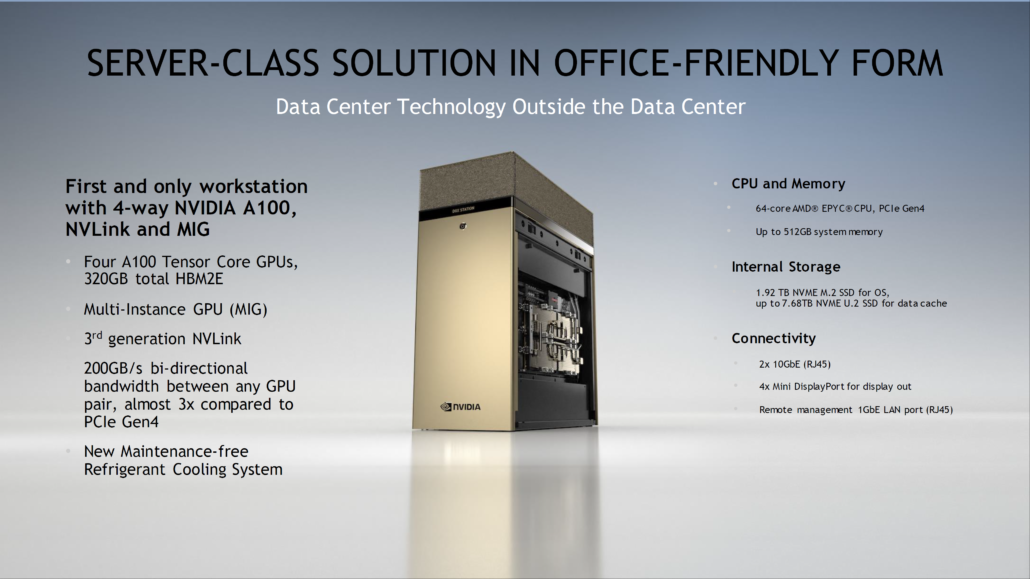

Spécifications du système NVIDIA DGX Station 320G

Pour répondre aux spécifications, la NVIDIA DGX Station 320G est alimentée par un total de quatre GPU A100 Tensor Core. Il ne s’agit pas de n’importe quel GPU A100 car NVIDIA a mis à jour les spécifications d’origine, hébergeant deux fois plus de mémoire.

Les GPU NVIDIA A100 Tensor Core de la DGX Station A100 sont livrés avec 80 Go de mémoire HBM2e, soit deux fois la taille de la mémoire de l’A100 d’origine. Cela signifie que la DGX Station a un total de 320 Go de capacité totale disponible tout en prenant pleinement en charge MIG (protocole GPU multi-instance) et la prise en charge de NVLink de 3e génération, offrant 200 Go/s de bande passante bidirectionnelle entre n’importe quelle paire de GPU et une interconnexion 3 fois plus rapide vitesses que PCIe Gen 4. Le reste des spécifications des GPU A100 Tensor Core restent les mêmes.

Le système lui-même héberge un processeur AMD EPYC Rome 7742 64 Core avec prise en charge complète de PCIe Gen 4, jusqu’à 512 Go de mémoire système dédiée, 1,92 To de stockage SSD NVME M.2 pour OS et jusqu’à 7,68 To NVME U. 2 stockage SSD pour le cache de données. Pour la connectivité, le système comporte 2 contrôleurs LAN 10 GbE, un seul port LAN 1 GbE pour la gestion à distance. La sortie d’affichage est fournie via une carte d’adaptateur d’affichage DGX discrète qui offre 4 sorties DisplayPort avec une prise en charge de résolution jusqu’à 4K. L’AIC dispose de sa propre solution de refroidissement actif.

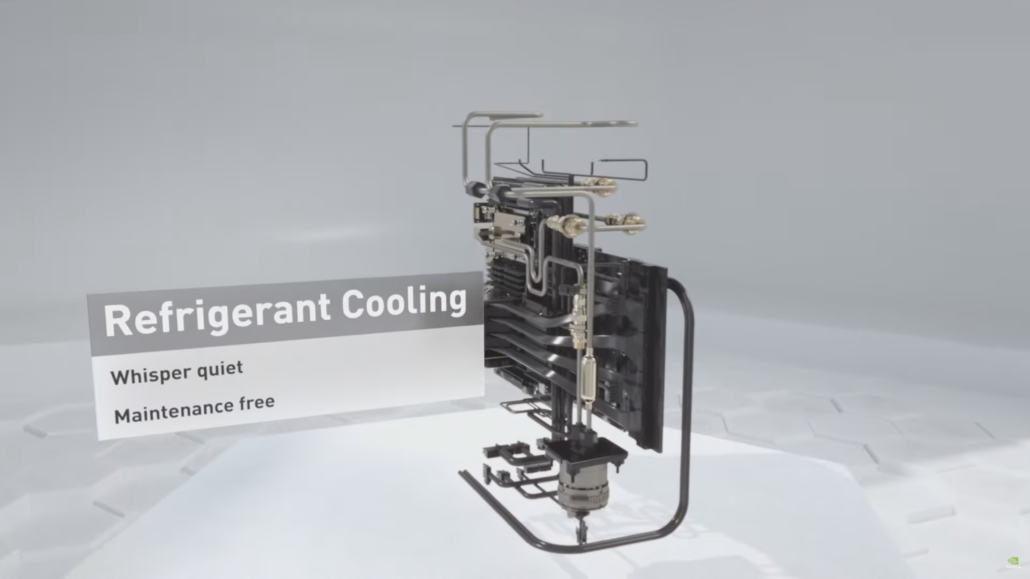

Parlant de la solution de refroidissement, la DGX Station 320G abrite les GPU A100 à l’arrière du châssis. Les quatre GPU et le CPU sont complétés par un système de refroidissement par réfrigérant qui est silencieux et sans entretien. Le compresseur du refroidisseur est situé dans le châssis DGX. L’ensemble du système est alimenté par un bloc d’alimentation de 1500 W et le refroidisseur fonctionne à un 37 dB silencieux.

Performances du système NVIDIA DGX Station A100

En ce qui concerne les performances, la DGX Station A100 délivre 2,5 Petaflops de puissance d’entraînement AI et 5 PetaOPS de puissance d’inférence INT8. La DGX Station A100 est également la seule station de travail de ce type à prendre en charge le protocole MIG (Multi-Instance GPU), permettant aux utilisateurs de découper des GPU individuels, ce qui permet d’exécuter des charges de travail simultanées plus rapidement et plus efficacement.

Sur DGX Station d’origine , la nouvelle version offre une augmentation de 3,17 fois des performances d’entraînement, de 4,35 fois les performances d’inférence et de 1,85 fois les charges de travail orientées HPC. NVIDIA a également mis à jour son système DGX A100 pour inclure également des GPU 80 Go A100 Tensor Core. Ceux-ci permettent à NVIDIA d’obtenir des performances d’entraînement 3 fois plus rapides que le système standard de 320 Go DGX A100, des performances d’inférence 25% plus rapides et des performances d’analyse de données deux fois plus rapides.

Disponibilité du système NVIDIA DGX Station 320G

La NVIDIA DGX Station 320G sera disponible plus tard cette année pour un prix de 149 000 USD ou un abonnement mensuel de 9 000 USD par mois.

Spécifications du Tesla A100 basées sur le GPU NVIDIA Ampere GA100:

| Carte graphique NVIDIA Tesla | Tesla K40 (PCI-Express) |

Tesla M40 (PCI-Express) |

Tesla P100 (PCI-Express) |

Tesla P100 (SXM2) | Tesla V100 (SXM2) | Tesla V100S (PCIe) | NVIDIA A100 (SXM4) | NVIDIA A100 (PCIe4) |

|---|---|---|---|---|---|---|---|---|

| GPU | GK110 (Kepler) | GM200 (Maxwell) | GP100 (Pascal) | GP100 (Pascal) | GV100 (Volta) | GV100 (Volta) | GA100 (Ampère) | GA100 (Ampère) |

| Nœud de processus | 28 nm | 28 nm | 16 nm | 16 nm | 12 nm | 12 nm | 7 nm | 7 nm |

| Transistors | 7,1 milliards | 8 milliards | 15,3 milliards | 15,3 milliards | 21,1 milliards | 21,1 milliards | 54,2 milliards | 54,2 milliards |

| GPU Die Size | 551 mm2 | 601 mm2 | 610 mm2 | 610 mm2 | 815mm2 | 815mm2 | 826mm2 | 826 mm2 |

| SM | 15 | 24 | 56 | 56 | 80 | 80 | 108 | 108 |

| TPC | 15 | 24 | 28 | 28 | 40 | 40 | 54 | 54 |

| Cœurs FP32 CUDA par SM | 192 | 128 | 64 | 64 | 64 | 64 | 64 | 64 |

| FP64 CUDA Cores/SM | 64 | 4 | 32 | 32 | 32 | 32 | 32 | 32 |

| FP32 CUDA Cores | 2880 | 3072 | 3584 | 3584 | 5120 | 5120 | 6912 | 6912 |

| FP64 CUDA Cores | 960 | 96 | 1792 | 1792 | 2560 | 2560 | 3456 | 3456 |

| Tensor Cores | N/A | N/A | N/A | N/A | 640 | 640 | 432 | 432 |

| Unités de texture | 240 | 192 | 224 | 224 | 320 | 320 | 432 | 432 |

| Boost Clock | 875 MHz | 1114 MHz | 1329 MHz | 1480 MHz | 1530 MHz | 1601 MHz | 1410 MHz | 1 410 MHz |

| TOP (DNN/AI) | N/A | N/A | N/A | N/A | 125 TOP | 130 TOP | 1248 TOP 2496 TOP avec Sparsity |

1248 TOP 2496 TOP avec Sparsity |

| FP16 Compute | N/A | N/A | 18,7 TFLOPs | 21,2 TFLOPs | 30,4 TFLOP | 32,8 TFLOP | 312 TFLOP 624 TFLOP avec Sparsity |

312 TFLOPs 624 TFLOP avec Sparsity |

| FP32 Compute | 5,04 TFLOPs | 6,8 TFLOP | 10,0 TFLOP | 10,6 TFLOP | 15,7 TFLOP | 16,4 TFLOP | 156 TFLOP (19,5 TFLOP standard) |

156 TFLOPs (19.5 TFLOPs standard) |

| FP64 Compute | 1,68 TFLOPs | 0,2 TFLOP | 4,7 TFLOP | 5,30 TFLOP | 7,80 TFLOP | 8,2 TFLOP | 19,5 TFLOP (9,7 TFLOP standard) |

19,5 TFLOPs (9.7 TFLOPs standard) |

| Interface mémoire | GDDR5 384 bits | GDDR5 384 bits | HBM2 4096 bits | HBM2 4096 bits | HBM2 4096 bits | HBM2 4096 bits | 6144-bit HBM2e | HBM2e 6144 bits |

| Taille de la mémoire | 12 Go GDDR5 @ 288 Go/s | 24 Go GDDR5 @ 288 Go/s | 16 Go HBM2 @ 732 Go/s 12 Go HBM2 @ 549 Go/s |

16 Go HBM2 @ 732 Go/s | 16 Go HBM2 @ 900 Go/s | 16 Go HBM2 @ 1134 Go/s | 40 Go HBM2 @ 1,6 To/s | Jusqu’à 80 Go HBM2 à 1,6 To/s |

| Taille du cache L2 | 1 536 Ko | 3072 Ko | 4 096 Ko | 4 096 Ko | 6144 Ko | 6144 Ko | 40960 Ko | 40960 Ko |

| TDP | 235W | 250W | 250W | 300W | 300W | 250W | 400W | 250W |