En plus de toutes les annonces CPU et GPU, NVIDIA est également lance aujourd’hui ses tout nouveaux GPU Tensor Core A10 et A30 basés sur Ampère. Les deux GPU sont destinés aux centres de données et sont principalement destinés aux plates-formes de virtualisation.

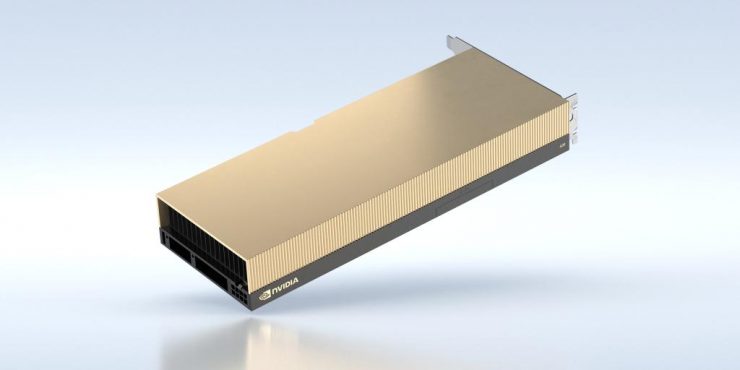

Lancement des processeurs NVIDIA Ampere A10 24 Go GDDR6 et A30 24 Go HBM2 Tensor Core

Ce qui est intéressant à propos de ces tout nouveaux GPU Tensor Core, ce sont leurs spécifications. L’A10 utilise le GPU GA102 tandis que l’A30 utilise le GPU GA100. Bien que les deux soient basés sur Ampère, le sous-système de mémoire pour les deux GPU sera très différent avec l’A10 offrant GDDR6 et l’A30 allant avec la norme de mémoire HBM2 standard pour les centres de données. Examinons donc en détail les spécifications.

GPU NVIDIA A10 Ampere Tensor Core

Le GPU NVIDIA A10 Tensor Core est alimenté par le SKU GA102-890. Il comporte 72 SM pour un total de 9216 cœurs CUDA. Le GPU fonctionne à une horloge de base de 885 MHz et augmente jusqu’à 1695 MHz. Il est conforme à la norme PCIe Gen 4.0 et en termes de mémoire, le GPU dispose de 24 Go de VRAM GDDR6 qui fonctionne à 12,5 Gbps sur une interface de bus de 384 bits. Le GPU offre une bande passante de 600 Go/s.

Quant à la conception de la carte, elle utilise un linceul de couleur champagne doré qui se présente dans un format pleine longueur à une seule fente. Puisqu’il s’agit d’une carte refroidie passivement, il n’y a pas de ventilateur dessus et l’alimentation est fournie via un seul connecteur à 8 broches avec la carte fonctionnant sur un seul connecteur à 8 broches pour répondre à sa demande de 150 W. TDP. En termes de performances, le GPU NVIDIA A10 Tensor Core offre jusqu’à 31,2 TF FP32, 62,5 TF TF32, 125 TF BFLOAT16, 250 TOPS INT8, 500 TOPS INT4 et deux fois les taux avec parcimonie.

GPU NVIDIA A30 Ampere Tensor Core

Le GPU NVIDIA A30 Tensor Core, quant à lui, utilise un SKU GA100 mais le la variante exacte n’est pas connue. Cela semble être une variante plutôt réduite qui présente une horloge de base de 930 MHz et une horloge de suralimentation allant jusqu’à 1440 MHz. Le GPU est équipé de 24 Go de VRAM HBM2 qui fonctionne à une vitesse de 1215 MHz sur une interface de bus de 3072 bits. Cela signifie que nous examinons seulement trois piles de mémoire HBM2 actives. Les piles fournissent jusqu’à 933 Go/s de bande passante mémoire.

Contrairement à l’A10, le GPU NVIDIA A30 Tensor Core présente une conception à double emplacement et pleine longueur. Il est également alimenté par un seul connecteur à 8 broches, mais a un TDP plus élevé de 165 W. En termes de performances, le GPU NVIDIA A30 Tensor Core offre jusqu’à 5,2 TF FP64, 10,3 TF Peak FP64TF, 10,3 TF FP32, 82 TF TF32, 165 TF BFLOAT16, 330 TOPS INT8, 661 TOPS INT4 et deux fois les taux avec parcimonie.

| GPU NVIDIA Tensor Core Ampere | ||

|---|---|---|

| A10 | A30 | |

| GPU | GA102-890 | GA100 |

| FP64 | – | 5.2 teraFLOPS |

| FP64 Tensor Core | – | 10.3 teraFLOPS |

| FP32 | 31.2 teraFLOPS | 10.3 teraFLOPS |

| TF32 Tensor Core | 62,5 teraFLOPS | 125 teraFLOPS * | 82 teraFLOPS | 165 teraFLOPS * |

| BFLOAT16 Tensor Core | 125 teraFLOPS | 250 téraFLOPS * | 165 teraFLOPS | 330 téraFLOPS * |

| FP16 Tensor Core | 125 teraFLOPS | 250 téraFLOPS * | 165 teraFLOPS | 330 teraFLOPS * |

| INT8 Tensor Core | 250 TOPS | 500 TOPS * | 330 TOPS | 661 TOPS * |

| INT4 Tensor Core | 500 TOPS | 1 000 TOPS * | 661 TOPS | 1321 TOPS * |

| RT Core | 72 cœurs RT | – |

| Encoder/décoder | 1 encodeur 2 décodeur (+ décodage AV1) |

1 accélérateur de flux optique (OFA) 1 décodeur JPEG (NVJPEG) 4 décodeurs vidéo (NVDEC) |

| Mémoire GPU | 24 Go GDDR6 | 24 Go HBM2 |

| Bande passante de la mémoire GPU | 600 Go/s | 933 Go/s |

| Interconnexion | PCIe Gen4 64 Go/s | PCIe Gen4: 64 Go/s NVLINK de troisième génération: 200 Go/s ** |

| Facteurs de forme | Fente simple, pleine hauteur, pleine longueur (FHFL) | Double emplacement, pleine hauteur, pleine longueur (FHFL) |

| Puissance thermique maximale de conception (TDP) | 150 W | 165 W |

| GPU multi-instance (MIG) | – | 4 instances de GPU de 6 Go chacune 2 instances de GPU de 12 Go chacune 1 instance de GPU de 24 Go |

| Prise en charge du logiciel vGPU | PC virtuel NVIDIA, applications virtuelles NVIDIA, station de travail virtuelle NVIDIA RTX, serveur de calcul virtuel NVIDIA | NVIDIA AI Enterprise pour VMware NVIDIA Virtual Compute Server |

Les tout nouveaux serveurs GPU d’Inspur prenant en charge A30, A10 et A100

NF5468M6: ultra-flexible pour les charges de travail IA, prend en charge 2 processeurs Intel Xeon Scalable de 3e génération et 8 processeurs graphiques NVIDIA A100/A40/A30, 16 processeurs graphiques NVIDIA A10 ou 20 processeurs graphiques NVIDIA T4; prend en charge jusqu’à 12 disques durs de 3,5 pouces pour un stockage local de grande taille dans un châssis 4U; s’adapte de manière flexible aux derniers accélérateurs d’IA et aux cartes réseau intelligentes et a la fonction unique de changer de topologies en un seul clic pour diverses applications d’IA, y compris le cloud AI, IVA (analyse vidéo intelligente), le traitement vidéo, etc.

NF5468A5: serveur AI polyvalent avec 2 processeurs AMD Rome/Milan et 8 processeurs graphiques NVIDIA A100/A40/A30; La conception de redondance N + N permet 8 accélérateurs AI de 350 W dans des opérations à pleine vitesse pour une fiabilité supérieure; la conception non bloquante CPU-GPU permet l’interconnexion sans la communication du commutateur PCIe, ce qui permet une efficacité de calcul plus rapide.

NF5280M6: spécialement conçu pour tous les scénarios, avec 2 processeurs Intel Xeon Scalable de 3e génération et 4 processeurs graphiques NVIDIA A100/A40/A30/A10 ou 8 processeurs graphiques NVIDIA T4 Tensor Core dans un châssis 2U, capable d’un fonctionnement stable à long terme à 45 ° C. Le NF5280M6 est équipé de la dernière technologie PFR/SGX et d’une conception de module de sécurité fiable, qui convient aux applications d’intelligence artificielle exigeantes.

Inspur a également annoncé que les tout nouveaux serveurs Inspur M6 AI prennent entièrement en charge les DPU NVIDIA Bluefield-2. À l’avenir, Inspur prévoit d’intégrer les DPU NVIDIA Bluefield-2 dans ses serveurs d’IA de nouvelle génération, ce qui permettra une gestion plus rapide et plus efficace des utilisateurs et des clusters ainsi qu’un accès aux données interconnectées, pour des scénarios tels que l’IA, l’analyse de données volumineuses, le cloud computing et la virtualisation.

<½Disponibilité

Plus de 20 systèmes certifiés NVIDIA sont désormais disponibles auprès de fabricants d’ordinateurs du monde entier. Les systèmes certifiés NVIDIA avec les GPU NVIDIA A30 et NVIDIA A10 seront disponibles plus tard cette année auprès des fabricants.

NVIDIA AI Enterprise est disponible sous forme de licence perpétuelle à 3 595 $ par socket de processeur. Le support Enterprise Business Standard pour NVIDIA AI Enterprise est de 899 USD par an par licence. Les clients peuvent demander un accès anticipé à NVIDIA AI Enterprise lorsqu’ils planifient leurs mises à niveau vers VMware vSphere 7 Update 2.