Apple a obtenu un brevet pour une technologie qui fait que l’iPhone entend mâcher, vous invite à photographier votre nourriture et pourrait ensuite critiquer vos choix alimentaires.

Le nouveau brevet”Augmented Reality Calorie Counter”d’Apple est divisé entre la détection de la mastication et la détermination de ce qui est mangé. Le brevet ne dit pas vraiment explicitement qu’Apple se plaindra de grignoter. Mais c’est uniquement parce que les brevets concernent la façon dont quelque chose est déterminé, et non ce qui est ensuite fait avec l’information.

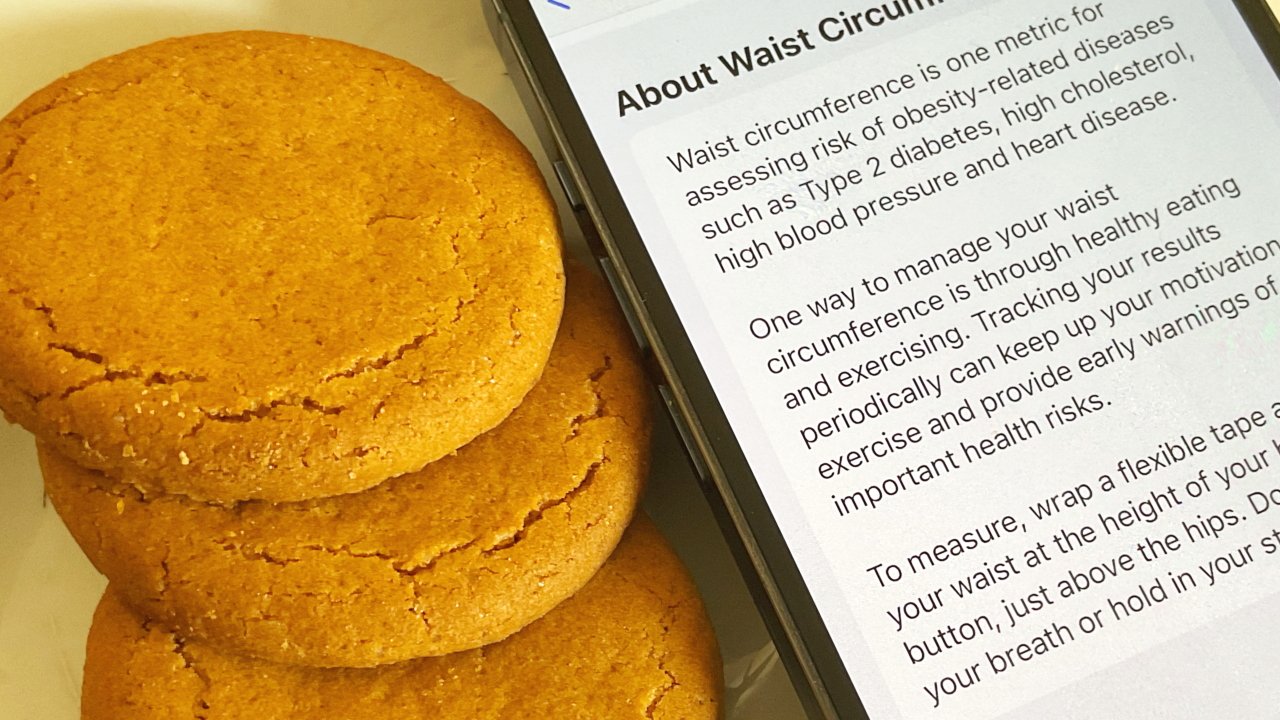

Même ainsi, c’est clairement une autre avenue pour Apple-l’expansion des services de santé. Mais dans ce cas, la société dit que c’est nécessaire en raison de notre tour de taille en constante expansion-et des difficultés peut-être surprenantes à compter les calories.

“De nombreux facteurs contribuent à un comptage inexact des calories”, déclare Apple.”Par exemple, la taille des portions peut être difficile à mesurer en mangeant dans un restaurant.”

“Le résultat est que les gens ont un nombre de calories inexact, ce qui nuit à la perte de poids, à des dosages de médicaments précis, etc.”, poursuit-il.

Selon Apple, il est possible d’acheter et de manger”uniquement à partir d’emballages à portion individuelle pour assurer un décompte calorique précis”, mais c’est”coûteux et peu pratique”. De plus, cela”conduit à une quantité excessive de matériaux d’emballage”.

Par conséquent, Apple pense que l’iPhone peut intervenir avec une”méthode pour améliorer la détermination de la consommation alimentaire”.

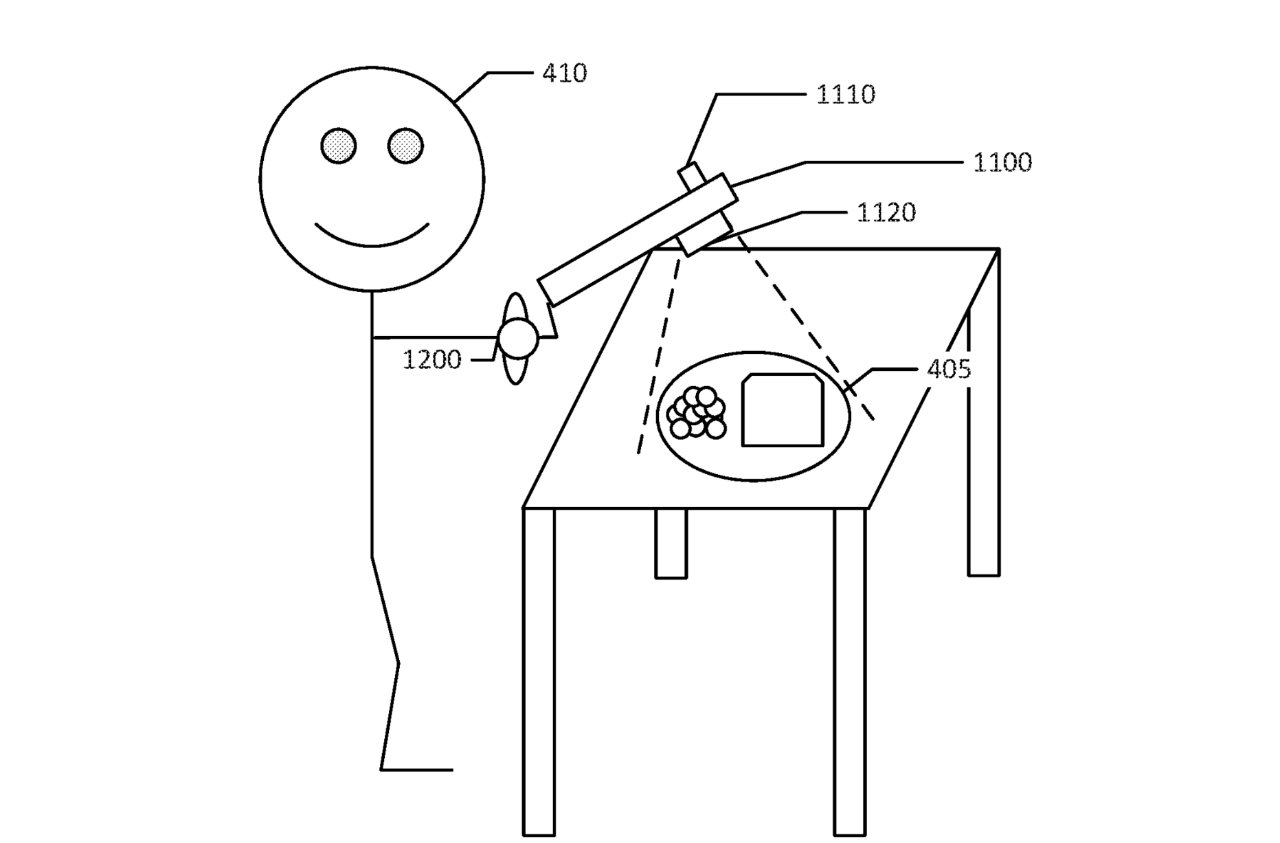

“[Il] comprend la détection, par un microphone, d’un bruit de mastication d’un utilisateur pendant une séance de mastication ;”poursuit Apple, « [et] en réponse à la détection du bruit de mastication, déclencher le fonctionnement d’une caméra ; obtenir, par la caméra, des données d’image capturant un produit alimentaire ».

Cette image peut ensuite être analysée de manière vraisemblablement similaire à la façon dont Visual Look Up identifie les plantes et les fleurs. En plus de déterminer s’il s’agit d’un gâteau au chocolat ou d’un BLT, le traitement d’image comprend”la détermination d’un volume du produit alimentaire en fonction de la mesure de la séance de mastication”.

Ainsi, il sait combien de grains il y a dans votre assiette, et il sait combien vous dépensez à mâcher. Cela signifie que l’iPhone peut ensuite être utilisé pour”déterminer un apport calorique basé sur le produit alimentaire, le volume du produit alimentaire et la mesure de la séance de mastication”.

Le brevet prend particulièrement soin de souligner à quel point il serait”complexe et long”de déterminer exactement comment mettre en œuvre un tel système.”[Ce] serait néanmoins une entreprise de routine pour les personnes de compétence ordinaire dans l’art de la capture d’images.”

Alors oui, prendre une photo d’un sandwich dans une station-service sera différent et peut-être plus difficile que de photographier une banane sur la table de votre cuisine. Mais les étapes seront les mêmes: détecter le fait de manger, demander une photo et analyser cette image.

Apple dit également qu’il y aura des circonstances où d’autres informations entreront en jeu.”Par exemple, les informations de localisation associées aux données d’image peuvent indiquer un restaurant particulier”, indique-t-il,”incitant le module de détection d’objets… et le processeur… à utiliser le menu du restaurant pour identifier le produit alimentaire”.

Encore une fois, le brevet se concentre uniquement sur l’obtention de ces données, en déterminant un nombre de calories. Vraisemblablement, ces informations pourraient être enregistrées dans une partie de l’application Santé.

Mais cela signifie que votre iPhone sait ce que vous mangez, combien de temps vous le mangez, combien vous mangez et même combien de fois vous allez chez Chili’s. Il doit y avoir de la place pour une application de régime tierce aussi sarcastique que Carrot Weather peut l’être.