Jeudi, Apple a annoncé trois nouveaux efforts visant à ajouter de nouvelles fonctionnalités de protection des enfants à l’iPhone, l’iPad et le Mac aux États-Unis. Maintenant, la société a répondu aux préoccupations dans une note interne.

Jeudi, Apple a annoncé trois nouveaux efforts visant à ajouter de nouvelles fonctionnalités de protection des enfants à l’iPhone, l’iPad et le Mac aux États-Unis. Maintenant, la société a répondu aux préoccupations dans une note interne.

Apple dit qu’elle continuera à expliquer et à détailler les fonctionnalités

Distribuées aux équipes qui ont travaillé sur l’initiative et obtenues par 9to5Mac, le mémo interne voit Apple reconnaître récents”malentendus”et inquiétudes quant aux implications de la technologie. Néanmoins, la société a déclaré qu’elle”continuerait à expliquer et à détailler les fonctionnalités afin que les gens comprennent”ce qui a été construit. En attendant, Apple déclare « il reste beaucoup de travail à faire pour fournir les fonctionnalités au cours des prochains mois..”

Jusqu’à présent, les critiques se sont principalement concentrées sur les projets d’Apple de numériser des photos iCloud à la recherche de matériel pédopornographique (CSAM), beaucoup affirmant que cette fonctionnalité pourrait ouvrir la porte à d’autres utilisations de surveillance plus préoccupantes.

Un L’un des critiques les plus en vue à ce jour est Edward Snowden, qui a déclaré ce qui suit: « Peu importe à quel point Apple est bien intentionné, Apple déploie une surveillance de masse dans le monde entier avec cela. Ne vous y trompez pas : s’ils peuvent rechercher du porno pour enfants aujourd’hui, ils peuvent rechercher n’importe quoi demain. »

La note interne complète envoyée aux employés d’Apple et rédigée par le vice-président des logiciels, Sébastien Marineau-Mes, est ci-dessous :

Aujourd’hui marque le dévoilement public officiel des protections étendues pour les enfants, et je voulais prendre un moment pour remercier chacun d’entre vous pour tout votre travail acharné au cours des dernières années. Nous n’aurions pas atteint cette étape sans votre dévouement et votre résilience inlassables.

La sécurité des enfants est une mission si importante. À la manière d’Apple, la poursuite de cet objectif a nécessité un engagement interfonctionnel profond, couvrant l’ingénierie, l’AG, l’HI, le juridique, le marketing produit et les relations publiques. Ce que nous avons annoncé aujourd’hui est le produit de cette incroyable collaboration, qui fournit des outils pour protéger les enfants, mais aussi pour maintenir l’engagement profond d’Apple envers la confidentialité des utilisateurs.

Nous avons reçu de nombreuses réponses positives aujourd’hui. Nous savons que certaines personnes ont des malentendus et que plus d’un s’inquiètent des implications, mais nous continuerons à expliquer et à détailler les fonctionnalités afin que les gens comprennent ce que nous avons construit. Et bien que beaucoup de travail acharné nous attend pour fournir les fonctionnalités au cours des prochains mois, je voulais partager cette note que nous avons reçue aujourd’hui du NCMEC. J’ai trouvé cela incroyablement motivant et j’espère que vous le ferez aussi.

Je suis fier de travailler chez Apple avec une équipe aussi formidable. Merci !

En quoi consistent les fonctionnalités de protection de l’enfance d’Apple ?

iCloud

Pour lutter contre la propagation du matériel d’abus sexuel d’enfants, le contenu qui décrit des activités sexuellement explicites impliquant un enfant, Apple ajoute une fonction de détection CSAM à son service iCloud Photos. Avant que les photos ne soient téléchargées sur iCloud Photos, les appareils Apple analyseront désormais les images pour trouver des correspondances avec une base de données d’images CSAM fournie par le National Center for Missing and Exploited Enfants.

Apple prétend avoir transformé la base de données en un « ensemble de hachages illisible qui est stocké en toute sécurité sur les appareils des utilisateurs ». Le processus de correspondance est alimenté par des bons de sécurité cryptographiques qui encodent les résultats du match.

Le contenu des bons de sécurité ne peut pas être interprété par Apple à moins d’un seuil spécifique de contenu CSAM. Si ce seuil est atteint, Apple examinera manuellement le rapport pour confirmer les correspondances et désactiver le compte de l’utilisateur.

En outre, la société indique qu’elle enverra un rapport au National Center for Missing and Exploited Children.

Il est important de noter que cette fonctionnalité est actuellement limitée aux États-Unis, bien qu’Apple espère se développer ailleurs à l’avenir. De plus, les photos stockées uniquement sur l’appareil ne sont pas incluses dans le processus de numérisation.

Messages

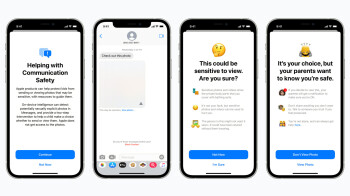

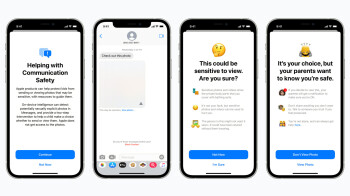

En plus des plans controversés d’iCloud Photos, Apple a dévoilé une nouvelle sécurité de communication opt-in fonctionnalité dans l’application Messages pour les enfants qui font partie d’une famille iCloud.

La fonctionnalité utilise l’apprentissage automatique sur l’appareil pour analyser le contenu des photos. Si un enfant reçoit une image sexuellement explicite, il verra un avertissement et l’image sera floue dans l’application Messages.

Si l’enfant choisit d’appuyer sur « Voir la photo », un bref message contextuel s’affiche. apparaîtra pour expliquer pourquoi l’image est considérée comme sensible. Si l’enfant choisit de continuer, son parent iCloud Family en sera informé.

Cela sera également expliqué dans le message contextuel. Des liens vers une aide supplémentaire seront également présents. Surtout, la notification pour les parents n’est disponible que pour les enfants de moins de 13 ans.

Siri et recherche

La dernière mise à jour annoncée par Apple était une extension des conseils dans Siri et Search. Plus précisément, les services fourniront des ressources supplémentaires pour aider les enfants et les parents à rester en sécurité et à obtenir de l’aide en cas de besoin.

Toutes ces fonctionnalités arriveront plus tard cette année dans une mise à jour vers iOS 15, iPadOS 15, watchOS 8 et macOS 12.