Az Apple számítógépes fényképezése a valósághűségre törekszik

A Samsung telefonkameráival kapcsolatos vita megújította a számítógépes fotózás körüli beszélgetést, és rávilágít a különbségre a fotózás és az Apple iOS-es megközelítése között.

Ez nem nagy titok hogy az Apple fejlett algoritmusokra és számítógépes fényképezésre támaszkodik iPhone fényképezőgépe szinte minden funkciójában. A felhasználók azonban kezdik feltenni a kérdést, hol húzzák meg a határt ezen algoritmusok és valami tolakodóbb dolog, például a rögzítés utáni pixelmódosítás között.

Ebben a cikkben megvizsgáljuk a Samsung holdfotói körüli vitákat, hogyan kezeli a vállalat a számítógépes fotózást, és mit jelent ez az Apple és versenytársai számára a jövőben.

Számítógépes fényképezés

A számítógépes fényképezés nem új fogalom. Ez szükségessé vált, mivel az emberek nagyobb teljesítményt akartak az apró okostelefonos kameráiktól.

Az alapötlet az, hogy a számítógépek milliárdnyi műveletet képesek végrehajtani egy pillanat alatt, például a fényképezőgép exponálása után, hogy helyettesítsék az alapvető szerkesztések szükségességét vagy fejlettebb korrekciókat alkalmazzanak. Minél többre tudjuk programozni a számítógépet az exponálás után, annál jobb lesz a fotó.

Ez az Apple kettős kamerarendszerével kezdődött az iPhone 7-en. Az addigi egyéb fényképészeti újítások, mint például az Élő fényképek, számítástechnikai fotózásnak tekinthetők, de a Portré mód jelentette a fordulópontot az Apple számára.

Az Apple 2016-ban vezette be a Portré módot, amely az iPhone 7 Plus két kamerájának mélységi adatait vette át a mesterséges bokeh létrehozásához. A cég azt állította, hogy ez a kettős kamerarendszernek és a fejlett képjel-processzornak köszönhető, amely fotónként 100 milliárd műveletet hajtott végre.

Mondanom sem kell, hogy ez nem volt tökéletes, de egy lépés volt a fotózás jövője felé. A kameratechnológia továbbra is alkalmazkodna az okostelefonok alaktényezőjéhez, a chipek gyorsabbak lennének, a képérzékelők pedig erősebbek lennének négyzethüvelykenként.

A portré mód számítógépes fényképezést használ a előtér

2023-ban nem ismeretlen, hogy moziszerűen elmosódott videókat készítenek fejlett számítási motorokkal vegyes eredménnyel. A számítógépes fotózás mindenhol megtalálható, a Photonic Engine-től a fényképezési stílusokig – egy algoritmus feldolgoz minden iPhone-on készült fényképet. Igen, még a ProRAW is.

Mindenre az emberek vágya volt, hogy megörökítsék életüket a kéznél lévő eszközzel – az iPhone-jukkal. A dedikált kameráknak a fizikája a nagy szenzorokkal és óriási objektívekkel rendelkezik, de az átlagember nem akar több száz vagy több ezer dollárt költeni egy erre a célra szolgáló berendezésre.

A számítógépes fényképezés tehát belépett az okostelefonok apró érzékelőinek képességeinek javítása érdekében. A nagy adatbázisokra épülő fejlett algoritmusok tájékoztatják a képjel-feldolgozót arról, hogyan rögzítse az ideális képet, hogyan dolgozza fel a zajt és exponálja a témát.

Azonban nagy különbség van aközött, hogy számítógépes fényképezést használunk a fényképezőgép képességeinek javítására, illetve aközött, hogy egy képet olyan adatok alapján módosítunk, amelyeket az érzékelő soha nem rögzített.

A Samsung moonshot

Az egyértelműség kedvéért: az Apple gépi tanulási modelleket használ – vagy „AI, mesterséges intelligencia” azok számára, akik a rosszul kitalált, népszerű új divatszót használják — számítógépes fényképezéshez. Az algoritmusok információt nyújtanak a többképes rögzítések vezérléséről a legjobb eredmény elérése vagy a mélységélesség profilok létrehozása érdekében.

A képfeldolgozó elemzi a bőrtónust, az eget, a növényeket, a háziállatokat és egyebeket, hogy megfelelő színezést és expozíciót biztosítson, nem pedig pixelcserét. Nem keres tárgyakat, például a holdat, hogy a kamera érzékelőjén kívüli információkon alapuló speciális fejlesztéseket biztosítson.

Ezt azért emeljük ki, mert azok, akik a Samsung holdfotóiról vitatkoznak, az Apple számítógépes fényképezését használták arra példaként, hogy más cégek hogyan hajtják végre ezeket a fényképezési módosításokat. Ez egyszerűen nem így van.

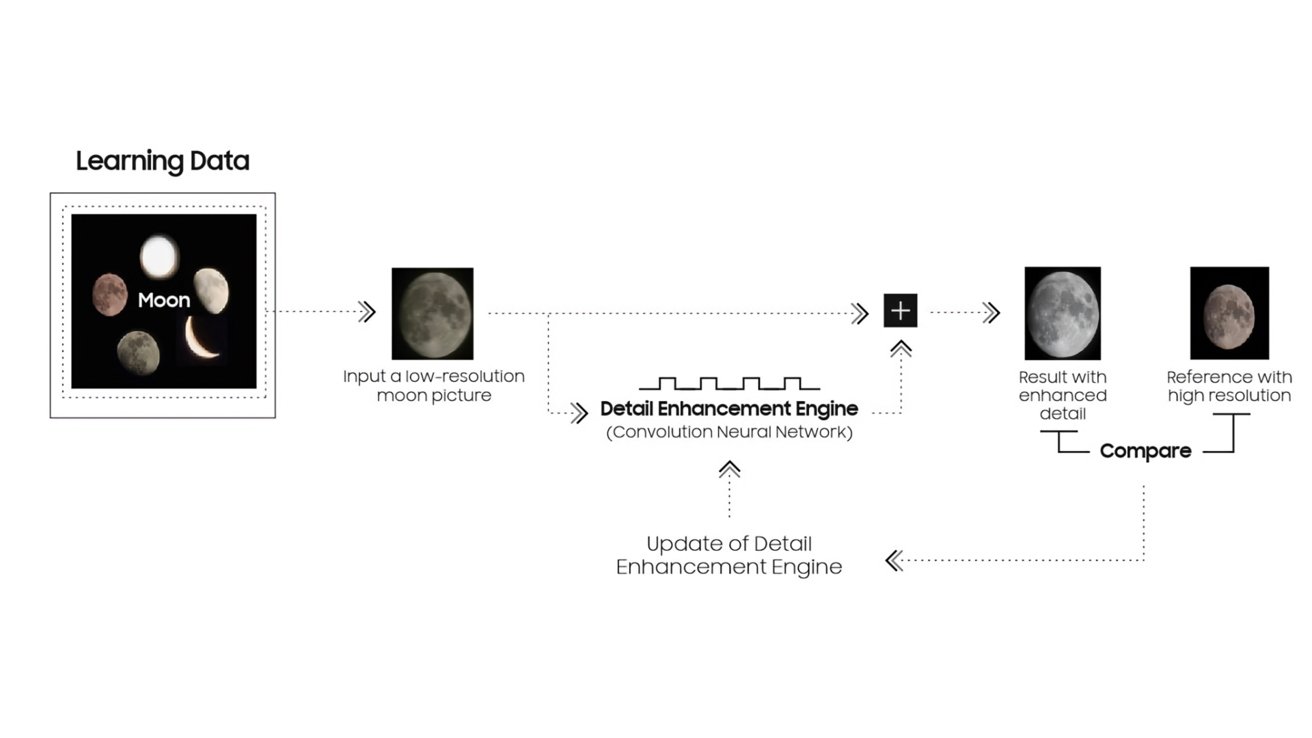

A Samsung holdalgoritmusa működés közben. Köszönet: u/ibreakphotos a Redditen

Samsung dokumentálta, hogy a Samsung telefonok a Galaxy S10 óta hogyan dolgozták fel a képeket tárgyfelismerés és-módosítás segítségével. A Scene Optimizer a Galaxy S21-el kezdte felismerni a Holdat.

Amint azt a nemrég közzétett dokumentum is leírja, az „AI” a tanult adatok alapján felismeri a Holdat, és a részletjavító motor funkciót alkalmazzák, hogy a többkockás szintézis és a gépi tanulás révén tisztább legyen a fénykép.

A Samsung készülékek alapvetően felismerik a nem takart holdat, majd más, nagy felbontású képeket és adatokat használnak a Holdról a jobb eredmény szintetizálása érdekében. Az eredmény nem a készülék kamerája által rögzített kép, hanem valami új és kitalált.

Összességében ez a rendszer okos, mert a Hold ugyanúgy néz ki, bárhol is nézzük a Földön. Csak a felszínéről visszaverődő fény színe és maga a holdfázis változik. A hold feljavítása egy fényképen mindig egyszerű számítás lesz.

Mind a Samsung, mind az Apple készülékek több fényképes expozíciót készítenek a fejlett számításokhoz. Mindkettő több rögzített képet is elemzi, hogy mindegyikből a legjobb részt vegyen, és egyetlen kiváló képpé olvasztja össze őket. A Samsung azonban hozzáad egy további lépést a felismert objektumokhoz, például a holdhoz, amely új adatokat vezet be más nagyfelbontású holdképekből, hogy korrigálja a holdat a végső rögzített képen.

A Samsung holdalgoritmusa ismertetve. Jóváírás: Samsung

Ez nem feltétlenül rossz. Ez nem olyasmi, amit a Samsung ne tett volna egyértelművé a reklámjaiban vagy a termékmarketingjében, ami az ügyfelek megzavarásához vezethet.

Az a probléma ezzel a folyamattal, és a vita oka, hogy ez hogyan befolyásolja a fotózás jövőjét.

Röviden: a végső kép nem tükrözi azt, amit az érzékelő észlelt és az algoritmus dolgozott fel. Ez egy idealizált változata annak, ami lehetséges, de nem azért, mert a kamera érzékelője és az objektív túl kicsi.

A küszöbön álló csata a realizmusért

A mi szempontunkból az iPhone-fotózás legfontosabb alapelve mindig is a realizmus és a pontosság volt. Ha van tökéletes közepe a telítettségben, élességben és expozícióban, az Apple az elmúlt évtizedben a középponthoz közeli tendenciát mutatott, még akkor is, ha ez nem mindig maradt tökéletesen konzisztens.

Tisztában vagyunk vele, hogy a fotózás hihetetlenül szubjektív, de úgy tűnik, hogy az Android fotózás, nevezetesen a Samsung, elhajlott a realizmustól. Ismétlem, nem feltétlenül negatív, hanem véleménynyilvánított választás a Samsung részéről, amellyel az ügyfeleknek foglalkozniuk kell.

Ebben a vitában a Samsung és a Pixel eszközök lassan elfordultak ettől az ideális valósághű reprezentációs központtól. Versenyeznek a nagyobb telítettségért, élességért vagy a nappalhoz hasonló éjszakai expozícióért.

A fenti példa azt mutatja, hogy a Galaxy S22 Ultra hogyan részesítette előnyben a nagyobb expozíciót és telítettséget, ami a részletek elvesztéséhez vezetett. Ártatlan és elgondolkodtató döntések, de az iPhone 13 Pro ebben az esetben egy részletesebb, később szerkeszthető fotóval tér haza.

A fotók rögzítésének módja közötti különbséget az egyes eszközök által használt véleményalgoritmusok határozzák meg. Ahogy ezek az algoritmusok fejlődnek, a jövőbeli fényképezési döntések több véleménynyilvánításhoz vezethetnek, amelyeket később nem lehet visszafordítani.

Például, ha fejlett algoritmusok segítségével megváltoztatja a Hold megjelenését a felhasználó figyelmeztetése nélkül, a kép örökre megváltozik, hogy megfeleljen a Samsung által ideálisnak. Persze, ha a felhasználók tudják, hogy ki kell kapcsolni a funkciót, megtehetik, de valószínűleg nem fogják.

Izgatottan várjuk a fotózás jövőjét, de a fotózás szerelmeseiként reméljük, hogy ez nem lesz annyira láthatatlan. Az Apple portré módjához, az Élő fényképekhez és más feldolgozási technikákhoz hasonlóan – egyértelmű kapcsolókkal engedélyezheti. Ezenkívül tegye visszafordíthatóvá.

Ha az eszköz fő kameraalkalmazásában megérinti a zárat, reprezentatív fotót kell készítenie arról, amit az érzékelő lát. Ha a felhasználó többet szeretne, döntse el, hogy hozzáadja-e az előtte vagy utána szerkeszthető kapcsolókkal.

Egyelőre próbáljon meg fényképeket készíteni az éjszakai égboltról az iPhone készülékén és egy állványon kívül. Működik.

Miért számít ez?

Fontos hangsúlyozni, hogy semmi gond nincs azzal, ha az égen a csúnyán izzó golyót megfelelő holdra cseréljük, az sem probléma, hogy embereket vagy szemetet (vagy szemetet) távolítanak el egy fényképről. Ennek azonban ellenőrizhető, átkapcsolható és a felhasználó számára látható folyamatnak kell lennie.

A számítógépes fényképezés a jövő, jóban-rosszban

Az algoritmusok fejlődésével egyre több idealizált és feldolgozott képet fogunk látni Android okostelefonokról. A legrosszabb elkövetők azonnal eltávolítják vagy kicserélik a tárgyakat, figyelmeztetés nélkül.

Az Apple elkerülhetetlenül javítani fogja az eszközön lévő képfeldolgozását és algoritmusait. De abból kiindulva, hogy a cég eddig hogyan viszonyult a fotózáshoz, azt várjuk, hogy a felhasználó realizmus iránti vágya tekintetében ezt fogja tenni.

A technológiai közösségben uralkodó tribalizmus mindig is vitákat váltott ki a felhasználók között. Ezek közé tartozik a Mac vagy PC, az iPhone vagy az Android, és hamarosan valódi vagy ideális fotók.

Reméljük, hogy az Apple a jövőben is a valósághűséget és a felhasználói vezérlést választja a fotók felett. Nem tűnik olyan jövőnek, amelynek a részesei akarunk lenni, ha egy vállalatnak adjuk meg, hogy a felhasználó mit készítsen egy fényképezőgéppel, egészen a képek megváltoztatásáig.