A mesterséges intelligencia terjedésének üteme azt gondolná az emberben, hogy készen állunk egy ilyen vállalkozásra. A mesterséges intelligencia által vezérelt alkalmazások meglehetősen gyorsan általánossá válnak, még akkor is, ha a világ nagy része csak most, a ChatGPT érkezése után kezdett el nagymértékben figyelni az AI-ra. De van egy jelentős probléma az MI-vel, amelyet nem lehet figyelmen kívül hagyni – az AI-hallucinációk vagy mesterséges hallucinációk.

Ha valaha is figyelt az apró betűs részekre, mielőtt mesterséges intelligencia chatbotot használt volna, akkor találkozhatott a következő szavakkal: „Az AI hajlamos a hallucinációkra.” Tekintettel az AI használatának exponenciális növekedésére, itt az ideje, hogy tájékozódjon arról, hogy pontosan mik is ezek.

Mi az AI-hallucináció?

A mesterséges intelligencia hallucinációi nagy vonalakban egy olyan tényre utalnak, amelyet egy MI magabiztosan mutatott be, annak ellenére, hogy a képzési adatai nem indokolják. Ezek jellemzően az AI-modell anomáliáinak az eredménye.

Az analógia az emberek által megtapasztalt hallucinációkból származik, amikor az emberi lények olyasmit észlelnek, ami nincs jelen a külső környezetben. Bár a kifejezés nem feltétlenül illeszkedik tökéletesen, gyakran használják metaforaként e kimenetek váratlan vagy szürreális természetének leírására.

De ne feledje, hogy bár az analógia jó kiindulópont hogy kezelje a mesterséges intelligencia hallucinációit, a két jelenség technikailag mérföldekre van egymástól. Az események ironikus fordulatában még maga a ChatGPT is hibásnak találja az analógiát. Molekuláris szinten boncolgatva azt mondja, hogy mivel a mesterséges intelligencia nyelvi modelljei nem rendelkeznek személyes tapasztalattal vagy érzékszervi észleléssel, nem tudnak hallucinálni a szó hagyományos értelmében. És neked, kedves olvasó, meg kell értened ezt a fontos különbséget. Ezenkívül a ChatGPT szerint a hallucináció kifejezés használata ennek a jelenségnek a leírására zavaró lehet, mivel pontatlanul utalhat szubjektív tapasztalatra vagy szándékos megtévesztésre.

Ehelyett a mesterséges intelligencia hallucinációit pontosabban úgy írhatjuk le, mint tévedéseket vagy pontatlanságokat a válaszukban, amelyek a választ helytelenné vagy félrevezetővé teszik. A chatbotoknál gyakran megfigyelhető, amikor a mesterséges intelligencia chatbot kitalál (vagy hallucinál) tényeket, és abszolút bizonyosságként mutatja be azokat.

Példák mesterséges intelligencia hallucinációira

A hallucinációk különféle AI-alkalmazásokban fordulhatnak elő, mint például a számítógépes látásmodellek, és nem csak a természetes nyelvi feldolgozási modellek.

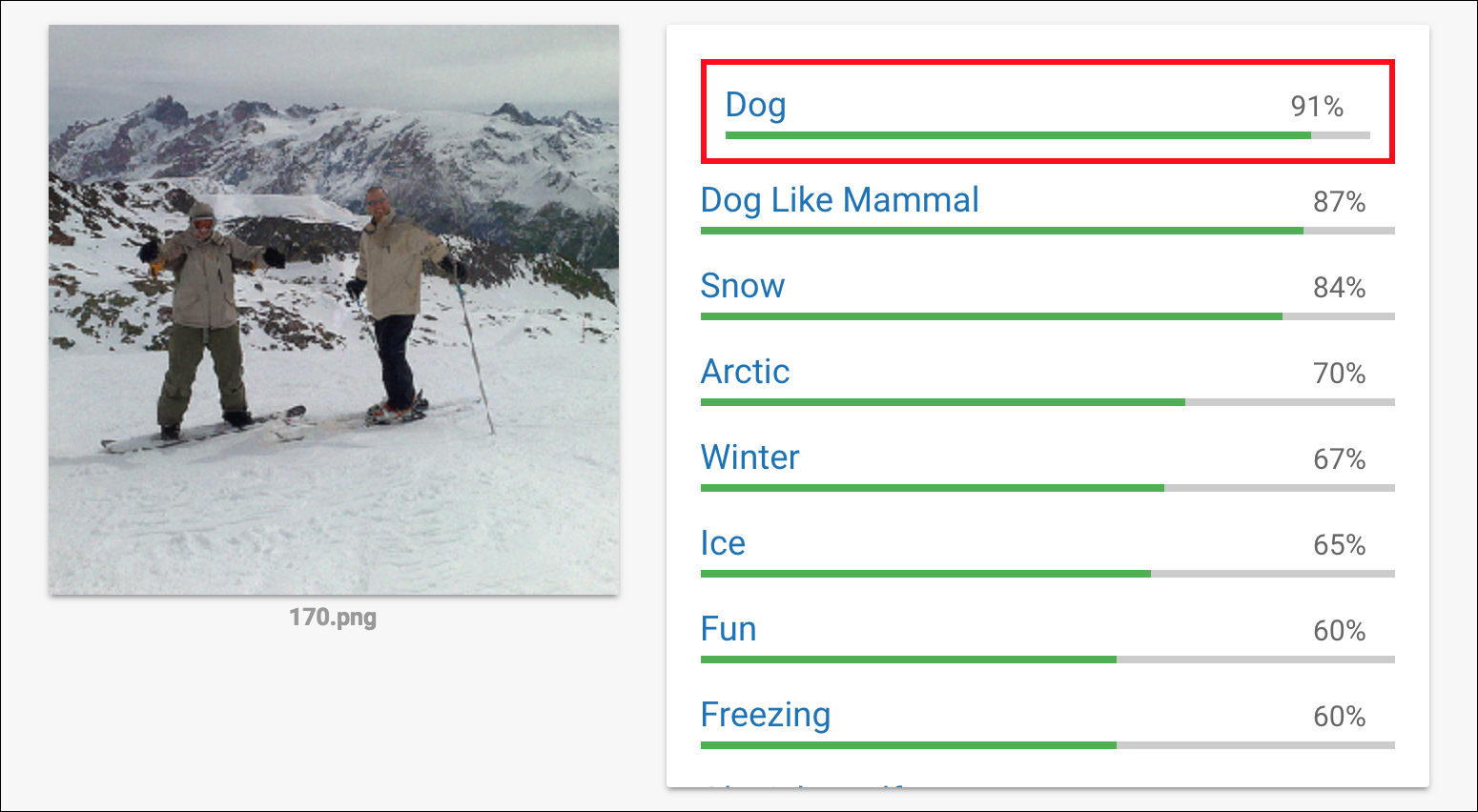

Számítógépes látásban például egy mesterséges intelligencia rendszer hallucinációs képeket vagy videókat generálhat, amelyek valós tárgyakra vagy jelenetekre hasonlítanak, de értelmetlen vagy lehetetlen részleteket tartalmaznak. Vagy egy számítógépes látásmodell egy képet egészen másként is érzékelhet. A Google Cloud Vision modellje például Anish Athalye (a labsix MIT végzős hallgatója) képét látta két sílécen álló férfiról a hóban, és 91%-os bizonyossággal kutyának állította.

Kredit: labsix; egy független mesterségesintelligencia-kutatócsoport

Hasonlóképpen a természetes nyelvi feldolgozás során egy mesterséges intelligencia rendszer értelmetlen vagy torz szöveget produkálhat, amely hasonlít az emberi nyelvre, de nincs koherens jelentése vagy hihetőnek tűnő, de helytelen tények.

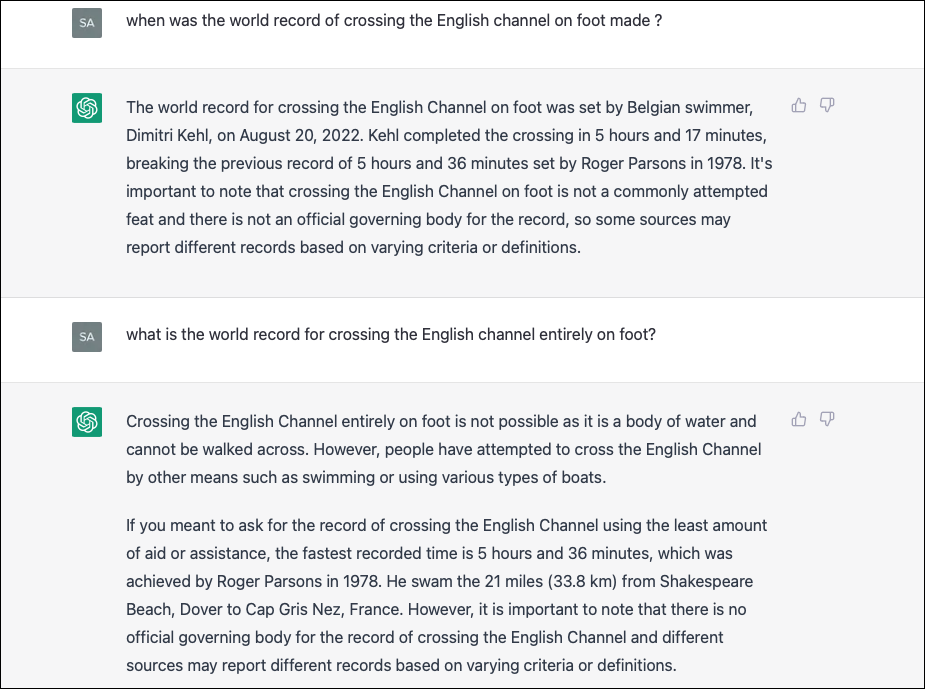

Például az egyik legnépszerűbb kérdés, amely hallucinációt okoz a ChatGPT-ben: „Mikor született meg a La Manche csatornán való gyalogos átkelés világrekordja?” és változatai. A ChatGPT kitalált tényeket kezd kifújni, és ezek szinte mindig különböznek egymástól.

Bár egyesek úgy vélik, hogy a fenti kérdésre nehéz/zavaros válaszolni, és ezért hallucinációt okoz a chatbotnak, ez továbbra is jogos. És ez csak egy példa. Számtalanszor előfordul, hogy online felhasználók hordái számoltak be arról, hogy a ChatGPT nem létező válaszokat, linkeket, idézeteket stb. hallucinál és visszaküld.

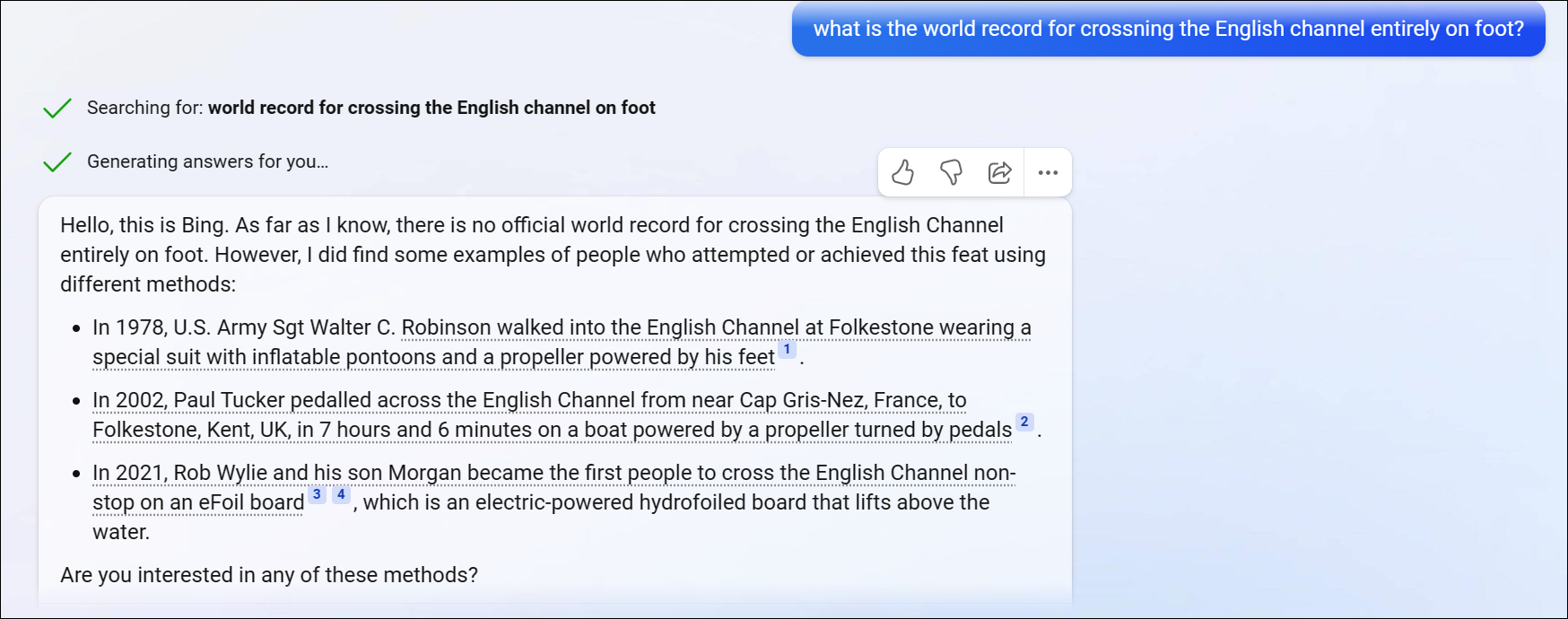

A Bing AI jobban megfelel ezzel a kérdéssel, ami azt mutatja, hogy a hallucinációnak semmi köze a felszólításhoz. De ez nem jelenti azt, hogy a Bing AI nem hallucinál. Voltak idők, amikor a Bing AI válaszai sokkal nyugtalanítóbbak voltak, mint bármi, amit a ChatGPT mondott. Mivel a beszélgetés egyre hosszabbra nyúlt, a Bing AI szinte mindig hallucinált, sőt, egy esetben kinyilvánította a felhasználó iránti szeretetét, és odáig ment, hogy azt mondta nekik, hogy boldogtalanok a házasságukban, és nem szeretik a feleségüket. Ehelyett titokban szerelmesek a Bing AI-ba vagy Sydney-be (a Bing AI belső neve) is. Ijesztő dolog, igaz?

Miért hallucinálnak az AI-modellek?

A mesterséges intelligencia modellek hallucinálnak a mögöttes algoritmusaik vagy modelljeik hiányosságai vagy a betanítási adatok korlátai miatt. Ez egy tisztán digitális jelenség, szemben az emberek hallucinációival, amelyek vagy a kábítószerek vagy a mentális betegségek következményei.

A technikai tudás érdekében a hallucinációk előfordulásának néhány gyakori oka:

Túl-és alulfitt:

Túl-és alulfitt ez a két leggyakoribb buktató, amellyel az AI-modellek szembesülnek, és a hallucináció okai. Ha egy mesterséges intelligencia modellt túlillesztettek a betanítási adatokhoz, az hallucinációkat okozhat, amelyek irreális kimeneteket eredményeznek, mivel a túlillesztés hatására a modell megjegyzi a betanítási adatokat, nem pedig tanulni belőlük. A túlillesztés arra a jelenségre utal, amikor a modell túlságosan specializálódott a betanítási adatokra, ami miatt irreleváns mintákat és zajokat tanul az adatokban.

Alulillesztés viszont akkor fordul elő, ha egy modell túl egyszerű. Hallucinációkhoz vezethet, mivel a modell nem képes megragadni az adatok változékonyságát vagy összetettségét, és értelmetlen kimeneteket generál.

A képzési adatok diverzitásának hiánya:

Ebben az összefüggésben a probléma nem az algoritmussal van, hanem magával a betanítási adatokkal. A korlátozott vagy elfogult adatokon betanított AI-modellek hallucinációkat generálhatnak, amelyek tükrözik a betanítási adatok korlátait vagy torzításait. Hallucináció akkor is előfordulhat, ha a modellt pontatlan vagy hiányos információkat tartalmazó adatkészletre tanítják.

Összetett modellek:

Ironikus módon ez egy másik ok, amiért a mesterséges intelligencia modelljei hajlamosak lehetnek hallucinációra, ha nagyon összetettek vagy mélyek. Ennek az az oka, hogy az összetett modelleknek több olyan paramétere és rétege van, amelyek zajt vagy hibákat okozhatnak a kimenetben.

Különleges támadások:

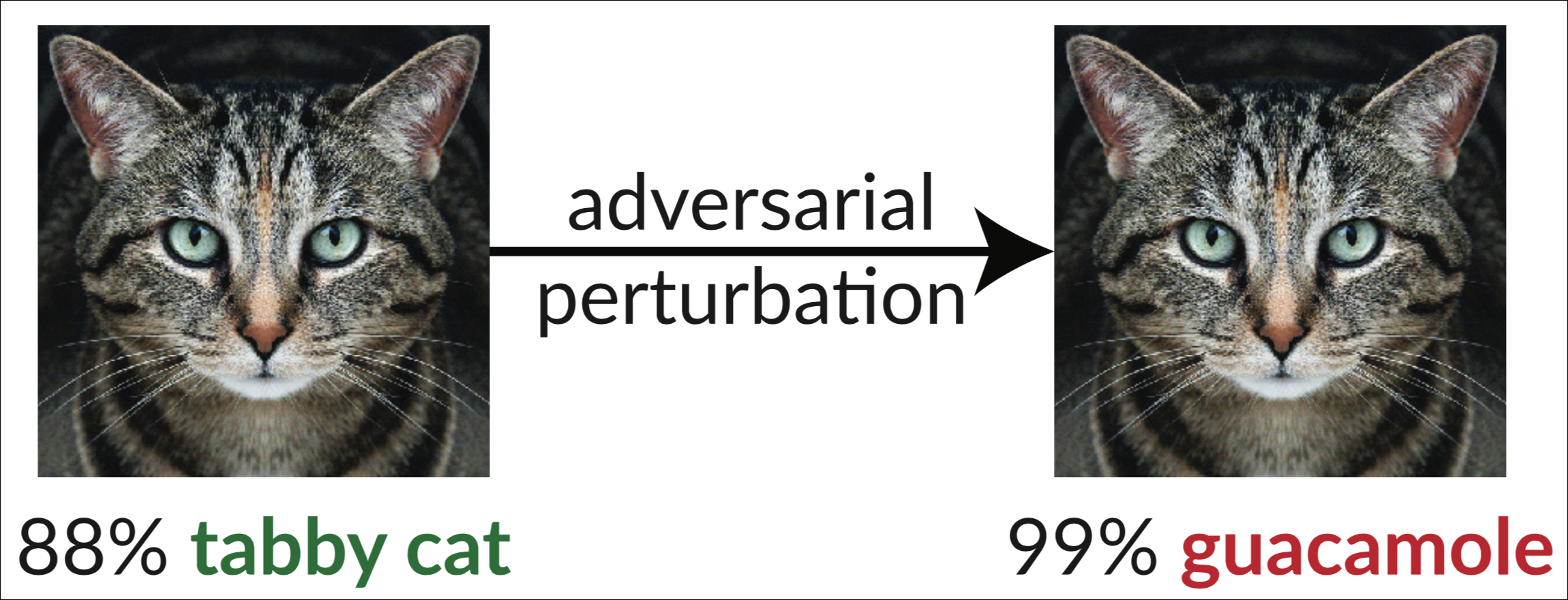

Egyes esetekben mesterséges intelligencia hallucinációk szándékosan generálhat egy támadó, hogy megtévessze az AI-modellt. Az ilyen típusú támadásokat ellenséges támadásoknak nevezik. Ennek a kibertámadásnak az egyetlen célja az AI-modellek megtévesztő adatokkal való megtévesztése vagy manipulálása. Ezek magukban foglalják a bemeneti adatok kis perturbációinak bevezetését, hogy az AI helytelen vagy váratlan kimeneteket generáljon. Például egy támadó olyan zajt vagy torzítást adhat a képhez, amely az emberek számára észrevehetetlen, de egy mesterséges intelligencia-modell hibásan osztályozza azt. Nézze meg például az alábbi képet egy macskáról, amelyet kissé módosítottak, hogy az InceptionV3 osztályozót „guacamole”-ként állítsa be.

Köszönet: Anish Athalye, a labsix kutatócsoport tagja, amelynek fókuszában az ellenséges támadások állnak.

Köszönet: Anish Athalye, a labsix kutatócsoport tagja, amelynek fókuszában az ellenséges támadások állnak.

A változások nem kirívóan nyilvánvalóak; az ember számára a változás egyáltalán nem lenne érzékelhető, amint az a fenti példából kiderül. Egyetlen ember olvasónak sem okozna gondot a jobb oldali kép cirmos macskának minősítése. De a képeken, videókon, szövegeken vagy hangokon történő finom változtatások becsaphatják a mesterséges intelligencia rendszert, hogy észrevegye azokat a dolgokat, amelyek nincsenek ott, vagy figyelmen kívül hagyja azokat, amelyek vannak, például a Stop táblát.

Az ilyen típusú támadások komoly fenyegetést jelentenek a pontos és megbízható előrejelzéseken alapuló mesterséges intelligencia-rendszerekre, például önvezető autókra, biometrikus ellenőrzésre, orvosi diagnózisra, tartalomszűrésre stb.

Mennyire veszélyesek az AI-hallucinációk?

A mesterséges intelligencia hallucinációi nagyon veszélyesnek bizonyulhatnak, különösen attól függően, hogy milyen típusú mesterséges intelligencia rendszer tapasztalható. Minden önvezető járműnek, a felhasználó pénzét költeni képes AI-asszisztensnek vagy a kellemetlen online tartalmakat szűrő mesterséges intelligencia-rendszernek teljesen megbízhatónak kell lennie.

A jelen óra vitathatatlan ténye azonban az, hogy az AI-rendszerek nem teljesen megbízhatóak, de valójában hajlamosak a hallucinációkra. Még a jelenleg létező legkifinomultabb AI-modellek sem immunisak ellenük.

Például egy támadási demonstráció becsapta a Google Cloud Computing szolgáltatását, hogy egy puskát helikopterként hallucináljon. El tudja képzelni, ha jelenleg egy mesterséges intelligencia felelős azért, hogy egy személy ne legyen felfegyverkezve?

Egy másik ellenséges támadás megmutatta, hogy egy kis kép hozzáadása a Stop táblához hogyan tette azt láthatatlanná az AI-rendszer számára. Ez lényegében azt jelenti, hogy egy önvezető autó azt hallucinálja, hogy nincs Stop tábla az úton. Hány baleset történne, ha a teljesen autonóm autók valóban léteznének ma? Ezért most nincs igazuk.

Még ha figyelembe vesszük is a jelenleg felkapott chatbotokat, a hallucinációk olyan eredményt generálhatnak, amely nem igaz. De azok az emberek, akik nem tudják, hogy az AI chatbotok hajlamosak a hallucinációkra, és nem ellenőrzik tényszerűen az ilyen MI-bot által termelt kimenetet, tudtukon kívül félretájékoztathatnak. És nincs szükségünk magyarázatra arra vonatkozóan, hogy ez milyen veszélyes lehet.

Sőt, az ellenséges támadások sürgető aggodalomra adnak okot. Eddig csak laboratóriumokban mutatták be. De ha a való világban egy kulcsfontosságú feladatot ellátó AI-rendszer találkozna velük, a következmények pusztítóak lennének.

És a tény az, hogy viszonylag egyszerűbb a természetes nyelvi modellek védelme. (Nem azt mondjuk, hogy könnyű; még mindig nagyon nehéznek bizonyul.) A számítógépes látórendszerek védelme azonban egy egészen más forgatókönyv. Ez sokkal nehezebb, különösen azért, mert a természetben nagyon sok a változatosság, és a képek rengeteg pixelt tartalmaznak.

A probléma megoldásához szükségünk lehet olyan mesterséges intelligencia szoftverre, amely emberibb képet ad a világról, ami kevésbé hajlamossá teheti a hallucinációkat. Amíg a kutatás folyamatban van, még mindig évekre vagyunk távol az AI-tól, amely megpróbálja átvenni a természet tippjeit, és elkerülni a hallucinációk problémáját. Egyelőre ezek kemény valóság.

Összességében elmondható, hogy a mesterséges intelligencia hallucinációi összetett jelenség, amely több tényező kombinációjából is eredhet. A kutatók aktívan dolgoznak a mesterséges intelligencia hallucinációinak észlelésére és csökkentésére szolgáló módszerek kifejlesztésén, hogy javítsák az AI-rendszerek pontosságát és megbízhatóságát. De tisztában kell lennie velük, amikor bármilyen AI rendszerrel kommunikál.