A Apple lançou vários novos recursos de acessibilidade para iOS e iPadOS. A gigante de Cupertino está dobrando seu compromisso de tornar “a tecnologia acessível para todos” com esta atualização. Os novos aprimoramentos de acessibilidade, incluindo acessibilidade cognitiva, Live Speech e muito mais, aproveitarão o hardware integrado dos dispositivos e os recursos de aprendizado de máquina. Continue lendo abaixo para saber mais.

Novos recursos de acessibilidade para iPhone e iPad

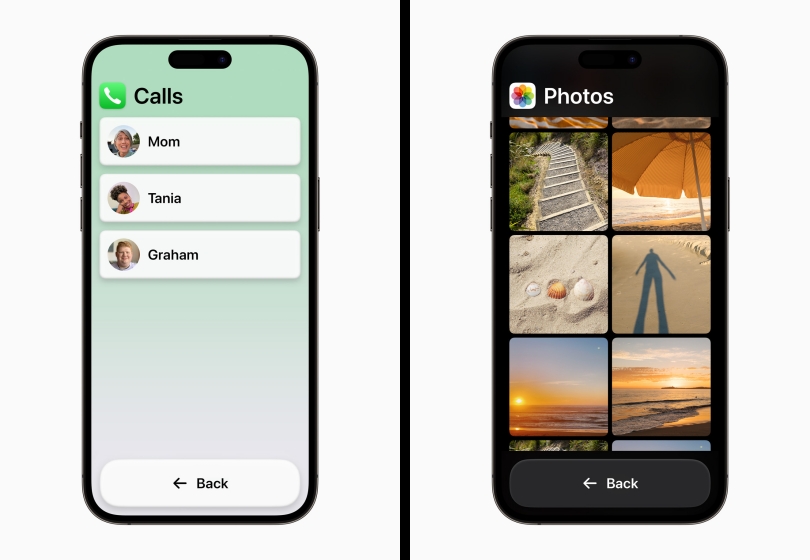

Um dos recursos anunciados recentemente é o Acesso Assistivo para Deficiência Cognitiva. Como fica evidente no nome, usuários com complicações como autismo, Alzheimer e assim por diante, geralmente acham difícil navegar pelos elementos em seus smartphones. Esse recurso organizará aplicativos e elementos do sistema operacional para manter intactas apenas as principais funcionalidades.

Este recurso funcionará com o telefone, FaceTime, câmera e outros aplicativos de motorista diários. Com esse recurso ativado, os usuários poderão interagir com texto ampliado e botões de alto contraste e apenas com as funcionalidades que importam. Isso é construído com base nos dados e feedback coletados de apoiadores confiáveis e pessoas com distúrbios cognitivos.

Recurso de acessibilidade assistida

Recurso de acessibilidade assistida

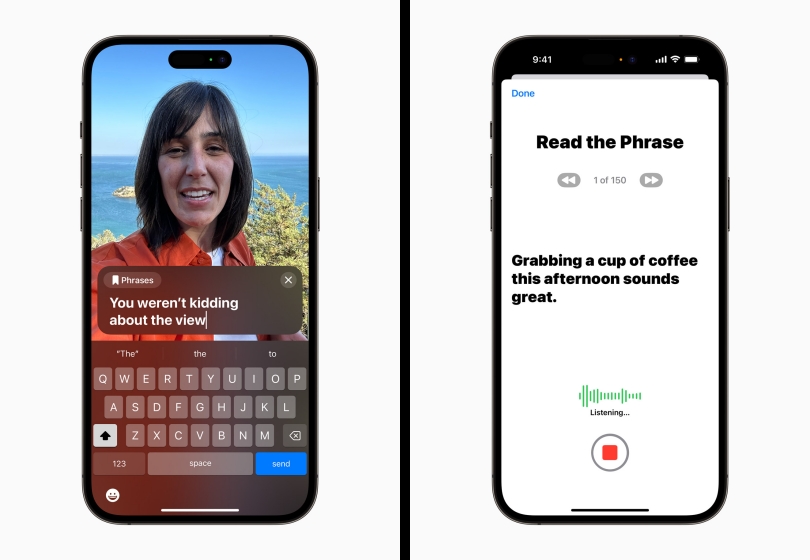

Outro novo recurso é o Live Speech e Personal Voice, cujo objetivo é tornar a tecnologia acessível a pessoas com problemas de voz como ALS. O recurso Live Speech permitirá que os usuários digitem suas palavras e deixem seu iPhone ou iPad expressá-las em voz alta. Esse recurso será útil durante conversas pessoais e conversas virtuais.

Por outro lado, o recurso Personal Voice está um nível acima do recurso Live Speech. Ele permite que usuários com deficiências de voz em estágios iniciais gravem uma impressão de áudio de sua própria voz. Isso significa que sempre que você quiser se comunicar com alguém e digitar sua resposta, ela será reproduzida com sua própria voz, em vez de uma voz robótica genérica. A funcionalidade usa aprendizado de máquina no dispositivo e um conjunto de prompts predefinidos para criar sua impressão de voz de maneira segura.

Fala ao vivo e voz pessoal

Fala ao vivo e voz pessoal

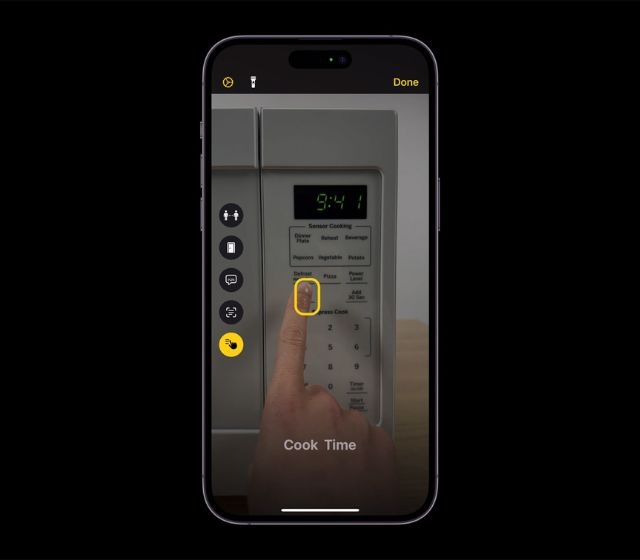

Para usuários com baixa visão ou que estão perdendo a capacidade de veja, a Apple introduziu um recurso de acessibilidade chamado Aponte e fale para o modo de detecção na lupa. Esse recurso permitirá que os usuários recebam prompts de áudio para elementos com textos. Por exemplo, se você estiver digitando no teclado, cada pressionamento de tecla terá um prompt de voz associado a eles. A Apple consegue esse feito combinando o sensor LiDAR no dispositivo, aplicativo de câmera e recursos de aprendizado de máquina. Usando o recurso de lupa, os usuários podem obter comandos de voz para quaisquer elementos de texto que o aplicativo da câmera escolher.

Aponte e fale para o modo de detecção na lupa

Aponte e fale para o modo de detecção na lupa

Alguns dos outros anúncios incluem dispositivos auditivos feitos para iPhone para usuários com deficiência auditiva, guias de controle de voz para os usuários aprenderem dicas e truques sobre recursos de controle de voz e muito mais mais. A Apple começará a distribuir esses recursos de acessibilidade para usuários de iPhone e iPad até o final deste ano. Então, o que você acha desses novos aprimoramentos de acessibilidade? Você acha que esses recursos irão beneficiá-lo de alguma forma? Comente seus pensamentos abaixo.

FONTE Apple Deixe um comentário