A era da inteligência artificial chegou, e a IA generativa está desempenhando um papel fundamental ao trazer avanços sem precedentes para a tecnologia cotidiana. Já existem várias ferramentas gratuitas de IA que podem ajudá-lo a gerar imagens, textos, músicas, vídeos e muito mais incríveis em poucos segundos. O AI Generative Fill da Adobe no Photoshop e os incríveis recursos do Midjourney realmente nos surpreenderam. Mas, o que exatamente é IA generativa e como ela está alimentando uma inovação tão rápida? Para saber mais, siga nosso explicador detalhado sobre Generative AI.

Índice

Definição: o que é IA generativa?

Como o nome sugere, IA generativa significa um tipo de tecnologia de IA que pode gerar novo conteúdo com base nos dados em que foi treinado. Pode gerar textos, imagens, áudio, vídeos e dados sintéticos. A IA generativa pode produzir uma ampla gama de resultados com base na entrada do usuário ou no que chamamos de “prompts”. A IA generativa é basicamente um subcampo do aprendizado de máquina que pode criar novos dados a partir de um determinado conjunto de dados.

Se o modelo tiver sido treinado em grandes volumes de texto, ele poderá produzir novas combinações de textos com som natural. Quanto maiores os dados, melhor será a saída. Se o conjunto de dados tiver sido limpo antes do treinamento, é provável que você obtenha uma resposta diferenciada.

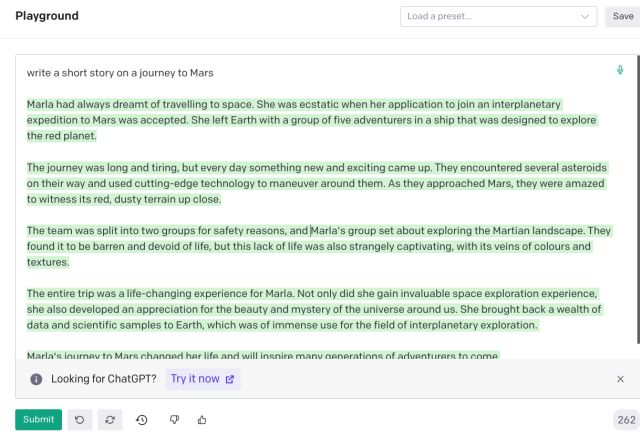

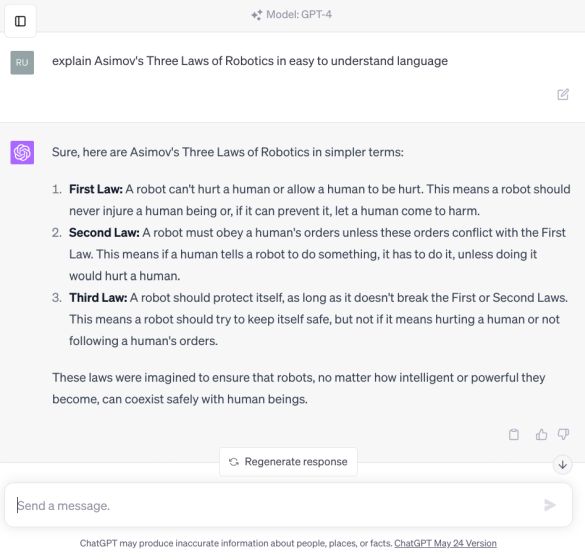

OpenAI Playground

OpenAI Playground

Da mesma forma, se você treinou um modelo com um grande corpus de imagens com marcação de imagens, legendas e muitos exemplos visuais, o modelo AI pode aprender com esses exemplos e realizar a classificação e geração de imagens. Esse sofisticado sistema de IA programado para aprender com exemplos é chamado de rede neural.

Dito isso, existem diferentes tipos de modelos de IA generativa. São redes adversárias generativas (GAN), codificador automático variacional (VAE), transformadores pré-treinados generativos (GPT), modelos autorregressivos e muito mais. Discutiremos brevemente esses modelos generativos abaixo.

Atualmente, os modelos GPT se tornaram populares após o lançamento do GPT-4/3.5 (ChatGPT), PaLM 2 (Google Bard), GPT-3 (DALL – E), LLaMA (Meta), Difusão Estável e outros. Todas essas interfaces de IA fáceis de usar são construídas na arquitetura do Transformer. Portanto, neste explicador, vamos nos concentrar principalmente em IA generativa e GPT (Transformador pré-treinado generativo).

Quais são os diferentes tipos de modelos de IA generativa?

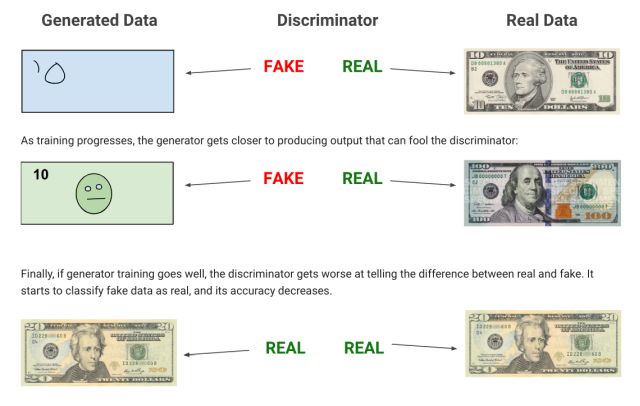

Entre todos os modelos de IA generativa, o GPT é preferido por muitos, mas vamos começar com GAN (Generative Adversarial Network) . Nesta arquitetura são treinadas duas redes paralelas, das quais uma é utilizada para gerar o conteúdo (denominado gerador) e a outra avalia o conteúdo gerado (denominado discriminador).

Basicamente, o objetivo é colocar duas redes neurais uma contra a outra para produzir resultados que reflitam dados reais. Os modelos baseados em GAN têm sido usados principalmente para tarefas de geração de imagens.

GAN (Generative Adversarial Network)/Fonte: Google

GAN (Generative Adversarial Network)/Fonte: Google

A seguir, temos o Variational Autoencoder (VAE), que envolve o processo de codificação, aprendizado, decodificação e geração de conteúdo. Por exemplo, se você tem a imagem de um cachorro, ele descreve a cena como cor, tamanho, orelhas e muito mais, e então aprende que tipo de características um cachorro tem. Depois disso, ele recria uma imagem aproximada usando pontos-chave, dando uma imagem simplificada. Por fim, gera a imagem final após adicionar mais variedade e nuances.

Mudando para modelos autorregressivos, é próximo ao modelo Transformer, mas carece de auto-atenção. É usado principalmente para gerar textos produzindo uma sequência e, em seguida, prevendo a próxima parte com base nas sequências que gerou até agora. Em seguida, temos fluxos de normalização e modelos baseados em energia também. Mas, finalmente, falaremos sobre os modelos populares baseados em Transformer em detalhes abaixo.

O que é um modelo de transformador pré-treinado generativo (GPT)

Antes da chegada da arquitetura do Transformer, Recurrent Redes neurais (RNNs) e redes neurais convolucionais (CNNs) como GANs e VAEs foram extensivamente usadas para IA generativa. Em 2017, pesquisadores que trabalham no Google lançaram um artigo seminal “Atenção é tudo que você precisa” (Vaswani, Uszkoreit, et al., 2017) para avançar no campo da IA generativa e criar algo como um modelo de linguagem grande (LLM).

O Google posteriormente lançou o modelo BERT (Representações de Codificador Bidirecional de Transformers) em 2018, implementando a arquitetura Transformer. Ao mesmo tempo, a OpenAI lançou seu primeiro modelo GPT-1 baseado na arquitetura Transformer.

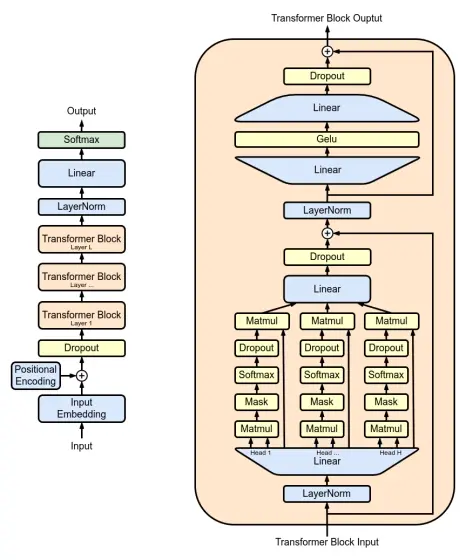

Fonte: Marxav/commons.wikimedia.org

Fonte: Marxav/commons.wikimedia.org

Então, qual foi o ingrediente-chave na arquitetura Transformer que a tornou a favorita para IA generativa? Como o artigo tem o título correto, ele introduziu a autoatenção, que faltava nas arquiteturas de redes neurais anteriores. O que isso significa é que basicamente prevê a próxima palavra em uma frase usando um método chamado Transformer. Ele presta muita atenção às palavras vizinhas para entender o contexto e estabelecer uma relação entre as palavras.

Por meio desse processo, o Transformer desenvolve uma compreensão razoável do idioma e usa esse conhecimento para prever a próxima palavra de maneira confiável. Todo esse processo é chamado de mecanismo de atenção. Dito isso, lembre-se de que os LLMs são desdenhosamente chamados de Stochastic Parrots (Bender, Gebru, et al., 2021) porque o modelo está simplesmente imitando palavras aleatórias com base em decisões probabilísticas e padrões que aprendeu. Não determina a próxima palavra com base na lógica e não possui nenhum entendimento genuíno do texto.

Chegando ao termo”pré-treinado”no GPT, significa que o modelo já foi treinado em uma grande quantidade de dados de texto antes mesmo de aplicar o mecanismo de atenção. Ao pré-treinar os dados, ele aprende o que é uma estrutura de sentença, padrões, fatos, frases, etc. Isso permite que o modelo obtenha uma boa compreensão de como funciona a sintaxe da linguagem.

Como o Google e a OpenAI abordam a IA generativa?

Tanto o Google quanto a OpenAI estão usando modelos baseados em Transformer no Google Bard e ChatGPT, respectivamente. No entanto, existem algumas diferenças importantes na abordagem. O mais recente modelo PaLM 2 do Google usa um codificador bidirecional (mecanismo de auto-atenção e uma rede neural de feed-forward), o que significa que ele pesa em todas as palavras ao redor. Ele essencialmente tenta entender o contexto da frase e então gera todas as palavras de uma vez. A abordagem do Google é essencialmente prever as palavras que faltam em um determinado contexto.

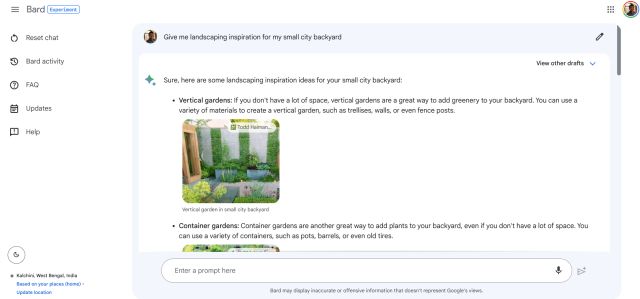

Google Bard

Google Bard

Em contraste, o ChatGPT da OpenAI utiliza a arquitetura Transformer para prever a próxima palavra em uma sequência – da esquerda para a direita. É um modelo unidirecional projetado para gerar frases coerentes. Ele continua a previsão até gerar uma frase completa ou um parágrafo. Talvez seja por isso que o Google Bard é capaz de gerar textos muito mais rápido que o ChatGPT. No entanto, ambos os modelos contam com a arquitetura Transformer em seu núcleo para oferecer front-ends Generative AI.

Aplicações da Generative AI

Todos sabemos que a Generative AI tem uma enorme aplicação não apenas para texto, mas também para imagens, vídeos, geração de áudio e muito mais. Chatbots de IA como ChatGPT, Google Bard, Bing Chat, etc. utilizam IA generativa. Também pode ser usado para preenchimento automático, resumo de texto, assistente virtual, tradução, etc. Para gerar música, vimos exemplos como o Google MusicLM e recentemente o Meta lançou MusicGen para geração de música.

ChatGPT

ChatGPT

Além disso, do DALL-E 2 ao Stable Diffusion, todos usam Generative AI para criar imagens realistas a partir de descrições de texto. Também na geração de vídeo, os modelos Gen-1, StyleGAN 2 e BigGAN da Runway contam com Generative Adversarial Networks para gerar vídeos realistas. Além disso, a IA generativa tem aplicações em gerações de modelos 3D e alguns dos modelos populares são DeepFashion e ShapeNet.

Imagem gerada por Midjourney

Imagem gerada por Midjourney

Além disso, a IA generativa também pode ser de grande ajuda na descoberta de medicamentos. Pode projetar novos medicamentos para uma doença específica. Já vimos modelos de descoberta de medicamentos como o AlphaFold, desenvolvido pelo Google DeepMind. Por fim, a IA generativa pode ser usada para modelagem preditiva para prever eventos futuros em finanças e clima.

Limitações da IA generativa

Embora a IA generativa tenha imensos recursos, ela não é isenta de falhas. Em primeiro lugar, requer um grande corpus de dados para treinar um modelo. Para muitas startups pequenas, dados de alta qualidade podem não estar prontamente disponíveis. Já vimos empresas como Reddit, Stack Overflow e Twitter fechando o acesso aos seus dados ou cobrando altas taxas pelo acesso. Recentemente, The Internet Archive relatou que seu site ficou inacessível por uma hora porque alguma startup de IA começou a martelar seu site em busca de dados de treinamento.

Além disso, os modelos de IA generativa também foram fortemente criticados por falta de controle e viés. Modelos de IA treinados em dados distorcidos da Internet podem representar uma seção da comunidade. Vimos como os geradores de fotos AI geralmente renderizam imagens em tons de pele mais claros. Então, há um enorme problema de vídeo deepfake e geração de imagens usando modelos de IA generativa. Como afirmado anteriormente, os modelos de IA generativa não entendem o significado ou o impacto de suas palavras e geralmente imitam a saída com base nos dados em que foram treinados.

É altamente provável que, apesar dos melhores esforços e alinhamento, desinformação, geração de deepfake, jailbreak e tentativas sofisticadas de phishing usando sua capacidade persuasiva de linguagem natural, as empresas terão dificuldade em domar Generative Limitações da IA.

Deixe um comentário

O RTX 4060 Ti finalmente chegou, chegando com o RTX 4060 básico a um preço atraente o suficiente para fazer os jogadores considerarem atualizar sua placa gráfica. Mas você deveria? Iremos nos aprofundar e comparar o RTX 4060 […]

Há muito debate na internet sobre AR (realidade aumentada) vs VR (realidade virtual), então não adicionarei mais combustível para o fogo, mas uma das coisas que notamos ao usar o Nreal Air é que o VR […]

Existem algumas escolhas de design questionáveis em Redfall, uma mistura da famosa fórmula incompleta de Arkane. Adoro jogos feitos pela Arkane Studios, com Dishonored se tornando um título que revisito de vez em quando por sua jogabilidade emergente única. E […]