Kung tinatalakay mo ang teknolohiya sa 2023, hindi mo maaaring balewalain ang mga trending na paksa tulad ng Generative AI at large language models (LLMs) na nagpapagana sa AI chatbots. Pagkatapos ng paglabas ng ChatGPT ng OpenAI, ang karera sa pagbuo ng pinakamahusay na LLM ay lumago nang multi-fold. Ang malalaking korporasyon, maliliit na startup, at ang open-source na komunidad ay nagsusumikap na bumuo ng pinaka-advanced na malalaking modelo ng wika. Sa ngayon, higit sa daan-daang LLM ang nailabas, ngunit alin ang mga pinaka-may kakayahan? Upang malaman, sundin ang aming listahan ng pinakamahusay na malalaking modelo ng wika (pagmamay-ari at open-source) sa 2023.

Talaan ng mga Nilalaman

1. GPT-4

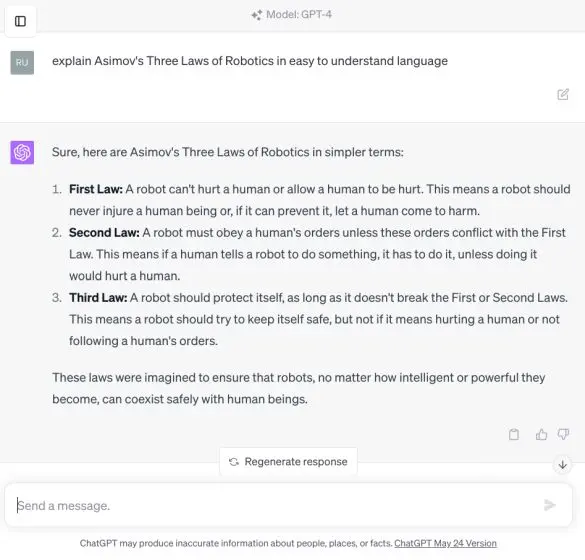

Ang modelo ng GPT-4 ng OpenAI ay ang pinakamahusay na AI large language model (LLM) na available noong 2023. Inilabas noong Marso 2023, ang modelo ng GPT-4 ay nagpakita ng napakalaking kakayahan na may kumplikadong pag-unawa sa pangangatwiran, advanced coding capability, proficiency in multiple academic exams, skills that exhibits human-level performance, at marami pang iba

Sa katunayan, ito ang unang multimodal model na maaaring tumanggap ng parehong mga teksto at larawan bilang input. Bagama’t hindi pa naidagdag ang multimodal na kakayahan sa ChatGPT, ang ilang mga user ay may access sa pamamagitan ng Bing Chat, na pinapagana ng modelong GPT-4.

Malaking bagong bagay sa AI: Ang Microsoft Bing (na gumagamit ng GPT-4 sa Creative Mode), ay tumatanggap ng mga larawan bilang input.

Kahanga-hanga ang mga resulta. Pinakain ko ito ng meme, naiintindihan nito ang konteksto at nagbabasa ng teksto! Kakabukas lang ng bagong dimensyon ng paggamit ng AI. Kaya asahan ang pagdami ng AI Twitter influencer thread… pic.twitter.com/pshP6J44tK— Ethan Mollick (@emollick)

Hunyo 21, 2023

Bukod mula doon, ang GPT-4 ay isa sa napakakaunting LLM na tumugon sa guni-guni at pinahusay na katotohanan ng isang milya. Sa paghahambing sa ChatGPT-3.5, ang modelo ng GPT-4 ay nakakuha ng malapit sa 80% sa mga makatotohanang pagsusuri sa ilang kategorya. Ang OpenAI ay nagtrabaho nang husto upang gawing mas nakaayon ang modelong GPT-4 sa mga halaga ng tao gamit ang Reinforcement Learning from Human Feedback (RLHF) at adversarial testing sa pamamagitan ng mga eksperto sa domain.

Ang modelo ng GPT-4 ay sinanay na sa napakalaking 1+ trilyong parameter at sumusuporta sa maximum na haba ng konteksto na 32,768 token. Hanggang ngayon, wala kaming gaanong impormasyon tungkol sa panloob na arkitektura ng GPT-4, ngunit kamakailan lamang si George Hotz ng The Tiny Corp ipinahayag Ang GPT-4 ay isang modelo ng pinaghalong na may 8 magkakaibang modelo na mayroong 220 bilyong parameter bawat isa. Talaga, hindi ito isang malaking siksik na modelo, gaya ng naintindihan kanina.

GPT-4

Sa wakas, maaari kang gumamit ng mga plugin ng ChatGPT at mag-browse sa web gamit ang Bing gamit ang modelong GPT-4. Ang iilan lang ay ang mabagal na tumugon at ang oras ng hinuha ay mas mataas, na pumipilit sa mga developer na gamitin ang mas lumang modelo ng GPT-3.5. Sa pangkalahatan, ang modelo ng OpenAI GPT-4 ay ang pinakamahusay na LLM na magagamit mo sa 2023, at lubos kong inirerekomenda ang pag-subscribe sa ChatGPT Plus kung balak mong gamitin ito para sa seryosong trabaho. Nagkakahalaga ito ng $20, ngunit kung ayaw mong magbayad, maaari mong gamitin ang ChatGPT 4 nang libre mula sa mga third-party na portal.

2. GPT-3.5

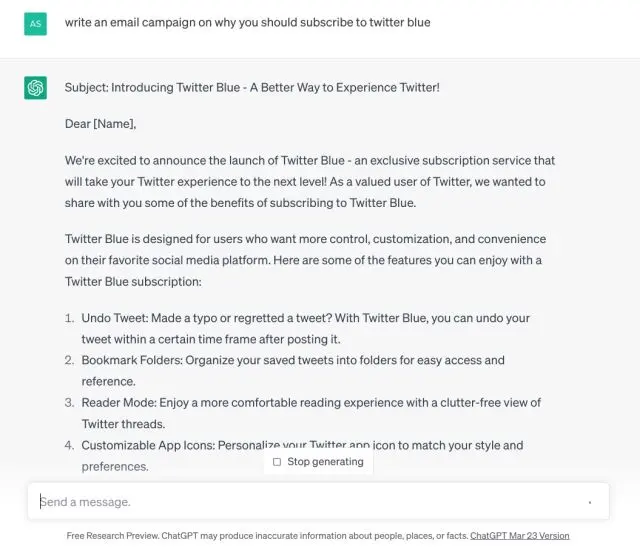

Pagkatapos ng GPT 4, ang OpenAI ay nasa pangalawang puwesto muli gamit ang GPT-3.5. Ito ay isang pangkalahatang layunin na LLM na katulad ng GPT-4 ngunit walang kadalubhasaan sa mga partikular na domain. Kung pinag-uusapan muna ang mga kalamangan, isa itong napakabilis na modelo at bumubuo ng kumpletong tugon sa loob ng ilang segundo.

Kung magtapon ka ng mga malikhaing gawain tulad ng pagsulat ng isang sanaysay sa ChatGPT o pagbuo ng isang plano sa negosyo upang kumita ng pera gamit ang ChatGPT, ang modelo ng GPT-3.5 ay gumaganap ng isang mahusay na trabaho. Bukod dito, naglabas kamakailan ang kumpanya ng mas malaking 16K na haba ng konteksto para sa modelong GPT-3.5-turbo. Huwag kalimutan, libre din itong gamitin at walang oras-oras o araw-araw na paghihigpit.

GPT-3.5

GPT-3.5

Sabi nga, ang pinakamalaking con nito ay ang GPT-3.5 ay nagha-hallucinate nang husto at madalas na naglalabas ng maling impormasyon. Kaya para sa seryosong gawaing pananaliksik, hindi ko iminumungkahi na gamitin ito. Gayunpaman, para sa mga pangunahing tanong sa coding, pagsasalin, pag-unawa sa mga konsepto ng agham, at mga malikhaing gawain, ang GPT-3.5 ay isang magandang modelo.

Sa HumanEval benchmark, ang GPT-3.5 na modelo ay nakakuha ng 48.1% samantalang ang GPT-4 ay nakakuha ng 67%, na siyang pinakamataas para sa anumang pangkalahatang layunin na modelo ng malaking wika. Tandaan, ang GPT-3.5 ay sinanay sa 175 bilyong parameter samantalang ang GPT-4 ay sinanay sa higit sa 1 trilyong parameter.

3. PaLM 2 (Bison-001)

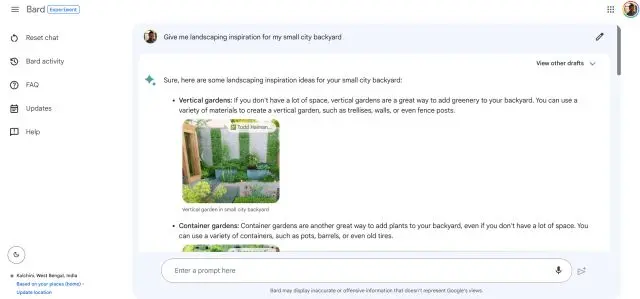

Susunod, mayroon kaming modelong PaLM 2 AI mula sa Google, na niraranggo sa mga pinakamahusay na modelo ng malalaking wika ng 2023. Nakatuon ang Google sa commonsense na pangangatwiran, pormal na lohika, matematika, at advanced na coding sa 20+ na wika sa modelo ng PaLM 2. Sinasabing ang pinakamalaking modelo ng PaLM 2 ay nasanay sa 540 bilyong parameter at may maximum na haba ng konteksto na 4096 token.

Nag-anunsyo ang Google ng apat na modelo batay sa PaLM 2 sa iba’t ibang laki (Gecko, Otter, Bison, at Unicorn). Kung saan, available ang Bison sa kasalukuyan, at nakakuha ito ng 6.40 sa MT-Bench test samantalang ang GPT-4 ay nakakuha ng napakalaking 8.99 na puntos.

Google Bard na tumatakbo sa PaLM 2

Google Bard na tumatakbo sa PaLM 2

Sabi nga, sa mga pagsusuri sa pangangatwiran tulad ng WinoGrande, StrategyQA, XCOPA, at iba pa sa mga pagsusulit, ang PaLM 2 ay gumagawa ng isang kahanga-hangang trabaho at nalampasan ang GPT-4. Isa rin itong multilingual na modelo at nakakaunawa ng mga idyoma, bugtong, at nuanced na teksto mula sa iba’t ibang wika. Ito ay isang bagay na pinaghihirapan ng ibang LLM.

Isa pang bentahe ng PaLM 2 ay napakabilis nitong tumugon at nag-aalok ng tatlong tugon nang sabay-sabay. Maaari mong sundan ang aming artikulo at subukan ang modelo ng PaLM 2 (Bison-001) sa platform ng Vertex AI ng Google. Para sa mga consumer, maaari mong gamitin ang Google Bard na tumatakbo sa PaLM 2.

4. Claude v1

Kung sakaling hindi mo alam, si Claude ay isang makapangyarihang LLM na binuo ng Anthropic, na sinuportahan ng Google. Ito ay co-founded ng mga dating empleyado ng OpenAI at ang diskarte nito ay ang bumuo ng mga AI assistant na kapaki-pakinabang, tapat, at hindi nakakapinsala. Sa maraming benchmark na pagsubok, ang mga modelong Claude v1 at Claude Instant ng Anthropic ay nagpakita ng magandang pangako. Sa katunayan, mas mahusay ang pagganap ni Claude v1 kaysa sa PaLM 2 sa mga pagsusulit sa MMLU at MT-Bench.

Claude sa pamamagitan ng Slack

Claude sa pamamagitan ng Slack

Malapit ito sa GPT-4 at nakakuha ng 7.94 sa MT-Bench test samantalang ang GPT-4 ay 8.99. Sa MMLU benchmark din, si Claude v1 ay nakakuha ng 75.6 puntos, at ang GPT-4 ay nakakuha ng 86.4. Ang Anthropic din ang naging unang kumpanya na nag-aalok ng 100k token bilang pinakamalaking window ng konteksto sa Claude-instant-100k na modelo nito. Maaari kang mag-load ng halos 75,000 salita sa isang window. Iyan ay ganap na baliw, tama? Kung interesado ka, maaari mong tingnan ang aming tutorial kung paano gamitin ang Anthropic Claude ngayon.

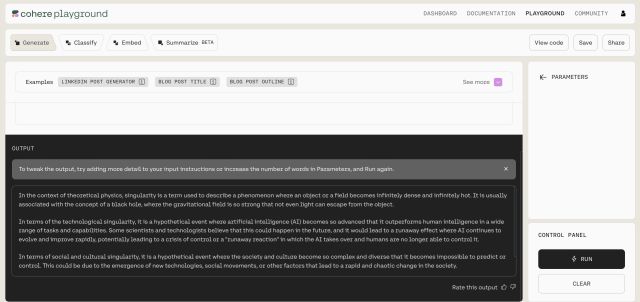

5. Cohere

Ang Cohere ay isang AI startup na itinatag ng mga dating empleyado ng Google na nagtrabaho sa Google Brain team. Isa sa mga co-founder nito, si Aidan Gomez ay bahagi ng papel na”Attention is all you Need”na nagpakilala sa arkitektura ng Transformer. Hindi tulad ng iba pang kumpanya ng AI, narito ang Cohere para sa mga negosyo at nilulutas ang mga generative na kaso ng paggamit ng AI para sa mga korporasyon. Ang Cohere ay may ilang mga modelo mula sa maliit hanggang sa malaki — na may 6B lang na parameter hanggang sa malalaking modelo na sinanay sa 52B na mga parameter.

Ang kamakailang modelo ng Cohere Command ay nanalo ng papuri para sa katumpakan at katatagan nito. Ayon sa Standford HELM, ang modelo ng Cohere Command ay may pinakamataas na marka para sa katumpakan sa mga kasamahan nito. Bukod doon, ang mga kumpanya tulad ng Spotify, Jasper, HyperWrite, atbp. ay lahat ay gumagamit ng modelo ng Cohere upang maghatid ng karanasan sa AI.

Sa mga tuntunin ng pagpepresyo, naniningil ang Cohere ng $15 upang makabuo ng 1 milyong token samantalang ang turbo model ng OpenAI ay naniningil ng $4 para sa parehong halaga ng mga token. Gayunpaman, sa mga tuntunin ng katumpakan, ito ay mas mahusay kaysa sa iba pang mga LLM. Kaya kung nagpapatakbo ka ng negosyo at naghahanap ng pinakamahusay na LLM na isasama sa iyong produkto, maaari mong tingnan ang mga modelo ng Cohere.

6. Falcon

Ang Falcon ay ang unang open-source na malaking modelo ng wika sa listahang ito, at nalampasan nito ang lahat ng open-source na modelo na inilabas sa ngayon, kabilang ang LLaMA, StableLM, MPT, at higit pa. Ito ay binuo ng Technology Innovation Institute (TII), UAE. Ang pinakamagandang bagay tungkol sa Falcon ay ito ay naging open-sourced na may Apache 2.0 na lisensya, na nangangahulugang magagamit mo ang modelo para sa mga layuning pangkomersyo. Wala ring royalty o restrictions.

Sa ngayon, ang TII ay naglabas ng dalawang modelo ng Falcon, na sinanay sa 40B at 7B na mga parameter. Iminumungkahi ng developer na ang mga ito ay mga hilaw na modelo, ngunit kung gusto mong gamitin ang mga ito para sa pakikipag-chat, dapat kang pumunta para sa modelong Falcon-40B-Instruct, na pino-pino para sa karamihan ng mga kaso ng paggamit.

Ang modelo ng Falcon ay pangunahing sinanay sa English, German, Spanish, at French, ngunit maaari rin itong gumana sa Italian, Portuguese, Polish, Dutch, Romanian, Czech, at Swedish na mga wika. Kaya kung interesado ka sa mga open-source na modelo ng AI, tingnan muna ang Falcon.

7. LLaMA

Mula nang mag-leak online ang mga modelo ng LLaMA, naging all-in na ang Meta sa open-source. Opisyal itong naglabas ng mga modelo ng LLaMA sa iba’t ibang laki, mula 7 bilyong parameter hanggang 65 bilyong parameter. Ayon sa Meta, ang modelong LLaMA-13B nito ay higit na mahusay sa modelong GPT-3 mula sa OpenAI na sinanay sa 175 bilyong parameter. Maraming developer ang gumagamit ng LLaMA para maayos at lumikha ng ilan sa mga pinakamahusay na open-source na modelo doon. Sa pagsasabing iyon, tandaan, ang LLaMA ay inilabas para sa pagsasaliksik lamang at hindi magagamit sa komersyo hindi katulad ng modelo ng Falcon ng TII.

Pag-uusapan ang modelong LLaMA 65B, ito ay nagpakita ng kamangha-manghang kakayahan sa karamihan ng mga kaso ng paggamit. Nagra-rank ito sa nangungunang 10 modelo sa Open LLM Leaderboard sa Hugging Face. Sinasabi ng Meta na hindi ito gumamit ng anumang pagmamay-ari na materyal upang sanayin ang modelo. Sa halip, gumamit ang kumpanya ng data na available sa publiko mula sa CommonCrawl, C4, GitHub, ArXiv, Wikipedia, StackExchange, at higit pa.

Sa madaling salita, pagkatapos ng paglabas ng modelong LLaMA ng Meta, ang open-source na komunidad ay nakakita ng mabilis na pagbabago at nakaisip ng mga bagong diskarte upang makagawa ng mas maliliit at mas mahusay na mga modelo.

8. Guanaco-65B

Sa ilang mga modelong nagmula sa LLaMA, ang Guanaco-65B ay naging pinakamahusay na open-source na LLM, pagkatapos lamang ng modelong Falcon. Sa pagsusulit sa MMLU, nakakuha ito ng 52.7 samantalang ang modelo ng Falcon ay nakakuha ng 54.1. Katulad nito, sa TruthfulQA evaluation, nakakuha si Guanaco ng 51.3 na marka at ang Falcon ay mas mataas sa 52.5. May apat na lasa ng Guanaco: 7B, 13B, 33B, at 65B na mga modelo. Lahat ng mga modelo ay pinong-pino sa OASST1 dataset ni Tim Dettmers at iba pang mga mananaliksik.

Kung paano naayos ang Guanaco, nakabuo ang mga mananaliksik ng isang bagong pamamaraan na tinatawag na QLoRA na mahusay na nagpapababa ng paggamit ng memorya habang pinapanatili ang buong 16-bit na pagganap ng gawain. Sa benchmark ng Vicuna, ang modelong Guanaco-65B ay higit na mahusay sa ChatGPT (GPT-3.5 model) na may mas maliit na laki ng parameter.

Ang pinakamagandang bahagi ay ang 65B na modelo ay nagsanay sa isang GPU na mayroong 48GB ng VRAM sa loob lang ng 24 na oras. Ipinapakita nito kung gaano kalayo ang narating ng mga open-source na modelo sa pagbawas ng gastos at pagpapanatili ng kalidad. Kung susumahin, kung gusto mong subukan ang isang offline, lokal na LLM, tiyak na masusubok mo ang mga modelo ng Guanaco.

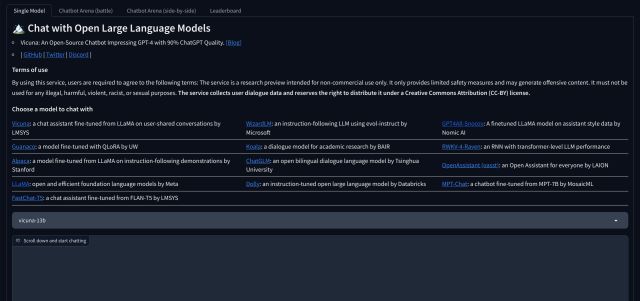

9. Ang Vicuna 33B

Ang Vicuna ay isa pang makapangyarihang open-source na LLM na binuo ng LMSYS. Ito ay nagmula sa LLaMA tulad ng maraming iba pang mga open-source na modelo. Pino-pino ito gamit ang pinangangasiwaang pagtuturo at ang data ng pagsasanay ay nakolekta mula sa sharegpt.com, isang portal kung saan ibinabahagi ng mga user ang kanilang hindi kapani-paniwalang mga pag-uusap sa ChatGPT. Ito ay isang auto-regressive na malaking modelo ng wika at sinanay sa 33 bilyong mga parameter.

Sa sariling MT-Bench test ng LMSYS, nakakuha ito ng 7.12 samantalang ang pinakamahusay na proprietary model, ang GPT-4 ay nakakuha ng 8.99 na puntos. Sa pagsusulit din ng MMLU, nakakuha ito ng 59.2 puntos at nakakuha ng 86.4 puntos ang GPT-4. Sa kabila ng pagiging isang mas maliit na modelo, ang pagganap ng Vicuna ay kapansin-pansin. Maaari mong tingnan ang demo at makipag-ugnayan sa chatbot sa pamamagitan ng pag-click sa link sa ibaba.

10. Ang MPT-30B

Ang MPT-30B ay isa pang open-source na LLM na nakikipagkumpitensya sa mga modelong nagmula sa LLaMA. Ito ay binuo ng Mosaic ML at pinong-tune sa isang malaking corpus ng data mula sa iba’t ibang mga mapagkukunan. Gumagamit ito ng mga dataset mula sa ShareGPT-Vicuna, Camel-AI, GPTeacher, Guanaco, Baize, at iba pang source. Ang pinakamagandang bahagi tungkol sa open-source na modelong ito ay mayroon itong haba ng konteksto na 8K token.

Dagdag pa rito, nahihigitan nito ang GPT-3 na modelo ng OpenAI at nakakuha ng 6.39 sa MT-Bench test ng LMSYS. Kung naghahanap ka ng isang maliit na LLM na tatakbo nang lokal, ang modelong MPT-30B ay isang mahusay na pagpipilian.

11. 30B-Lazarus

Ang modelong 30B-Lazarus ay binuo ng CalderaAI at ginagamit nito ang LLaMA bilang batayan nitong modelo. Gumamit ang developer ng mga dataset na nakatutok sa LoRA mula sa maraming modelo, kabilang ang Manticore, SuperCOT-LoRA, SuperHOT, GPT-4 Alpaca-LoRA, at higit pa. Bilang resulta, mas mahusay ang pagganap ng modelo sa maraming mga benchmark ng LLM. Nakakuha ito ng 81.7 sa HellaSwag at 45.2 sa MMLU, pagkatapos lamang ng Falcon at Guanaco. Kung ang iyong kaso ng paggamit ay halos pagbuo ng teksto at hindi pakikipag-usap sa pakikipag-usap, ang 30B Lazarus na modelo ay maaaring isang mahusay na pagpipilian.

12. WizardLM

Ang WizardLM ay ang aming susunod na open-source na malaking modelo ng wika na binuo upang sundin ang mga kumplikadong tagubilin. Ang isang pangkat ng mga mananaliksik ng AI ay nakabuo ng isang Evol-instruct na diskarte upang muling isulat ang paunang hanay ng mga tagubilin sa mas kumplikadong mga tagubilin. At ang nabuong data ng pagtuturo ay ginagamit upang i-fine-tune ang modelo ng LLaMA.

Dahil sa diskarteng ito, mas mahusay na gumaganap ang modelo ng WizardLM sa mga benchmark at mas gusto ng mga user ang output mula sa WizardLM kaysa sa mga tugon sa ChatGPT. Sa pagsusulit sa MT-Bench, nakakuha ang WizardLM ng 6.35 puntos at 52.3 sa pagsusulit sa MMLU. Sa pangkalahatan, para lamang sa 13B na mga parameter, ang WizardLM ay gumagawa ng isang magandang trabaho at nagbubukas ng pinto para sa mas maliliit na modelo.

Bonus: GPT4All

Ang GPT4ALL ay isang proyektong pinapatakbo ng Nomic AI. Inirerekomenda ko ito hindi lamang para sa in-house na modelo nito ngunit upang patakbuhin ang mga lokal na LLM sa iyong computer nang walang anumang nakatalagang GPU o koneksyon sa internet. Nakabuo ito ng 13B Snoozy na modelo na gumagana nang maayos. Sinubukan ko ito sa aking computer nang maraming beses, at ito ay bumubuo ng mga tugon nang medyo mabilis, dahil mayroon akong isang entry-level na PC. Gumamit din ako ng PrivateGPT sa GPT4All, at talagang sumagot ito mula sa custom na dataset.

Bukod dito, naglalaman ito ng 12 open-source na modelo mula sa iba’t ibang organisasyon. Karamihan sa mga ito ay binuo sa 7B at 13B na mga parameter at tumitimbang ng humigit-kumulang 3 GB hanggang 8 GB. Pinakamaganda sa lahat, makakakuha ka ng isang installer ng GUI kung saan maaari kang pumili ng isang modelo at simulang gamitin ito kaagad. Walang kalikot sa Terminal. Sa madaling salita, kung gusto mong magpatakbo ng lokal na LLM sa iyong computer sa paraang madaling gamitin, GPT4All ang pinakamahusay na paraan para gawin ito.

Mag-iwan ng komento

Narito na sa wakas ang RTX 4060 Ti, na dumarating kasama ang base RTX 4060 sa isang sapat na kaakit-akit na punto ng presyo upang mapag-isipan ng mga manlalaro na i-upgrade ang kanilang graphics card. Ngunit dapat ba? Magiging malalim at ihahambing natin ang RTX 4060 […]

Maraming debate sa internet tungkol sa AR (augmented reality) vs VR (virtual reality), kaya hindi na ako magdadagdag ng gasolina sa ang sunog, ngunit ang isa sa mga bagay na napansin namin habang ginagamit ang Nreal Air ay ang VR […]

May ilang kaduda-dudang pagpipilian sa disenyo sa Redfall, isang mishmash ng kalahating-baked na sikat na formula ng Arkane. Gustung-gusto ko ang mga laro na ginawa ng Arkane Studios, na ang Dishonored ay naging isang pamagat na muli kong binibisita paminsan-minsan para sa kakaibang lumilitaw na gameplay nito. At […]