Apple Vision Pro, Apples neues „Spatial Computing“-Gerät, verfügt nicht über einen hardwarebasierten Steuerungsmechanismus. Es basiert auf Eye-Tracking und Handgesten, um Benutzern die Manipulation von Objekten im virtuellen Raum vor ihnen zu ermöglichen. In einer kürzlich durchgeführten Entwicklersitzung haben Apple-Designer die spezifischen Gesten beschrieben, die mit Vision Pro verwendet werden können, und wie einige der Interaktionen funktionieren werden.

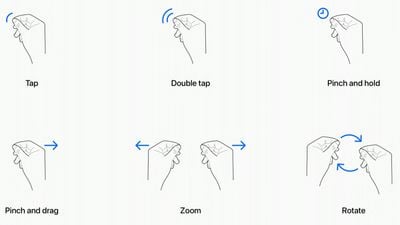

Tippen – Durch gleichzeitiges Tippen von Daumen und Zeigefinger wird dem Headset signalisiert, dass Sie auf ein virtuelles Element tippen möchten das Display, das Sie betrachten. Benutzer haben dies auch als Kneifen beschrieben und es entspricht dem Tippen auf den Bildschirm eines iPhones. Doppeltippen – Durch zweimaliges Tippen wird eine Doppeltipp-Geste ausgelöst. Ziehen und Halten – Das Zusammenziehen und Halten ähnelt einer Geste zum Tippen und Halten und bewirkt beispielsweise das Hervorheben von Text. Pinch and Drag – Durch Pinch-und Ziehbewegungen können Fenster gescrollt und verschoben werden. Sie können horizontal oder vertikal scrollen, und wenn Sie Ihre Hand schneller bewegen, können Sie schneller scrollen. Zoom – Zoom ist eine der beiden wichtigsten zweihändigen Gesten. Sie können Ihre Finger zusammenziehen und Ihre Hände auseinanderziehen, um hineinzuzoomen, und vermutlich wird das Herauszoomen zu einer schiebenden Bewegung führen. Fenstergrößen können auch durch Ziehen an den Ecken angepasst werden. Drehen – Drehen ist die andere zweihändige Geste und basiert auf der Apple-Tabelle. Dabei werden die Finger zusammengedrückt und die Hände gedreht, um virtuelle Objekte zu manipulieren.

Gesten funktionieren parallel zu den Augenbewegungen und die vielen Kameras im Vision Pro verfolgen mit großer Genauigkeit, wohin Sie schauen. Die Augenposition ist ein Schlüsselfaktor bei der gezielten Ausrichtung auf das, mit dem Sie mit Handgesten interagieren möchten. Wenn Sie sich beispielsweise ein App-Symbol oder ein Element auf dem Bildschirm ansehen, wird es gezielt darauf ausgerichtet und hervorgehoben. Anschließend können Sie eine Geste ausführen.

Handgesten sind nicht erforderlich Sei großartig und du kannst deine Hände im Schoß behalten. Apple fördert dies sogar, denn es verhindert, dass Ihre Hände und Arme durch das Halten in der Luft ermüden. Sie brauchen nur eine kleine Pinch-Geste, die einem Tippen entspricht, da die Kameras präzise Bewegungen verfolgen können.

Mit dem, was Sie sehen, können Sie Objekte auswählen und manipulieren, die sich sowohl in Ihrer Nähe als auch in der Ferne befinden von Ihnen, und Apple rechnet mit Szenarien, in denen Sie möglicherweise größere Gesten verwenden möchten, um Objekte zu steuern, die sich direkt vor Ihnen befinden. Sie können Ihre Fingerspitzen ausstrecken und mit ihnen interagieren, um mit ihnen zu interagieren. Wenn Sie beispielsweise ein Safari-Fenster direkt vor sich haben, können Sie Ihre Hand ausstrecken und von dort aus scrollen, anstatt Ihre Finger in Ihrem Schoß zu verwenden.

Zusätzlich zu Gesten unterstützt das Headset Handbewegungen wie das Tippen in der Luft, obwohl es den Anschein hat, dass diejenigen, die eine Demoversion erhalten haben, diese Funktion bisher noch nicht ausprobieren konnten. Gesten funktionieren natürlich auch zusammen, und um beispielsweise eine Zeichnung zu erstellen, schauen Sie auf eine Stelle auf der Leinwand, wählen mit der Hand einen Pinsel aus und zeichnen mit einer Geste in die Luft. Wenn Sie anderswo suchen, können Sie den Cursor sofort dorthin bewegen, wo Sie suchen.

Während dies die sechs wichtigsten Systemgesten sind, die Apple beschrieben hat, können Entwickler benutzerdefinierte Gesten für ihre Apps erstellen das andere Aktionen ausführt. Entwickler müssen sicherstellen, dass sich benutzerdefinierte Gesten von den Systemgesten oder üblichen Handbewegungen unterscheiden, die Benutzer möglicherweise verwenden, und dass die Gesten ohne Belastung der Hände häufig wiederholt werden können.

Zur Ergänzung von Hand-und Augengesten Bluetooth An das Headset können Tastaturen, Trackpads, Mäuse und Gamecontroller angeschlossen werden, außerdem gibt es sprachbasierte Such-und Diktiertools.

Mehrere Personen, die das Vision Pro ausprobieren konnten, hatten das Gleiche Wort zur Beschreibung des Steuerungssystems – intuitiv. Die Designer von Apple scheinen es so konzipiert zu haben, dass es ähnlich wie Multitouch-Gesten auf dem „iPhone“ und dem iPad funktioniert, und bisher waren die Reaktionen positiv.