Les utilisateurs d’appareils Apple n’auront peut-être même pas besoin d’appeler le mot”Siri”à l’avenir, Apple recherchant des moyens d’utiliser la détection du regard pour qu’un appareil sache qu’il est recherché.

Les propriétaires de plusieurs appareils dans l’écosystème Apple seront familiarisés avec l’un des problèmes les moins connus de l’utilisation de Siri, à savoir le faire fonctionner sur un appareil et pas sur un autre. Lorsque vous vous trouvez dans une pièce contenant un iPhone, un iPad et un HomePod mini, il peut être difficile de déterminer quel appareil répondra réellement à une requête, et ce n’est peut-être pas nécessairement l’appareil souhaité.

De plus, tout le monde ne se sent pas à l’aise avec l’utilisation de l’invite”Hey Siri”, c’est pourquoi Apple a récemment annoncé la réduire à”Siri”, ou du moins sur certains appareils.

Même ainsi, les utilisations erronées de”Siri”ou”Hey Siri”-et les phrases de déclenchement d’autres assistants numériques-à la télévision et à la radio peuvent toujours provoquer des requêtes que les utilisateurs ne souhaitent peut-être pas avoir.

Ensuite, il est également possible que les utilisateurs aient besoin d’interagir avec des appareils sans utiliser leur voix du tout. Il peut bien sûr y avoir des situations où une commande doit être émise à distance, ou où il peut être socialement gênant de parler à l’appareil.

Dans un brevet nouvellement délivré intitulé”Device control using gaze informations”, Apple suggère qu’il pourrait être possible de commander visuellement Siri. Plus précisément, il propose que les appareils puissent détecter le regard d’un utilisateur pour déterminer si cet utilisateur souhaite que cet appareil réponde.

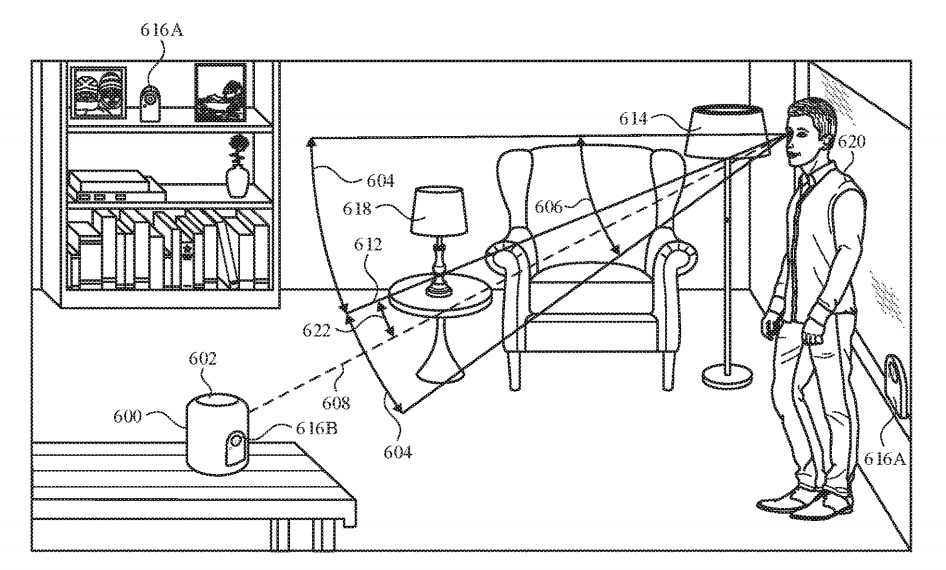

Le dossier suggère un système qui utilise des caméras et d’autres capteurs capables de déterminer l’emplacement d’un utilisateur et la trajectoire de son regard, pour déterminer ce qu’il regarde. Ces informations pourraient être utilisées pour régler automatiquement le dispositif regardé pour qu’il passe dans un mode d’acceptation d’instructions où il écoute activement, dans l’attente que des instructions lui soient transmises.

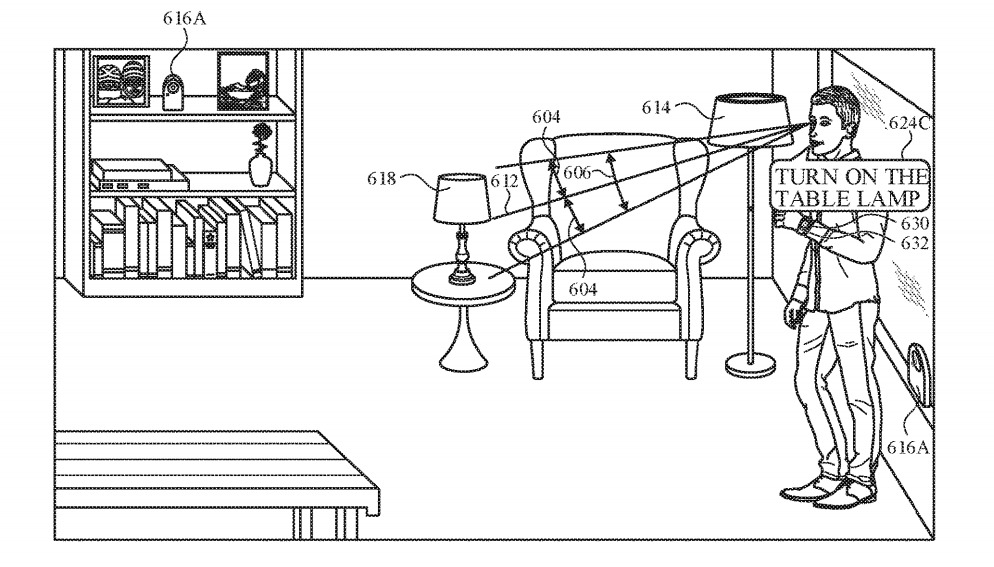

Si l’assistant numérique interprète ce qui pourrait être une commande dans cet état, il peut alors l’exécuter comme si le déclencheur verbal avait été dit au préalable, évitant ainsi une étape aux utilisateurs. Cela permettrait toujours à des phrases comme”Hey Siri”de fonctionner, en particulier lorsque l’utilisateur ne regarde pas l’appareil.

Utiliser le regard comme baromètre pour savoir si l’utilisateur veut dire une commande à l’assistant numérique est également utile à d’autres égards. Par exemple, le regard détecté en regardant l’appareil pourrait confirmer que l’utilisateur a activement l’intention que l’appareil suive les commandes.

Concrètement, cela pourrait signifier la différence entre l’appareil interprétant un fragment de phrase tel que”jouer Elvis”comme une commande ou comme faisant partie d’une conversation qu’il devrait autrement ignorer.

Pour les propriétaires de plusieurs appareils, la détection du regard pourrait permettre d’envoyer une instruction à un appareil et pas aux autres, distingués en le regardant.

Le dossier mentionne que le simple fait de regarder l’appareil ne sera pas nécessairement enregistré comme une intention pour lui d’écouter les instructions, car un ensemble de”critères d’activation”doit être rempli. Cela pourrait simplement consister en un regard continu pendant une période de temps, comme une seconde, pour éliminer les regards mineurs ou les faux positifs d’une personne qui tourne la tête.

L’angle de la position de la tête est également important. Par exemple, si l’appareil est situé sur une table de chevet et que l’utilisateur est endormi dans son lit, l’appareil pourrait potentiellement compter l’utilisateur faisant face à l’appareil comme un regard en fonction de la façon dont il est allongé, mais pourrait l’écarter en tant que tel pour réaliser l’utilisateur. la tête est sur le côté au lieu d’être verticale.

En réponse, un appareil peut fournir un certain nombre d’indicateurs à l’utilisateur indiquant que l’assistant a été activé par un coup d’œil, comme un bruit ou un motif lumineux provenant de LED intégrées ou d’un écran.

Étant donné la possibilité d’enregistrer le regard d’un utilisateur, il serait également possible que le système détecte si l’utilisateur regarde un objet avec lequel il souhaite interagir, plutôt que l’appareil contenant l’assistant virtuel. Par exemple, un utilisateur peut regarder l’une des multiples lampes de la pièce, et l’appareil peut utiliser le contexte du regard de l’utilisateur pour déterminer quelle lampe l’utilisateur souhaite allumer à partir d’une commande.

Les appareils à proximité pourraient détecter le regard de l’utilisateur sur d’autres objets contrôlables dans une pièce.

Déposé à l’origine le 28 août 2019, le brevet répertorie ses inventeurs comme Sean B. Kelly, Felipe Bacim De Araujo E Silva et Karlin Y. Bark.

Apple dépose de nombreuses demandes de brevet chaque semaine, mais bien que l’existence d’un brevet indique des domaines d’intérêt pour ses efforts de recherche et développement, ils ne garantissent pas que le brevet sera utilisé dans un futur produit ou service.

La possibilité de faire fonctionner un appareil à distance est apparue à plusieurs reprises dans les dépôts de brevets antérieurs. Par exemple, un brevet de 2015 pour une”estimation basée sur l’apprentissage de la pose de la main et des doigts”suggérait l’utilisation d’un système de cartographie optique 3D pour les gestes de la main, un système qui pourrait être similaire dans son concept au matériel Kinect de Microsoft.

Un autre dépôt de 2018 pour un”système informatique ou de divertissement multimédia pour répondre à la présence et à l’activité de l’utilisateur”propose l’introduction de données de capteurs tridimensionnelles pour produire une carte de profondeur de la pièce, qui pourrait être utilisé pour la reconnaissance des gestes dans toute la pièce.

La détection du regard a également été largement explorée, plus récemment avec le casque Apple Vision Pro.