iOS 15は、多くの機能を備えています。オペレーティングシステムの重要な改善点の1つは、画像からテキストを抽出する機能です。ライブテキストと呼ばれるiOS15を使用すると、電話番号を間違えたり、カメラから直接Webサイトにアクセスしたりすることが簡単になります。 Androidデバイスには、Googleレンズと呼ばれるこの機能がかなり前からあります。 iOS15のライブテキストとAndroid12のGoogleレンズの比較はどうですか?掘り下げてみましょう。

詳細な

<!-EndEzoic-ラップされたsidebar_bottom-sidebar_bottom->

ライブテキストとGoogleレンズ:テキスト認識

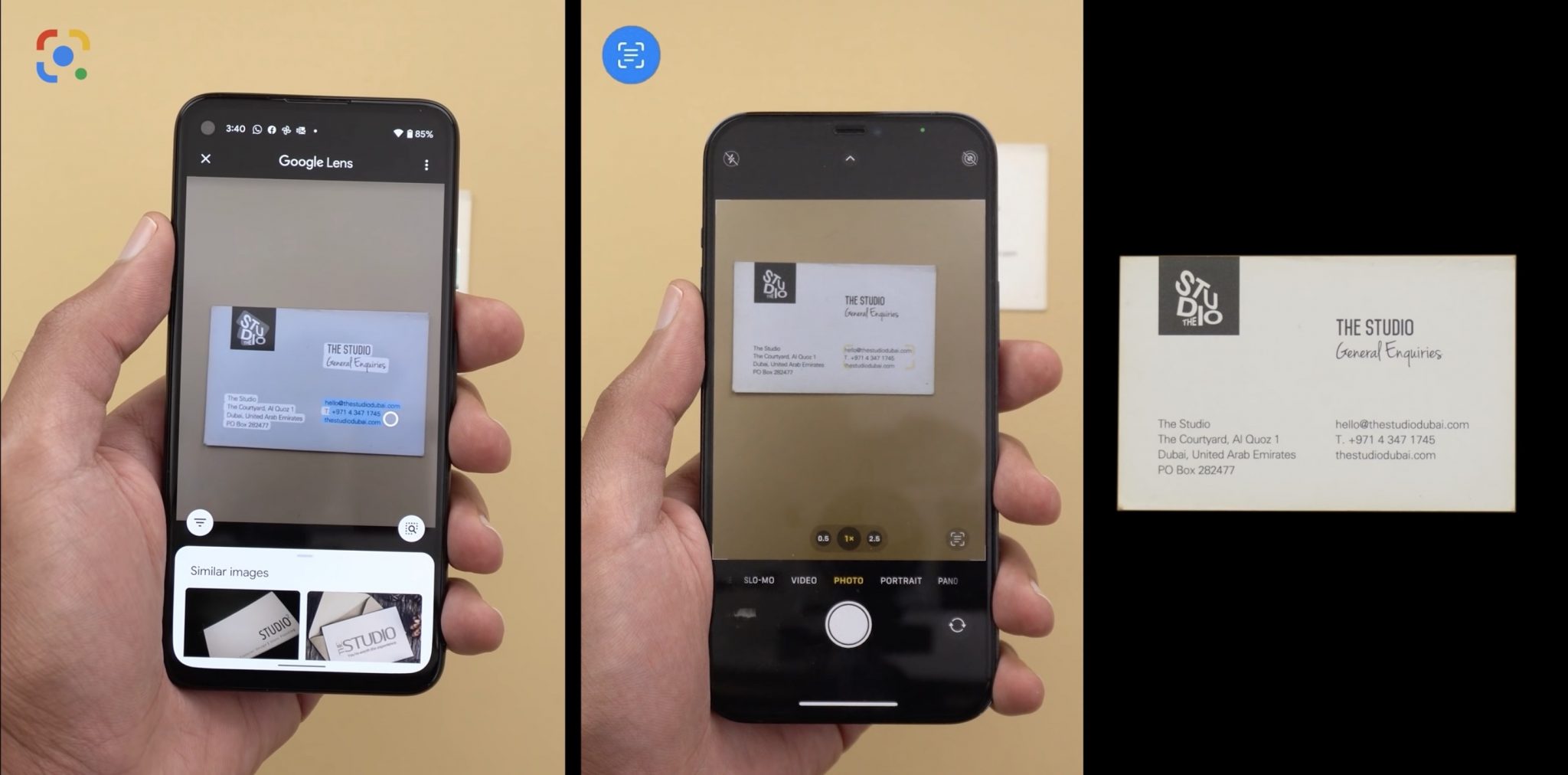

YouTuberはテストを6つの部分に分けました。最初のもの、そして最も重要なものは、テキスト認識が両方でどれだけうまく機能するかです。 iOS 15は、Spotlgithからテキストを直接検索できるため、より優れたテキスト認識システムを備えています。画像に移動してテキストを選択する必要はありません。探しているテキストをSpotlightに直接入力することで、直接検索できます。

連絡先カードやパンフレットなど、テキストが印刷されている画像からテキストを抽出する場合、Googleレンズとライブテキストの両方が問題なく機能しました。ただし、手書きの画像からテキストを抽出する際には、Googleレンズが主導権を握りました。全体として、両方のテキスト抽出サービスは問題なく機能しました。

テキストの翻訳

コンピューターから取得した画像からテキストを翻訳する場合、Googleレンズとライブテキストの両方が正常に機能しました。ただし、ここでも、手書きの画像からテキストを翻訳する場合、Googleレンズはテキストをより適切に翻訳しました。

ビジュアルルックアップ

<!-End Ezoic--mid_content--mid_content->

Visual Lookupは、ランドマークの情報を直接提供するiOS15の機能です。写真アプリから。 Googleレンズはすでにこのことを行うことができ、オブジェクトを検索する機能も追加されています。予想通り、Live Textは現在オブジェクトを認識していないため、Lensがトップになりました。画像からランドマークを抽出する場合でも、ライブテキストはドバイのトレランス橋をニューキャッスルのミレニアムブリッジとして識別する際に誤りを犯しました。

このテストから、LiveTextは現在まだベータ版であることが明らかです。 Appleは今後数日間でソフトウェアをさらに微調整し、発売が近づくにつれてこれについてさらに報告します。

iOS 15の新しいライブテキスト機能を試してみたいですか? iOS 15 Beta1をダウンロードしてインストールできます。今すぐiPhoneを。

個人的な話ですが、私はまだiOS 15のライブテキストのファンです。Spotlightから直接、任意の画像から任意のテキストを検索できるという事実に興奮しました。ライブテキストはもう試しましたか? GoogleレンズとAppleのライブテキストのどちらが好きですか?なぜあなたはそれを他のものより好むのですか?下記のコメントセクションでお知らせください!

<!-この投稿のように?共有してください!-> <!-

->