Apple の新しい「空間コンピューティング」デバイスである Apple Vision Pro には、ハードウェアベースの制御メカニズムがありません。これは視線追跡と手のジェスチャーを利用して、ユーザーが目の前の仮想空間内のオブジェクトを操作できるようにします。 最近の開発者セッションで、Apple のデザイナーは Vision Pro で使用できる特定のジェスチャの概要を説明しました。

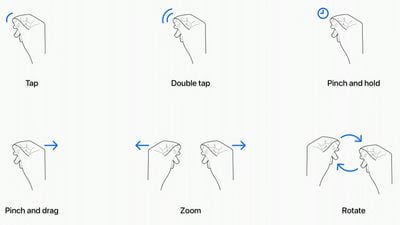

タップ-親指と人差し指を一緒にタップすると、ヘッドセットに仮想要素をタップするよう通知されます。あなたが見ているディスプレイ。ユーザーはこれをピンチとも表現しており、iPhone の画面をタップするのと同じです。 ダブルタップ-2 回タップすると、ダブルタップ ジェスチャが開始されます。 ピンチ アンド ホールド-ピンチ アンド ホールドはタップ アンド ホールド ジェスチャに似ており、テキストのハイライト表示などの操作を行います。 ピンチとドラッグ-ピンチとドラッグを使用して、ウィンドウをスクロールしたり移動したりできます。水平方向または垂直方向にスクロールでき、手を速く動かすとより速くスクロールできます。 ズーム-ズームは、2 つの主要な両手操作ジェスチャのうちの 1 つです。指をつまんで両手を離すとズームインできますが、ズームアウトすると押し込むような動作になると思われます。ウィンドウのサイズは、隅をドラッグして調整することもできます。 回転-回転はもう 1 つの両手ジェスチャで、Apple のチャートに基づくと、指をつまんで手を回転させて仮想オブジェクトを操作します。

ジェスチャーは目の動きと連動し、Vision Pro の多数のカメラがユーザーが見ている場所を非常に正確に追跡します。目の位置は、手のジェスチャーを使用して操作したい対象をターゲットにする際の重要な要素になります。たとえば、アプリのアイコンや画面上の要素を見ると、それがターゲットとなって強調表示され、ジェスチャーでフォローアップできます。

手のジェスチャーは必要ありません堂々としていれば、膝の上に手を置いても大丈夫です。実際、Apple はこれを奨励しています。なぜなら、空中に保持されても手や腕が疲れないからです。カメラは正確な動きを追跡できるため、タップに相当する小さなピンチ ジェスチャのみが必要です。

見ているものによって、近くにあるオブジェクトと遠くにあるオブジェクトの両方を選択して操作できます。そして Apple は、ユーザーが目の前にあるオブジェクトを制御するために、より大きなジェスチャーを使用したいというシナリオを予測しています。手を伸ばして指先を使ってオブジェクトを操作できます。たとえば、目の前に Safari ウィンドウがある場合、膝の上で指を使うのではなく、手を伸ばしてそこからスクロールできます。

ヘッドセットはジェスチャーに加えて、エア タイピングなどの手の動きもサポートしますが、デモを受け取った人はまだこの機能を試すことができていないようです。もちろん、ジェスチャは連携して機能します。描画の作成などを行うには、キャンバス上の点を見て、手でブラシを選択し、空中でジェスチャを使用して描画します。他の場所を見ている場合は、探している場所にカーソルをすぐに移動できます。

これらは Apple が説明した 6 つの主要なシステム ジェスチャですが、開発者はアプリ用にカスタム ジェスチャを作成できます。他のアクションを実行します。開発者は、カスタム ジェスチャがシステム ジェスチャや人々が使用する一般的な手の動きとは区別されていること、および手の負担なくジェスチャを頻繁に繰り返すことができることを確認する必要があります。

手と目のジェスチャを補うために、Bluetooth を使用します。キーボード、トラックパッド、マウス、ゲーム コントローラーをヘッドセットに接続でき、音声ベースの検索ツールやディクテーション ツールもあります。

Vision Pro を試すことができた複数の人が同じように感じました。制御システムを表す言葉-直感的。 Apple のデザイナーは、「iPhone」や iPad のマルチタッチ ジェスチャと同じように動作するようにこの機能を作成したようで、これまでのところ、反応は良好です。