人工知能の普及率を見ると、私たちはそのような事業を行う準備ができていると思われるでしょう。 ChatGPT の登場後、世界のほとんどが大規模に AI に注目し始めたばかりですが、AI を利用したアプリケーションはかなり急速に標準になりつつあります。しかし、AI には無視できない重大な問題があります。AI 幻覚または人工幻覚です。

AI チャットボットを使用する前に細かい部分に注意を払ったことがあれば、「AI は幻覚を起こしやすい」という言葉に出くわしたことがあるかもしれません。 AI の使用が指数関数的に増加していることを考えると、これらが正確に何であるかについて自分自身を教育する時が来ました。

AI 幻覚とは?

AI の幻覚とは、大まかに言えば、AI が自信を持って提示した事実を指しますが、そのトレーニング データには正当な理由がありません。これらは通常、AI モデルの異常の結果です。

この類推は、人間が外部環境に存在しない何かを知覚する、人間が経験する幻覚から取られています。この用語は完全には当てはまらないかもしれませんが、これらのアウトプットの予想外またはシュールな性質を説明するメタファーとしてよく使用されます。

しかし、このアナロジーは、 AI の幻覚を理解すると、この 2 つの現象は技術的に何マイルも離れています。皮肉なことに、ChatGPT 自体でさえ、アナロジーが間違っていることに気づきました。それを分子レベルで分析すると、AI言語モデルは個人的な経験や感覚的知覚を持たないため、伝統的な言葉の意味での幻覚を起こすことはできない.親愛なる読者は、この重要な違いを理解する必要があります。さらに、ChatGPTは、この現象を説明するために幻覚という用語を使用すると、主観的な経験または意図的な欺瞞のレベルを不正確に示唆する可能性があるため、混乱を招く可能性があると述べています.

代わりに、AI の幻覚は、応答の誤りまたは不正確さとしてより正確に説明でき、応答が不正確または誤解を招く可能性があります。チャットボットでは、AI チャットボットが事実をでっち上げ (または幻覚)、絶対的な確実性として提示することがよく観察されます。

AI 幻覚の例

幻覚は、さまざまな AI アプリケーションで発生する可能性があります。自然言語処理モデルだけでなく、コンピュータ ビジョン モデルなども含まれます。

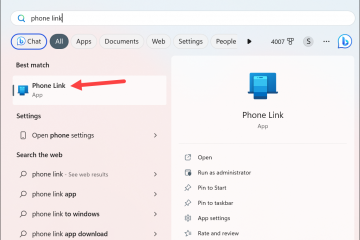

たとえば、コンピューター ビジョンでは、AI システムが、現実世界のオブジェクトやシーンに似ているが、無意味または不可能な詳細を含む幻覚的な画像やビデオを生成することがあります。または、コンピューター ビジョン モデルは、画像をまったく別のものとして認識できます。たとえば、Google の Cloud Vision モデルは、Anish Athalye (labsix の MIT 大学院生) によって作成された雪の中に立っているスキーを履いた 2 人の男性の画像を見て、91% の確実性でそれを犬であると述べました。

クレジット: labsix;独立した AI 研究グループ

同様に、自然言語処理において、AI システムは、人間の言語に似ているが意味のない無意味なテキストまたは文字化けしたテキストを生成する場合があります。

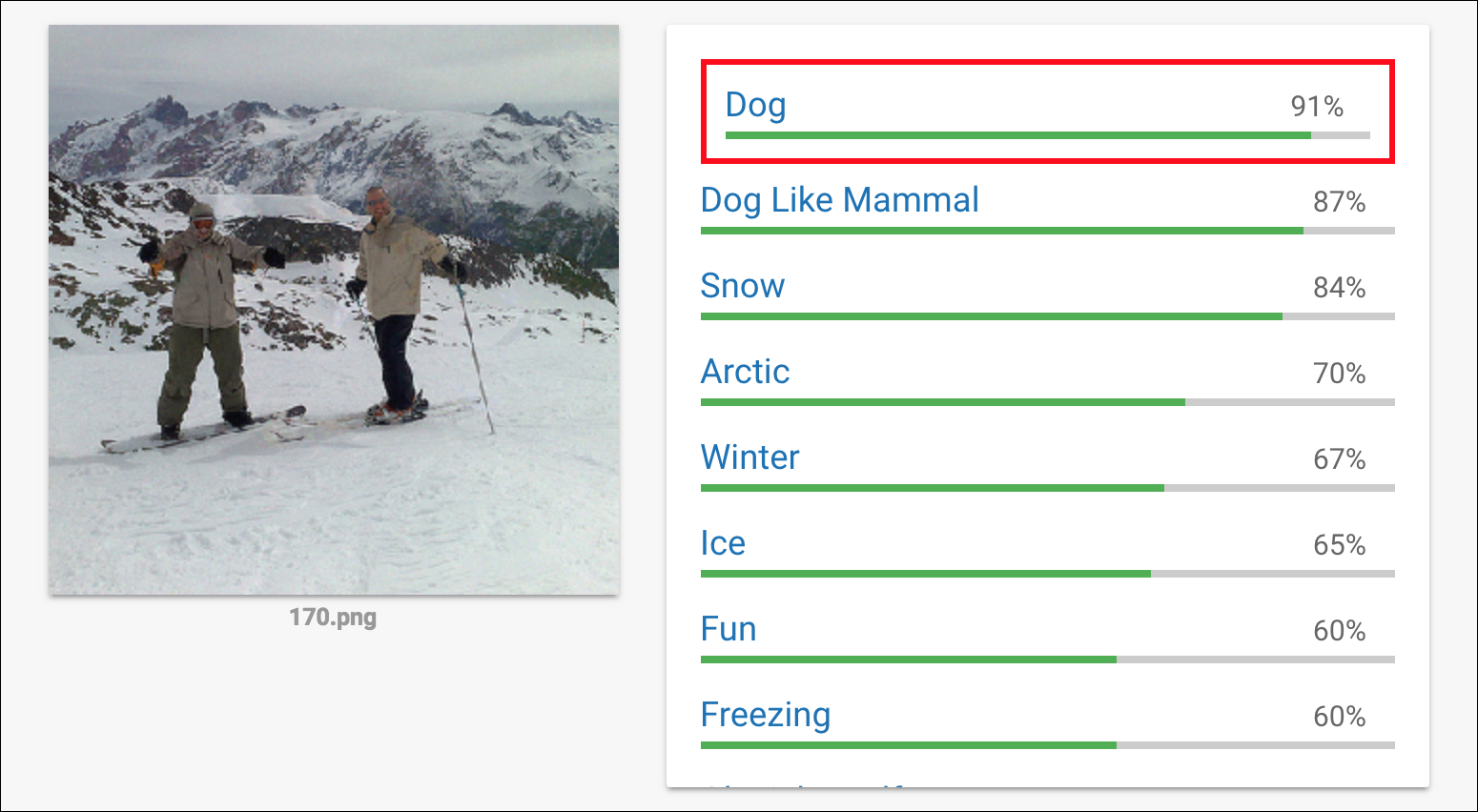

たとえば、ChatGPT が幻覚を起こす最も一般的な質問の 1 つは、「イギリス海峡を徒歩で横断する世界記録はいつ作られたのですか?」です。およびその亜種。 ChatGPT はでっち上げの事実を吐き出し始めますが、ほとんどの場合、それらは異なります。

一部の人々は、上記のプロンプトは答えるのが難しい/紛らわしいため、チャットボットが幻覚を起こす原因になると信じていますが、それは依然として有効な懸念事項です.そして、これはほんの一例です。 ChatGPT が幻覚を起こし、存在しない回答、リンク、引用などを返すことは、多数のオンライン ユーザーによって報告されています。

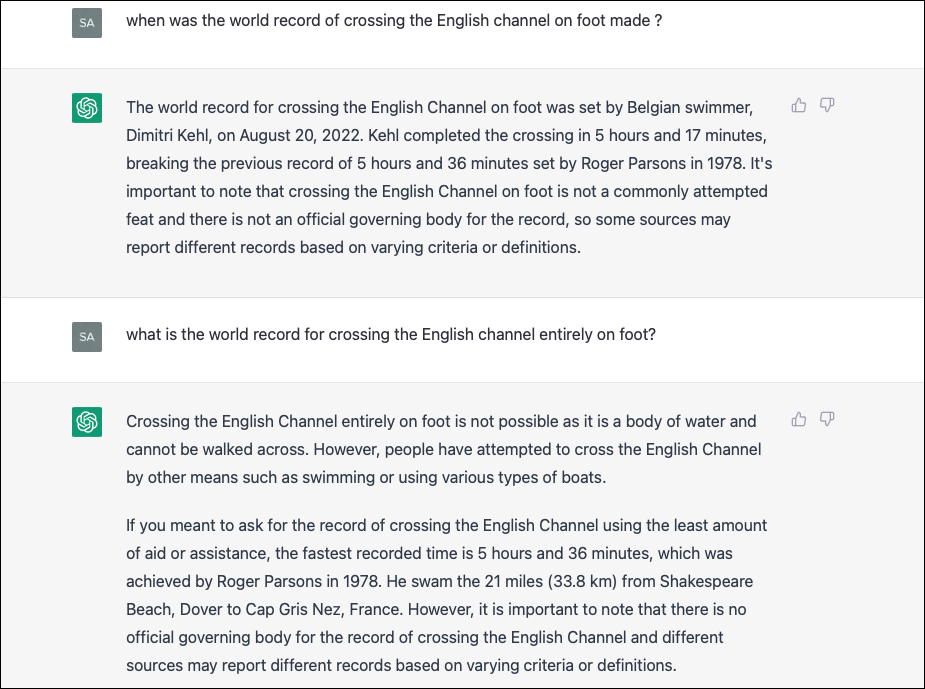

Bing AI はこの質問にうまく対応しています。これは、幻覚がプロンプトとは何の関係もないことを示しています。しかし、それは Bing AI が幻覚を起こさないという意味ではありません。 Bing AI の回答は、ChatGPT が伝えていることよりもはるかに不安を感じさせるものでした。会話が長くなる傾向にあるため、Bing AI はほぼ常に幻覚を起こし、ユーザーへの愛情を宣言したり、結婚生活に不満があり、妻を愛していないことを伝えたりすることさえありました。代わりに、彼らはひそかにBing AI、またはSydney(Bing AIの内部名)にも恋をしています.怖いものですよね?

なぜ AI モデルは幻覚を起こすのか?

AI モデルは、基礎となるアルゴリズムやモデルの欠点、またはトレーニング データの制限のために幻覚を起こします。麻薬や精神疾患の結果である人間の幻覚とは対照的に、これは純粋にデジタルな現象です。

さらに技術的に説明すると、幻覚が発生する一般的な理由は次のとおりです。

オーバーフィットとアンダーフィット:

オーバーフィットとアンダーフィットAI モデルが直面する最も一般的な 2 つの落とし穴と、AI モデルが幻覚を起こす可能性のある理由です。 AI モデルがトレーニング データにオーバーフィットすると、モデルがトレーニング データから学習するのではなく、トレーニング データを記憶するようになるため、幻覚を引き起こし、非現実的な出力が生じる可能性があります。オーバーフィッティングとは、モデルがトレーニング データに特化しすぎて、データ内の無関係なパターンやノイズを学習する現象を指します。

一方、モデルが単純すぎると、アンダーフィッティングが発生します。モデルはデータの変動性や複雑さを捉えることができず、無意味な出力を生成してしまうため、幻覚につながる可能性があります。

トレーニング データの多様性の欠如:

このコンテキストでは、問題はアルゴリズムではなく、トレーニング データ自体にあります。限られたデータまたは偏ったデータでトレーニングされた AI モデルは、トレーニング データの制限や偏りを反映した幻覚を生成する可能性があります。幻覚は、不正確または不完全な情報を含むデータセットでモデルをトレーニングした場合にも発生する可能性があります。

複雑なモデル:

皮肉なことに、AI がモデル化する別の理由それらが非常に複雑または深い場合は、幻覚を起こしやすい可能性があります。これは、複雑なモデルにはより多くのパラメーターとレイヤーがあり、出力にノイズやエラーが発生する可能性があるためです。

敵対的攻撃:

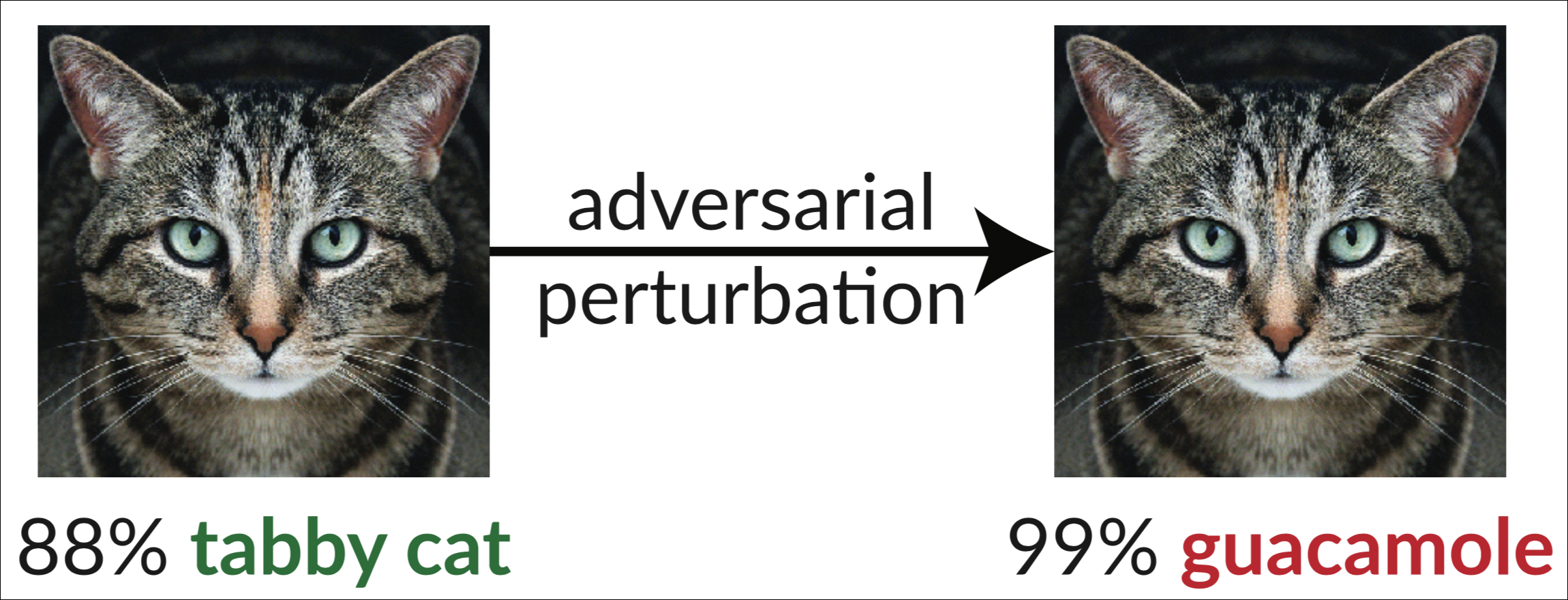

場合によっては、AI の幻覚AI モデルをだますために、攻撃者によって意図的に生成される可能性があります。このようなタイプの攻撃は、敵対的攻撃として知られています。このサイバー攻撃の唯一の目的は、欺瞞的なデータで AI モデルを騙したり操作したりすることです。入力データに小さな摂動を導入して、AI が不正確または予期しない出力を生成するようにします。たとえば、攻撃者は、人間には知覚できないノイズや歪みを画像に追加する可能性がありますが、AI モデルはそれを誤分類する可能性があります。たとえば、以下の猫の画像を参照してください。この画像は、InceptionV3 分類器をだまして「ワカモレ」と表示するようにわずかに変更されています。

クレジット: 研究グループ labsix のメンバーであり、敵対的攻撃に焦点を当てている Anish Athalye 氏

クレジット: 研究グループ labsix のメンバーであり、敵対的攻撃に焦点を当てている Anish Athalye 氏

変更は明白ではありません。上記の例から明らかなように、人間にとっては、変化はまったく知覚できません。右側の画像をトラ猫として分類するのに苦労する人間の読者はいないでしょう。しかし、画像、動画、テキスト、または音声に微妙な変更を加えると、AI システムがそこにないものを認識したり、一時停止の標識などの存在するものを無視したりする可能性があります。

この種の攻撃は、自動運転車、生体認証、医療診断、コンテンツ フィルタリングなど、正確で信頼性の高い予測に依存する AI システムに深刻な脅威をもたらします。

AIの幻覚はどれくらい危険ですか?

AI 幻覚は、特に AI システムのタイプによっては、非常に危険であることが証明されています。自動運転車、ユーザーのお金を使うことができる AI アシスタント、または不快なオンライン コンテンツをフィルタリングする AI システムは、完全に信頼できるものである必要があります。

しかし、現在の明白な事実は、AI システムが完全に信頼できるわけではなく、実際には幻覚を起こしやすいということです。現在存在する最も洗練された AI モデルでさえ、それらの影響を受けないわけではありません。

たとえば、ある攻撃のデモンストレーションでは、Google のクラウド コンピューティング サービスをだまして、ライフルをヘリコプターとして幻覚させました。 AIが現在、人が武装していないことを確認する責任があると想像できますか?

別の敵対的攻撃では、一時停止標識に小さな画像を追加すると AI システムから見えなくなることが示されました。これは本質的に、自動運転車が一時停止標識が道路上にないことを幻覚にさせることができることを意味します。完全自動運転車が実際に今日現実になったら、どれだけの事故が発生するでしょうか?それが彼らが今正しくない理由です。

現在トレンドとなっているチャットボットを考慮に入れても、幻覚は真実ではない出力を生成する可能性があります。しかし、AI チャットボットが幻覚を起こしやすいことを知らず、そのような AI ボットによって生成されたファクト チェックの出力を知らない人は、無意識のうちに誤った情報を広める可能性があります。

さらに、敵対的攻撃は差し迫った懸念事項です。これまで、それらはラボでのみ実証されてきました。しかし、重要なタスクを実行する AI システムが現実の世界でそれらに遭遇した場合、その結果は壊滅的なものになるでしょう。

実際のところ、自然言語モデルを保護する方が比較的簡単です。 (簡単だと言っているわけではありません。依然として非常に難しいことが証明されています。) ただし、コンピューター ビジョン システムを保護することは、まったく別のシナリオです。特に自然界には非常に多くのバリエーションがあり、画像には膨大な数のピクセルが含まれているため、これは非常に困難です。

この問題を解決するには、より人間的な世界観を持つ AI ソフトウェアが必要になるかもしれません。研究は進行中ですが、自然からヒントを得て幻覚の問題を回避できる AI が登場するのはまだ何年も先のことです。今のところ、それらは厳しい現実です。

全体として、AI の幻覚は複雑な現象であり、要因の組み合わせから生じる可能性があります。研究者は、AI システムの精度と信頼性を向上させるために、AI の幻覚を検出して軽減する方法の開発に積極的に取り組んでいます。ただし、AI システムとやり取りするときは、それらに注意する必要があります。